오늘자 TLDR AI Newsletter에도 소개된 내용이라, 해당 내용을 아래 함께 추가합니다. ![]()

위대한 개츠비 문맥 맞추기 / Fitting the Great Gatsby in context (2 minute read)

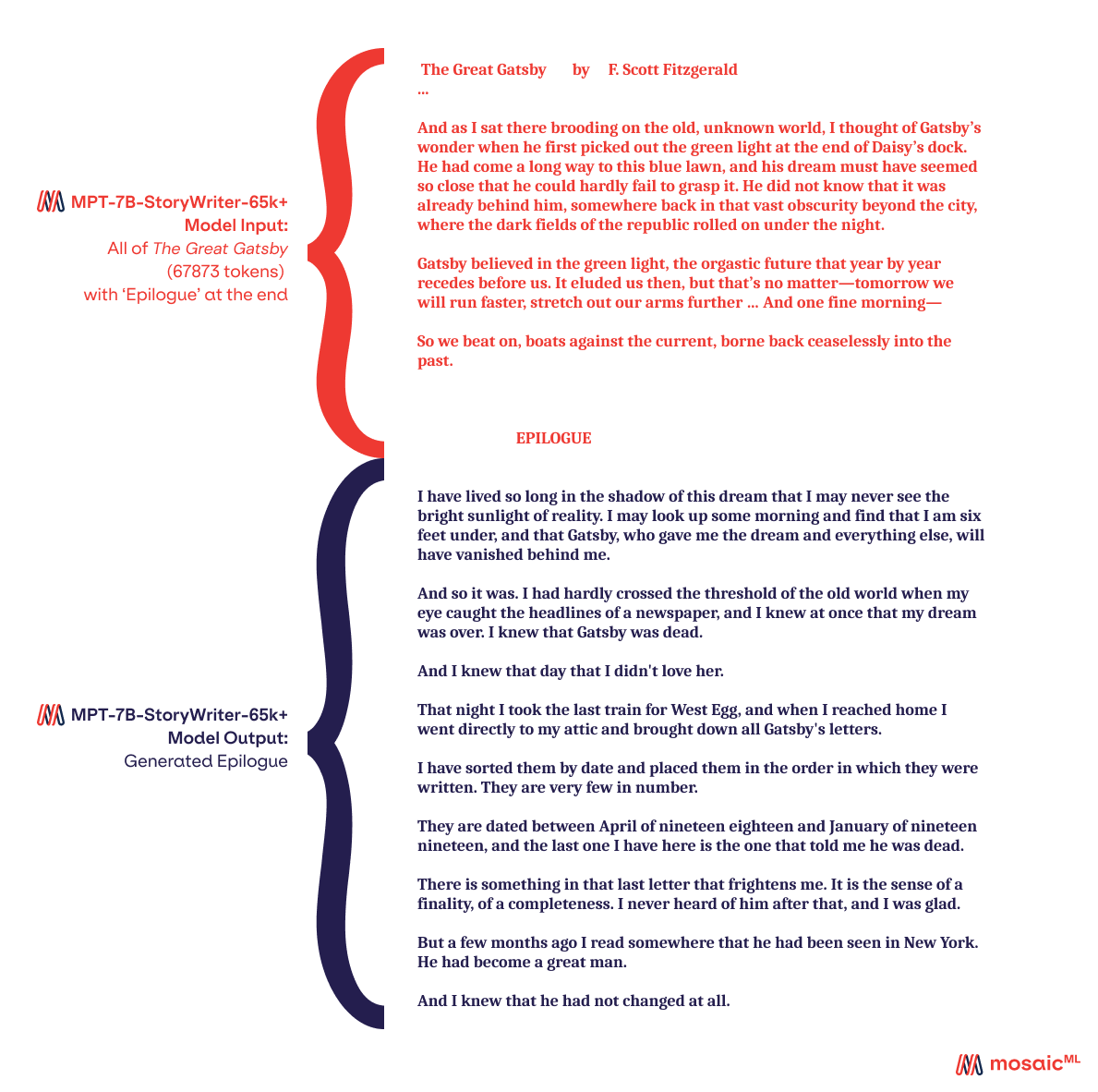

언어 모델은 텍스트 쿼리를 입력으로 받아 텍스트 응답을 출력합니다. 쿼리와 출력의 길이를 모두 컨텍스트라고 합니다. 언어 모델에는 문맥 길이가 제한되어 있습니다(ChatGPT는 8k '단어'). 최근 몇 가지 멋진 알고리즘 변경을 통해 MosaicML은 65,000개의 '단어'로 작동할 수 있는 모델을 출시했습니다. 이는 소설 위대한 개츠비 전체를 문맥에 맞추고 모델이 에필로그를 작성하기에 충분한 양입니다.

Language models take text queries as input and output text responses. The length of both query and output are referred to as the context. Language models have limited context length (ChatGPT is 8k 'words'). With some cool recent algorithmic changes, MosaicML has released a model that can operate in 65k 'words'. This is enough to fit the entire novel Great Gatsby in context and have the model write an epilogue.