- 이 글은 GPT 모델로 자동 요약한 설명으로, 잘못된 내용이 있을 수 있으니 원문을 참고해주세요!

- 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다!

서론

- 이번 주에는 언어 모델링, 모델 압축, 유전자 상호작용 예측, 코드 해석 및 개선, 개인화된 텍스트 생성 등 다양한 주제의 논문들이 선정되었습니다.

- 이들 논문들은 인공지능의 다양한 분야에서 새로운 접근법과 기술을 제시하며, 이를 통해 기존의 문제를 해결하거나 성능을 향상시키는 방법을 제시하고 있습니다.

논문 목록

1. Self-Alignment with Instruction Backtranslation (지시어 역번역을 통한 자기 정렬)

- 이 논문은 사람이 작성한 텍스트에 대응하는 지시어를 자동으로 라벨링하는 방법을 제시하며, 이를 통해 고품질의 지시어를 따르는 언어 모델을 구축할 수 있습니다. 이 방법은 작은 양의 시드 데이터와 웹 코퍼스를 이용해 LLM을 미세 조정하고, 각 웹 문서에 대한 지시어를 생성한 후, LLM을 통해 고품질의 예제를 선별하고, 이렇게 선별된 데이터로 다시 미세 조정하는 과정을 거칩니다. 이 자기 정렬 방법은 Alpaca 리더보드에서 모든 Llama 기반 모델을 능가합니다.

- 더보기: x.com

2. Platypus (오리너구리)

- 이 논문은 현재 Open LLM 리더보드에서 가장 높은 성능을 보이는 미세 조정 및 병합된 LLM인 Platypus를 소개합니다. 이 논문에서는 LoRA 모듈을 효율적으로 미세 조정하고 병합하는 과정을 설명하며, 미세 조정을 위한 고품질 데이터셋 수집의 이점을 보여줍니다. 특히, 작은 규모의 고품질이며, 철저하게 선별된 데이터셋인 Open-Platypus를 제시하며, 이를 통해 짧고 저렴한 미세 조정 시간 및 비용으로 강력한 성능을 달성할 수 있음을 보여줍니다.

- 더보기: x.com

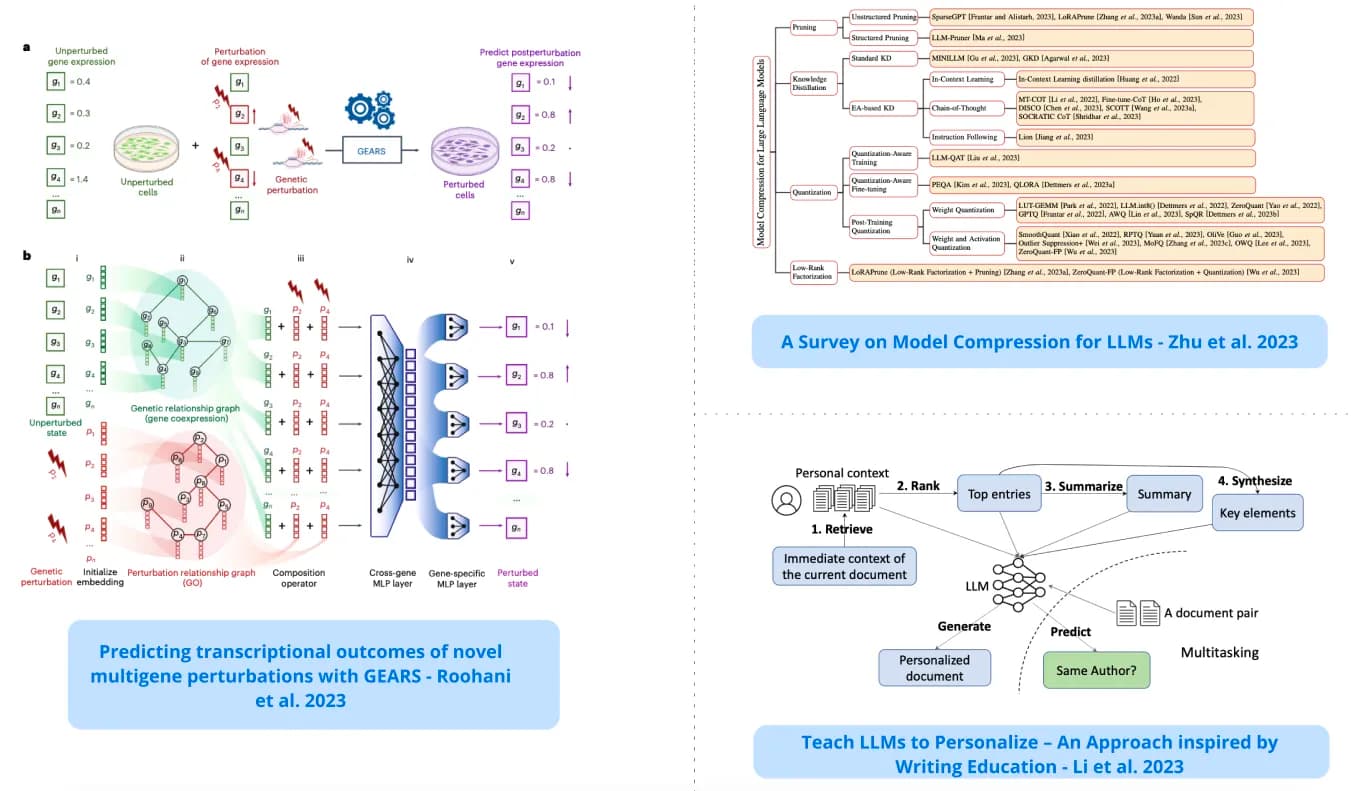

3. Model Compression for LLMs (LLM을 위한 모델 압축)

- 이 논문은 최근의 LLM을 위한 모델 압축 기법에 대한 짧은 서베이를 제공합니다. 양자화, 가지치기, 지식 증류 등의 주제에 대한 고수준 개요를 제공하며, 압축된 LLM의 효과를 측정하기 위한 벤치마크 전략과 평가 지표에 대한 개요도 제공합니다.

- 더보기: x.com

4. GEARS

- 이 논문은 딥러닝과 유전자 관계 지식 그래프를 사용하여 유전자 변형에 대한 세포 반응을 예측하는 데 도움을 줍니다. GEARS는 조합적 변형 스크린에서 네 가지 다른 유전자 상호작용 하위 유형을 예측하는 작업에서 기존 방법보다 40% 더 높은 정밀도를 보였습니다.

http://nature.com/articles/s41587-023-01905-6.pdf

- 더보기: x.com

5. Shepherd 모델

- 이 논문은 모델 응답을 비판하고 개선을 제안하는 데 특화된 언어 모델인 Shepherd를 소개합니다. 이를 통해 다양한 오류를 식별하고 해결책을 제안하는 능력을 갖추게 됩니다. 그것의 비판은 ChatGPT와 비슷하거나 선호됩니다.

- 더보기: x.com

6. Using GPT-4 Code Interpreter to Boost Mathematical Reasoning (수학적 추론력 향상을 위한 GPT-4 코드 해석기 사용)

- 이 논문은 GPT-4 코드 해석기에 대해 코드를 사용한 자체 검증을 명시적으로 장려하는 제로샷 프롬프팅 기법을 제안합니다. 초기 실험에서 GPT4-Code는 MATH 데이터셋에서 제로샷 정확도 69.7%를 달성하였으며, 이는 GPT-4의 성능(42.2%)에 비해 27.5%의 향상을 보여줍니다.

- 더보기: x.com

7. Teach LLMs to Personalize (LLM에게 개인화된 텍스트 생성을 가르치기)

- 이 논문은 LLM을 사용한 개인화된 텍스트 생성을 위한 다중 작업 학습 기반의 일반적인 접근법을 제안합니다. 목표는 미리 정의된 속성에 의존하지 않고 LLM이 개인화된 텍스트를 생성하게 하는 것입니다.

- 더보기: x.com

8. OctoPack

- 이 논문은 350개의 언어에 걸쳐 Git 커밋 4TB를 사용하여 코드 LLMs를 지시어 조정하는 방법을 제시합니다. 이 방법은 HumanEval Python 벤치마크에서 OpenAI 출력에 학습되지 않은 모델 중 최고의 성능을 보여줍니다. 또한, 이 데이터는 코드 설명 및 코드 수리와 같은 다른 작업에 대한 HumanEval 벤치마크를 확장하는 데 사용됩니다.

- 더보기: x.com

9. Efficient Guided Generation for LLMs (LLM을 위한 효율적인 가이드 생성)

- 이 논문은 LLM 개발자가 텍스트 생성을 빠르고 신뢰할 수 있는 방법으로 안내하는 데 도움이 되는 라이브러리를 제시합니다. 출력이 정규 표현식을 따르거나 JSON 스키마를 따르도록 보장하는 생성 방법을 제공합니다.

- 더보기: x.com

10. Bayesian Flow Networks (베이지안 플로우 네트워크)

- 이 논문은 베이지안 추론과 딥러닝의 힘을 결합한 새로운 클래스의 생성 모델을 소개합니다. 이는 데이터의 노이즈 버전이 아닌 데이터 분포의 매개변수에 작용하는 점에서 확산 모델과 다릅니다. 이는 연속적인, 이산화된, 이산 데이터에 대해 학습 절차에 최소한의 변경으로 적응됩니다.

- 더보기: x.com