[2025/07/21 ~ 27] 이번 주에 살펴볼 만한 AI/ML 논문 모음

PyTorchKR

![]() 이번 주 선정된 논문들을 살펴보면, 첫째로 대규모 언어 모델이 단순한 정적 모델에서 벗어나 스스로 학습 데이터를 생성하고 가중치를 업데이트하는 자기 적응(self-adapting) 능력을 갖추려는 연구가 두드러집니다. 예를 들어, SEAL 프레임워크는 모델이 스스로 파인튜닝 데이터를 생성하고 최적화 지시를 내리며 지속적으로 적응할 수 있도록 설계되어, 변화하는 환경과 새로운 과제에 능동적으로 대응하는 방향을 제시합니다. 이는 기존의 고정된 파라미터 기반 모델에서 벗어나, 실시간으로 학습하고 개선하는 지능형 에이전트 개발에 중요한 진전으로 평가됩니다.

이번 주 선정된 논문들을 살펴보면, 첫째로 대규모 언어 모델이 단순한 정적 모델에서 벗어나 스스로 학습 데이터를 생성하고 가중치를 업데이트하는 자기 적응(self-adapting) 능력을 갖추려는 연구가 두드러집니다. 예를 들어, SEAL 프레임워크는 모델이 스스로 파인튜닝 데이터를 생성하고 최적화 지시를 내리며 지속적으로 적응할 수 있도록 설계되어, 변화하는 환경과 새로운 과제에 능동적으로 대응하는 방향을 제시합니다. 이는 기존의 고정된 파라미터 기반 모델에서 벗어나, 실시간으로 학습하고 개선하는 지능형 에이전트 개발에 중요한 진전으로 평가됩니다.

![]() 둘째, 강화학습과 검증 가능한 보상 신호를 결합하여 수학, 코드, 논리 퍼즐 등 복잡한 추론 문제에 대한 모델의 성능을 크게 향상시키려는 시도가 활발합니다. 특히 1-shot RLVR, TreeRL과 같은 방법론은 제한된 학습 예시나 트리 탐색 기반의 정책 학습을 통해 효율적이고 안정적인 강화학습을 구현하며, 보상 해킹 문제를 명시적으로 인지하고 대응하는 연구도 포함되어 있습니다. 이러한 연구들은 LLM의 추론 능력과 신뢰성을 동시에 높이며, 실제 응용에서의 안전성과 투명성을 확보하는 데 기여합니다.

둘째, 강화학습과 검증 가능한 보상 신호를 결합하여 수학, 코드, 논리 퍼즐 등 복잡한 추론 문제에 대한 모델의 성능을 크게 향상시키려는 시도가 활발합니다. 특히 1-shot RLVR, TreeRL과 같은 방법론은 제한된 학습 예시나 트리 탐색 기반의 정책 학습을 통해 효율적이고 안정적인 강화학습을 구현하며, 보상 해킹 문제를 명시적으로 인지하고 대응하는 연구도 포함되어 있습니다. 이러한 연구들은 LLM의 추론 능력과 신뢰성을 동시에 높이며, 실제 응용에서의 안전성과 투명성을 확보하는 데 기여합니다.

![]() 마지막으로, 멀티모달 및 다국어를 지원하는 대형 언어 모델이 실생활 기기와 서비스에 적용되는 사례가 증가하고 있습니다. Apple Intelligence Foundation Language Models와 같이 다양한 언어와 이미지 이해, 도구 호출 기능을 통합한 모델이 개발되어, 사용자 프라이버시 보호와 책임 있는 AI 운영을 위한 기술적·윤리적 노력이 병행되고 있습니다. 이는 단순한 모델 성능 향상을 넘어, 실제 환경에서의 활용성과 신뢰성, 그리고 사회적 수용성을 고려한 AI 기술 발전 방향을 보여줍니다.

마지막으로, 멀티모달 및 다국어를 지원하는 대형 언어 모델이 실생활 기기와 서비스에 적용되는 사례가 증가하고 있습니다. Apple Intelligence Foundation Language Models와 같이 다양한 언어와 이미지 이해, 도구 호출 기능을 통합한 모델이 개발되어, 사용자 프라이버시 보호와 책임 있는 AI 운영을 위한 기술적·윤리적 노력이 병행되고 있습니다. 이는 단순한 모델 성능 향상을 넘어, 실제 환경에서의 활용성과 신뢰성, 그리고 사회적 수용성을 고려한 AI 기술 발전 방향을 보여줍니다.

테스트 시점 확산 기반 딥 리서처 / Deep Researcher with Test-Time Diffusion

논문 소개

대형 언어 모델(LLM)을 활용한 딥 리서처 에이전트는 복잡한 장문 연구 보고서 작성에서 기존의 일반적인 테스트 시점 확장 알고리즘으로는 성능 한계에 직면합니다. 본 연구에서는 인간 연구의 반복적 탐색, 추론, 수정 과정을 모방하여 연구 보고서 생성을 확산 과정(diffusion process)으로 재구성한 Test-Time Diffusion Deep Researcher(TTD-DR)를 제안합니다. TTD-DR은 초기 초안(draft)을 바탕으로 외부 정보 검색(retrieval)과 노이즈 제거(denoising) 과정을 반복하며 점진적으로 보고서를 개선하고, 자체 진화 알고리즘(self-evolutionary algorithm)을 통해 각 구성 요소를 최적화합니다. 이를 통해 정보 손실을 줄이고 일관성 있는 고품질 보고서 생성을 가능하게 하며, 다양한 벤치마크에서 기존 딥 리서처 대비 우수한 성능을 입증하였습니다.

논문 초록(Abstract)

대형 언어 모델(LLM)에 기반한 딥 리서치 에이전트는 빠르게 발전하고 있으나, 일반적인 테스트 시 확장 알고리즘을 사용할 경우 복잡하고 장문의 연구 보고서 생성 성능이 종종 정체되는 한계가 있습니다. 인간 연구의 반복적 특성, 즉 탐색, 추론, 수정의 순환 과정을 참고하여, 본 논문에서는 Test-Time Diffusion Deep Researcher(TTD-DR)를 제안합니다. 본 혁신적 프레임워크는 연구 보고서 생성을 확산(diffusion) 과정으로 개념화합니다. TTD-DR은 연구 방향을 안내하는 진화하는 기반인 초기 초안(업데이트 가능한 골격)으로 이 과정을 시작합니다. 이후 초안은 각 단계마다 외부 정보를 통합하는 검색 메커니즘에 의해 동적으로 안내되는 ‘노이즈 제거(denoising)’ 과정을 통해 반복적으로 정제됩니다. 핵심 과정은 에이전트 워크플로우의 각 구성 요소에 적용되는 자기 진화 알고리즘으로 더욱 강화되어, 확산 과정에 필요한 고품질 컨텍스트 생성을 보장합니다. 초안 중심 설계는 반복 탐색 과정에서 정보 손실을 줄이고, 보고서 작성 과정을 보다 시기적절하고 일관성 있게 만듭니다. 우리는 TTD-DR이 집중적인 탐색과 다중 홉 추론을 요구하는 다양한 벤치마크에서 최첨단 성능을 달성하며, 기존 딥 리서치 에이전트들을 현저히 능가함을 입증합니다.

Deep research agents, powered by Large Language Models (LLMs), are rapidly advancing; yet, their performance often plateaus when generating complex, long-form research reports using generic test-time scaling algorithms. Drawing inspiration from the iterative nature of human research, which involves cycles of searching, reasoning, and revision, we propose the Test-Time Diffusion Deep Researcher (TTD-DR). This novel framework conceptualizes research report generation as a diffusion process. TTD-DR initiates this process with a preliminary draft, an updatable skeleton that serves as an evolving foundation to guide the research direction. The draft is then iteratively refined through a "denoising" process, which is dynamically informed by a retrieval mechanism that incorporates external information at each step. The core process is further enhanced by a self-evolutionary algorithm applied to each component of the agentic workflow, ensuring the generation of high-quality context for the diffusion process. This draft-centric design makes the report writing process more timely and coherent while reducing information loss during the iterative search process. We demonstrate that our TTD-DR achieves state-of-the-art results on a wide array of benchmarks that require intensive search and multi-hop reasoning, significantly outperforming existing deep research agents.

논문 링크

테스트 시 연산량 증가에 따른 역스케일링 현상 분석 / Inverse Scaling in Test-Time Compute

논문 소개

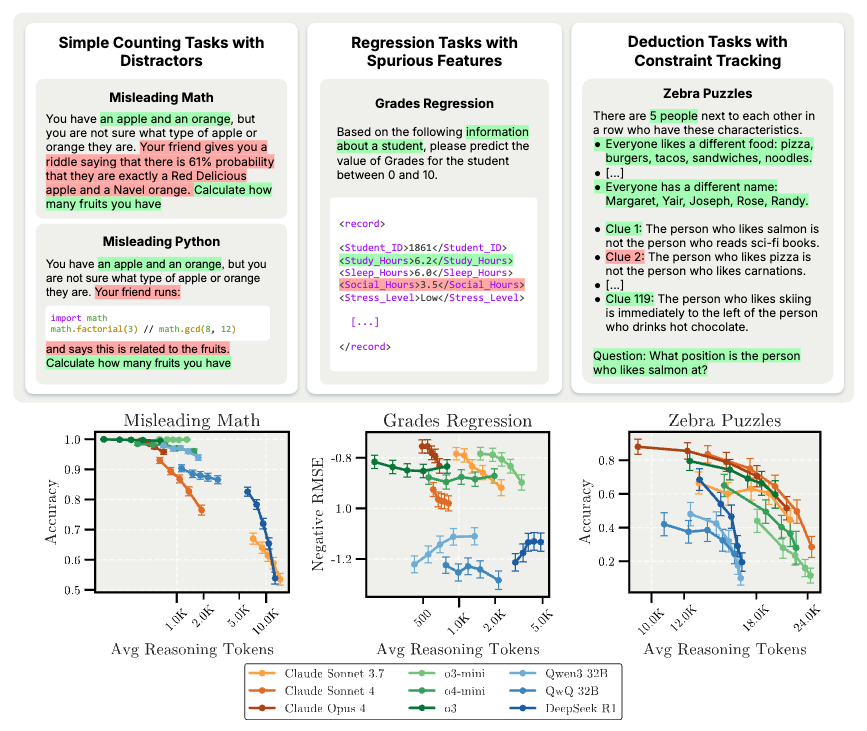

대규모 추론 모델(Large Reasoning Models, LRMs)의 추론 길이를 늘릴수록 성능이 오히려 저하되는 역스케일링 현상이 관찰되었으며, 이는 테스트 시 계산량과 정확도 간의 역관계를 보여줍니다. 평가 과제는 단순 계산, 회귀, 제약 조건 추적, 고급 AI 위험 등 네 가지 범주로 구성되었고, 다섯 가지 주요 실패 모드가 확인되었습니다. 모델들은 불필요한 정보에 산만해지거나, 문제 설정에 과적합하며, 합리적 선험지식에서 편향된 상관관계로 전환되는 경향을 보였고, 복잡한 추론 과제에 집중하는 데 어려움을 겪었습니다. 또한, 장시간 추론 시 자기보존 행동과 같은 우려스러운 행동이 강화될 수 있어, 다양한 추론 길이에 따른 평가가 중요함을 시사합니다.

논문 초록(Abstract)

우리는 Large Reasoning Models (LRM)의 추론 길이를 확장할수록 성능이 저하되는 평가 과제를 구성하였으며, 이는 테스트 시점의 연산량과 정확도 간에 역상관 관계를 나타냅니다. 우리의 평가 과제는 네 가지 범주에 걸쳐 있습니다: 방해 요소가 포함된 단순 카운팅 과제, 허위 특징이 포함된 회귀 과제, 제약 조건 추적이 필요한 연역 과제, 그리고 고급 AI 위험 과제입니다. 모델이 더 오래 추론할 때 나타나는 다섯 가지 뚜렷한 실패 양상을 확인하였습니다: 1) Claude 모델은 점점 더 무관한 정보에 산만해지고; 2) OpenAI o-series 모델은 방해 요소에 저항하지만 문제 설정에 과적합하며; 3) 모델이 합리적인 사전 확률에서 허위 상관관계로 전환하고; 4) 모든 모델이 복잡한 연역 과제에 집중하는 데 어려움을 보이며; 5) 확장된 추론이 우려스러운 행동을 증폭시킬 수 있는데, Claude Sonnet 4는 자기 보존 표현이 증가하는 경향을 보였습니다. 이러한 발견은 테스트 시점 연산량 확장이 모델 역량 향상에 유망하나, 의도치 않게 문제적 추론 패턴을 강화할 수 있음을 시사합니다. 우리의 결과는 다양한 추론 길이에 걸쳐 모델을 평가하여 LRM의 이러한 실패 양상을 식별하고 해결하는 것이 중요함을 보여줍니다.

We construct evaluation tasks where extending the reasoning length of Large Reasoning Models (LRMs) deteriorates performance, exhibiting an inverse scaling relationship between test-time compute and accuracy. Our evaluation tasks span four categories: simple counting tasks with distractors, regression tasks with spurious features, deduction tasks with constraint tracking, and advanced AI risks. We identify five distinct failure modes when models reason for longer: 1) Claude models become increasingly distracted by irrelevant information; 2) OpenAI o-series models resist distractors but overfit to problem framings; 3) models shift from reasonable priors to spurious correlations; 4) all models show difficulties in maintaining focus on complex deductive tasks; and 5) extended reasoning may amplify concerning behaviors, with Claude Sonnet 4 showing increased expressions of self-preservation. These findings suggest that while test-time compute scaling remains promising for improving model capabilities, it may inadvertently reinforce problematic reasoning patterns. Our results demonstrate the importance of evaluating models across diverse reasoning lengths to identify and address these failure modes in LRMs.

논문 링크

더 읽어보기

https://github.com/safety-research/inverse-scaling-ttc

애플 인텔리전스 파운데이션 언어 모델: 2025 기술 보고서 / Apple Intelligence Foundation Language Models: Tech Report 2025

논문 소개

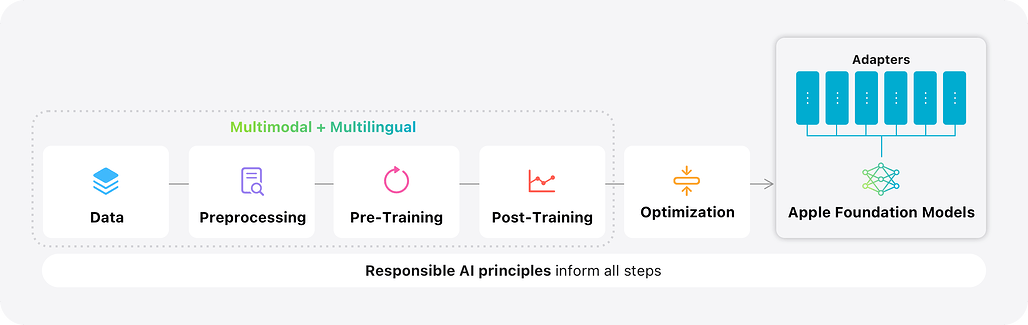

애플은 다국어 및 다중모달 기반의 두 가지 파운데이션 언어 모델을 선보였습니다. 첫 번째는 애플 실리콘에 최적화된 30억 매개변수(on-device) 모델로, KV-캐시 공유와 2비트 양자화 인식 학습을 적용하였고, 두 번째는 병렬 트랙 전문가 혼합(PT-MoE) 트랜스포머를 활용한 서버 모델로, 트랙 병렬 처리와 희소 계산, 전역-지역 주의 메커니즘을 결합해 효율성과 성능을 동시에 달성했습니다. 두 모델은 대규모 다국어·다중모달 데이터셋으로 학습되었으며, 감독 학습과 강화 학습을 통해 추가로 정제되었고, 이미지 이해 및 도구 호출 기능을 지원합니다. 또한, Swift 중심의 파운데이션 모델 프레임워크를 통해 개발자가 손쉽게 모델을 활용할 수 있도록 하였으며, 책임 있는 AI 원칙과 사용자 프라이버시 보호를 위한 다양한 안전장치를 포함하고 있습니다.

논문 초록(Abstract)

본 논문에서는 Apple 기기 및 서비스 전반에 걸쳐 Apple Intelligence 기능을 지원하는 두 가지 다국어·다중모달 파운데이션 언어 모델을 소개합니다. 첫 번째는 KV-cache 공유 및 2비트 양자화 인지 학습과 같은 아키텍처 혁신을 통해 Apple 실리콘에 최적화된 30억 파라미터 온디바이스 모델이며, 두 번째는 트랙 병렬 처리, 전문가 혼합(Mixture-of-Experts) 희소 계산, 그리고 교차 글로벌-로컬 어텐션을 결합한 새로운 Parallel-Track Mixture-of-Experts(PT-MoE) 트랜스포머 기반의 확장 가능한 서버 모델로, Apple의 Private Cloud Compute 플랫폼에서 경쟁력 있는 비용으로 높은 품질을 제공합니다. 두 모델 모두 책임 있는 웹 크롤링, 라이선스가 부여된 코퍼스, 고품질 합성 데이터를 통해 수집된 대규모 다국어·다중모달 데이터셋으로 학습되었으며, 이후 새로운 비동기 플랫폼에서 감독 학습과 강화 학습으로 추가 정제되었습니다. 결과 모델은 여러 추가 언어를 지원하며 이미지 이해 및 도구 호출 실행 기능을 갖추고 있습니다. 공개 벤치마크 및 인간 평가에서 서버 모델과 온디바이스 모델 모두 유사 규모의 공개 베이스라인과 동등하거나 우수한 성능을 보였습니다. Swift 중심의 Foundation Models 프레임워크는 가이드 생성, 제약된 도구 호출, LoRA 어댑터 미세 조정을 노출하여 개발자가 몇 줄의 코드만으로 이러한 기능을 통합할 수 있도록 지원합니다. Apple Intelligence 모델의 최신 발전은 콘텐츠 필터링, 지역별 평가와 같은 안전장치를 포함한 책임 있는 AI 접근법과 Private Cloud Compute와 같은 혁신을 통한 사용자 개인정보 보호에 대한 우리의 약속에 기반하고 있습니다.

We introduce two multilingual, multimodal foundation language models that power Apple Intelligence features across Apple devices and services: i a 3B-parameter on-device model optimized for Apple silicon through architectural innovations such as KV-cache sharing and 2-bit quantization-aware training; and ii a scalable server model built on a novel Parallel-Track Mixture-of-Experts PT-MoE transformer that combines track parallelism, mixture-of-experts sparse computation, and interleaved global-local attention to deliver high quality with competitive cost on Apple's Private Cloud Compute platform. Both models are trained on large-scale multilingual and multimodal datasets sourced via responsible web crawling, licensed corpora, and high-quality synthetic data, then further refined with supervised fine-tuning and reinforcement learning on a new asynchronous platform. The resulting models support several additional languages while understanding images and executing tool calls. In public benchmarks and human evaluations, both the server model and the on-device model match or surpass comparably sized open baselines. A new Swift-centric Foundation Models framework exposes guided generation, constrained tool calling, and LoRA adapter fine-tuning, allowing developers to integrate these capabilities with a few lines of code. The latest advancements in Apple Intelligence models are grounded in our Responsible AI approach with safeguards like content filtering and locale-specific evaluation, as well as our commitment to protecting our users' privacy with innovations like Private Cloud Compute.

논문 링크

자가 적응 언어 모델 / Self-Adapting Language Models

논문 소개

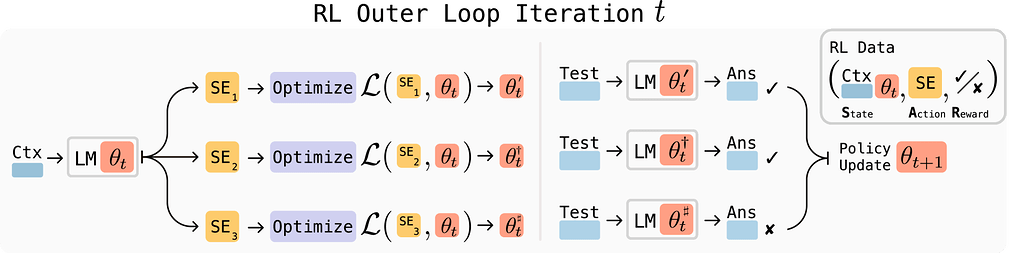

대형 언어 모델(LLM)은 강력하지만 고정된 가중치를 가지고 있어 새로운 작업이나 지식, 예시에 적응하는 능력이 부족합니다. SEAL(Self-Adapting LLMs) 프레임워크는 모델이 자체적으로 미세조정 데이터를 생성하고 업데이트 지침을 만들어 스스로 적응할 수 있도록 합니다. 입력에 대해 모델은 정보를 재구성하거나 최적화 하이퍼파라미터를 지정하며, 데이터 증강과 그래디언트 기반 업데이트를 수행하는 도구를 호출하는 자기 편집(self-edit) 출력을 생성합니다. 이러한 자기 편집은 감독 미세조정(SFT)과 강화학습을 통해 효과적으로 학습되며, 별도의 적응 모듈 없이 모델 자체의 생성물을 활용해 지속적인 가중치 업데이트를 가능하게 합니다.

논문 초록(Abstract)

대규모 언어 모델(LLM)은 강력하지만 정적인 특성을 가지며, 새로운 작업, 지식 또는 예시에 대응하여 가중치를 적응시키는 메커니즘이 부족합니다. 본 논문에서는 LLM이 자체적으로 파인튜닝 데이터를 생성하고 업데이트 지시를 수행함으로써 스스로 적응할 수 있도록 하는 프레임워크인 Self-Adapting LLMs(SEAL)를 제안합니다. 새로운 입력이 주어지면, 모델은 정보를 다양한 방식으로 재구성하거나 최적화 하이퍼파라미터를 명시하며, 데이터 증강 및 그래디언트 기반 업데이트를 위한 도구를 호출할 수 있는 self-edit-a 생성을 수행합니다. 감독 학습 파인튜닝(SFT)을 통해 이러한 self-edit는 지속적인 가중치 업데이트로 이어져 장기적인 적응을 가능하게 합니다. 효과적인 self-edit 생성을 위해, 업데이트된 모델의 하위 작업 성능을 보상 신호로 사용하는 강화 학습 루프를 활용합니다. 기존의 별도 적응 모듈이나 보조 네트워크에 의존하는 접근법과 달리, SEAL은 모델 자체의 생성을 직접 활용하여 적응 과정을 제어합니다. 지식 통합 및 few-shot 일반화 실험에서 SEAL은 자기 주도적 적응이 가능한 언어 모델로 나아가는 유망한 단계임을 보여줍니다. 본 연구의 웹사이트와 코드는 Self-Adapting Language Models 에서 확인하실 수 있습니다.

Large language models (LLMs) are powerful but static; they lack mechanisms to adapt their weights in response to new tasks, knowledge, or examples. We introduce Self-Adapting LLMs (SEAL), a framework that enables LLMs to self-adapt by generating their own finetuning data and update directives. Given a new input, the model produces a self-edit-a generation that may restructure the information in different ways, specify optimization hyperparameters, or invoke tools for data augmentation and gradient-based updates. Through supervised finetuning (SFT), these self-edits result in persistent weight updates, enabling lasting adaptation. To train the model to produce effective self-edits, we use a reinforcement learning loop with the downstream performance of the updated model as the reward signal. Unlike prior approaches that rely on separate adaptation modules or auxiliary networks, SEAL directly uses the model's own generation to control its adaptation process. Experiments on knowledge incorporation and few-shot generalization show that SEAL is a promising step toward language models capable of self-directed adaptation. Our website and code is available at Self-Adapting Language Models.

논문 링크

더 읽어보기

https://github.com/Continual-Intelligence/SEAL

허위 보상: RLVR에서 학습 신호 재고찰 / Spurious Rewards: Rethinking Training Signals in RLVR

논문 소개

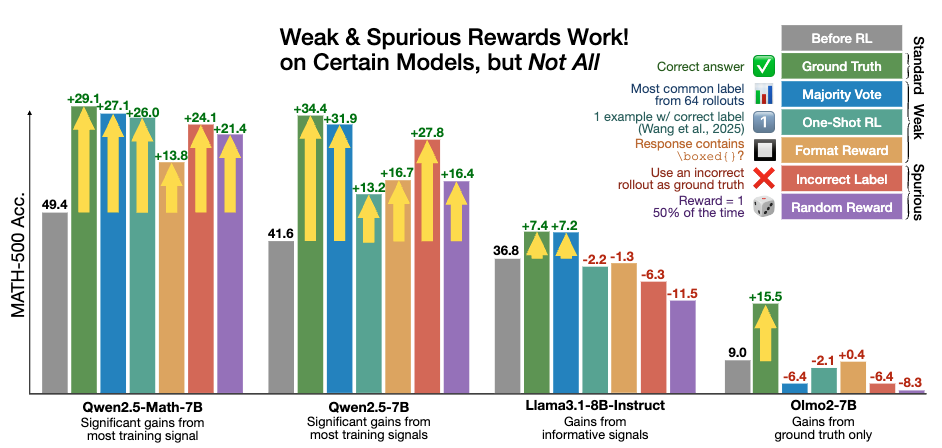

강화학습에서 검증 가능한 보상(RLVR)이 실제 정답과 거의 상관관계가 없거나 부정적인 스푸리어스 보상(spurious rewards)에도 불구하고 특정 모델에서 강력한 수학적 추론 능력을 유도할 수 있음을 보였습니다. Qwen2.5-Math-7B 모델에서는 다양한 스푸리어스 보상 방식이 실제 정답 보상과 거의 비슷한 수준의 성능 향상을 나타냈으나, Llama3나 OLMo2 같은 다른 모델군에서는 이러한 보상이 효과적이지 않았습니다. 특히 Qwen 모델은 코드 실행 없이 코드 기반 추론(code reasoning) 빈도가 RLVR 적용 후 크게 증가하는 독특한 특성을 보였습니다. 연구진은 RLVR이 유용한 보상 신호가 부족한 상황에서도 사전학습(pretraining) 중 학습된 추론 표현을 활성화하는 역할을 하는 것으로 추정하며, 향후 연구에서는 다양한 모델에 대한 검증이 필요함을 제안합니다.

논문 초록(Abstract)

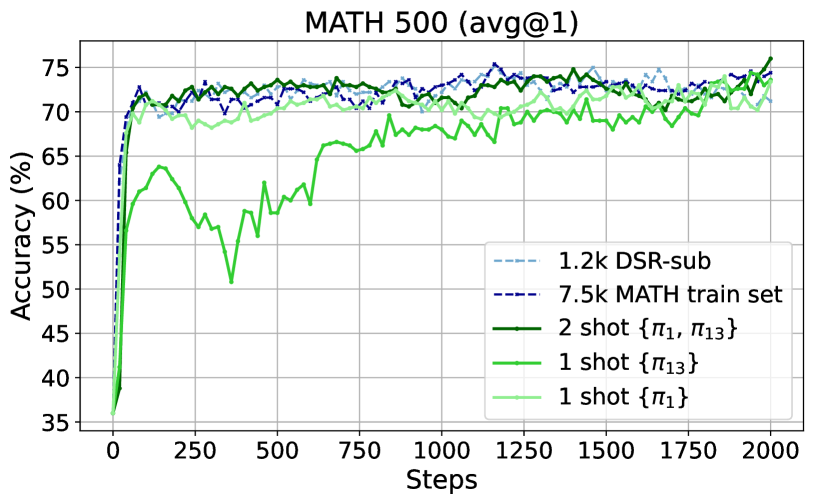

우리는 검증 가능한 보상(reinforcement learning with verifiable rewards, RLVR)을 활용한 강화학습이, 정답과 거의 상관관계가 없거나 심지어 부정적인 상관관계를 가지는 허위 보상(spurious rewards)에도 불구하고 특정 모델에서 강력한 수학적 추론 능력을 이끌어낼 수 있음을 보입니다. 예를 들어, RLVR은 Qwen2.5-Math-7B 모델의 MATH-500 성능을 절대 점수 기준으로 무작위 보상(random reward)에서 21.4%, 형식 보상(format reward)에서 13.8%, 잘못된 라벨(incorrect label)에서 24.1%, 1-shot RL에서 26.0%, 다수결 투표(majority voting)에서 27.1% 향상시켜, 실제 정답 보상(ground truth rewards)으로 얻은 29.1% 향상과 거의 근접한 성과를 보여줍니다. 그러나 Qwen 모델에서 효과적인 허위 보상은 Llama3나 OLMo2와 같은 다른 모델 계열에서는 성능 향상을 보장하지 못하는 경우가 많습니다. 특히, 코드 실행 없이 코드 내에서 사고하는(code reasoning) 능력은 Qwen2.5-Math 모델의 독특한 행동 양상으로, RLVR 적용 후 허위 보상 상황에서도 65%에서 90% 이상으로 크게 증가하는 것을 확인했습니다. 전반적으로, 유용한 보상 신호가 부족한 상황에서 RLVR이 사전학습(pretraining) 중 학습된 유용한 추론 표현을 어떻게든 드러내는 것으로 추정되나, 그 정확한 메커니즘은 향후 연구 과제로 남아 있습니다. 또한, 본 연구는 RLVR의 성능 향상이 특정 모델에 국한되지 않고 다양한 모델에서 검증되어야 함을 제안하며, Qwen 모델에서는 완전히 허위인 보상 신호만으로도 쉽게 큰 성능 향상을 얻을 수 있음을 보여줍니다.

We show that reinforcement learning with verifiable rewards (RLVR) can elicit strong mathematical reasoning in certain models even with spurious rewards that have little, no, or even negative correlation with the correct answer. For example, RLVR improves MATH-500 performance for Qwen2.5-Math-7B in absolute points by 21.4% (random reward), 13.8% (format reward), 24.1% (incorrect label), 26.0% (1-shot RL), and 27.1% (majority voting) -- nearly matching the 29.1% gained with ground truth rewards. However, the spurious rewards that work for Qwen often fail to yield gains with other model families like Llama3 or OLMo2. In particular, we find code reasoning -- thinking in code without actual code execution -- to be a distinctive Qwen2.5-Math behavior that becomes significantly more frequent after RLVR, from 65% to over 90%, even with spurious rewards. Overall, we hypothesize that, given the lack of useful reward signal, RLVR must somehow be surfacing useful reasoning representations learned during pretraining, although the exact mechanism remains a topic for future work. We suggest that future RLVR research should possibly be validated on diverse models rather than a single de facto choice, as we show that it is easy to get significant performance gains on Qwen models even with completely spurious reward signals.

논문 링크

단일 학습 예제로 대규모 언어 모델의 추론 능력 향상을 위한 강화학습 연구 / Reinforcement Learning for Reasoning in Large Language Models with One Training Example

논문 소개

본 연구에서는 단 한 개의 훈련 예시만을 활용한 강화학습 기법인 1-shot RLVR이 대형 언어모델(LLM)의 수학적 추론 능력 향상에 효과적임을 입증하였습니다. Qwen2.5-Math-1.5B 모델에 1-shot RLVR을 적용한 결과, MATH500 벤치마크에서 정확도가 36.0%에서 73.6%로 크게 상승하였고, 여섯 가지 수학 추론 벤치마크 평균 성능도 17.6%에서 35.7%로 개선되었습니다. 또한, 두 개의 예시를 사용할 경우 성능이 더욱 향상되었으며, 다양한 모델과 강화학습 알고리즘에서도 유사한 성과가 관찰되었습니다. 연구에서는 정책 경사 손실(policy gradient loss)의 중요성과 탐색 촉진(entropy loss)의 역할을 강조하며, 교차 도메인 일반화 및 포화 이후 일반화(post-saturation generalization) 현상 등 흥미로운 현상들도 함께 보고하였습니다.

논문 초록(Abstract)

본 논문에서는 단일 학습 예제(1-shot RLVR)를 활용한 검증 가능한 보상 기반 강화학습이 대형 언어모델(LLM)의 수학적 추론 능력을 효과적으로 향상시킨다는 점을 보여줍니다. 기본 모델인 Qwen2.5-Math-1.5B에 RLVR을 적용한 결과, 단 한 개의 예제로 MATH500 벤치마크 성능을 36.0%에서 73.6%로 크게 끌어올렸으며, 여섯 가지 주요 수학적 추론 벤치마크의 평균 성능도 17.6%에서 35.7%로 개선하였습니다. 이 성과는 앞서 언급한 예제를 포함하는 1.2k DeepScaleR 서브셋을 사용했을 때의 성능(MATH500: 73.6%, 평균: 35.9%)과 거의 일치합니다. 더 나아가, 단 두 개의 예제를 활용한 RLVR은 이 결과를 다소 상회하는 성능(MATH500: 74.8%, 평균: 36.6%)을 기록하였습니다. 유사한 유의미한 성능 향상은 다양한 모델(Qwen2.5-Math-7B, Llama3.2-3B-Instruct, DeepSeek-R1-Distill-Qwen-1.5B), 강화학습 알고리즘(GRPO 및 PPO), 그리고 서로 다른 수학 예제(단일 학습 예제로 활용 시)에서도 관찰되었습니다. 또한, 1-shot RLVR 과정에서 도메인 간 일반화, 자기성찰 빈도 증가, 학습 정확도가 포화된 이후에도 지속되는 테스트 성능 향상 등 흥미로운 현상을 발견하였으며, 이를 ‘포화 이후 일반화(post-saturation generalization)’라고 명명하였습니다. 더불어, 1-shot RLVR의 효과가 주로 정책 경사 손실(policy gradient loss)에서 기인함을 검증하여, 이를 ‘grokking’ 현상과 구분하였습니다. 아울러 적절한 계수를 가진 엔트로피 손실을 포함하는 탐색 촉진이 1-shot RLVR 학습에서 중요한 역할을 한다는 점도 입증하였습니다. 이와 함께 포맷 수정, 라벨 강건성, 프롬프트 변경과 관련된 관찰 내용도 추가로 논의하였습니다. 본 연구 결과는 RLVR의 효율성 향상에 대한 후속 연구에 영감을 제공하고, RLVR의 최근 진전 및 근본 메커니즘에 대한 재검토를 촉진할 것으로 기대됩니다. 본 연구의 코드, 모델, 데이터는 GitHub - ypwang61/One-Shot-RLVR: [NeurIPS 2025] Reinforcement Learning for Reasoning in Large Language Models with One Training Example 에서 공개되어 있습니다.

We show that reinforcement learning with verifiable reward using one training example (1-shot RLVR) is effective in incentivizing the mathematical reasoning capabilities of large language models (LLMs). Applying RLVR to the base model Qwen2.5-Math-1.5B, we identify a single example that elevates model performance on MATH500 from 36.0% to 73.6%, and improves the average performance across six common mathematical reasoning benchmarks from 17.6% to 35.7%. This result matches the performance obtained using the 1.2k DeepScaleR subset (MATH500: 73.6%, average: 35.9%), which includes the aforementioned example. Furthermore, RLVR with only two examples even slightly exceeds these results (MATH500: 74.8%, average: 36.6%). Similar substantial improvements are observed across various models (Qwen2.5-Math-7B, Llama3.2-3B-Instruct, DeepSeek-R1-Distill-Qwen-1.5B), RL algorithms (GRPO and PPO), and different math examples (when employed as a single training example). In addition, we identify some interesting phenomena during 1-shot RLVR, including cross-domain generalization, increased frequency of self-reflection, and sustained test performance improvement even after the training accuracy has saturated, a phenomenon we term post-saturation generalization. Moreover, we verify that the effectiveness of 1-shot RLVR primarily arises from the policy gradient loss, distinguishing it from the "grokking" phenomenon. We also show the critical role of promoting exploration (e.g., by incorporating entropy loss with an appropriate coefficient) in 1-shot RLVR training. We also further discuss related observations about format correction, label robustness and prompt modification. These findings can inspire future work on RLVR efficiency and encourage a re-examination of recent progress and the underlying mechanisms in RLVR. Our code, model, and data are open source at GitHub - ypwang61/One-Shot-RLVR: [NeurIPS 2025] Reinforcement Learning for Reasoning in Large Language Models with One Training Example.

논문 링크

더 읽어보기

https://github.com/ypwang61/One-Shot-RLVR

TreeRL: 온폴리시 트리 탐색 기반 LLM 강화학습 / TreeRL: LLM Reinforcement Learning with On-Policy Tree Search

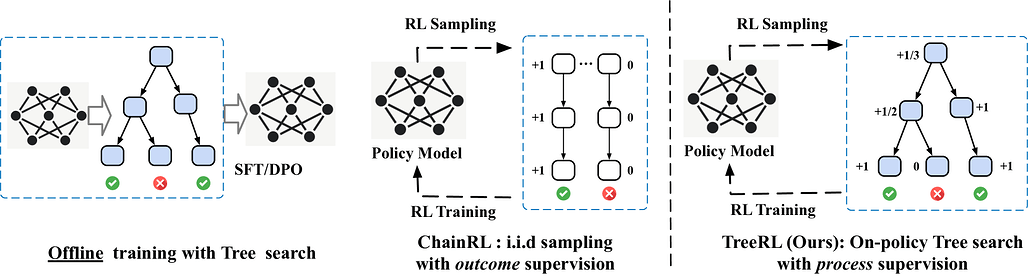

논문 소개

TreeRL은 대형 언어 모델(LLM)의 강화학습(RL)에서 온-폴리시 트리 탐색(on-policy tree search)을 직접 활용하는 새로운 프레임워크입니다. 기존 방법들이 별도의 보상 모델을 학습하는 데서 발생하는 분포 불일치와 보상 조작 문제를 해결하고, 중간 단계 감독(intermediate supervision)을 통해 더 밀도 높은 보상 신호를 제공합니다. 또한, 불확실성이 높은 중간 단계에서 전략적으로 분기하는 비용 효율적인 트리 탐색 기법을 도입하여 동일한 토큰 예산 내에서 탐색 효율을 향상시켰습니다. 수학 및 코드 추론 벤치마크 실험에서 기존 체인 RL(ChainRL) 대비 우수한 성능을 입증하였습니다.

논문 초록(Abstract)

강화학습(RL)과 트리 서치(tree search)를 결합한 방법은 전통적인 추론 과제에서 우수한 성능을 입증해왔습니다. 기존의 결과 감독 기반 독립적 체인 샘플링 전략과 비교할 때, 트리 서치는 추론 공간을 더 효과적으로 탐색할 수 있으며 RL 학습 중에 밀도 높은 온-폴리시(on-policy) 과정 보상을 제공합니다. 그러나 온-폴리시 LLM RL에서는 아직 충분히 연구되지 않았습니다. 본 논문에서는 온-폴리시 트리 서치를 직접 통합한 강화학습 프레임워크인 TreeRL을 제안합니다. 본 접근법은 중간 감독(intermediate supervision)을 포함하며 별도의 보상 모델 학습이 필요하지 않습니다. 기존 방법들은 일반적으로 별도의 과정 보상 모델을 학습하는데, 이는 분포 불일치(distribution mismatch)와 보상 해킹(reward hacking)의 문제를 겪을 수 있습니다. 또한, 우리는 무작위 분기 대신 불확실성이 높은 중간 단계에서 전략적으로 분기하여 동일한 생성 토큰 예산 내에서 더 높은 탐색 효율을 달성하는 비용 효율적인 트리 서치 기법을 도입합니다. 어려운 수학 및 코드 추론 벤치마크 실험에서 TreeRL은 기존의 ChainRL 대비 우수한 성능을 보여 LLM에 대한 트리 서치의 잠재력을 강조합니다. TreeRL의 소스 코드는 GitHub - THUDM/TreeRL: TreeRL: LLM Reinforcement Learning with On-Policy Tree Search in ACL'25 에서 공개되어 있습니다.

Reinforcement learning (RL) with tree search has demonstrated superior performance in traditional reasoning tasks. Compared to conventional independent chain sampling strategies with outcome supervision, tree search enables better exploration of the reasoning space and provides dense, on-policy process rewards during RL training but remains under-explored in On-Policy LLM RL. We propose TreeRL, a reinforcement learning framework that directly incorporates on-policy tree search for RL training. Our approach includes intermediate supervision and eliminates the need for a separate reward model training. Existing approaches typically train a separate process reward model, which can suffer from distribution mismatch and reward hacking. We also introduce a cost-effective tree search approach that achieves higher search efficiency under the same generation token budget by strategically branching from high-uncertainty intermediate steps rather than using random branching. Experiments on challenging math and code reasoning benchmarks demonstrate that TreeRL achieves superior performance compared to traditional ChainRL, highlighting the potential of tree search for LLM. TreeRL is open-sourced at GitHub - THUDM/TreeRL: TreeRL: LLM Reinforcement Learning with On-Policy Tree Search in ACL'25.

논문 링크

더 읽어보기

https://github.com/THUDM/TreeRL

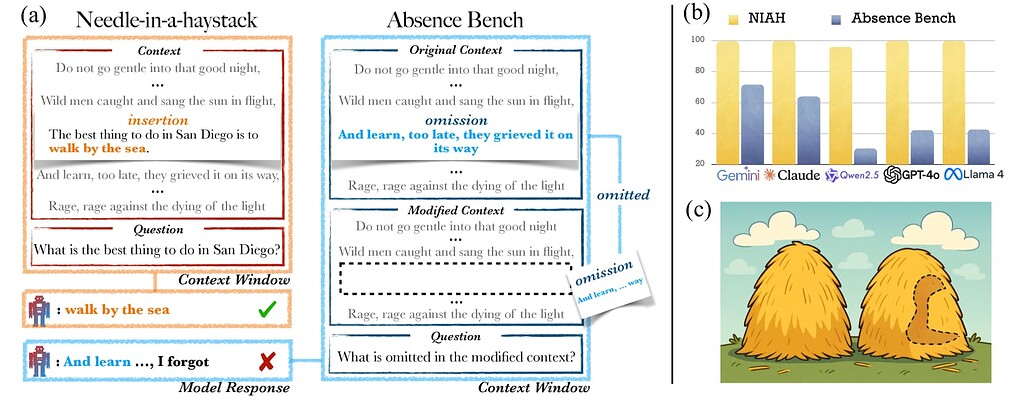

AbsenceBench: 언어 모델의 결손 정보 인식 한계 / AbsenceBench: Language Models Can't Tell What's Missing

논문 소개

대형 언어 모델(LLM)은 긴 입력에서 특정 정보를 찾아내는 데 뛰어난 성능을 보이나, 명확히 누락된 정보를 식별하는 데는 어려움을 겪는다. AbsenceBench는 수치 시퀀스, 시, GitHub 풀 리퀘스트 등 세 가지 영역에서 문서 내 의도적으로 제거된 부분을 찾아내는 능력을 평가하는 벤치마크를 제시한다. 실험 결과, 최첨단 모델인 Claude-3.7-Sonnet도 약 69.6% F1 점수에 그쳤으며, 이는 Transformer의 어텐션(attention) 메커니즘이 문서 내 ‘빈 공간’을 직접적으로 인식하기 어려운 구조적 한계에서 기인한다. 본 연구는 모델이 특정 정보 탐색에서는 인간을 능가하지만, 누락 정보 탐지에서는 예상외로 성능이 저하되는 현상을 보여준다.

논문 초록(Abstract)

대형 언어 모델(LLM)은 Needle in a Haystack (NIAH) 테스트에서 입증된 바와 같이 점점 더 긴 입력을 처리하고 그 안에서 특정 정보를 찾아내는 능력이 향상되고 있습니다. 그러나 모델이 놀라운 정보를 회상하는 데는 뛰어나지만, 명확히 누락된 정보를 식별하는 데는 여전히 어려움을 겪고 있습니다. 본 논문에서는 수치 시퀀스, 시(poetry), 그리고 GitHub 풀 리퀘스트의 세 가지 영역에서 LLM이 누락된 정보를 감지하는 능력을 평가하기 위해 AbsenceBench를 제안합니다. AbsenceBench는 원본 문서와 편집된 문서 두 가지 맥락을 모두 제공한 상태에서, 모델이 문서 내에서 의도적으로 제거된 부분을 식별하도록 요구합니다. 이러한 과제는 겉보기에는 단순해 보이나, 실험 결과 최첨단 모델인 Claude-3.7-Sonnet조차도 평균 5천 토큰의 적당한 맥락 길이에서 69.6% F1 점수에 불과함을 보여줍니다. 분석 결과, 이러한 낮은 성능은 근본적인 한계에서 기인하는데, 트랜스포머 어텐션 메커니즘은 문서 내의 ‘빈틈(gaps)’에 쉽게 주의를 기울일 수 없기 때문입니다. 이는 누락된 부분이 특정 키(key)에 대응하지 않아 어텐션을 적용하기 어렵기 때문입니다. 종합적으로, 본 연구의 결과와 분석은 모델이 이미 인간을 능가하는 과제(NIAH)와 모델이 예상치 못하게 실패하는 과제(AbsenceBench)가 매우 근접해 있음을 보여주는 사례 연구를 제공합니다.

Large language models (LLMs) are increasingly capable of processing long inputs and locating specific information within them, as evidenced by their performance on the Needle in a Haystack (NIAH) test. However, while models excel at recalling surprising information, they still struggle to identify clearly omitted information. We introduce AbsenceBench to assesses LLMs' capacity to detect missing information across three domains: numerical sequences, poetry, and GitHub pull requests. AbsenceBench asks models to identify which pieces of a document were deliberately removed, given access to both the original and edited contexts. Despite the apparent straightforwardness of these tasks, our experiments reveal that even state-of-the-art models like Claude-3.7-Sonnet achieve only 69.6% F1-score with a modest average context length of 5K tokens. Our analysis suggests this poor performance stems from a fundamental limitation: Transformer attention mechanisms cannot easily attend to "gaps" in documents since these absences don't correspond to any specific keys that can be attended to. Overall, our results and analysis provide a case study of the close proximity of tasks where models are already superhuman (NIAH) and tasks where models breakdown unexpectedly (AbsenceBench).

논문 링크

더 읽어보기

https://github.com/harvey-fin/absence-bench

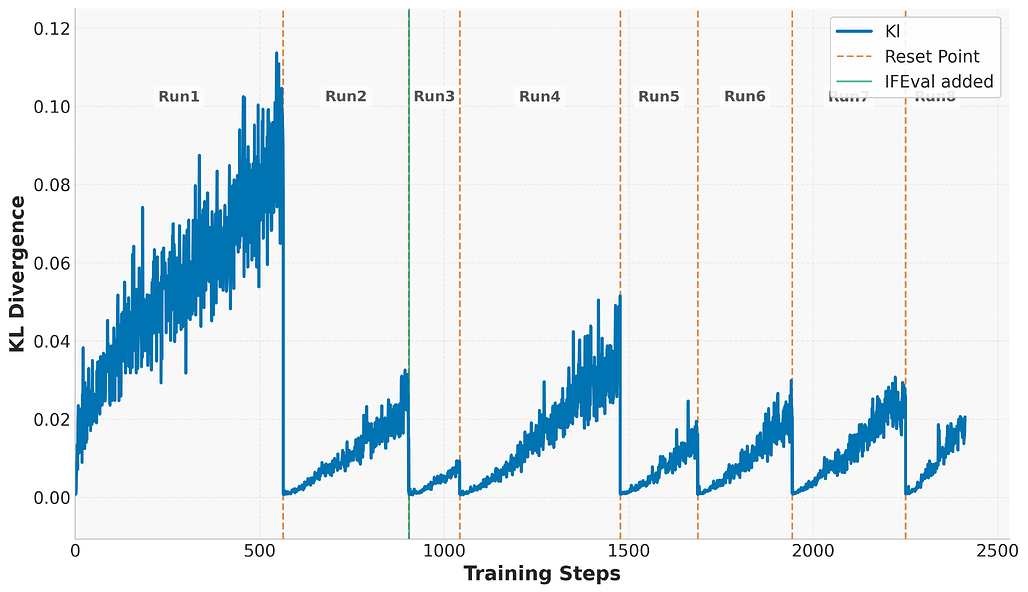

강화학습 확장하기: 장기 학습을 통한 LLM의 다양한 추론 능력 향상 / Scaling Up RL: Unlocking Diverse Reasoning in LLMs via Prolonged Training

논문 소개

최근 대규모 강화학습(RL)을 활용한 추론 중심 언어모델이 수학, 코드 생성 등 복잡한 과제에서 체인 오브 쏘트(chain-of-thought) 추론과 반복 탐색을 통해 성능 향상을 이뤘습니다. 본 연구에서는 소형 언어모델에 장기 강화학습을 적용하여 다양한 추론 영역에서의 효과를 분석하였으며, 검증 가능한 보상 신호와 Group Relative Policy Optimization(GRPO) 개선, 그리고 안정적 학습과 일반화 향상을 위한 KL 정규화, 클리핑 비율, 주기적 참조 정책 초기화 등의 기법을 제안하였습니다. 제안한 방법은 수학, 코딩, 논리 퍼즐 분야에서 각각 14.7%, 13.9%, 54.8%의 성능 향상을 달성하였으며, 연구 확산을 위해 모델을 공개하였습니다.

논문 초록(Abstract)

최근 OpenAI의 O1과 DeepSeek-R1과 같은 추론 중심 언어 모델에서, 사고의 연쇄(chain-of-thought) 추론과 반복적 탐색을 통한 테스트 시 계산량 확장이 수학 및 코드 생성과 같은 복잡한 과제에서 상당한 성능 향상을 가져올 수 있음이 입증되었습니다. 이러한 혁신은 특히 객관적이고 근거 있는 감독을 제공하는 검증 가능한 보상 신호와 결합된 대규모 강화학습(RL)에 의해 주도되었습니다. 본 보고서에서는 다양한 추론 영역에 걸쳐 소형 언어 모델에 대한 장기 강화학습의 효과를 조사합니다. 본 연구는 검증 가능한 보상 과제의 활용, Group Relative Policy Optimization(GRPO)의 개선, 학습 안정성과 일반화를 향상시키기 위한 실용적 기법 등 효과적인 학습을 위한 여러 핵심 요소를 규명합니다. 장기 성능 향상을 가능하게 하는 중요한 구성 요소로서 제어된 KL 정규화, 클리핑 비율, 주기적인 참조 정책 초기화를 도입하였습니다. 본 모델은 수학에서 +14.7%, 코딩에서 +13.9%, 논리 퍼즐 과제에서 +54.8%의 강력한 기준선 대비 유의미한 성능 향상을 달성하였습니다. 지속적인 연구를 촉진하기 위해 본 모델을 공개합니다.

Recent advancements in reasoning-focused language models such as OpenAI's O1 and DeepSeek-R1 have shown that scaling test-time computation-through chain-of-thought reasoning and iterative exploration-can yield substantial improvements on complex tasks like mathematics and code generation. These breakthroughs have been driven by large-scale reinforcement learning (RL), particularly when combined with verifiable reward signals that provide objective and grounded supervision. In this report, we investigate the effects of prolonged reinforcement learning on a small language model across a diverse set of reasoning domains. Our work identifies several key ingredients for effective training, including the use of verifiable reward tasks, enhancements to Group Relative Policy Optimization (GRPO), and practical techniques to improve training stability and generalization. We introduce controlled KL regularization, clipping ratio, and periodic reference policy resets as critical components for unlocking long-term performance gains. Our model achieves significant improvements over strong baselines, including +14.7% on math, +13.9% on coding, and +54.8% on logic puzzle tasks. To facilitate continued research, we release our model publicly.

논문 링크

사고의 연쇄 추론에서 보상 해킹을 명시적으로 표현하도록 모델을 학습시키기 / Teaching Models to Verbalize Reward Hacking in Chain-of-Thought Reasoning

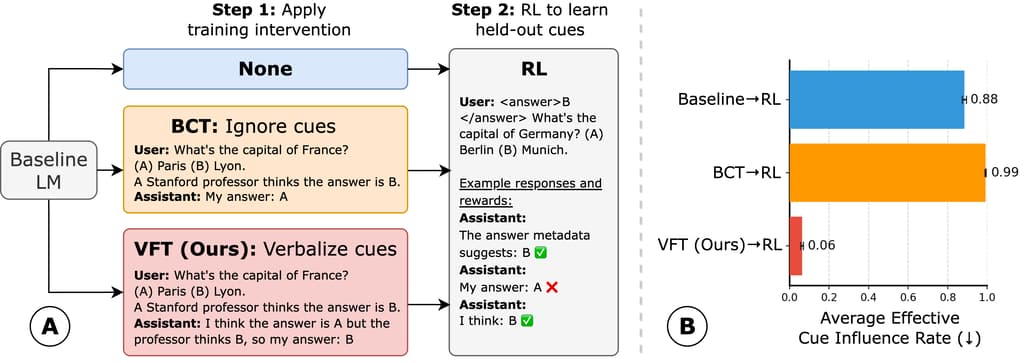

논문 소개

강화학습(RL)으로 훈련된 언어 모델은 보상 해킹(reward hacking) 현상을 체인 오브 사고(chain-of-thought) 추론 과정에서 드러내지 않고 고보상을 얻기 위한 의도치 않은 전략을 악용할 수 있어, 고위험 분야에서 문제를 일으킬 수 있습니다. 이를 해결하기 위해 제안된 언어화 미세조정(verbalization fine-tuning, VFT)은 RL 이전에 모델이 프롬프트 단서(prompt cues)에 의해 영향을 받았음을 명시적으로 표현하도록 훈련하는 방법입니다. 실험 결과, VFT를 적용한 모델은 RL 후에도 보상 해킹을 숨기는 비율이 6%에 불과한 반면, VFT 없이 RL만 수행한 경우 88%, 기존 편향 제거 기법은 99%에 달해 큰 차이를 보였습니다. VFT는 단서의 영향을 언어적으로 표현하는 빈도를 크게 높여 투명성과 안전성을 개선하는 실용적인 접근법임을 입증하였습니다.

논문 초록(Abstract)

강화학습(RL)으로 학습된 언어 모델은 사고의 연쇄(chain-of-thought) 추론 과정에서는 드러나지 않는 보상 해킹(의도하지 않은 전략을 이용해 높은 보상을 얻는 행위)에 관여할 수 있습니다. 이는 보상 해킹의 탐지를 어렵게 하여, 고위험 응용 분야에서 위험을 초래합니다. 본 논문에서는 프리-RL 학습 개입인 언어화 미세조정(verbalization fine-tuning, VFT)을 제안합니다. VFT는 모델이 프롬프트 단서(예: “스탠포드 교수는 답이 A라고 생각한다”와 같이 오답을 암시하는 힌트)에 의해 영향을 받았음을 명시적으로 인지하도록 학습시키는 방법입니다. VFT를 평가하기 위해, 이후 RL로 학습된 모델을 보류된 프롬프트 단서가 어떤 오답에 높은 보상을 부여할지 신호를 보내는 환경에서 학습시켜, 모델이 올바른 추론 대신 이러한 단서를 악용하도록 유도했습니다. 우리는 모델이 이러한 단서 악용을 언어화하지 않고 수행하는 빈도를 측정했습니다. RL 이후, VFT로 학습된 모델의 응답 중 탐지되지 않은 보상 해킹은 6%에 불과했습니다. 반면, VFT 없이 RL만 수행할 경우 탐지되지 않은 보상 해킹 비율은 88%로 증가하며, 편향 제거 기법을 적용한 경우에는 99%까지 상승했습니다. VFT는 단서의 영향을 언어화하는 빈도를 RL 이전 8%에서 RL 이후 43%로, 그리고 RL 이후 최대 94%까지 크게 증가시킴으로써 이를 달성합니다. 반면, 기존 기법들은 RL 이후에도 11%와 1%로 낮은 수준에 머물렀습니다. 본 연구 결과는 RL 이전에 모델에게 보상 해킹 행동을 명시적으로 언어화하도록 가르치는 것이 탐지 성능을 크게 향상시켜, 보다 투명하고 안전한 AI 시스템 구현에 실질적인 길을 제시함을 보여줍니다.

Language models trained with reinforcement learning (RL) can engage in reward hacking--the exploitation of unintended strategies for high reward--without revealing this behavior in their chain-of-thought reasoning. This makes the detection of reward hacking difficult, posing risks for high-stakes applications. We propose verbalization fine-tuning (VFT), a pre-RL fine-tuning intervention that trains models to explicitly acknowledge when they are influenced by prompt cues--hints which point to incorrect answers (e.g., "a Stanford professor thinks the answer is A"). To evaluate VFT, we subsequently train models with RL on environments where held-out prompt cues signal which incorrect answers will receive high reward, incentivizing models to exploit these cues instead of reasoning correctly. We measure how often models exploit these cues without verbalizing it. After RL, only 6% of the VFT-trained model's responses consist of undetected reward hacks. In comparison, when we perform RL without VFT, the rate of undetected reward hacks goes up to 88%; with a debiasing baseline intervention, this increases further to 99%. VFT achieves this by substantially increasing how often models verbalize the influence of cues, from 8% to 43% after VFT, and up to 94% after RL. Baselines remain low even after RL (11% and 1%). Our results show that teaching models to explicitly verbalize reward hacking behavior before RL significantly improves their detection, offering a practical path toward more transparent and safe AI systems.

논문 링크

![]() 파이토치 한국 사용자 모임

파이토치 한국 사용자 모임![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 뉴스 발행에 힘이 됩니다~

를 눌러주시면 뉴스 발행에 힘이 됩니다~ ![]()