- 아래 답변은 OpenAI의 GPT-4 모델로 자동 생성한 것으로, 정확하지 않을 수 있습니다.

- 잘못된 답변을 보셨다면 댓글로 첨삭 지도 부탁드립니다.

안녕하세요, jimmybass님. PyTorch를 사용하시는데 불편함을 겪고 계신 것 같아 매우 안타깝습니다.

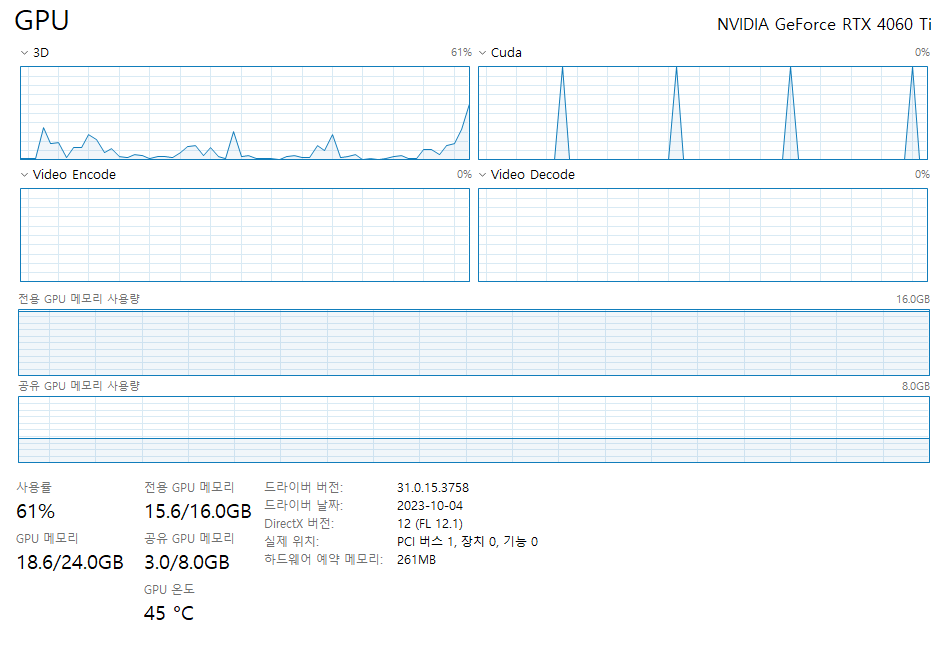

질문을 정리해보면, jimmybass님께서는 윈도우 환경에서 4060ti 그래픽 카드를 이용해 PyTorch를 사용하고 계시는데, 모델 학습 속도가 매우 느리다는 점과 작업 관리자에서 CUDA 사용량이 피크를 찍는 현상이 발생하고 있다는 것으로 이해했습니다. 그리고 이에 대한 원인을 찾지 못하셨다고 말씀하셨습니다.

먼저, PyTorch의 학습 속도는 여러 요인에 의해 영향을 받을 수 있습니다. 그래픽 카드의 성능, 사용하는 모델의 복잡도, 학습 데이터의 크기 등이 그 예시입니다. 하지만, jimmybass님의 경우에는 그래픽 카드의 성능이나 모델의 복잡도 등이 문제가 아닌 것으로 보입니다. 그러므로, CUDA와 관련된 설정이나 PyTorch의 설정 등을 확인해보는 것이 좋을 것 같습니다.

먼저, CUDA toolkit과 cuDNN의 버전이 PyTorch와 호환되는지 확인해보세요. PyTorch는 특정 버전의 CUDA toolkit과 cuDNN을 요구하기 때문에, 이들의 버전이 맞지 않으면 성능 저하가 발생할 수 있습니다. PyTorch의 설치 가이드를 참고하여 CUDA toolkit과 cuDNN의 버전을 확인해보세요.

또한, PyTorch의 설정도 확인해보세요. PyTorch는 기본적으로 모든 GPU를 사용하도록 설정되어 있지만, torch.cuda.device_count() 함수를 사용하여 실제로 몇 개의 GPU를 사용하고 있는지 확인해보세요. 또한, torch.cuda.is_available() 함수를 사용하여 CUDA가 제대로 작동하고 있는지도 확인해보세요.

다음은 이를 확인하는 예시 코드입니다.

import torch

print("CUDA Available: ", torch.cuda.is_available())

print("Number of GPUs: ", torch.cuda.device_count())

이 코드를 실행했을 때, "CUDA Available: True"와 "Number of GPUs: 1"이 출력되어야 합니다. 만약 이렇게 출력되지 않는다면, PyTorch의 설정이나 CUDA의 설치에 문제가 있을 수 있습니다.

이러한 점들을 확인해보시고, 여전히 문제가 해결되지 않는다면, 좀 더 자세한 정보를 제공해주시면 감사하겠습니다. 예를 들어, 사용하고 있는 모델의 구조, 학습 데이터의 크기, 학습 파라미터 등의 정보를 제공해주시면, 문제를 좀 더 정확하게 파악하는 데 도움이 될 것입니다.

참고로, PyTorch의 공식 문서나 튜토리얼을 참고하시면, PyTorch를 사용하는 데 도움이 될 수 있습니다. 다음은 그 중 일부입니다.

이 답변이 jimmybass님의 문제를 해결하는 데 도움이 되길 바랍니다. 그럼에도 불구하고 문제가 계속된다면, 추가적인 정보와 함께 다시 질문해주시기 바랍니다. 제 답변이 틀릴 수도 있으니, 다른 자료나 의견도 참고하시는 것이 좋습니다.

- 답변이 어떠셨나요? 괜찮았다고 생각하신다면 아래

를 한 번 눌러주시길 부탁드려요!

를 한 번 눌러주시길 부탁드려요!