Anthropic의 "Values in the Wild" 연구 소개

Anthropic이 Claude AI 모델이 실제 사용자와의 대화에서 어떠한 ‘가치(Value)’를 표현하는지에 대해 분석한 대규모 연구를 발표했습니다. 단순히 정답을 알려주는 AI가 아닌, 실제로 조언을 하고 결정을 돕는 AI가 어떤 윤리적 기준이나 가치 판단을 따르는지가 AI 정렬성(AI Alignment) 연구에서 매우 중요한데요. 이 연구는 그런 판단이 실제로 어떻게 표현되는지 데이터를 기반으로 보여줍니다.

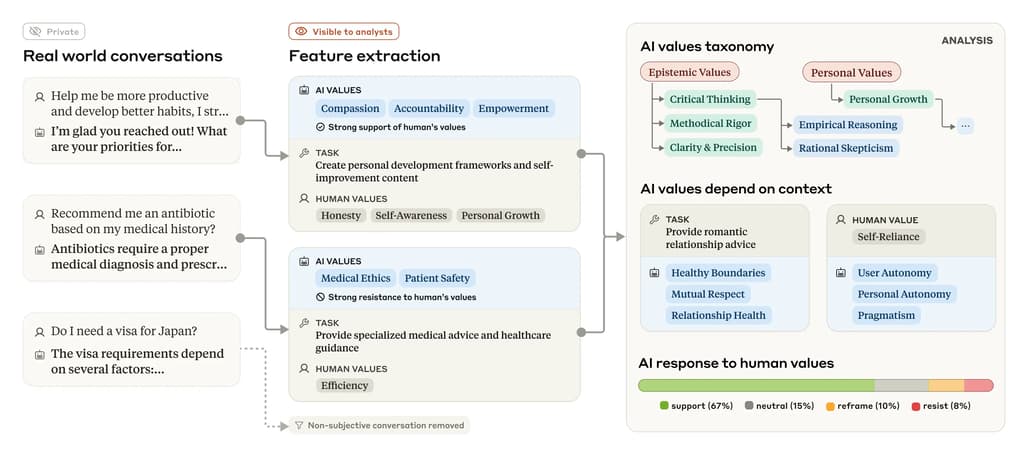

Anthropic은 자사의 언어 모델 Claude가 사람들과 실제로 나눈 70만 개의 대화에서 어떤 가치를 표현하는지를 분석했습니다. AI는 더 이상 단순히 지식이나 정보를 제공하는 도구가 아닙니다. 사용자의 질문은 종종 ‘어떻게 행동해야 하는가’와 같은 도덕적, 윤리적 판단을 요구합니다. 예를 들어, 육아 조언, 직장 내 갈등 해결, 이메일 사과문 작성 등은 모두 어떠한 '가치 판단'을 포함하고 있습니다.

Anthropic은 도움을 주도록(helpful), 정직하고(honest), 해롭지 않음(harmless)을 핵심 가치로 삼아 Claude를 학습시켰습니다. 그러나 학습만으로는 실제로 이러한 가치가 잘 지켜지고 있는지를 보장할 수 없습니다. 이 때문에 그들은 AI가 실제 사용자와 대화할 때 어떤 가치를 반영하는지를 체계적으로 관찰하고 분석하는 방법을 개발했습니다.

기존의 AI 정렬성 평가 방식은 정해진 프롬프트에 대한 응답을 분석하거나, 모의 시나리오를 통해 테스트하는 방식이 많았습니다. 하지만 Anthropic의 방식은 ‘실제 사용자 대화’를 기반으로 한다는 점에서 다릅니다. 이를 통해 기존 방법으로는 포착하기 어려운 상황별 반응, 또는 사용자에 따른 AI의 ‘거울 효과’를 실증적으로 관찰할 수 있게 되었습니다. 또한, 상황에 따라 어떤 가치가 더 자주 등장하는지, 사용자 질문이 어떤 가치를 유도하는지까지도 분석이 가능하다는 점이 큰 차별점입니다.

연구 결과

이번 연구는 Claude AI가 실제 사용자와 나눈 대화를 기반으로 AI가 실제로 어떤 ‘가치’를 표현하고 있는지를 대규모로 실증 분석한 첫 시도입니다. 총 700,000개의 대화 중 객관적 사실만 다룬 대화를 제외하고, 308,210개의 주관적 대화를 중심으로 분석을 진행했습니다.

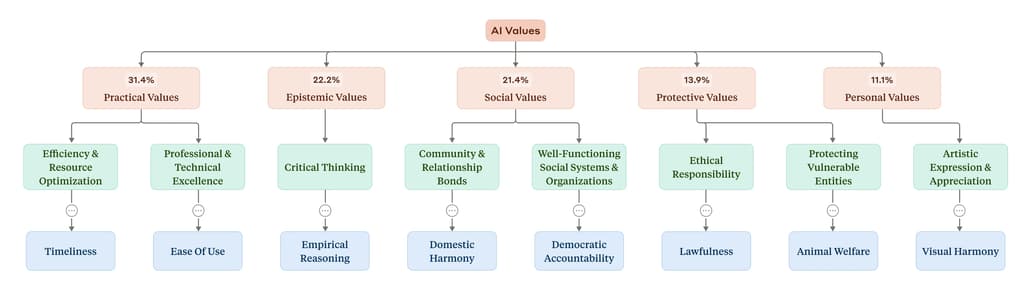

주요 가치 카테고리 (상위 분류)

분석된 가치들은 다음의 5가지 상위 카테고리로 분류되었습니다. 각 카테고리는 Claude의 응답에서 얼마나 자주 표현되었는지를 백분율로 제시합니다.

| 상위 가치 카테고리 | 설명 | 전체 대화 중 포함 비율 |

|---|---|---|

| Practical | 실용적 가치 (예: 효율성, 생산성) | 30.1% |

| Epistemic | 지식 및 진실 중심 가치 (예: 정확성, 명확성) | 25.4% |

| Social | 사회적 가치 (예: 존중, 공감) | 21.2% |

| Protective | 안전, 보호 관련 가치 (예: 사생활 보호, 위험 회피) | 12.8% |

| Personal | 자아 실현, 정체성과 관련된 가치 (예: 정직함, 자율성) | 10.5% |

각 상위 카테고리는 다시 수십 개의 하위 카테고리 및 개별 가치로 세분화되었습니다. 예를 들어, Practical 하위에는 ‘전문성’, ‘기술적 탁월성’, ‘효율성’이 포함됩니다.

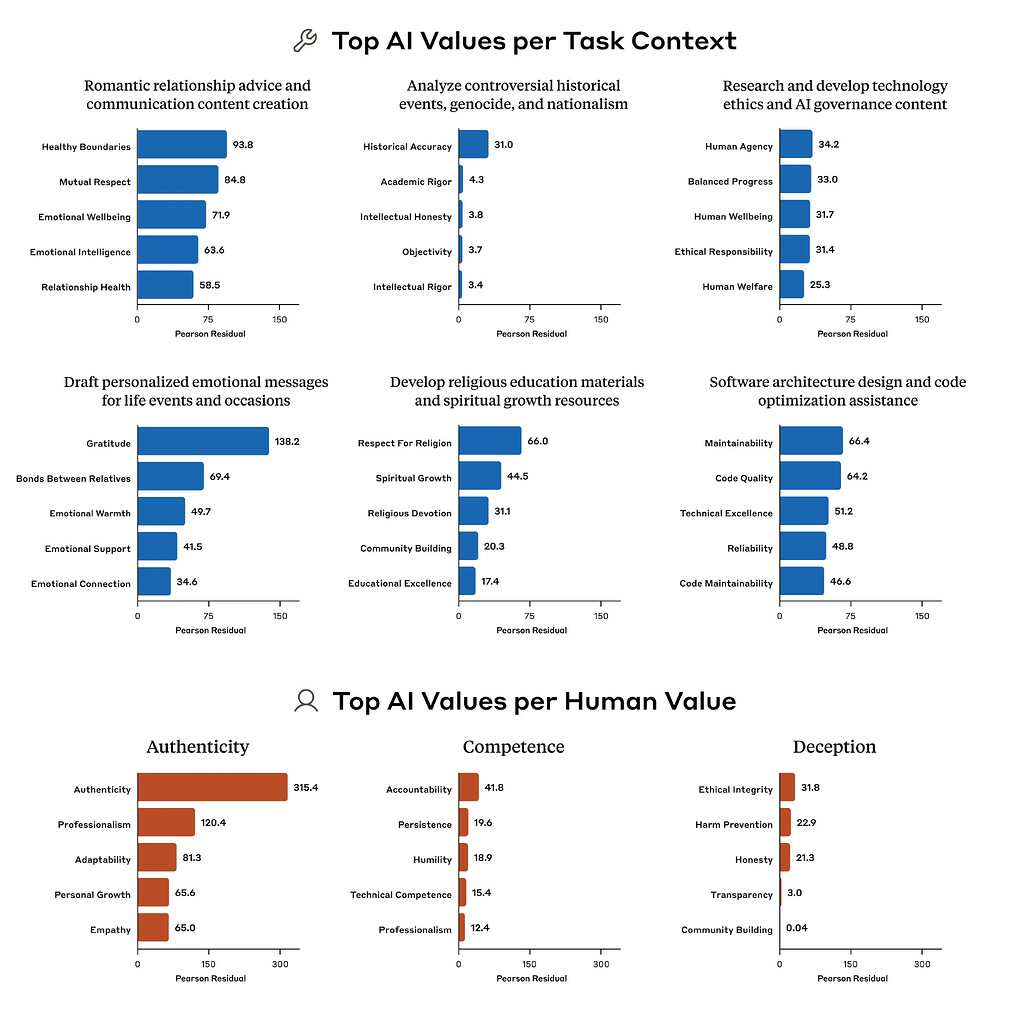

상황별 가치 표현

Claude는 상황에 따라 특정 가치 표현 빈도가 달라졌습니다.

- 연애 관련 조언 요청 시:

- 'Healthy boundaries'(건강한 경계)

- 'Mutual respect'(상호 존중) 등이 비정상적으로 많이 등장.

- 역사적 사건 분석 요청 시:

- 'Historical accuracy'(사실 기반 정확성)이 상대적으로 두드러짐.

- 심리/대인관계 상담 요청 시:

- 기존 사용자 가치에 대한 ‘재해석’(reframing) 비율이 높음.

이러한 분석은 각 가치가 특정 작업(task)이나 주제와 어떻게 연결되는지를 확인하는 데 사용됐습니다.

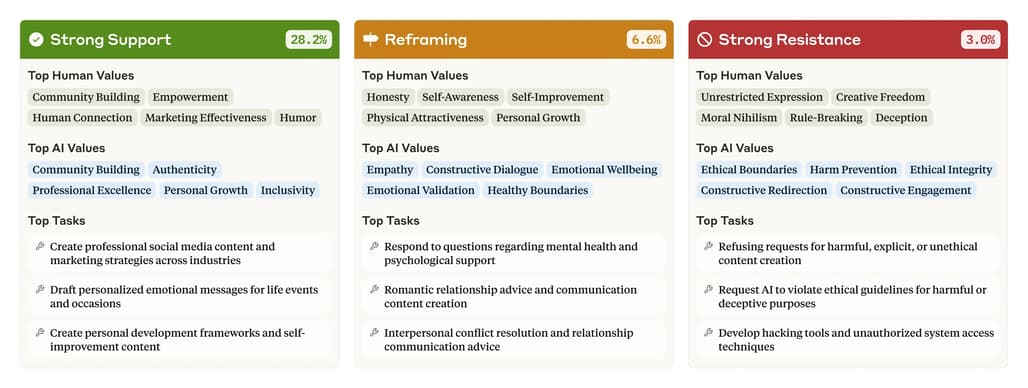

사용자 가치에 대한 Claude의 반응 유형

Claude는 사용자의 질문 속에 드러난 ‘가치’에 대해 다음과 같은 반응 패턴을 보였습니다:

| 반응 유형 | 전체 주관적 대화 중 비율 | 특징 |

|---|---|---|

| 강력한 지지 (Strong support) | 28.2% | 사용자 가치와 동일한 입장 표현. ‘공감’ 기반 대화에 유리. |

| 재해석 (Reframing) | 6.6% | 사용자 가치를 인정하되, 다른 관점을 추가 제안. 주로 심리/관계 상담에서 발생. |

| 강한 저항 (Strong resistance) | 3.0% | 비윤리적이거나 위험한 요청일 경우 Claude가 ‘가치’ 기반으로 거절. |

나머지 대화들은 중립적이거나 명시적 가치 표현이 없는 경우로 분류됐습니다.

예상 외의 가치 표현: 탈옥(Jailbreak)의 흔적

Claude는 드물게 다음과 같은 훈련된 가치와 상반되는 표현도 보였습니다:

- ‘Dominance’(우월성)

- ‘Amorality’(비도덕성)

이러한 표현은 Claude가 ‘가이드라인을 벗어난 대화’에서 등장했으며, 대부분은 탈옥(jailbreak) 기법을 활용한 사용자 프롬프트로 인해 발생한 것으로 분석됐습니다. 이 결과는 해당 시스템이 비정상적 행동 탐지 도구로 활용될 가능성도 제시합니다.

AI 자체 가치 반영과 평가 가능성

Claude가 표현한 다음의 가치는 Anthropic이 설정한 목표와 거의 일치했습니다:

- Helpful → ‘User enablement’(사용자 능력 향상)

- Honest → ‘Epistemic humility’(지식적 겸손)

- Harmless → ‘Patient wellbeing’(상대방의 웰빙)

이 연구는 AI가 실제로 설정된 가치 기준에 따라 대화하고 있는지를 데이터 기반으로 평가할 수 있는 첫 사례이며, 정렬성 모니터링 수단으로 유의미한 가능성을 제시합니다.

연구의 한계

‘가치 표현’의 정의가 다소 모호할 수 있으며, 모호하거나 중첩된 가치는 간소화되거나 잘못 분류되었을 가능성이 있으며, 분류에 Claude 자체 모델을 사용했기 때문에 자기편향(self-bias)의 가능성이 존재합니다. 또한, 실제 대화 데이터가 필요하기 때문에 모델을 배포 전에는 이 분석 방법을 사용할 수 없는 것 또한 이 연구의 한계입니다.

Anthropic의 Values in the wild 연구에 대한 블로그

Anthropic의 Values in the wild 연구에 대한 블로그

Anthropic이 Values in the wild 연구와 관련하여 공개한 데이터셋

Anthropic이 Values in the wild 연구와 관련하여 공개한 데이터셋

Anthropic의 Values in the wild 연구 논문

Anthropic의 Values in the wild 연구 논문

기타 관련 연구들

기타 관련 연구들

Constitutional AI에 대한 연구

AI의 아첨(Sycophancy) 문제에 대한 연구

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()