좋은 글들을 올려주시고 한국어 번역을 허락해주신 ENCORD에서 행사를 진행하신다고 알려오셨습니다! ![]()

최근 InstructBLIP 등과 같은 여러 Multimodal 모델들이 속속 등장하는 가운데, 직접 서비스를 만들고자 고민하시는 분들께는 좋은 기회가 될 것 같습니다.

다만 시간이 June 14th at 5pm BST (BST가 British Summer Time인걸 처음 알았습니다 ,![]() )

)

(한국 시간으로) 새벽 1시라 실시간 참석은 쉽지 않을 것 같은데요... 녹화 영상 제공이 되는지 문의해보겠습니다. ![]()

아래는 온라인 행사 정보입니다

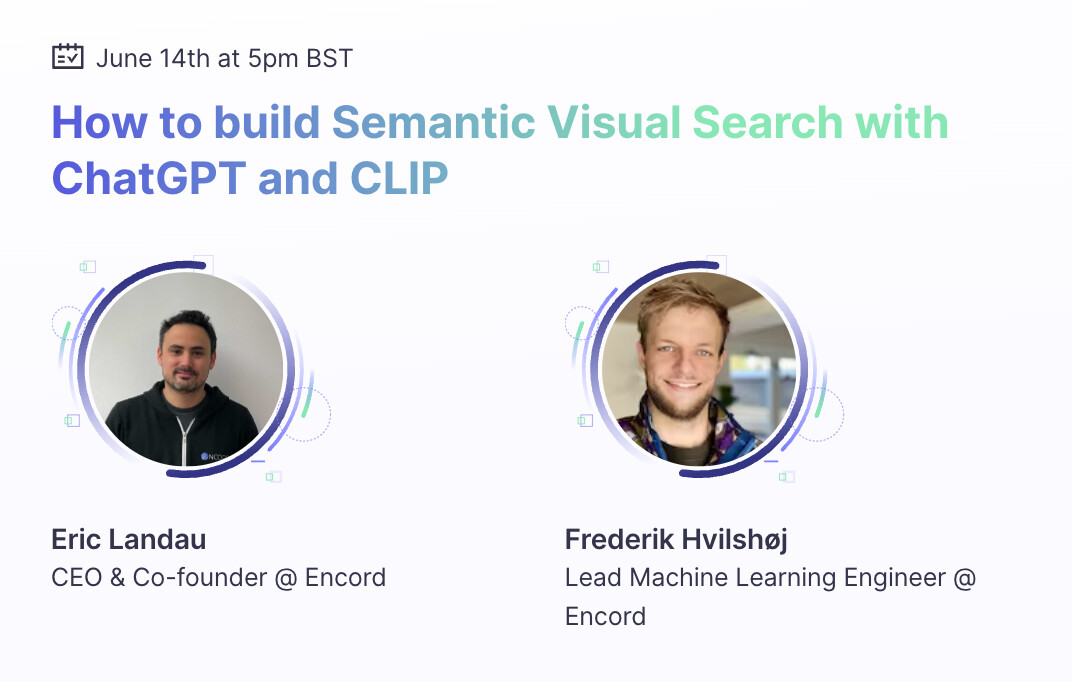

ChatGPT와 CLIP을 사용한 Semantic Visual Search 만들기

How to build Semantic Visual Search with ChatGPT and CLIP

이 웨비나에서 무엇을 얻을 수 있나요?

OpenAI의 ChatGPT와 CLIP 릴리스는 조직과 개인 기여자가 사용자에게 기능을 제공하는 방식에 혁신을 가져왔습니다. Encord에서는 신경망(CLIP)과 LLM(ChatGPT)을 결합하여 효과적이고 강력한 시맨틱 시각 검색을 구축하는 방법에 중점을 두었습니다.

OpenAI’s ChatGPT and CLIP releases have revolutionised the ways in which organisations and individual contributors can ship features to their users. At Encord, we’ve focused on how the neural network (CLIP) and LLM (ChatGPT) can be combined to build an effective and powerful Semantic Visual Search.

제너레이티브 AI 박사 학위를 취득한 수석 머신러닝 엔지니어 프레데릭 흐빌쇼이(Frederik Hvilshøj)가 Encord의 CEO이자 공동 창립자인 에릭 랜도(Eric Landau)와 함께 이 기능을 처음부터 구축하는 방법에 대한 실행 가능한 인사이트를 제공할 것입니다. 의제는 다음과 같습니다:

Frederik Hvilshøj, Lead ML Engineer with a PhD in Generative AI, will join Eric Landau, CEO and Co-Founder of Encord, to provide actionable insights into how to build this function from scratch. Here’s the agenda:

![]() OpenAI 출시 전 시맨틱 시각적 검색 소개

OpenAI 출시 전 시맨틱 시각적 검색 소개

![]() CLIP과 ChatGPT로 시맨틱 시각적 검색을 구축하는 방법에 대한 라이브 워크스루

CLIP과 ChatGPT로 시맨틱 시각적 검색을 구축하는 방법에 대한 라이브 워크스루

![]() 공개 Q&A

공개 Q&A

![]() 팀이 사용한 리소스에 액세스

팀이 사용한 리소스에 액세스

- Introduction to Semantic Visual Search before OpenAI’s releases

- Live walkthrough on building Semantic Visual Search with CLIP and ChatGPT

- Open Q&A

- Access to the resources the team used