오랜만에 Cloudflare에 들어갔다가, 좌측 메뉴에 AI라는게 있길래 뭔가하고 봤더니, 최근(9/27)에 서비스를 출시했었네요 ![]()

AWS의 Lambda와 비슷한 Cloudflare의 Worker에 연결하여 GPU 기반으로 빠르게 추론(inference)를 해주는 것이 핵심인 것 같습니다.

올해 말까지 전세계에 위치한 Cloudflare 데이터센터 중 100여곳에서, 2024년까지 Cloudflare의 데이터센터 대부분에서 지원하는 것이 목표라고 합니다.

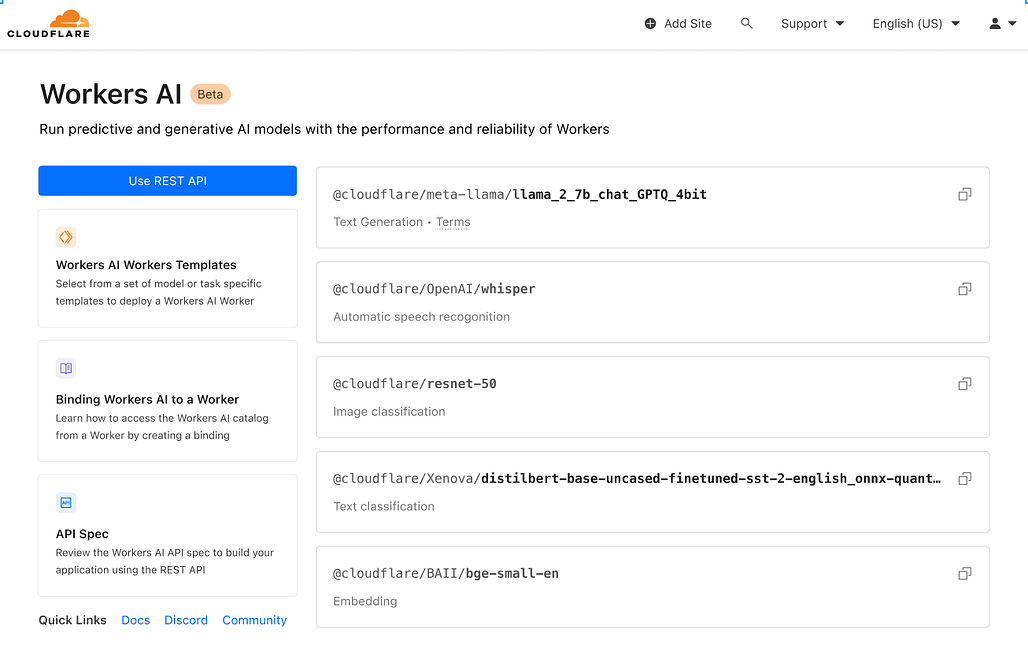

대략 6개 분야에서 다음과 같은 모델들을 지원하는 것을 시작으로 계속 늘려나갈 것 같습니다.

- Text generation (large language model): meta/llama-2-7b-chat-int8

- Automatic speech recognition (ASR): openai/whisper

- Translation: meta/m2m100-1.2

- Text classification: huggingface/distilbert-sst-2-int8

- Image classification: microsoft/resnet-50

- Embeddings: baai/bge-base-en-v1.5

가격은 2종류로 나뉘는데, 가용한 데이터센터에서 실행되는 RTN(Regular Twitch Neurons)은 뉴런 1000개당 $0.01, CDN처럼 사용자에게서 가장 가까운 곳에서 실행되는 FTN(Fast Twitch Neurons)는 뉴런 1000개당 $0.125입니다.

블로그 글에서 설명하기로는, 뉴런 1000개로는 130개의 LLM 응답, 830개의 이미지 분류 또는 1,250개의 임베딩을 생성할 수 있다고 하네요. ![]()

- Regular Twitch Neurons (RTN) - running wherever there's capacity at $0.01 / 1k neurons

- Fast Twitch Neurons (FTN) - running at nearest user location at $0.125 / 1k neurons

아직 가격에 대한 감은 잘 안오지만, 이런 류의 서비스가 많아지는 것은 환영할만한 일인 것 같습니다. (GPU는 여전히 비싸고 큰 모델은 계속 나오지만, 그래도 여러 곳의 서비스들이 경쟁하다보면 저렴해지지 않을까요? ![]() )

)

\

더 읽어보기

더 자세한 내용은 아래의 출시 소개 블로그를 참고해보세요~

Workers AI 소개글(영어):

https://blog.cloudflare.com/workers-ai/