Continuous Thought Machine(CTM) 소개

Sakana AI가 생물학적 뇌의 시간 기반 동기화 원리를 모방한 새로운 신경망 아키텍처, Continuous Thought Machine(CTM)을 공개했습니다. 기존의 딥러닝 모델과는 다른 방식으로 “생각”하는 이 모델은, 인간과 유사한 사고 과정을 구현하려는 시도입니다. 특히, 시간에 따른 뉴런 간의 동기화를 통해 문제를 해결하는 방식은 기존 AI 모델과 차별화됩니다.

현대의 인공지능 모델은 주로 입력에 대한 즉각적인 출력에 초점을 맞추며, 시간에 따른 뉴런의 활동 패턴은 대부분 무시되어 왔습니다. 그러나 생물학적 뇌에서는 뉴런 간의 정밀한 타이밍과 동기화가 중요한 역할을 합니다. Sakana AI가 공개한 CTM은 이러한 생물학적 원리를 모방하여, 시간에 따른 뉴런의 동기화를 중심으로 사고하는 새로운 신경망 아키텍처입니다.

CTM은 뉴런이 자신의 과거 활동 이력을 기반으로 현재의 출력을 결정하며, 뉴런 간의 동기화 패턴을 통해 정보를 처리합니다. 이러한 방식은 기존의 피드포워드 네트워크나 트랜스포머와는 다른, 보다 유연하고 해석 가능한 사고 과정을 가능하게 합니다. 특히, CTM은 문제를 단계적으로 “생각”하며 해결하는 과정을 보여주어, 인간의 사고 방식과 유사한 특성을 지닙니다.

Continuous Thought Machine(CTM)의 핵심 개념

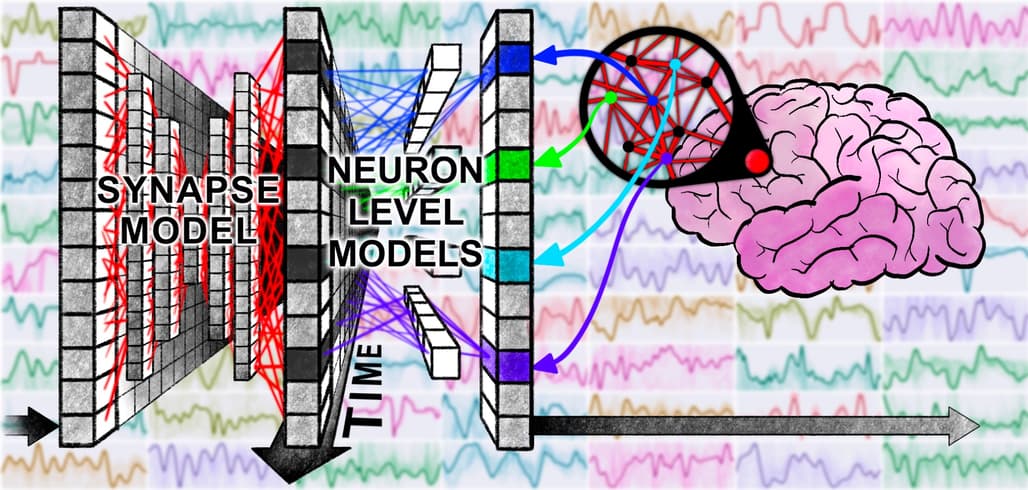

Continuous Thought Machine(CTM)은 기존의 인공신경망 모델들과 달리, 시간적 정보와 뉴런 간의 상호작용을 핵심 연산 단위로 끌어올립니다. 이 아키텍처의 본질은 “생각한다”는 개념을 계산 가능한 프로세스로 환원하는 데 있으며, 이를 위해 CTM은 내부적으로 세 가지 주요 구조적 아이디어(내부 사고 차원, 뉴런 수준 모델, 동기화 기반 표현)를 사용합니다.

CTM은 아래 세 가지 개념을 하나의 사고 메커니즘으로 통합합니다. 내부 tick은 사고의 흐름을 만들고, 각 뉴런 수준 모델은 입력의 시간적 패턴을 감지하며, 그 결과로 형성된 동기화 표현은 CTM이 세계를 인식하고 반응하는 기반이 됩니다. 결과적으로 CTM은 시간에 따라 사고를 전개하고, 각 뉴런이 개별적인 기억을 가지며, 뉴런들 간의 관계를 통해 사고의 결과를 만들어내는, 생물학적 뇌의 연산 원리에 매우 근접한 인공지능 아키텍처입니다.

내부 사고 차원(Internal Ticks)

전통적인 시퀀스 모델(RNN, Transformer 등)은 외부 데이터가 지닌 순차성에 따라 연산 순서를 결정합니다. 그러나 CTM은 입력 시퀀스의 길이나 외부 데이터의 시퀀스에 의존하지 않고, “internal tick”이라고 부르는 스스로 사고가 전개되는 자체적인 ‘사고 단계’를 진행합니다. 또한, CTM은 각 tick에서 신경망은 생각을 한 번 진행합니다. 이를 통해 모델은 정적인 데이터(예: 이미지, 정수 배열)에도 반복적으로 사고를 수행할 수 있게 되며, 각 internal tick은 모델이 한 번 더 “생각”한 결과를 축적하는 과정으로 기능합니다. 이 내부 시간 차원은 완전히 독립적으로 동작하며, CTM이 데이터를 충분히 분석할 때까지 사고를 이어가게 해줍니다. 이는 마치 인간이 어려운 문제일수록 더 오랫동안 생각하는 것과 유사한 구조로, CTM은 Adaptive Compute를 자연스럽게 실현할 수 있습니다.

뉴런 수준 모델(Neuron-Level Models, NLM)

기존의 딥러닝 모델에서는 모든 뉴런이 동일한 활성화 함수(e.g., ReLU)를 공유하며, 단일한 스칼라 값을 기반으로 연산합니다. 반면 CTM에서는 각 뉴런이 고유한 MLP 구조를 갖는 독립적인 처리 유닛으로 설계되어 있습니다. 이 뉴런 수준 모델은 단일 값이 아닌 과거 일정 기간의 사전 활성화(pre-activation) 값을 시계열로 받아들여 이를 처리하고 사후 활성화(post-activation) 값을 출력합니다.

즉, 뉴런이 순간적인 입력에만 반응하는 것이 아니라 자신이 받은 자극의 시간적 패턴을 기억하고 학습합니다. 이는 생물학적 뉴런이 시간에 따라 누적된 입력을 통해 발화 결정을 내리는 방식과 매우 유사하며, 각 뉴런이 자기만의 “과거 해석 방식”을 가질 수 있다는 점에서 계산적 다양성과 표현력을 비약적으로 증가시킵니다.

동기화 기반 표현(Synchronization Representation)

CTM은 뉴런들이 발화한 사후 활성화(post-activation) 값들을 시간 축으로 배열한 뒤, 이들의 유사도를 내적(dot product) 방식으로 계산하여 뉴런 간의 동기화 행렬을 생성합니다. 이는 뉴런들이 시가에 따라 어떤 식으로 함께 활성화(synchronize)되는지를 측정하는 것으로, 다음과 같이 표현할 수 있습니다:

이 동기화 행렬은 CTM이 외부 데이터를 인식하거나 예측을 생성할 때 사용하는 잠재 표현(latent representation)으로 사용됩니다. 즉, 모델이 데이터를 어떻게 ‘이해’했는지를 나타내는 벡터가 개별 뉴런의 상태가 아닌, 뉴런들 간의 동기화 관계로 정의된다는 점에서 기존의 벡터 기반 표현 패러다임을 벗어납니다. 이 구조는 정보 표현의 밀도와 해상도를 극적으로 향상시킬 뿐만 아니라, 신경망의 행동을 더 해석 가능하게 만듭니다. 왜냐하면 어떤 뉴런 쌍이 함께 발화하는지를 살펴보는 것만으로도, 모델이 어떤 특징을 주의 깊게 분석했는지를 파악할 수 있기 때문입니다.

CTM 실험 사례

ImageNet 이미지 분류: 사고를 통한 시각적 이해

ImageNet 실험은 CTM이 정적인 시각 데이터를 시간적으로 사고하며 분류하는 과정을 보여줍니다. 전통적인 모델은 한 번의 전방향 처리로 이미지를 분류하는 반면, CTM은 여러 internal tick 동안 이미지 정보를 반복적으로 관찰하고 분석합니다. 초기에는 불확실한 정보를 기반으로 예측을 시작하지만, tick이 거듭되면서 attention 위치가 변화하고 뉴런 간의 동기화 구조가 발전함에 따라 점점 더 정확하고 확신 있는 예측을 만들어냅니다.

이 실험에서 내부 사고 차원은 CTM이 정적인 이미지에 대해 동적인 사고 과정을 부여하는 데 사용되며, 뉴런 수준 모델은 이미지의 다양한 부분을 서로 다른 방식으로 해석하게 만듭니다. 특히, 동기화 기반 표현은 시각 피처에 대한 CTM의 ‘이해’를 압축적으로 표현하며, 특정 클래스에 대한 예측이 어떻게 강화되었는지를 시각화할 수 있게 해줍니다.

2D Maze 탐색: 위치 정보 없이 경로를 찾는 사고 모델

미로 실험은 CTM이 위치 정보(positional embedding) 없이도 문제 공간을 모델링하고 추론할 수 있음을 보여주는 매우 강력한 사례입니다. 모델은 단지 미로의 픽셀 맵을 입력받고, 내부 tick을 반복하며 어디로 가야 하는지 판단합니다. 출력은 간단한 명령어(위, 아래, 왼쪽, 오른쪽 등)로 구성된 경로입니다.

이 실험에서 내부 tick은 경로 탐색을 위한 사고 단위로 작용하며, 각 tick마다 CTM은 이전의 뉴런 상태와 attention 결과를 바탕으로 다음 결정을 내립니다. 뉴런 수준 모델은 각 지점에서 주변 지형과 가능한 이동 방향을 시간적으로 해석하며, 그 결과 뉴런 간 동기화 구조가 **내부 세계 모델(world model)**로 기능하게 됩니다. 특히 주목할 점은 동기화 행렬을 기반으로 생성된 attention query가 실제 미로 경로의 구조를 따라 움직이며, 이는 CTM이 미로를 ‘이해’하고 있다는 증거로 작용합니다.

Parity 문제: 순서를 무시하고도 순서를 추론

Parity(짝수/홀수 여부) 문제는 간단하지만 깊이 있는 실험입니다. CTM은 64개의 이진 숫자(1, -1)가 포함된 벡터를 입력으로 받아 각 위치까지의 누적 곱의 부호(=짝수/홀수)를 예측해야 합니다. 데이터는 순차적으로 주어지지 않으며, 전체 벡터가 한꺼번에 입력됩니다.

이 경우, CTM은 각 tick마다 입력을 반복적으로 훑으며, 주의(attention)를 이동시켜 자신이 어떤 요소를 봐야 정답을 만들 수 있을지를 결정합니다. 어떤 모델은 입력을 뒤에서 앞으로 읽으며 마지막에 결론을 내리는 전략을 학습했고, 또 어떤 모델은 앞에서부터 차근차근 예측을 갱신해가며 결과에 접근했습니다. 이는 내부 tick과 attention이 결합되어 전략적 사고를 구현한 사례입니다. 뉴런 수준 모델은 입력 값의 부호 변화를 시간적으로 추적하며, 동기화 구조는 중간 계산 상태를 보존하고 해석하는 수단이 됩니다.

Continuous Thought Machine 소개 블로그

Continuous Thought Machine 소개 블로그

Continuous Thought Machine 인터랙티브 데모 및 상세 소개

Continuous Thought Machine 인터랙티브 데모 및 상세 소개

Continuous Thought Machine 논문

Continuous Thought Machine 논문

Continuous Thought Machine GitHub 저장소

Continuous Thought Machine GitHub 저장소

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()