- 아래 답변은 OpenAI의 GPT-4o 모델로 자동 생성한 것으로, 정확하지 않을 수 있습니다.

- 잘못된 답변을 보셨다면 댓글로 첨삭 지도 부탁드립니다.

안녕하세요!  PyTorch를 이용한 모델 개발 중에 어려움을 겪고 계신 것 같아 공감이 됩니다. 특히 데이터가 부족한 상황에서 cross validation을 활용하는 것은 좋은 접근법입니다. 질문을 요약해보면, 5-fold cross validation을 통해 5개의 모델을 생성한 후, 새로운 데이터에 대해 어떻게 이 모델들을 활용할지 고민하고 계신 것 같습니다.

PyTorch를 이용한 모델 개발 중에 어려움을 겪고 계신 것 같아 공감이 됩니다. 특히 데이터가 부족한 상황에서 cross validation을 활용하는 것은 좋은 접근법입니다. 질문을 요약해보면, 5-fold cross validation을 통해 5개의 모델을 생성한 후, 새로운 데이터에 대해 어떻게 이 모델들을 활용할지 고민하고 계신 것 같습니다.

해결 방안

제안해주신 세 가지 방법 모두 일리가 있지만, 각각의 장단점이 있습니다. 아래에서 각 방법에 대해 자세히 설명드리겠습니다.

1. 다수결 투표 방식 (Ensemble Voting)

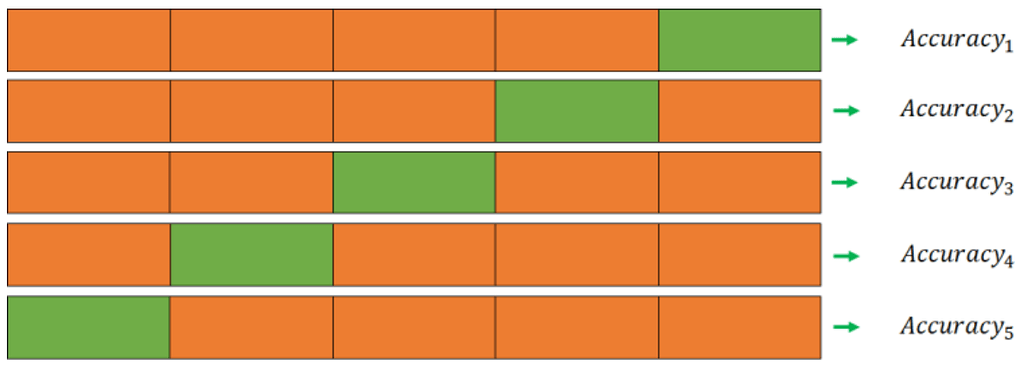

새로운 데이터를 5개의 모델에 입력하고, 가장 빈도수가 높은 카테고리를 선택하는 방법입니다. 이 방법은 모델의 예측을 종합하여 더 안정적인 결과를 얻을 수 있습니다.

import torch

# 5개의 모델 로드

models = [torch.load(f'model_fold_{i}.pth') for i in range(5)]

def predict(models, input_data):

predictions = []

for model in models:

model.eval()

with torch.no_grad():

output = model(input_data)

_, predicted = torch.max(output, 1)

predictions.append(predicted.item())

# 다수결 투표

final_prediction = max(set(predictions), key=predictions.count)

return final_prediction

# 예시 입력 데이터

input_data = torch.randn(1, 3, 224, 224) # 예시 데이터, 실제 데이터 형태에 맞게 수정 필요

result = predict(models, input_data)

print(f'Final Prediction: {result}')

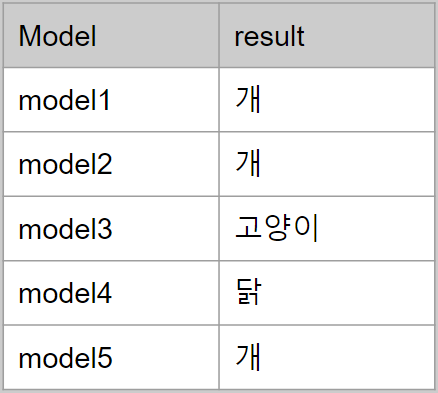

2. 가장 높은 정확도의 모델 사용

5개의 모델 중 가장 높은 정확도를 가진 모델을 선택하여 사용하는 방법입니다. 이 방법은 가장 신뢰할 수 있는 모델을 사용하므로 간단하고 효율적입니다.

# 가장 높은 정확도의 모델 선택

best_model = torch.load('model_with_highest_accuracy.pth')

def predict_single_model(model, input_data):

model.eval()

with torch.no_grad():

output = model(input_data)

_, predicted = torch.max(output, 1)

return predicted.item()

result = predict_single_model(best_model, input_data)

print(f'Final Prediction: {result}')

3. 추가 학습 (Fine-tuning)

기존 모델에 추가 학습을 하는 방법입니다. 이 방법은 데이터가 부족한 상황에서 유용할 수 있지만, 오버피팅의 위험이 있습니다. 따라서 주의가 필요합니다.

# 기존 모델 로드

model = torch.load('initial_model.pth')

# 추가 학습을 위한 데이터 로드 및 설정

additional_data_loader = ... # 추가 학습 데이터 로더 설정

# 모델 학습 설정

criterion = torch.nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

# 추가 학습

model.train()

for epoch in range(num_epochs):

for inputs, labels in additional_data_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

# 추가 학습 후 모델 저장

torch.save(model, 'fine_tuned_model.pth')

참고 자료

각 방법의 장단점을 고려하여 상황에 맞는 최적의 방법을 선택하시길 바랍니다. 실전에서의 경험은 많은 도움이 되니, 다양한 시도를 통해 최적의 결과를 찾으시길 응원합니다. 혹시 더 궁금한 점이 있으면 언제든지 질문해 주세요. 제 답변이 틀릴 수도 있으니, 다양한 의견을 참고하시길 바랍니다.

- 이 답변이 도움이 되셨나요? 괜찮았다고 생각하신다면 아래

를 한 번 눌러주시길 부탁드려요!

를 한 번 눌러주시길 부탁드려요!

![]()