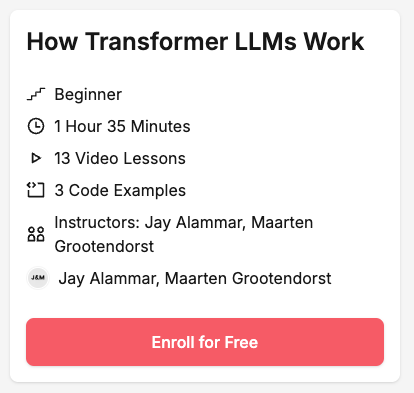

"How Transformer LLMs Work" 강의 소개

Andrew Ng이 설립한 DeepLearning.AI에서 Transformer 기반 대형 언어 모델(LLM)의 작동 원리를 다루는 새로운 무료 강의를 공개했습니다. Transformer 모델이 어떻게 동작하는지 이해하면, LLM을 더 효과적으로 활용할 수 있고, 다양한 애플리케이션에 적용할 때 더욱 깊이 있는 접근이 가능합니다.

이 강의에서는 Transformer 모델의 핵심 원리 를 학습하고, 최신 연구에서 발전한 Multi-query Attention, Grouped Query Attention, Sparse Attention 같은 개선 사항도 다룹니다. 특히, 토큰화(tokenization), 임베딩(embedding), 셀프 어텐션(self-attention), Transformer 블록 등의 핵심 개념을 쉽게 익힐 수 있습니다.

"How Transformers LLMs Work" 강의는 GPT-2를 비롯하여 DeepSeek-R1 등의 모델이 어떻게 동작하는지를 시각화한 글들로 유명한 Jay Alammar가 "Hands-on Large Language Models" 도서를 공동 집필한 Maarten Grootendorst와 함께 제작했으며, 중점적으로 다루는 내용은 다음과 같습니다:

-

Bag-of-Words, Word2Vec부터 Transformer까지 언어 표현 방식의 진화

-

토큰화 과정과 다양한 토크나이저 전략 비교

-

Transformer 블록의 셀프 어텐션(Self-Attention)과 피드포워드(Feedforward) 레이어 원리

-

모델 연산 속도를 높이기 위한 KV 캐시(Key-Value Cache)와 계산 최적화 기법

-

Hugging Face Transformers 라이브러리 를 활용한 최신 모델 실습

"How Transformer LLMs Work" 강의 목차

이 강의는 총 13개의 비디오 강의와 3개의 코드 실습으로 구성되어 있습니다.

-

1. 도입 (Introduction)

- 강의 개요 소개 (5분)

-

2. 언어 모델 이해하기 (Understanding Language Models)

-

Bag-of-Words 모델: 단어를 개별적인 토큰으로만 취급하는 기초적인 접근 (5분)

-

(Word) Embeddings: 단어 간 의미적 유사성을 벡터로 표현하는 방법 (5분)

-

Attention을 활용한 문맥 인코딩 및 디코딩 (5분)

-

Transformer 개념 소개 (7분)

-

-

3. 토큰화 (Tokenizers)

- 토크나이저 전략 및 코드 예제 (11분)

-

4. Transformer 모델 아키텍처 (Architectural Overview)

- Transformer의 주요 구조 개요 (6분)

-

5. Transformer 블록 (The Transformer Block)

- Transformer 네트워크에서 가장 중요한 단위인 Transformer 블록 구조 (6분)

-

6. 셀프 어텐션 (Self-Attention)

- 문맥을 학습하는 핵심 기술인 Self-Attention 기법 설명 (10분)

-

7. 모델 예제 (Model Example)

- Hugging Face Transformers 를 활용한 실습 코드 (9분)

-

8. 최신 Transformer 개선 기술 (Recent Improvements)

- Multi-query Attention, Grouped Query Attention, Sparse Attention 등 최신 연구 소개 (10분)

-

9. Mixture of Experts (MoE)

- LLM에서 연산 효율을 높이는 Mixture of Experts 기법 소개 (9분)

-

10. 결론 (Conclusion)

- 강의 요약 (1분)

-

11. 부록 (Appendix – Tips, Help, and Download)

- 코드 예제 다운로드 및 추가 학습 자료 (1분)

강의 보러 가기

강의 보러 가기

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()

![DeepLearning.AI, 트랜스포머 기반 LLM의 동작에 대한 무료 강의 공개 [무료/영어/온라인] (feat. Jay Alammar & Maarten Grootendorst)](https://discuss.pytorch.kr/uploads/default/original/2X/a/ab7c6aca1a2a3c2cf6799e77f47adef755d272b5.jpeg)