GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다. ![]()

소개

- StableDiffusion, Whisper, 오픈소스 LLM등을 이용한 AI도구를 만든다면 어디선가 계속 실행되어야 함

어떤 GPU를 써야할까?

Cloud GPU를 쓴다면:

- Falcon-40B, Falcon-40B-Uncensored, or Falcon-40B-Instruct

- 비용 상관없이 최고의 성능을 원한다면 H100 2개

- 비용과 성능 밸런스를 추구한다면 RTX 6000 Ada 2개(A6000 이나 RTX6000 아님)

- 저렴하게 원하면 A6000 2개

- MPT-30B

- 최고의 성능이나 가성비: H100 1개

- 저렴 : A100 80GB 1개

- Stable Diffusion

- 최고의 성능 : H100 1개

- 가성비 : 4090 1개

- 저렴 : 3090 1개

- Whisper

- Stable Diffusion과 같음

- Whisper-Large 는 더 적은 VRAM에서 실행가능하지만, 대부분 클라우드는 그런 카드가 없음

- 4090/3090도 잘 동작하고, CPU에서도 가능

- 대규모 LLM을 파인튜닝 한다면

- H100 클러스터 또는 A100 클러스터

- 대규모 LLM을 훈련하고 싶다면

- 대규모 H100 클러스터

로컬 GPU를 쓴다면:

- 대규모 H100 클러스터

- 위와 거의 같지만, LLM 훈련 및 파인튜닝은 불가

- 대부분의 LLM들은 작은 VRAM에서 실행 가능한 버전이 있음 (Falcon on 40GB)

모델들을 로컬에서 실행해야 할까? 클라우드 GPU로 실행해야 할까?

- 둘다 합리적인 선택임

- 모델을 클라우드에서 실행하려면 Runpod 의 템플릿이 가장 쉬운 선택임

- 가장 쉬운 옵션은 호스트된 인스턴스를 사용하는 것 : DreamStudio, RunDiffusion, Playground AI for stable diffusion 등

RTX 6000, A6000, 6000 Ada 은 무슨 차이야 ?

셋이 완전히 다름

- RTX 6000 (Quadro RTX 6000, 24 GB VRAM, 2018/08/13 출시)

- RTX A6000 (48 GB VRAM, 2020/10/05 출시)

- RTX 6000 Ada (48 GB VRAM, 2022/12/03 출시)

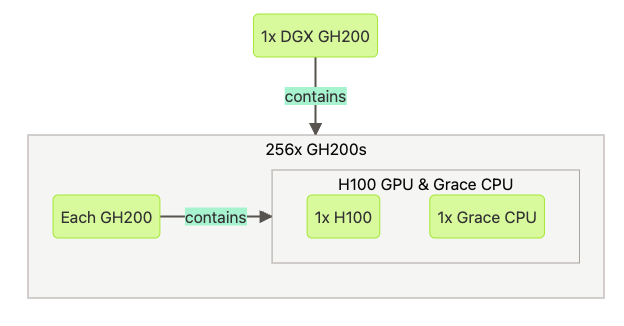

DGX GH200, GH200, H100?

- 1개의 DGX GH200 은 256개의 GH200 을 포함하고 있음

- 1개의 GH200 은 1개의 H100 과 1개의 Grace CPU를 포함

- 더 자세히 알아보려면: DGX GH200 vs GH200 vs H100 · GPU Utils ⚡️

H100 은 A100에서 큰 업그레이드인가 ?

- 당근. 스피드 향상이 매우 큼. H100은 A100 보다 더 많은 수의 GPU로 확장이 가능

- 즉 LLM 훈련에는 H100 여러대가 최고임

AMD, Intel, Cerebras 는 ?

- 현재로선 Nvidia가 제일 쉬움

어떤 GPU 클라우드를 써야할까 ?

- 다수의 A100/H100이 필요하다면: Oracle, FluidStack, Lambda Labs 등에 문의.

- 몇대의 A100이 필요하다면: FluidStack or Runpod

- H100 1개가 필요하다면: FluidStack or Lambda Labs

- 저렴한 3090s, 4090s, A6000s: Tensordock.

- Stable Diffusion 추론만 필요하다면: Salad.

- 다양한 종류의 GPU가 필요하다면: Runpod or FluidStack.

- 템플릿을 쓰거나 취미로 한다면: Runpod.

- 큰 클라우드는 가격이 비싸고 복잡함

- 더 자세히 알아보려면:

시작하기 가장 쉬운 GPU Cloud

- RunPod에서 템플릿 사용

- RunPod 파드는 완전한 기능을 갖춘 VM이 아니라 호스트 머신의 도커 컨테이너라는 점에 유의할 것

얼마나 많은 VRAM과 시스템 램, 몇개의 vCPU가 필요할까 ?

- VRAM (Video RAM / GPU RAM)

- Falcon-40B: 85-100GB

- MPT-30B: 80GB

- Stable Diffusion: 16GB+ 이상 선호

- Whisper: 12GB+. (OpenAI 버전을 사용하면 이정도, 커뮤니티 버전으로는 CPU로도 가능)

- System ram

- VRAM의 1~2배

- vCPUs

- 8-16 vCPU면 대규모 GPU 워크로드가 아닌 이상 충분

- 디스크 용량

- 유스케이스에 따라 다름. 잘 모르겠으면 100GB로 시작해서 유스케이스에 맞는지 볼 것

SXM나 PCIe, NVLink가 필요할까?

- 확신하지 못하겠다면, 우선은 중요하지 않다고 가정할 것

- 더 자세히 알아려면: NVLink, SXM, and PCIe · GPU Utils ⚡️

인피니밴드(InfiniBand)는?

- 1~2개의 GPU를 사용하는 경우에는 필요없음. 수천 개의 클러스터를 사용하는 경우 필요.