GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다. ![]()

소개

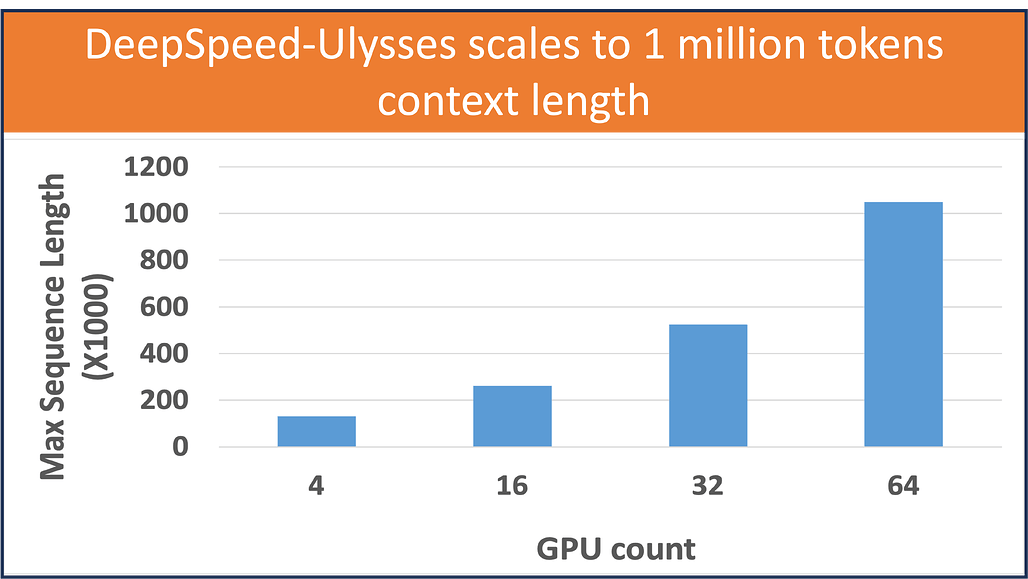

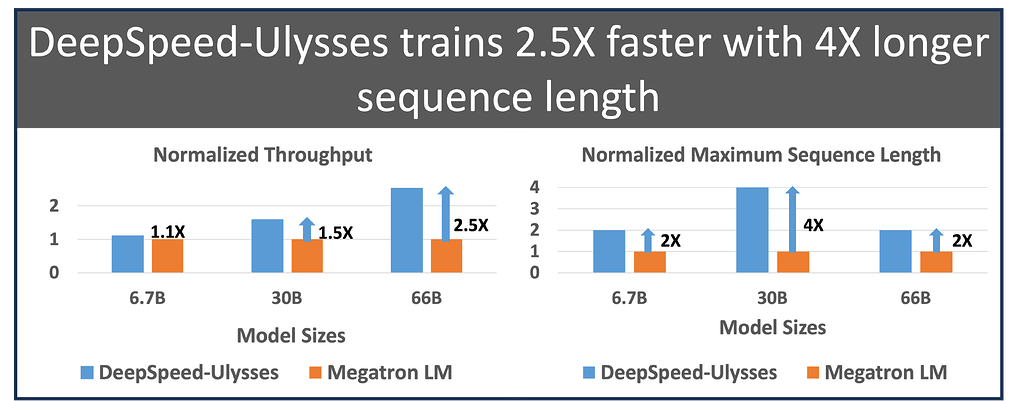

- 기존 시스템보다 4배 더 긴 시퀀스 길이를 제공, 백만개 이상의 토큰이 포함된 시퀀스로 훈련 가능

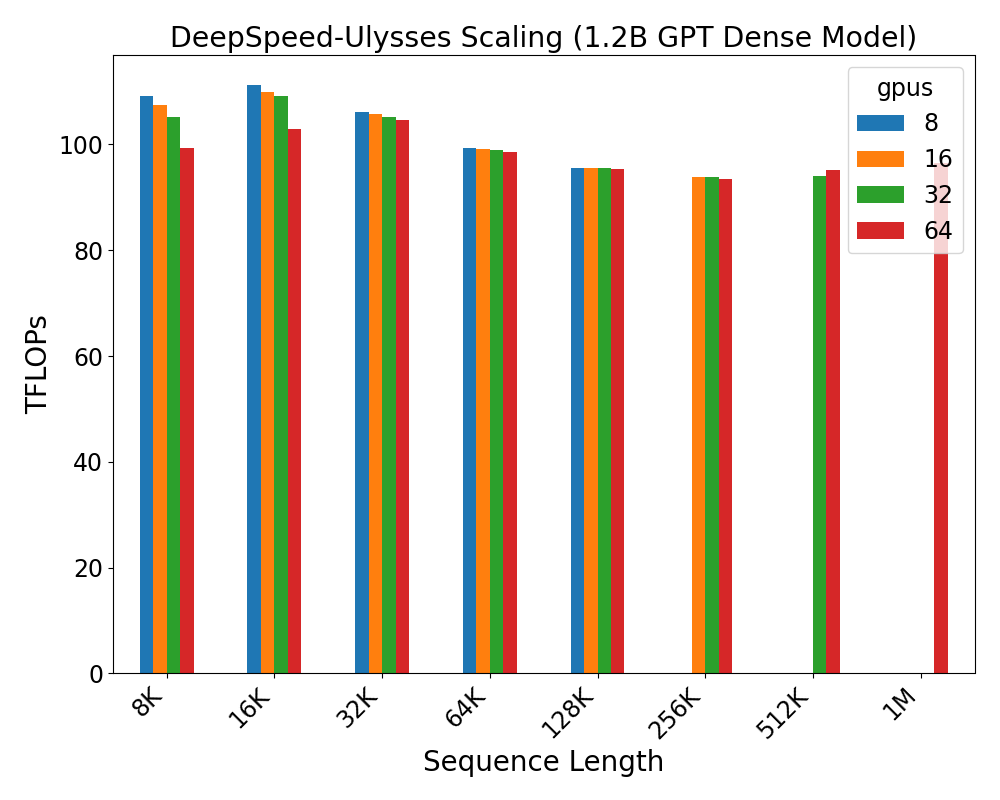

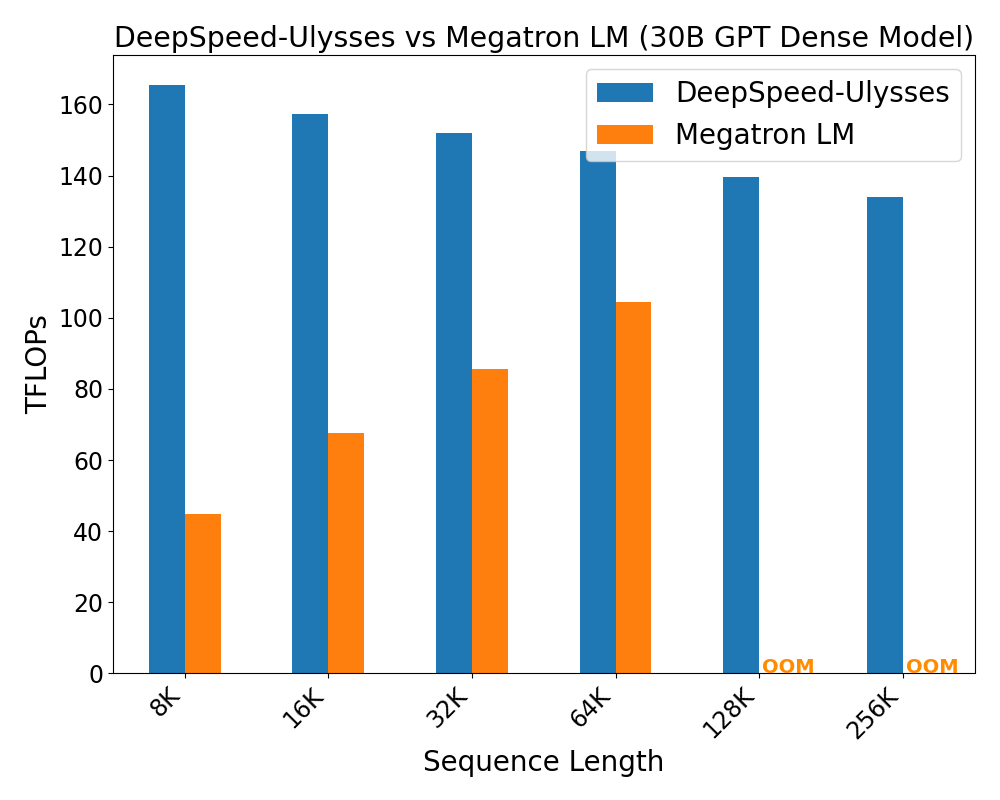

- 통신이 10배 이상 감소하여 처리량이 최대 2.5배 향상. 처리량이 175 TFlops/GPU 이상으로 유지

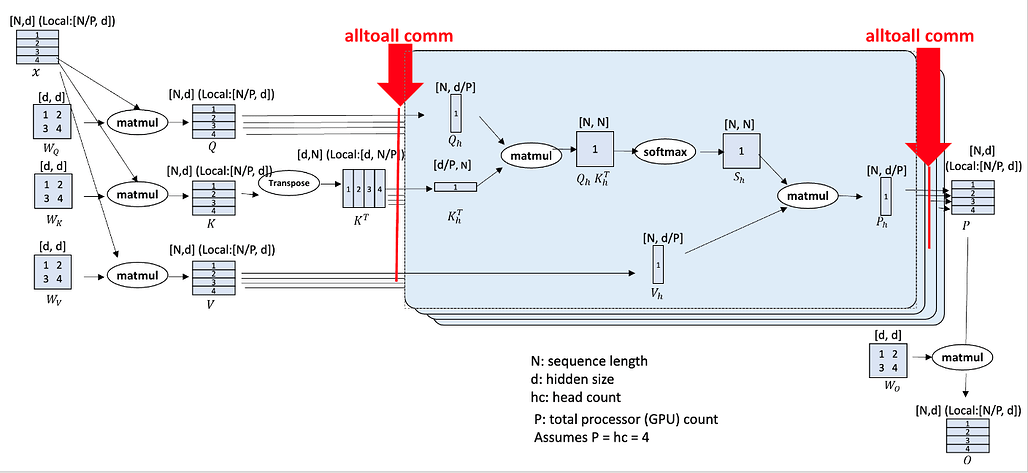

- 완전히 general 하고 구현에 agnostic한 Attention (FlashAttention 2 같은 구현과도 동작)

- 대규모 모델 훈련 지원: ZeRO-3 과 함께 작동하여 대규모 시퀀스/모델 크기를 지원

- ZeRO Redundancy Optimizer Stage 3 (ZeRO-3)는 대규모 모델 학습을 위한 메모리 최적화 기법

- 사용하기 쉽고 이식성이 뛰어나 기존 프레임워크 변경 최소화