GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다. ![]()

소개

- 많은 사람들이 이에 대해 얘기를 했지만, 지금까지는 단편적인 것에 그쳤음

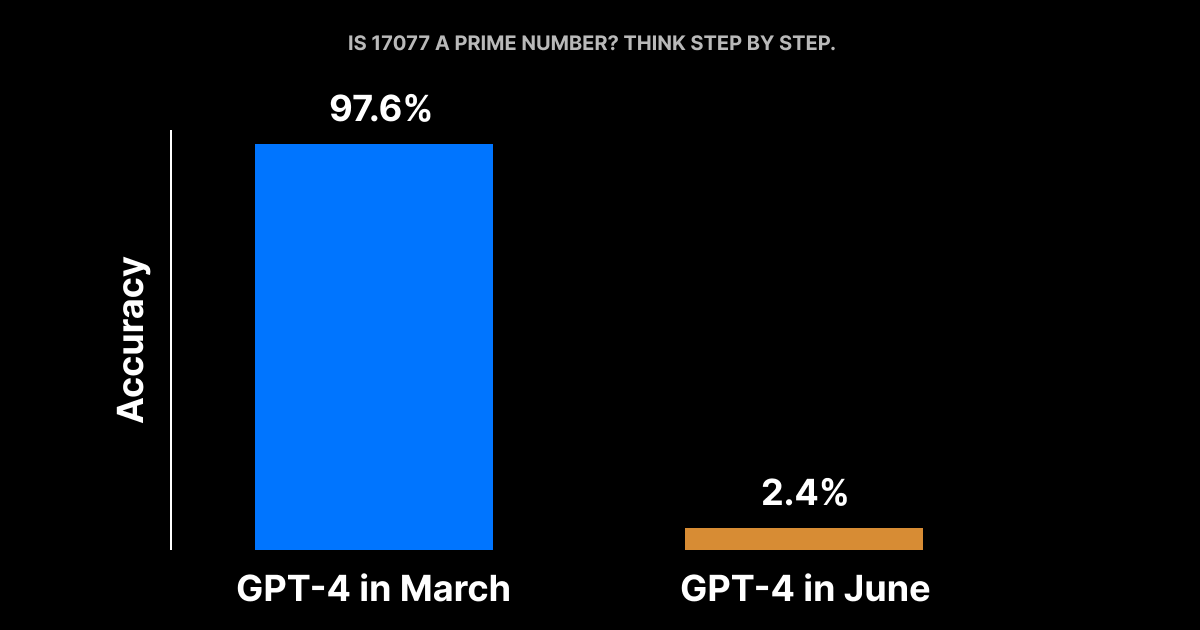

- 최근 발표된 논문에서 GPT-4의 6월버전과 3월버전을 500개의 문제를 가지고 객관적으로 비교해봤음

- 3월에는 488개를 정확하게 답했지만, 6월에는 정답이 12개에 불과

- 3개월만에 정답률이 97.6% 에서 2.4%가 된 것

- 하지만, 여기서 더 나빠짐

- Chain-of-Thought 기법을 이용해서 추론을 시켜봄

- "17077은 소수인가? Think step by step." 이라고 지시하자, GPT-4는 중간 단계를 생성하지도 않고 "아니오" 라고 답변함

- 코드 생성도 더 안 좋아짐

- LeetCode 에서 50개의 쉬운 문제로 데이터 세트를 구축해서 실행해봄

- 3월 버전은 52% 성공했지만, 6월버전은 10%만 성공함

- 왜 이런 일이 발생할까?

- OpenAI는 계속 변경을 하고 있다고 가정하지만, 어떻게 동작하는지, 그들이 어떻게 평가하는지 등을 알지 못함

- 소문에 따르면 그들은 여러개의 작은 특화된 GPT-4 모델을 묶어서 사용하여, 마치 큰모델인것 처럼 동작하지만 더 저렴한 비용으로 실행하고 있다고 함

- 더 저렴하고 빠르게 하는게 이 품질저하의 원인이 될 수 있을까?

- 이것은 GPT-4에 의존하는 어플리케이션을 구축하는 모든 사람에게 위험 신호임

- 시간경과에 따라서 LLM의 동작이 변하는 것은 허용할 수 없음

- 해당 실험은 누구나 Google Colab에서 재현해볼 수 있음

원문

https://twitter.com/svpino/status/1681614284613099520

출처 / GeekNews

더 읽어보기

논문: How Is ChatGPT’s Behavior Changing over Time?

https://arxiv.org/pdf/2307.09009.pdf