GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다. ![]()

소개

- 요약(Summarizing)은 LLM의 가장 실용적인 응용중 하나지만, 요약이 정확하다는 것을 신뢰할 수 있어야 함

- 비용이나 데이터 접근성 이슈때문에 Llama2 와 같은 오픈소스 LLM을 사용하고 싶지만 정확성에 대한 확신이 서지 않음

- 실험을 통해서 Llama-2-70b 가 gpt-4 만큼 사실성이 강하고, gpt-3.5-turbo 보다 훨씬 우수하다는 사실을 발견했음

- Anyscale Endpoint 를 이용해서 Llama 2 7b/13b/70b 와 gpt-3.5/4 를 비교

- 3자 검층을 거친 373개의 뉴스 보도 문장을 라벨링 하여 각각 정답과 오답을 하나씩 제시

- 각 LLM들이 어떤 진술이 사실에 근거한 정확한 요약인지 선택하게 함

- 문제 2가지

- 작은 모델이 지시를 잘 따르지 않음. 더 큰 모델이 지침을 더 잘 따름. 그래서 다른 LLM을 이용하여 작은 LLM의 출력을 이해하도록 해야 했음

- 순서 편향. 첫번째로 뭘 제시하는 가에 따라 선택이 달라짐. 그래서 순서를 바꿔서도 확인

- 결과

- 사람 : 84% (이전 연구 기준)

- gpt-3.5-turbo: 67.0% 정답 (순서 편향 이슈가 심함)

- gpt-4: 85.5% 정답

- Llama-2-7b: 엄청 심한 순서 편향 이슈. 랜덤 정확도 아래임

- Llama-2-13b: 58.9% 정답

- Llama-2-70b: 81.7%

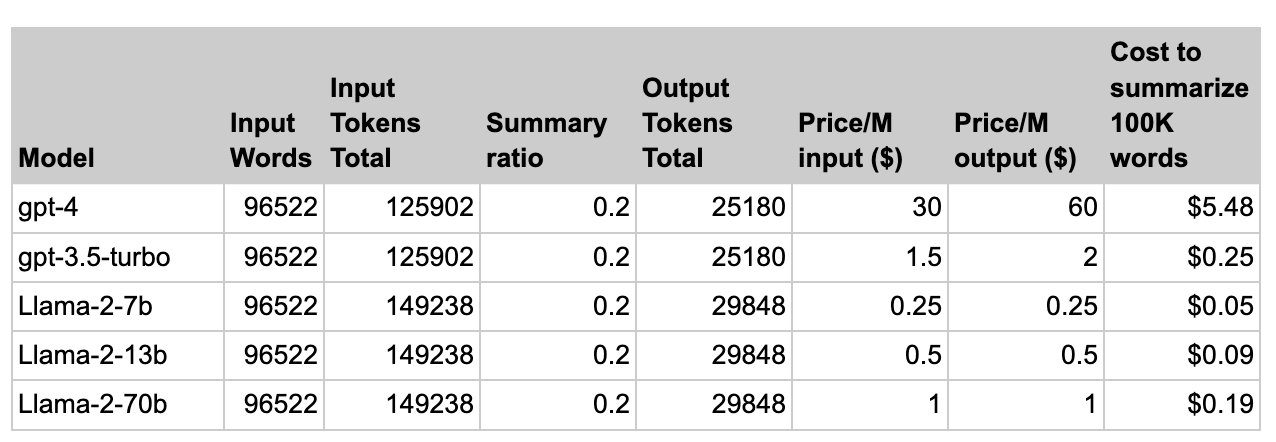

- 비용 (100K 단어 요약하는데)

- gpt-4 : $5.48

- gpt-3.5-turbo : $0.25

- Llama-2-7b : $0.05

- Llama-2-13b : $0.09

- Llama-2-70b : $0.19