GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다. ![]()

소개

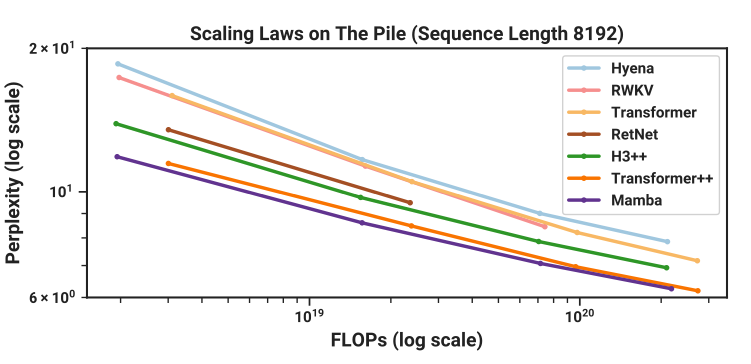

Mamba는 Transformer에 도전하는 상태 공간 모델(State Space Model)

- AI는 현재 세계를 지배하고 있으며, 그 중심에는 트랜스포머가 있음

- Mamba는 상태 공간 모델(SSM, State-Space Model)이라는 대안적 모델 클래스에 속함

- Mamba는 트랜스포머와 유사한 성능과 확장성을 가지면서도 긴 시퀀스 길이에서 실행 가능함

- 주목할 만한 점은 Mamba가 '어텐션 메커니즘'의 '제곱 병목현상'을 제거하여 긴 컨텍스트를 가능하게 함

- Mamba는 트랜스포머보다 최대 5배 빠른 속도로 실행됨

트랜스포머의 문제점 - 어텐션만으로는 충분하지 않을 수도 있음

- 트랜스포머는 모든 토큰이 이전 토큰을 참조할 수 있어, 컨텍스트가 커질수록 모델이 느려짐

- 이러한 KV 캐시의 저장은 공간 복잡도도 O(n)이 필요함

- 기존의 트랜스포머의 병목 현상을 완화하는 기술들이 있지만, 근본적인 해결을 위해서는 다른 접근 방식이 필요함

기초 모델 백본

- 좋은 ML 아키텍처 백본의 두 가지 중요한 구성 요소

- 토큰 간의 통신(Communication)

- 토큰 내의 계산(Computation)

- 트랜스포머 블록은 주의(Attention)와 MLPs로 구성되어 있음

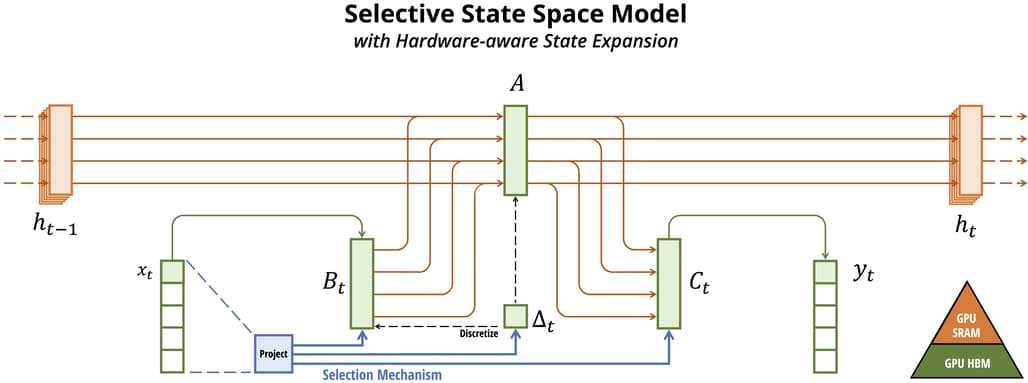

- Mamba는 통신을 위해 제어 이론에서 영감을 받은 SSM을 사용하고, 계산을 위해 MLP 스타일의 투영을 유지함

Mamba 동기 부여 - Temple Run으로 돌아가기

- 상태(state) 는 시스템의 미래 행동을 결정하는 데 필요한 변수들을 의미함

- 상태는 과거에 대해 알아야 할 모든 것을 압축한 것으로, 마르코프 결정 과정으로 변환됨

이산화 - 양자화된 세계에서 살아가기

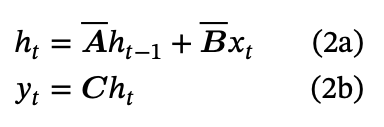

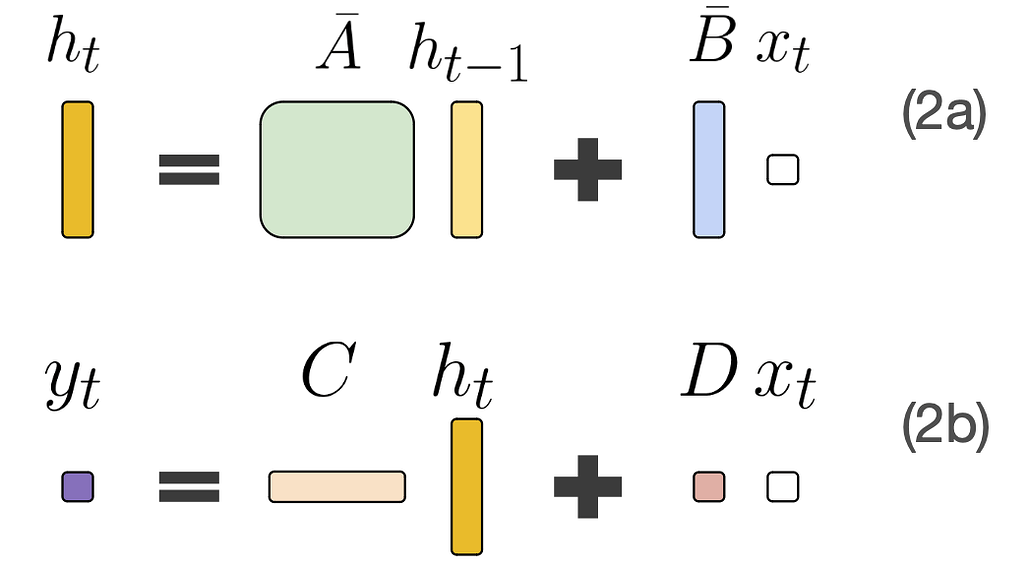

- 연속 시간 미분 방정식을 이산 시간 차분 방정식으로 변환하는 과정을 이산화(discretisation) 라고 함

- Mamba는 제로-오더 홀드(ZOH) 이산화를 사용함

SSM 행렬 이해하기

- A, B, C, D 행렬은 상태 전이, 새 입력을 상태에 매핑, 상태를 SSM 출력에 매핑, 새 입력을 출력에 통과시키는 역할을 함

효율성 대 효과성: Attention is Focus, Selectivity is Prioritisation (주의는 집중이고, 선택성은 우선 순위 설정)

- 트랜스포머는 매우 효과적 이지만 효율적 이지는 않음

- Mamba 아키텍처는 효율성과 효과성의 파레토 최전선을 밀어내는 솔루션을 제공함

선택 메커니즘

- 선택성(Selectivity) 은 각 토큰을 그것의 필요에 맞게 상태로 변환할 수 있게 함

- Mamba는 A, B, C 행렬을 x의 함수로 만들어 정적이 아닌 컨텍스트 의존적으로 함

선택성의 문제점

- 선택 메커니즘을 적용하면 비선택적 SSM보다 계산이 느려질 수 있음

- 하드웨어 최적화를 통해 Mamba는 비슷한 크기의 트랜스포머보다 빠르게 실행될 수 있음

기계 학습과 정치 경제학 - 상태의 크기는 얼마나 커야 하는가?

- 시퀀스 모델의 효율성 대 효과성 트레이드오프는 상태를 얼마나 잘 압축하는지에 의해 특징지어짐

- 상태 표현이 중요하며, 상태를 선택적이고 동적으로 압축하는 것이 핵심임

트랜스포머 대 Mamba의 정보 흐름

- 트랜스포머는 훈련 데이터와 컨텍스트 데이터를 통해 학습함

- Mamba는 훈련 데이터와 컨텍스트 데이터가 압축/필터링되어 접근 가능함

새로운 프롬프팅 패러다임으로서의 상태 교체

- Mamba와 같은 모델을 사용하면 전문 데이터를 통해 생성된 상태 라이브러리를 공유할 수 있음

- 상태는 백프롭 없이 추론 시간에 무한한 컨텍스트 학습을 적용할 수 있음

Mamba와 메커니즘 해석 가능성

- Mamba의 해석 가능성은 토큰 간의 정보 이동을 이해하는 것에 초점을 맞춤

Mamba와 SSM이 다음에 할 일

- Mamba와 같은 모델은 매우 긴 컨텍스트와 장기 기억이 필요한 시나리오에서 뛰어난 성능을 발휘할 가능성이 있음

에이전트와 AI 안전성

- 언어 모델은 본질적으로 안전하지만, 장기적인 시퀀스 추론의 가능성은 에이전트 기반 AI 안전성의 중요성을 되살림

트랜스포머와 Mamba의 최고의 협업

- Mamba의 긴 컨텍스트와 트랜스포머의 짧은 시퀀스에 대한 고해상도를 결합하는 것이 가치가 있음

GN⁺의 의견

- Mamba는 트랜스포머의 병목 현상을 해결하고 긴 시퀀스 처리에 효과적인 대안을 제시함

- 이 기술은 특히 의료, 유전학, 자연어 처리 등 데이터의 긴 시퀀스가 중요한 분야에서 유용할 수 있음

- Mamba의 선택 메커니즘이 실제로 효과적인지에 대한 추가 연구가 필요함

- Mamba의 선택성은 트랜스포머가 제공하는 높은 정확도와 효율성 사이의 균형을 찾는 데 도움이 될 수 있음

더 읽어보기

원문

PyTorchKR의 관련 글들

-

Mamba: 선택적 상태 공간을 활용한 선형 시간 시퀀스 모델링 (Linear-Time Sequence Modeling with Selective State Spaces)

-

Mamba-chat출시 - Long sequence data 에서 효율적인 Mamba의 SSM을 이용한 Mamba-chat사용후기

![[GN⁺] Mamba: 트랜스포머에 도전하는 상태-공간 모델(SSM)](https://discuss.pytorch.kr/uploads/default/optimized/2X/a/aad357b7d2b1dff81535f237331b067bf08d155d_2_1028x581.png)