GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다. ![]()

소개

Emu Video: 단일 Diffusion Model 기반으로 텍스트를 비디오로 고품질로 생성

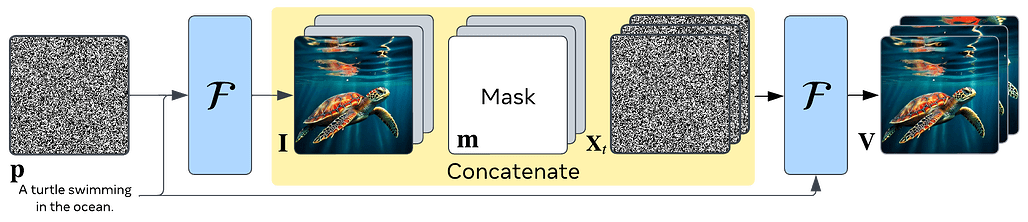

- 두 단계로 프로세스를 분리

- 먼저 텍스트 프롬프트에 따라 조건이 지정된 이미지를 생성

- 텍스트와 생성된 이미지 모두에 조건이 지정된 비디오를 생성

- 이런 'Factorized' 또는 분할 접근 방식을 통해 비디오 생성 모델을 효율적으로 훈련 가능

- 여러개의 모델 중첩이 필요했던 이전 작업(예: Make-A-Video의 경우 5개 모델)과 달리, 구현이 간단하며 두 개의 확산 모델만으로 초당 16프레임으로 512x512 4초 길이의 동영상을 생성

- 실제로 응답자의 96%가 품질 면에서, 85%가 텍스트 프롬프트에 대한 충실도 면에서 Make-A-Video보다 선호했음

- 또한 이 모델이 텍스트 프롬프트를 기반으로 사용자가 제공한 이미지에 '애니메이션'을 적용하여 다시 한 번 이전 작업을 큰 차이로 뛰어넘음

Emu Edit: 인식 및 생성 작업을 통한 정밀한 이미지 편집

- 원하는 이미지를 만들기 위해서는 프롬프트를 계속 조정해야하고, 그래서 프롬프트 엔지니어링이 등장

- 하지만 정밀한 제어에 있어서는 여전히 한계가 있음

- Emu Edit는 다양한 이미지 조작 작업을 간소화하고 이미지 편집에 향상된 기능과 정밀도를 제공

- 로컬 및 전역 편집, 배경 제거 및 추가, 색상 및 지오메트리 변환, 감지 및 분할 등의 작업을 포괄하는 명령을 통해 자유 형식 편집이 가능

- 현재의 방식은 다양한 편집 작업에서 과도하게 수정하거나 성능이 떨어지는 경우가 많음

- 오늘날의 많은 제너레이티브 AI 모델과 달리 Emu Edit는 지침을 정확하게 따르기 때문에 지침과 관련이 없는 입력 이미지의 픽셀은 그대로 유지함

- 예를 들어 야구 모자에 "알로하!"라는 텍스트를 추가할 때 모자 자체는 변경되지 않아야 함

- 모델을 학습시키기 위해 각각 입력 이미지, 수행할 작업에 대한 설명, 목표 출력 이미지가 포함된 1,000만 개의 합성 샘플이 포함된 데이터 세트를 개발했음

- 현재까지 가장 큰 규모의 데이터 세트

- 이 결과, Emu Edit 모델은 지침 충실도와 이미지 품질 측면에서 전례 없는 편집 결과를 보여줌

- 다양한 이미지 편집 작업에 대한 정성적, 정량적 평가 모두에서 새로운 최첨단 결과를 도출하며 기존 방식보다 우수한 성능을 입증