9bow

(박정환)

1

GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다.

소개

-

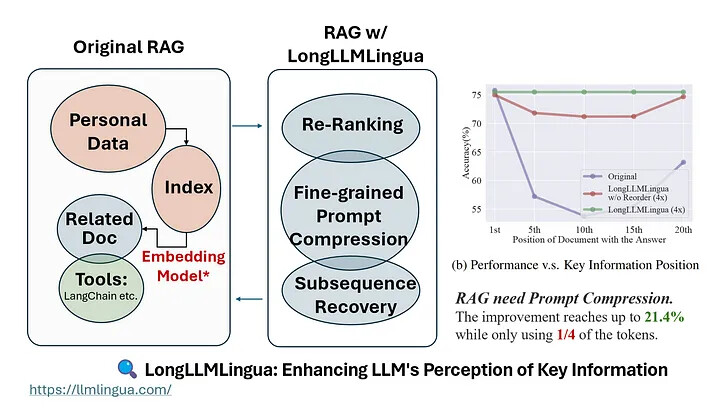

GPT2-small 또는 LLaMA-7B와 같이 정렬 및 잘 훈련된 작은 언어 모델을 압축에 사용

-

프롬프트에서 중요하지 않은 토큰을 감지하고 블랙박스 LLM에서 압축된 프롬프트로 추론을 가능하게 함

- LLM의 추론 속도를 높이고 주요 정보에 대한 LLM의 인식을 향상시키기 위해 프롬프트와 KV-Cache를 압축

- 성능 손실을 최소화하면서 최대 20배의 압축을 달성

-

프롬프트 와 생성된 컨텍스트를 줄여서 비용을 절감

-

프롬프트내에 중요한 정보의 밀집도를 더 높여서 더 긴 컨텍스트를 지원 가능

데모 영상

원문

프로젝트 홈페이지

LLMLingua 논문

LongLLMLingua 논문

HuggingFace 데모

GitHub 저장소

https://github.com/microsoft/LLMLingua

LongLLMLingua 소개 글

![]()

![[GN] Microsoft LLMLingua - 추론 가속 및 비용 절감을 위해 프롬프트 압축하기 - 개요 소개 이미지](https://discuss.pytorch.kr/uploads/default/optimized/2X/e/ee33d9851505da50c892c34a4f299010af41b16c_2_1028x777.png)

![[GN] Microsoft LLMLingua - 추론 가속 및 비용 절감을 위해 프롬프트 압축하기 - LLMLingua 소개 이미지](https://discuss.pytorch.kr/uploads/default/original/2X/b/b861f9f82ed6ddba6693319a87ff7337da2f901a.jpeg)

![[GN] Microsoft LLMLingua - 추론 가속 및 비용 절감을 위해 프롬프트 압축하기 - LongLLMLingua 소개 이미지](https://discuss.pytorch.kr/uploads/default/original/2X/d/dfeda4686ffeeefb24a014ee4e6bec07d8b36b1c.jpeg)