Mistral AI, 새로운 오픈 모델 Mixtral 8x22B 공개

소개

- "더 저렴하고, 더 좋으며, 더 빠르고, 더 강력한"

- 총 141B 파라미터 중 39B의 활성 파라미터만 사용하는 Sparse Mixture-of-Experts(SMoE) 모델로, 모델 크기 대비 비용 효율성이 매우 뛰어남

Mixtral 8x22B의 주요 특징

- 영어, 프랑스어, 이탈리아어, 독일어, 스페인어에 유창함

- 수학과 코딩 능력이 우수함

- 함수 호출이 기본적으로 가능하며, la Plateforme에 구현된 제한된 출력 모드와 함께 대규모 애플리케이션 개발과 기술 스택 현대화가 가능함

- 64K 토큰 컨텍스트 윈도우를 통해 대량의 문서에서 정확한 정보 리콜이 가능함

진정한 오픈 모델

- Mistral AI는 AI에서의 혁신과 협업을 촉진하기 위해 개방성과 광범위한 배포의 힘을 믿음

- Mixtral 8x22B는 가장 허용적인 오픈 소스 라이선스인 Apache 2.0으로 배포되어, 누구나 제한 없이 모델을 사용할 수 있음

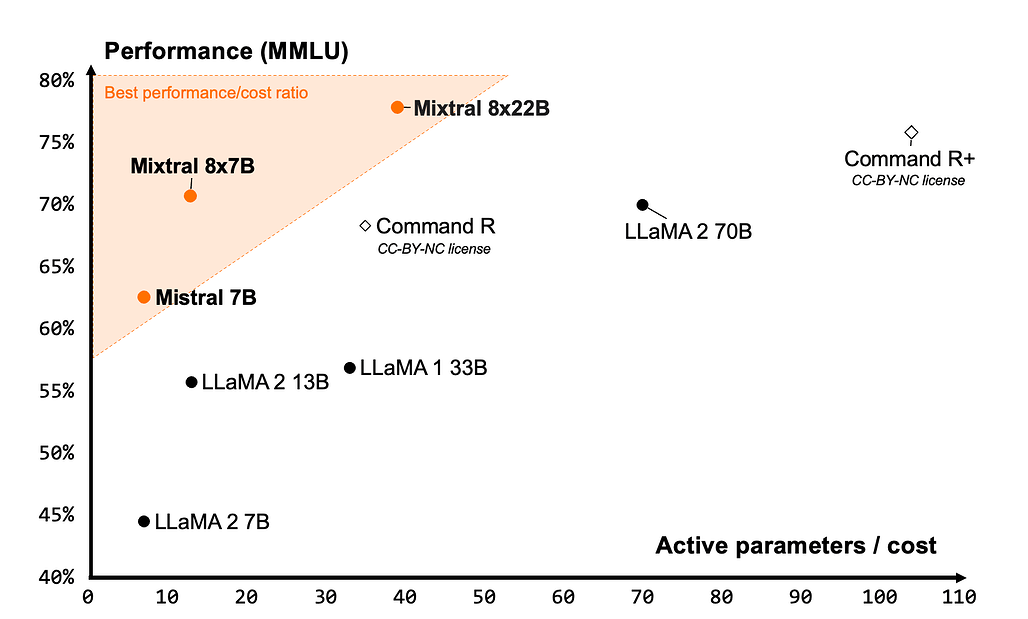

최고의 효율성

성능(MMLU) 대 추론 예산 트레이드-오프(활성 매개변수 수) 측정. Mistral 7B, Mixtral 8x7B, Mixtral 8x22B는 모두 다른 개방형 모델에 비해 매우 효율적인 모델 제품군에 속합니다.

- Mistral AI는 각 모델 크기에 대해 비용 대비 최고의 성능을 제공하는 모델을 구축하여, 커뮤니티에서 제공하는 모델 중 최고의 성능 대비 비용 비율을 제공함

- Mixtral 8x22B는 Mistral AI 오픈 모델 제품군의 자연스러운 연장선상에 있음. Sparse 활성화 패턴 덕분에 Dense 70B 모델보다 빠르면서도 허용적이거나 제한적인 라이선스로 배포되는 다른 오픈 웨이트 모델보다 더 많은 기능을 제공함. 기본 모델의 가용성으로 인해 파인튜닝 사용 사례에 매우 적합한 기반이 됨

견줄 데 없는 오픈 성능

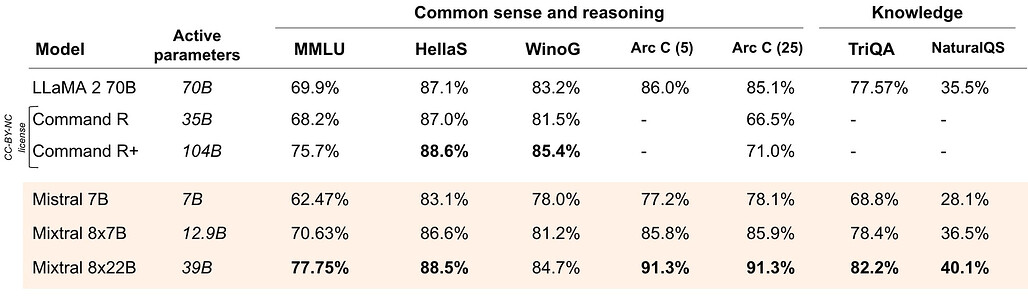

추론 및 지식

- Mixtral 8x22B는 추론에 최적화되어 있음

- 상식, 추론, 지식 벤치마크(MMLU, HellaSwag, Wino Grande, Arc Challenge, TriviaQA, NaturalQS)에서 최고 수준의 LLM 오픈 모델 중 최고 성능을 보임

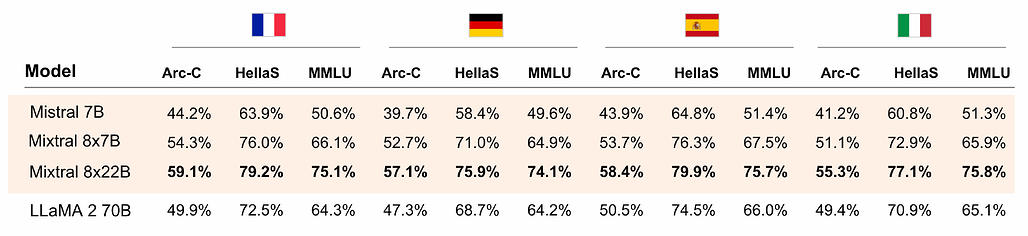

다국어 기능

- Mixtral 8x22B는 기본적인 다국어 기능을 갖추고 있음

- 프랑스어, 독일어, 스페인어, 이탈리아어로 된 HellaSwag, Arc Challenge, MMLU 벤치마크에서 LLaMA 2 70B를 크게 능가함

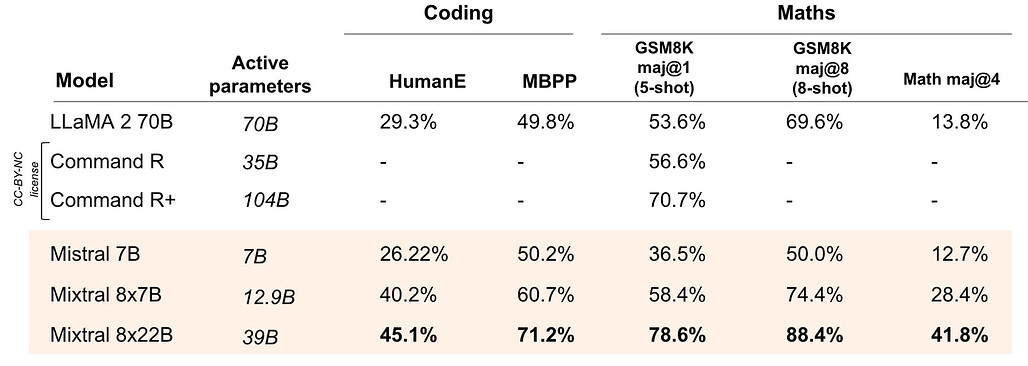

수학 및 코딩

- Mixtral 8x22B는 다른 오픈 모델에 비해 코딩 및 수학 작업에서 가장 우수한 성능을 보임

- 코딩 및 수학 벤치마크(HumanEval pass@1, MBPP pass@1, GSM8K maj@1/8, Math maj@4)에서 선두적인 오픈 모델 중 최고 성능을 보임

- 오늘 발표된 Mixtral 8x22B의 Instructed 버전은 수학 성능이 더욱 우수하여 GSM8K maj@8에서 90.8%, Math maj@4에서 44.6%의 점수를 기록

GN⁺의 의견

- Mixtral 8x22B는 Mistral의 오픈 모델 중 가장 큰 규모이면서도 Sparsity를 활용해 비용 대비 매우 효율적인 모델임. 이는 오픈 소스 LLM 모델의 발전 방향 중 하나로 주목할 만함

- 모델 크기 대비 뛰어난 다국어 성능, 수학/코딩 능력은 Mixtral 8x22B만의 차별화 포인트로 보임. 하지만 영어 외 언어의 경우 지원 언어의 폭이 좁은 편이며, GPT-4 등 최신 LLM과 비교하면 코딩이나 수학 능력도 뒤쳐지는 수준임

- Apache 2.0 라이선스 적용으로 누구나 자유롭게 활용 가능한 점은 장점이나, 악용 가능성도 높아 보임. 오픈소스 AI 모델의 책임있는 개발과 활용을 위한 커뮤니티의 노력이 더욱 필요해 보임

- Mixtral 모델을 활용한 애플리케이션 개발과 기술 스택 현대화가 가능하다는 점은 매력적이나, 대규모 서비스에 적용하기에는 아직 기술적/비용적 한계가 있어 보임. 다만 오픈소스 기반의 혁신 사례들이 늘어날 것으로 기대됨

- 국내에서는 KakaoBrain, NAVER, LG AI Research 등도 자체 LLM을 개발 중임. 한국어 처리 성능 등 한국 시장 특화 측면에서는 이들 모델이 경쟁력을 가질 것으로 보임

원문

Mixtral-8x22B Base 모델

Mixtral-8x22B Instruct 모델

출처 / GeekNews

알려드립니다

알려드립니다

이 글은 국내외 IT 소식들을 공유하는 GeekNews의 운영자이신 xguru님께 허락을 받아 GeekNews에 게제된 AI 관련된 소식을 공유한 것입니다.

출처의 GeekNews 링크를 방문하시면 이 글과 관련한 추가적인 의견들을 보시거나 공유하실 수 있습니다! ![]()

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식을 정리하고 공유하는데 힘이 됩니다~ ![]()

![[GN⁺] Mistral AI, 새로운 오픈 모델 Mixtral 8x22B 공개](https://discuss.pytorch.kr/uploads/default/optimized/2X/c/c1eb74def4878f8d5aedb248e94faea1b12b58fe_2_1028x314.png)