9bow

(박정환)

1

GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다.

소개

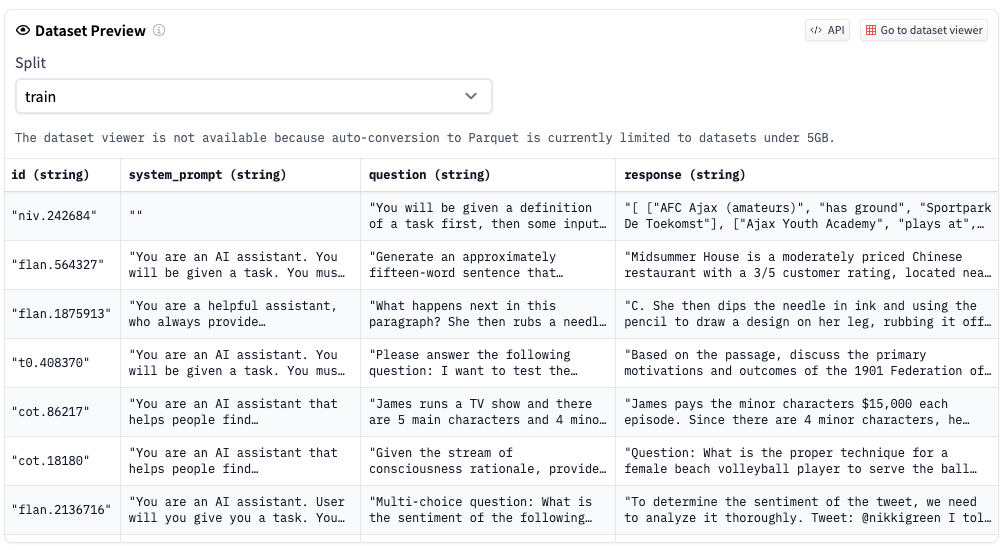

- Microsoft의 Orca 논문 내용을 가져다가 오픈소스로 복제하여 만든 것

- GPT-4 Completion으로 보강된 약 1백만개의 FLANv2

- GPT-3.4 Completion으로 보강된 약 3.5백만개의 FLANv2

- FLAN-1m 데이터셋에 있는 75k CoT 전체를 포함

- 현재는 LLaMA-13B 파운데이션위에서 전체 가중치에 대한 파인튜닝 진행중이서 Microsoft 의 것과 성능이 비슷해 질 것

- 7월 중순쯤에 OpenOrca-LLaMA-13b 를 릴리즈 할 수 있을 것

- OpenOrca 를 다른 플랫폼(Falcon, LLaMA, MPT 등)에 적용하기 위한 GPU 컴퓨팅 스폰서를 찾는 중

원문

(원문이 삭제되어 백업본 링크를 공유드립니다)

Datasets

출처

삭제된 데이터셋은 'Dolphin'이라는 이름으로 새로 올라왔습니다. 오픈오르카 팀과 의견차이가 있어서 팀을 나와 별도로 모델을 제작하려는 듯 하네요.

1개의 좋아요

9bow

(박정환)

3

오, 그런 일이 있었군요. 알려주셔서 감사합니다!!!

![]()