GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다. ![]()

소개

-

1800억개의 파라미터가 포함된 최대 규모의 공개 언어 모델

-

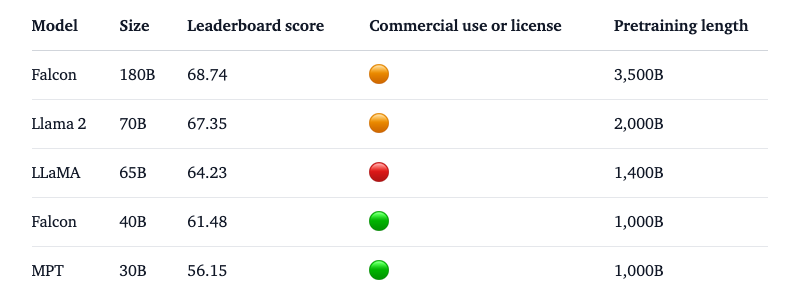

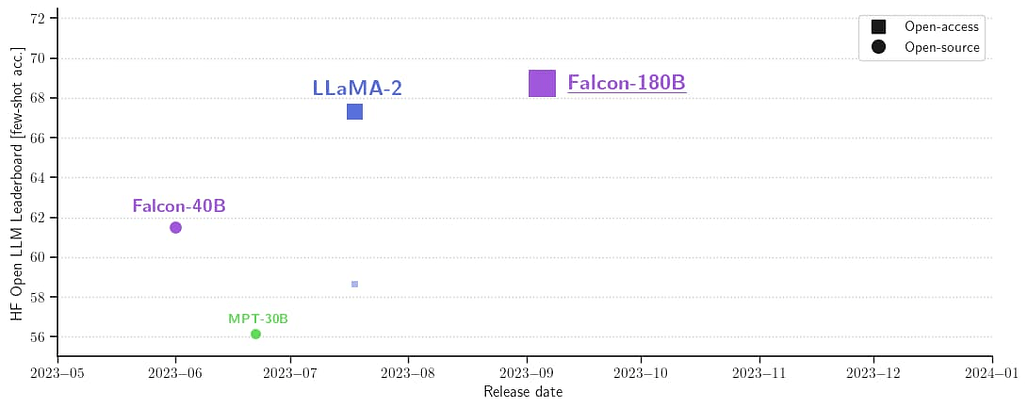

공개 모델중에선 리더보드 1위에 랭크. Llama 2 70B 및 GPT-3.5를 능가하며 PaLM-2와 경쟁

-

TII의 RefinedWeb 데이터 세트(대부분 영어)를 이용하여 3.5T 토큰으로 훈련

- Llama 2 보다 2.5배 더 크고 4배 이상의 컴퓨팅 파워로 훈련했음(Amazon SageMaker 로 4096개의 GPU 이용)

-

Falcon 180B 는 상업적으로 이용은 가능하지만, "호스팅 사용"을 제외하고 매우 제한적인 조건에서만 사용 가능. 라이센스 확인 필수

-

하드웨어 요구사항

- 풀 파인튜닝: 메모리 5120GB, 8x 8x A100 80GB

- LoRA with ZeRO-3: 1280GB, 2x 8x A100 80GB

- QLoRA: 160GB, 2x A100 80GB

- 추론 BF16/FP16 : 640GB, 8x A100 80GB

- 추론 GPTQ/int4 : 320GB, 8x A100 40GB

원문

소개 글

TII 홈페이지

- Falcon LLM을 개발한 아랍에미리트의 개발 기관 TII(Technology Innovation Institue)의 홈페이지

https://falconllm.tii.ae/?utm_source=pytorchkr

Falcon-180B 모델

Falcon-180B Chat 모델

- Falcon-180B 모델 + 여러 데이터셋(Ultrachat, Platypus, Airoboros)을 혼합하여 파인튜닝

Falcon-180B Chat 모델 데모

https://huggingface.co/spaces/tiiuae/falcon-180b-demo?utm_source=pytorchkr