Google AI 에너지 효율 혁신 소개

인공지능은 현대 사회에서 가장 중요한 기술 혁신 중 하나로 꼽히며, 앞으로 10년 동안 의료, 교육, 교통, 기후 대응 등 여러 분야에서 막대한 변화를 이끌 것으로 예상됩니다. 그러나 AI의 발전에는 상당한 에너지 수요가 뒤따릅니다. 특히 대규모 모델을 학습하는 과정뿐만 아니라, 실제 사용자에게 서비스를 제공하는 추론 단계에서도 상당한 전력이 소모됩니다. 이러한 문제는 단순히 컴퓨팅 자원의 확대만으로는 해결될 수 없으며, 지속 가능한 에너지 관리와 효율화가 반드시 병행되어야 합니다.

구글은 이 문제를 해결하기 위해 새로운 데이터센터 인프라 투자, 탄력적 전력망 구축, 청정에너지 조달 확대, 그리고 하드웨어 및 소프트웨어 최적화를 포함한 다층적인 전략을 추진하고 있습니다. 특히 데이터센터 운영 효율을 개선하는 동시에 AI 모델과 인프라 전반의 에너지 발자국을 체계적으로 측정하고 줄이는 것이 핵심 과제라고 강조합니다. 이번 연구는 그러한 노력의 일환으로, AI 추론 과정에서 발생하는 에너지 소비와 탄소 배출, 그리고 물 사용량까지 종합적으로 측정하는 새로운 방법론을 제시하고 있습니다.

기존 연구와 구글의 접근 비교

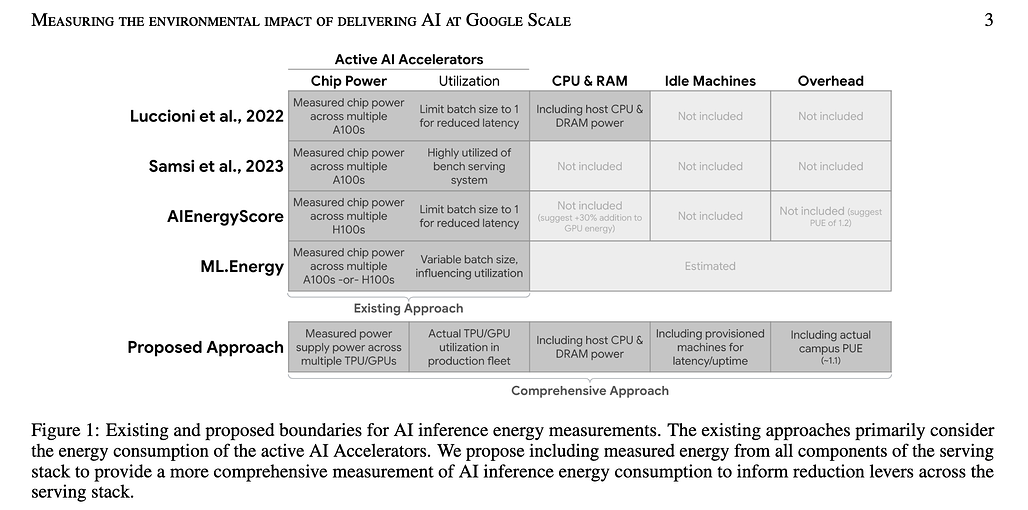

AI의 환경적 영향을 평가하는 기존 연구들은 크게 두 가지 방식으로 나눌 수 있습니다:

-

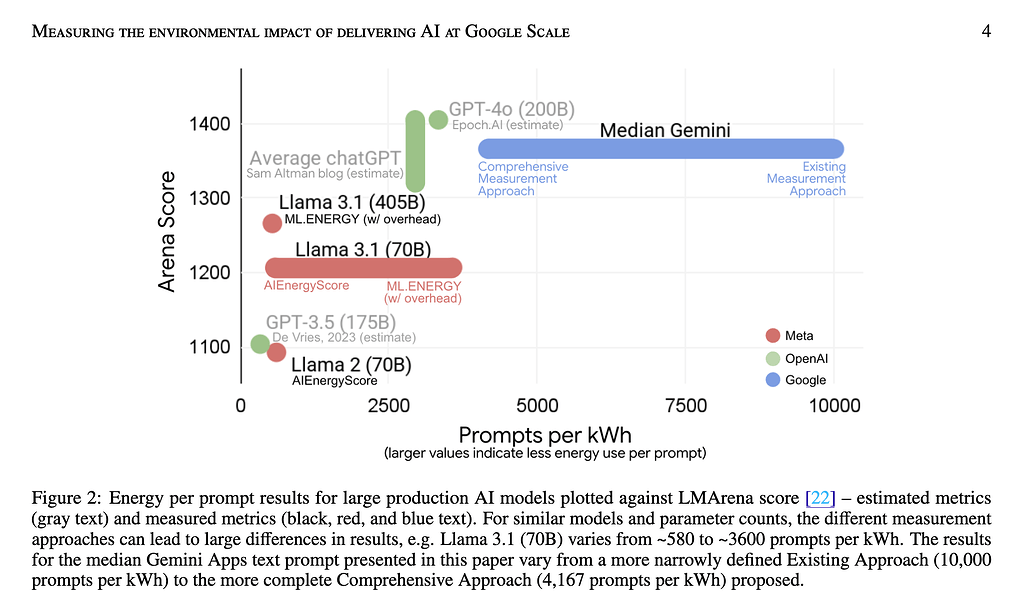

**추정 기반 방식(Estimated metrics): 모델 크기와 하드웨어 사양을 토대로 한 추정치에 의존하는 방식입니다. 예를 들어 GPT-3.5 한 번의 응답에 약 3 Wh가 소모된다는 연구 결과나, GPT-4o 기반 ChatGPT가 약 0.3 Wh 정도의 에너지를 사용한다는 공개 수치가 대표적입니다. 그러나 이러한 추정치들은 입력과 출력 토큰 길이, 하드웨어 효율성, 운영 방식에 따라 결과가 크게 달라질 수 있어 신뢰도가 떨어진다는 문제가 있습니다.

-

Measured metrics 실제 하드웨어에서 실행하며 소프트웨어 도구를 활용해 전력 소비를 직접 측정하는 방법입니다. 최근 CodeCarbon, ML.ENERGY, AI Energy Score 같은 프레임워크가 이를 시도했지만, 여전히 어디까지를 측정 범위로 포함할 것인가에 따라 값이 크게 달라졌습니다. 같은 모델이라도 연구마다 0.3 Wh에서 4 Wh까지 차이가 나는 경우가 있어 결과 비교가 어려웠습니다.

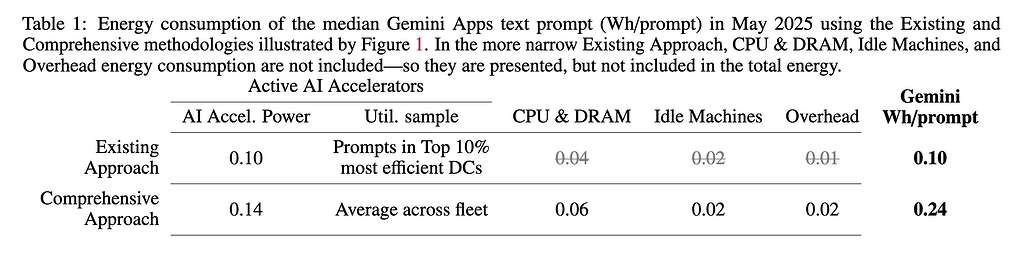

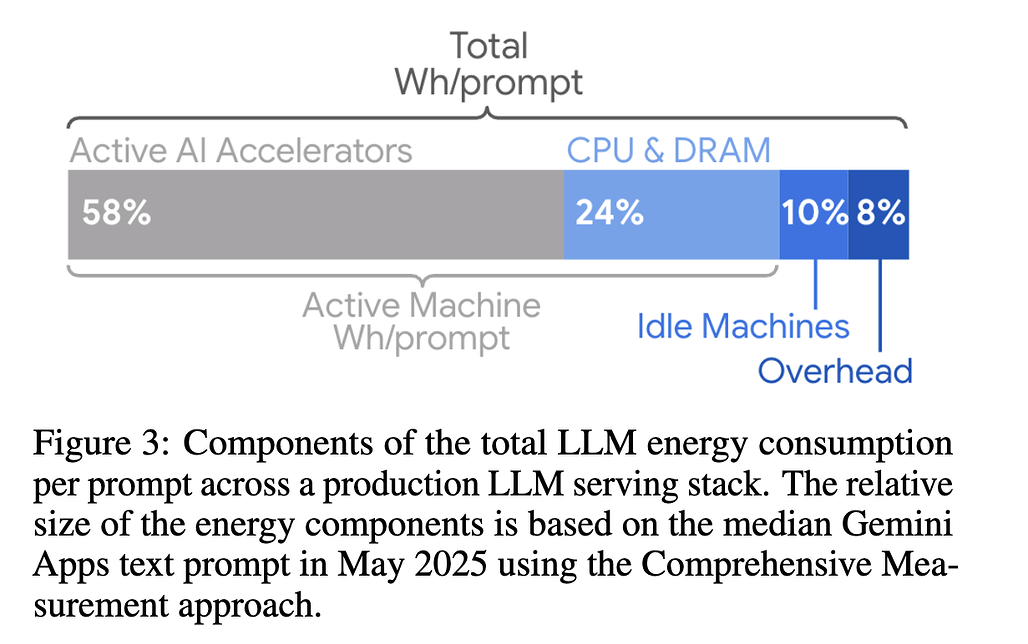

구글의 접근은 이러한 문제를 해결하기 위해 기존보다 훨씬 포괄적인 측정 범위를 설정한 것이 특징입니다. 단순히 AI 가속기에서 발생하는 전력만 계산하는 것이 아니라, CPU와 DRAM, 서비스 안정성을 위해 대기 상태로 운영되는 유휴 머신, 그리고 데이터센터의 냉각 및 전력 손실을 반영하는 PUE까지 모두 포함시켰습니다. 이를 통해 실제 대규모 운영 환경에서의 AI 추론이 소비하는 에너지를 더 현실적으로 측정할 수 있었습니다.

구글의 새로운 측정 시도: 프롬프트당 에너지 / 탄소 / 물 사용량

구글은 자사 AI 서비스인 Gemini Apps를 대상으로, 텍스트 프롬프트 하나가 소모하는 에너지, 배출하는 탄소, 그리고 사용하는 물의 양을 세밀하게 측정했습니다. 그 결과 Gemini Apps의 평균 프롬프트 하나가 소비하는 에너지(Energy consumed per Median Prompt)는 약 0.24 Wh로, 이는 일반 TV를 약 9초 동안 켜는 것과 같은 수준입니다. 탄소 배출량은 0.03 gCO₂e에 불과했으며, 물 사용량은 약 0.26 mL로 물방울 다섯 방울 정도에 해당했습니다.

이는 기존의 좁은 범위 측정치(0.1 Wh, 0.01 gCO₂e, 0.12 mL)보다는 다소 높지만, 과거 연구들이 제시한 값(16 Wh, 1050 mL)들 보다는 훨씬 낮습니다. 예컨대 일부 연구에서는 프롬프트당 수 Wh의 전력 소비와 10~50 mL 수준의 물 사용량을 추정했는데, 구글의 결과는 이를 크게 밑도는 값입니다. 이러한 차이는 실제 서비스 환경에서 대규모 배치 처리, 효율적인 자원 활용, 맞춤형 하드웨어와 소프트웨어 최적화가 이루어지고 있기 때문으로 해석됩니다.

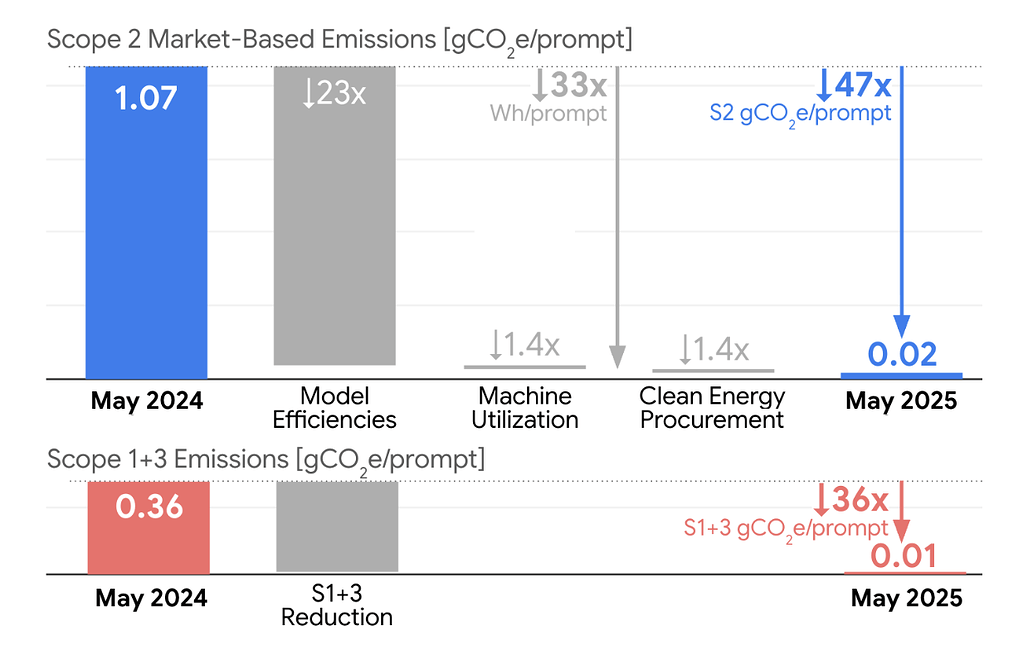

1년간의 효율성 향상: 33배 에너지 절감, 44배 탄소 절감

구글의 연구에서 특히 주목할 점은 불과 1년 사이에 효율성이 크게 개선되었다는 사실입니다. Gemini Apps 기준으로 프롬프트당 에너지 소비량은 33배 감소했고, 탄소 배출량은 44배 줄어들었습니다. 이는 단순히 모델 학습만의 결과가 아니라, 모델 아키텍처 설계, 알고리즘 개선, 하드웨어 최적화, 운영 방식 혁신 등, AI의 모든 계층을 아우르는 풀스택 접근(Full-stack Approach)의 결과입니다.

구글의 풀스택 접근을 상세히 살펴보면 다음과 같습니다:

-

더 효율적인 모델 아키텍처: Gemini 모델은 구글 연구진이 개발한 Transformer 모델 아키텍처 위에 구축되어 있으며, 이는 기존 언어 모델링 아키텍처 대비 10배에서 100배에 이르는 효율 향상을 제공합니다. 또한 Mixture-of-Experts(MoE)와 하이브리드 추론(hybrid reasoning) 같은 구조를 설계에 반영하여 본질적으로 효율적인 모델을 구현합니다. 예를 들어 MoE 모델은 질의에 응답하는 데 필요한 모델의 일부만 활성화할 수 있어, 불필요한 연산과 데이터 전송을 10배에서 100배까지 줄일 수 있습니다.

-

효율적인 알고리즘과 양자화: 구글은 모델을 구동하는 알고리즘을 지속적으로 개선하고 있습니다. 정확한 양자화 학습(Accurate Quantized Training, AQT) 같은 방법을 통해 응답 품질을 해치지 않으면서도 에너지 소비를 줄이고, 추론 효율을 극대화합니다.

-

최적화된 추론과 서빙: 구글은 AI 모델의 응답성(responsiveness)과 효율성을 높이기 위해 지속적으로 서빙 방식을 개선하고 있습니다. Speculative decoding 기술은 작은 모델이 먼저 예측을 수행하고, 이를 큰 모델이 빠르게 검증하는 방식으로, 대규모 모델이 모든 예측을 순차적으로 수행하는 것보다 훨씬 효율적입니다. 또한 지식 증류(distillation)를 통해 Gemini Flash 및 Flash-Lite 같은 작고 효율적인 모델을 만들어, 더 큰 모델을 “교사”로 활용합니다. 빠른 하드웨어와 최적화된 모델 덕분에 더 큰 배치 크기(batch size)를 사용하면서도 지연(latency) 목표를 충족할 수 있게 되었습니다.

-

맞춤형 하드웨어: 구글은 10년 넘게 성능 대비 전력 효율을 극대화하기 위해 자체 TPU를 설계해왔습니다. AI 모델과 TPU를 공동 설계(co-design)하여, 소프트웨어가 하드웨어의 성능을 최대한 활용하도록 하고, 하드웨어가 미래의 AI 소프트웨어를 효율적으로 실행할 수 있도록 합니다. 최신 세대 TPU인 Ironwood는 최초 공개 TPU보다 30배 이상 효율적이며, 범용 CPU보다 추론에서 훨씬 뛰어난 전력 효율성을 보여줍니다.

-

최적화된 유휴 관리: 구글의 서빙 스택은 CPU를 효율적으로 활용하고, TPU 유휴 상태를 최소화하기 위해 수요에 맞춰 모델을 거의 실시간으로 이동시키는 방식을 사용합니다. 이는 단순히 “설정 후 방치”하는 방식보다 훨씬 효율적입니다.

-

ML 소프트웨어 스택: 구글의 XLA ML 컴파일러, Pallas 커널, 그리고 Pathways 시스템은 JAX 같은 고수준 시스템에서 표현된 모델 연산을 TPU 서빙 하드웨어에서 효율적으로 실행할 수 있게 합니다.

-

초고효율 데이터센터: 구글의 데이터센터는 업계에서 가장 효율적인 수준에 속하며, 전체 평균 PUE 1.09를 기록하고 있습니다.

-

책임 있는 데이터센터 운영: 구글은 24/7 무탄소 전력 목표를 위해 지속적으로 청정에너지 발전을 추가하고 있으며, 사무실과 데이터센터에서 소비하는 담수의 평균 120%를 재보충(replenish)하는 것을 목표로 하고 있습니다. 또한 데이터센터 냉각 방식을 최적화하여, 에너지·물·탄소 배출 간의 지역적 균형을 고려합니다. 이를 위해 과학적 기반의 유역 건강 평가를 실시하고, 물 스트레스가 큰 지역에서는 물 사용을 최소화할 수 있는 냉각 방식을 선택합니다.

데이터센터와 지속 가능성

구글은 데이터센터를 운영하며 에너지와 물 사용에서 지속 가능한 전략을 병행하고 있습니다. 구글의 데이터센터는 AI 운영의 핵심 기반으로, 에너지와 물 사용 관리에 있어 업계 최고 수준의 효율성을 보여주고 있습니다. 2024년 한 해 동안 데이터센터의 전력 사용량은 전년 대비 27% 증가했지만, 탄소 배출량은 오히려 12% 감소했습니다. 이는 청정에너지 사용 확대, 냉각 시스템의 개선을 통한 효율 개선, 그리고 맞춤형 하드웨어 최적화가 종합적으로 작용한 결과입니다.

또한, 구글은 물 사용 관리에서도 책임 있는 접근을 하고 있습니다. 특히 물 스트레스가 높은 지역의 데이터센터는 기존 수냉식 방식 대신 공랭 시스템을 도입하여 물 사용량을 거의 0에 가깝게 줄이고 있습니다. 구글은 향후 기존 데이터센터가 점차 교체됨에 따라, 신규 데이터센터에서는 이런 방식을 도입하여 전체적인 물 사용에 따른 환경적 영향을 최소화할 계획입니다.

결론: 표준화와 투명성의 필요성 - 지속 가능한 AI를 향하여

이번 구글의 연구는 AI 추론의 환경적 영향을 측정하는 데 있어 기존 접근 방식이 얼마나 불완전했는지를 보여줍니다. 즉, AI가 반드시 환경적 비용을 치러야 하는 기술이 아니며, 하드웨어, 소프트웨어, 데이터센터, 에너지 조달을 아우르는 총체적 최적화를 통해, AI는 충분히 친환경적이고 지속 가능한 방식으로 운영될 수 있음을 보여줍니다.

단일 프롬프트의 소비량은 일상 활동과 비교했을 때 미미해 보일 수 있지만, 전 세계적으로 수십억 건이 실행되는 상황을 고려하면 그 총량은 결코 무시할 수 없습니다. 따라서 보다 표준화된 전 주기 측정 방법론이 필요하며, 이를 통해 업계 전반의 효율 개선을 유도하는 것이 중요합니다. 단순히 모델 성능만을 고려하는 것이 아니라, 에너지 효율과 환경 영향까지 포함한 총체적 성능 지표가 앞으로는 더욱 중요해질 것입니다. 이러한 변화는 기술의 발전뿐 아니라, AI가 사회 전체에 책임 있는 방식으로 확산되는 데 중요한 토대가 될 것입니다.

구글은 투명하게 데이터를 공개함으로써 업계와 학계가 함께 지속 가능한 AI 운영 방안을 모색할 수 있도록 했습니다. 이 연구는 AI가 반드시 환경 비용을 수반해야만 하는 기술이 아니라, 끊임없는 최적화와 혁신을 통해 충분히 친환경적으로 발전할 수 있음을 보여주는 사례라 할 수 있습니다.

관련 블로그: Our approach to energy innovation and AI’s environmental footprint

관련 블로그: Our approach to energy innovation and AI’s environmental footprint

관련 블로그: How much energy does Google’s AI use? We did the math

관련 블로그: How much energy does Google’s AI use? We did the math

관련 논문: Measuring the environmental impact of delivering AI at Google Scale

관련 논문: Measuring the environmental impact of delivering AI at Google Scale

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()