Imagine Yourself 소개

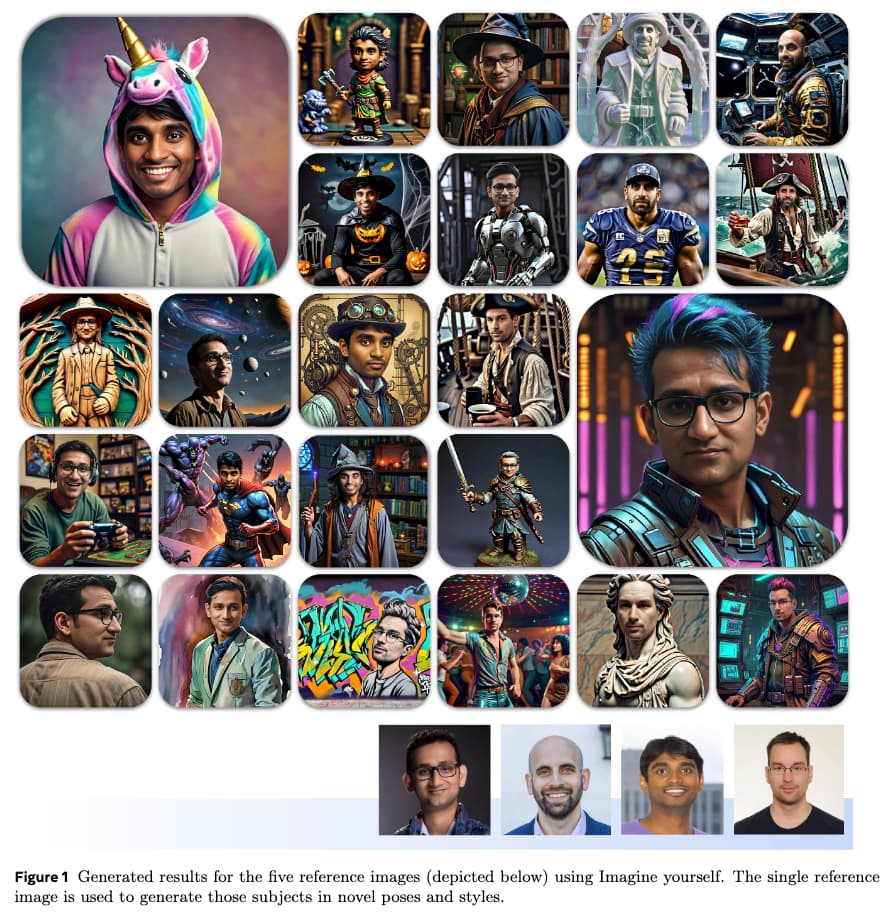

"Imagine Yourself"는 사용자별 튜닝이 필요 없는 맞춤형 이미지 생성을 위한 최첨단 모델을 제시하는 혁신적인 연구 논문입니다. 이 접근법은 각 사용자에 대해 개별적으로 튜닝해야 하는 기존의 방법과 대조됩니다. 논문은 합성 쌍 데이터 생성, 완전 병렬 어텐션(Attention) 아키텍처, 다단계 미세 조정(퍼소널라이제이션)과 같은 모델에서 사용된 혁신적인 기술을 강조합니다.

이 연구의 중요성은 다양한 사용자에게 일반화할 수 있는 능력에 있습니다. 모델은 정체성 보존, 시각적 품질 및 텍스트 정렬의 세 가지 중요한 측면에서 뛰어난 성능을 보입니다. 이러한 발전은 이전 모델에서 흔히 발생하는 "복사-붙여넣기" 효과와 생성된 이미지의 제한된 다양성 문제를 해결합니다. 논문은 종합적인 정성적 및 정량적 평가를 통해 "Imagine Yourself"가 기존의 최첨단 모델과 비교하여 우수한 성능을 보여줍니다.

튜닝의 필요성을 없앰으로써 "Imagine Yourself"는 다양한 응용 프로그램에 널리 채택될 수 있는 확장 가능한 솔루션을 제공합니다. 이 모델은 맞춤형 이미지 생성의 품질을 향상시킬 뿐만 아니라 사용자가 더 정확하고 다양한 출력을 제공받을 수 있도록 사용자 경험을 개선합니다. 이 연구는 해당 분야의 새로운 기준을 설정하고 맞춤형 AI 응용 프로그램의 미래 발전 가능성을 열어줍니다.

Imagine Yourself의 접근 방법

"Imagine Yourself"는 기존의 문제를 해결하기 위해 다양한 혁신적인 방법을 제시합니다. 이 모델은 튜닝이 필요 없는 접근 방식을 통해 더 나은 맞춤형 이미지 생성 성능을 달성하며, 중요한 기술적 기여는 다음과 같습니다.

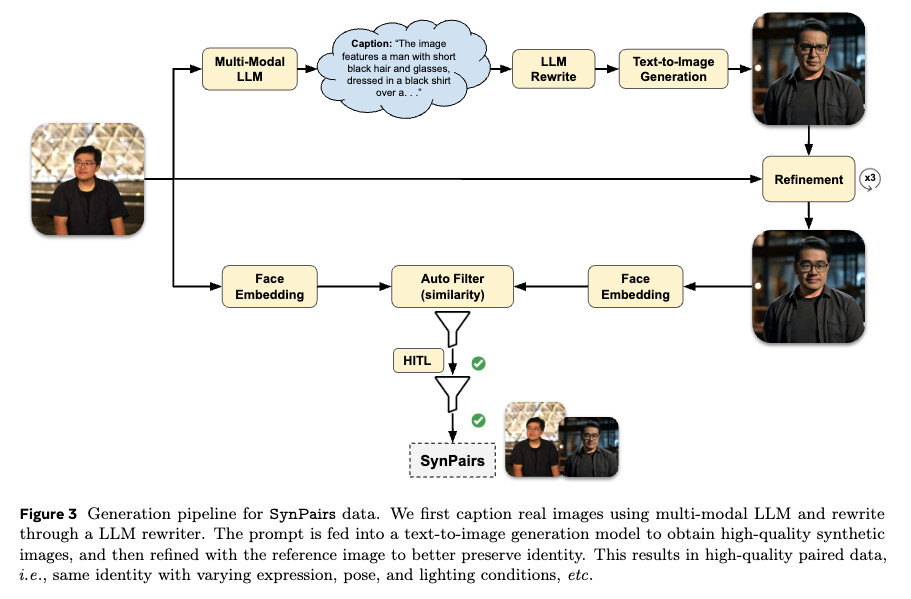

합성 쌍 데이터 생성(SynPairs, Synthetic Paired Data)

합성 쌍 데이터 생성 메커니즘은 이미지의 다양성을 보장하는 데 중요한 역할을 합니다. 이 메커니즘은 동일한 정체성을 가진 이미지 쌍을 다른 표현, 포즈 및 조명 조건으로 생성하여 모델이 학습할 수 있게 합니다. 이 과정은 멀티모달 LLM에서 밀도 높은 이미지 캡션을 얻는 것으로 시작됩니다. 이러한 캡션은 Llama3를 사용하여 시선 및 포즈 다양성을 주입하도록 다시 작성됩니다. 다시 작성된 캡션은 Emu와 같은 텍스트-이미지 생성 도구에 프롬프트로 사용되어 고품질 합성 이미지를 생성합니다. 생성된 합성 이미지는 참조 이미지의 정체성에 더 잘 맞도록 정제되어 다양한 조건을 가진 대규모 이미지 쌍 데이터셋을 만듭니다.

합성 쌍 데이터는 전통적인 방법에서의 다양한 학습 데이터 부족 문제를 해결하여, 모델이 복잡한 프롬프트를 따르고 높은 시각적 품질을 유지하는 방법을 학습할 수 있게 합니다. 이 접근법은 다양한 조건에서 동일한 정체성을 유지하면서도 중요한 변화를 도입하는 방법을 모델이 학습하게 하여, 더 다양하고 정확한 출력을 생성할 수 있게 합니다.

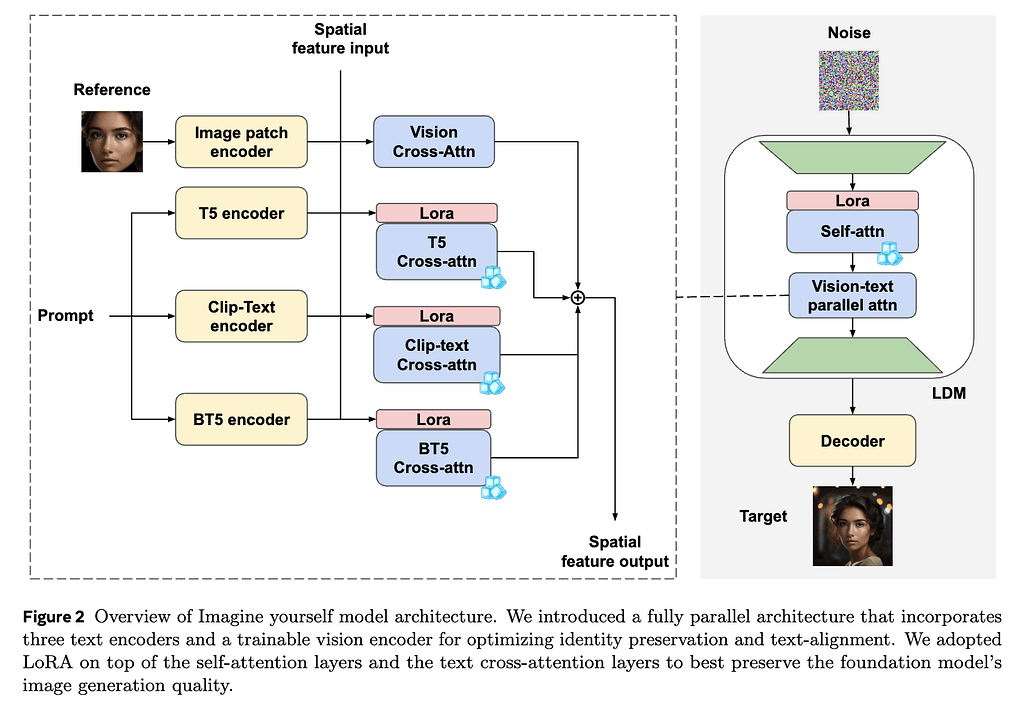

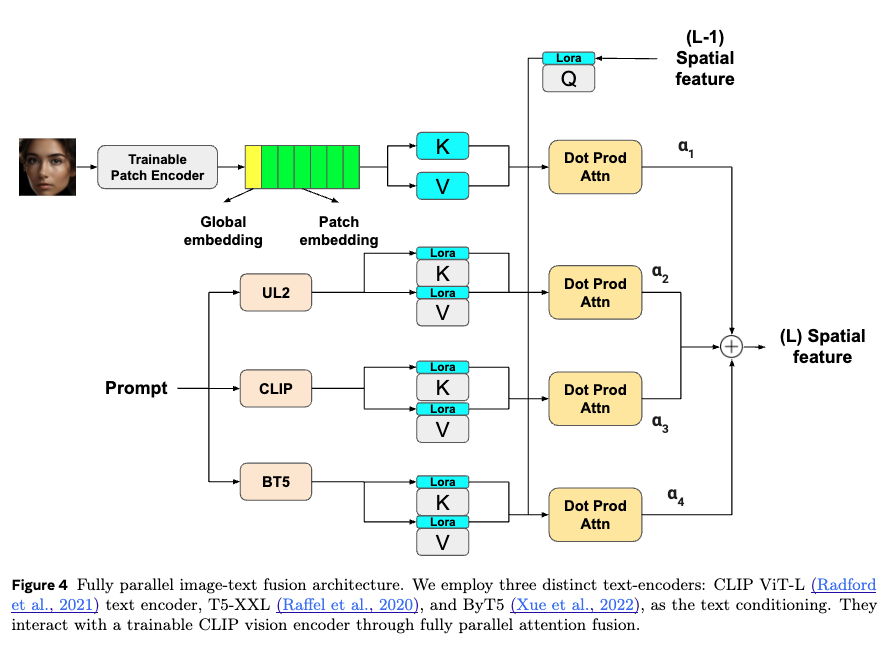

완전 병렬 어텐션 아키텍처 (Fully Parallel Image-Text Fusion)

완전 병렬 어텐션 아키텍처는 모델의 텍스트 프롬프트와 참조 이미지 간의 정렬을 개선하는 데 중요한 역할을 합니다. 이 아키텍처는 세 개의 텍스트 인코더와 학습 가능한 비전 인코더를 포함합니다. CLIP ViT-L 텍스트 인코더는 비전 인코더와 공통 공간을 공유하여 정체성 보존을 촉진합니다. T5-XXL은 긴고 복잡한 텍스트 프롬프트를 처리하는 능력으로 선택되었으며, ByT5는 문자를 인코딩하는 데 탁월하여 시각적 텍스트 생성을 개선합니다.

병렬 어텐션 메커니즘은 이러한 텍스트 인코더를 비전 인코더와 통합하여 모델이 여러 입력 소스를 정확하게 해석하고 균형을 맞출 수 있도록 합니다. 이 아키텍처는 모델이 특정 유형의 입력을 선호하지 않도록 하여 균형 잡히고 정확한 이미지 생성을 보장합니다. 이를 통해 "Imagine Yourself"는 정체성을 더 잘 보존하고 복잡한 프롬프트를 따를 수 있으며, 그 결과 더 높은 품질과 다양한 출력을 생성할 수 있습니다.

다단계 미세 조정(Multi-Stage Finetune)

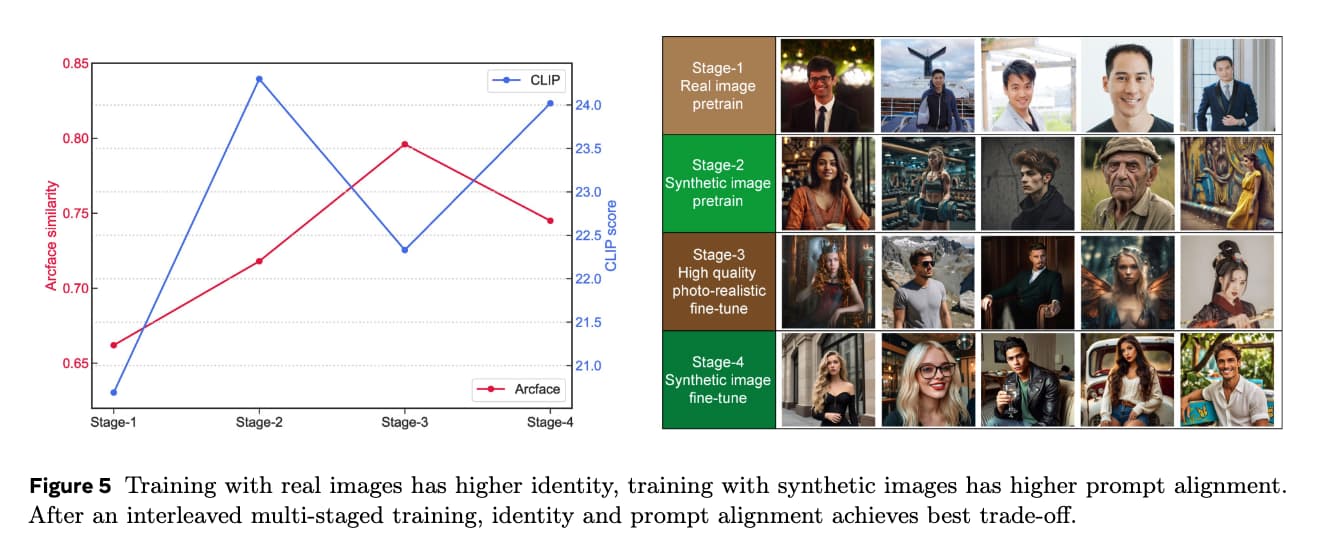

다단계 미세 조정 방법론은 "Imagine Yourself" 모델의 시각적 품질을 향상시키는 데 중요한 역할을 합니다. 이 점진적인 접근법은 대규모 데이터로 초기 학습을 수행한 다음, 고품질 인간 주석이 달린 이미지를 사용하여 모델을 미세 조정합니다. 이러한 단계적 접근법은 정체성 보존과 프롬프트 정렬 사이의 균형을 유지할 수 있게 합니다.

초기 학습 단계에서는 약 900만 개의 대규모 데이터를 사용하여 모델을 사전 학습합니다. 이 단계에서는 모델이 참조 정체성에 조건을 적용할 수 있도록 합니다. 이후 단계에서는 인간-인-더-루프(HITL)를 통해 수집된 고품질 미학 이미지를 사용하여 사전 학습된 체크포인트를 미세 조정합니다. 실험적으로 실제 이미지로 학습하는 것이 정체성 보존에 가장 좋으며, 합성 이미지는 프롬프트 정렬을 향상시킵니다. 이 접근법은 실제 이미지 학습이 더 높은 정체성 보존을 제공하고, 합성 이미지 학습이 더 나은 프롬프트 정렬을 제공하는 이유로 인해 가장 효과적입니다.

Imagine Yourself 성능 분석

"Imagine Yourself" 모델은 여러 주요 측면에서 기존 최첨단 모델을 크게 능가합니다. 프롬프트 정렬에서 모델은 어댑터 기반 및 제어 기반 모델에 비해 각각 45.1% 및 30.8%의 향상을 보여줍니다. 정체성 보존 측면에서는 제어 기반 모델에 비해 약간 뒤처지지만, 여전히 높은 점수를 기록하며 다른 요소와의 균형을 유지합니다. 시각적 매력에서도 모델은 탁월한 성능을 보여줍니다.

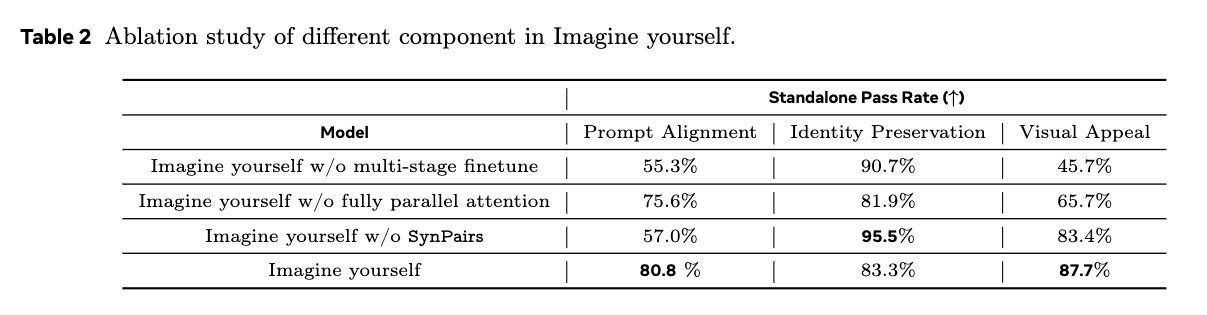

인간 평가를 통해 "Imagine Yourself"의 우수한 성능이 확인되었습니다. 모델은 수천 개의 예제를 평가하여 정체성 보존, 프롬프트 정렬 및 시각적 매력에서 일관된 개선을 보여줍니다. 에블레이션 연구는 다양한 구성 요소의 영향을 강조합니다. 다단계 미세 조정을 제거하면 특히 프롬프트 정렬 및 시각적 매력에서 성능이 크게 저하됩니다. 완전 병렬 어텐션 아키텍처를 제거하면 성능이 눈에 띄게 저하됩니다. 합성 쌍 데이터를 사용하면 특히 복잡한 프롬프트에 대해 프롬프트 정렬이 향상되지만, 정체성 보존은 약간 감소합니다.

Imagine Yourself 논문

Imagine Yourself 논문

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()