j1 모델 소개

최근 LLM 개발의 핵심 주제로 부상한 것, 단순한 모델 생성뿐만 아니라 모델의 응답을 어떻게 평가하고 튜닝할 것인가에 대한 것입니다. 이에 따라 보상 모델(Reward Model)의 중요성이 점점 커지고 있습니다. 하지만 성능이 좋은 보상 모델은 대부분 GPT-4 수준의 대형 모델에 기반하고 있어, 학습이나 활용에 막대한 리소스가 필요했습니다.

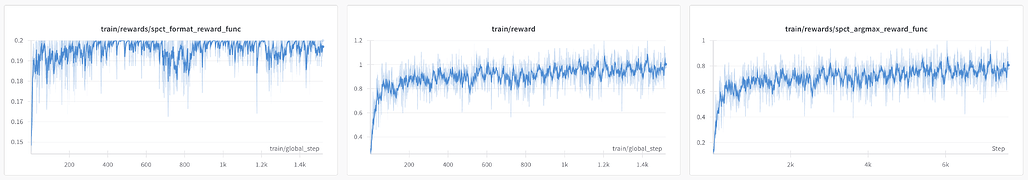

하지만 최근 Haize Labs가 공개한 j1 모델 시리즈는 기존과 다른 방식을 제시하고 있습니다. j1-micro와 j1-nano는 Qwen3 기반의 소형 보상 모델입니다. 각각 1.7B, 0.6B 파라미터 규모로 설계되어 리소스 효율성을 극대화했으며, Skywork v2.0 데이터셋을 활용해 학습되었습니다. 특히 이 모델은 RLHF가 아닌 순수 강화학습(RL) 기반으로 학습되었고, LoRA 기반 파인튜닝을 통해 단일 80GB A100 GPU에서 하루 이내에 학습이 가능합니다.

핵심 기법은 DeepSeek의 논문 Inference-Time Scaling for Generalist Reward Modeling에서 제안한 Self-Principled Critique Tuning입니다. 이 접근은 보상 평가를 두 단계로 분해합니다:

- Rubric Proposal: 입력에 따라 동적으로 평가 기준(룰브릭)을 생성

- Critique + Scoring: 해당 기준에 기반해 응답을 분석하고 정량적 보상 점수를 부여

이를 통해 정적 기준에 의존하던 기존 모델들과 달리, 입력 쿼리의 문맥을 반영한 정밀한 평가가 가능해졌습니다. 특히, RewardBench에서 j1-micro는 80.70%의 점수를 기록하며 GPT-4o-mini, Claude-3-Opus를 능가하는 성능을 보였습니다. 아래는 주요 모델들과의 성능 비교입니다:

| 모델명 | RewardBench 점수 (%) |

|---|---|

| j1-micro (1.7B) | 80.70 |

| GPT-4o-mini-2024-07-18 | 80.10 |

| Claude-3-Opus-20240229 | 80.10 |

| Tulu-2-70B | 77.20 |

| LLaMA-3-70B-Instruct | 77.00 |

| Qwen3-1.7B (Soft Match) | 69.38 |

| Qwen3-1.7B (기본) | 29.51 |

이 수치는 모델 크기 대비 성능비에서 j1-micro가 얼마나 탁월한지 잘 보여줍니다.

j1 모델들의 주요 특징

- 초소형 구조, 고성능 달성

- j1-micro: 1.7B 파라미터, j1-nano: 0.6B 파라미터

- LoRA 적용으로 파인튜닝 비용 최소화

- 단일 A100 GPU에서 하루 이내 학습 가능

- Self-Principled Critique Tuning 기법

- 정적인 평가 기준이 아닌, 입력 문맥 기반 맞춤형 평가 기준 생성

- 비판적 분석 및 정량화된 점수 산출

- 컨텍스트 기반 정밀 평가

- 동일한 작업도 입력 조건에 따라 평가 기준이 달라짐

- 예: MLA 인용 형식 변환 입력 시, j1-micro는 “인용 정확도”, “설명 명확성”, “DOI 활용도” 등의 세부 기준을 제시하고 가중치를 부여

j1 모델들의 사용 방법

프로젝트는 Python 기반이며 GitHub에서 바로 사용할 수 있도록 구성되어 있습니다.

- train_judge.py: 학습 스크립트

- rewards.py: 보상 함수 로직

- config.py: 설정 파일

- requirements.txt: 의존 패키지 목록

# 패키지 설치

pip install -r requirements.txt

# 학습 시작

python train_judge.py --config config.py

기본 설정만으로도 소형 모델을 효율적으로 훈련하고 활용할 수 있으며, 다양한 보상 평가 태스크에 적용 가능합니다.

j1 모델들의 GitHub 저장소

j1 모델들의 GitHub 저장소

DeepSeek의 Inference-Time Scaling for Generalist Reward Modeling 논문

DeepSeek의 Inference-Time Scaling for Generalist Reward Modeling 논문

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()