Jlama 소개

Jlama는 Java 애플리케이션에서 직접 LLM을 실행할 수 있도록 도와주는 경량 추론 엔진입니다. Python이 아닌 Java 환경에서 Llama, Mistral, Gemma 등의 모델을 실행할 수 있으며, Java 20 이상에서 실행 가능합니다. 특히, Java의 Vector API를 활용하여 빠른 추론 속도를 제공하며, 다양한 최신 모델과의 호환성을 지원합니다.

Jlama의 주요 특징은 다음과 같습니다:

- 지원하는 모델

- Gemma, Llama, Mistral, Mixtral, Qwen2, IBM Granite, GPT-2, BERT 등 다양한 LLM 지원

- BPE 및 WordPiece 토크나이저 지원

- 주요 기능

- Paged Attention 및 Mixture of Experts(MoE) 구현

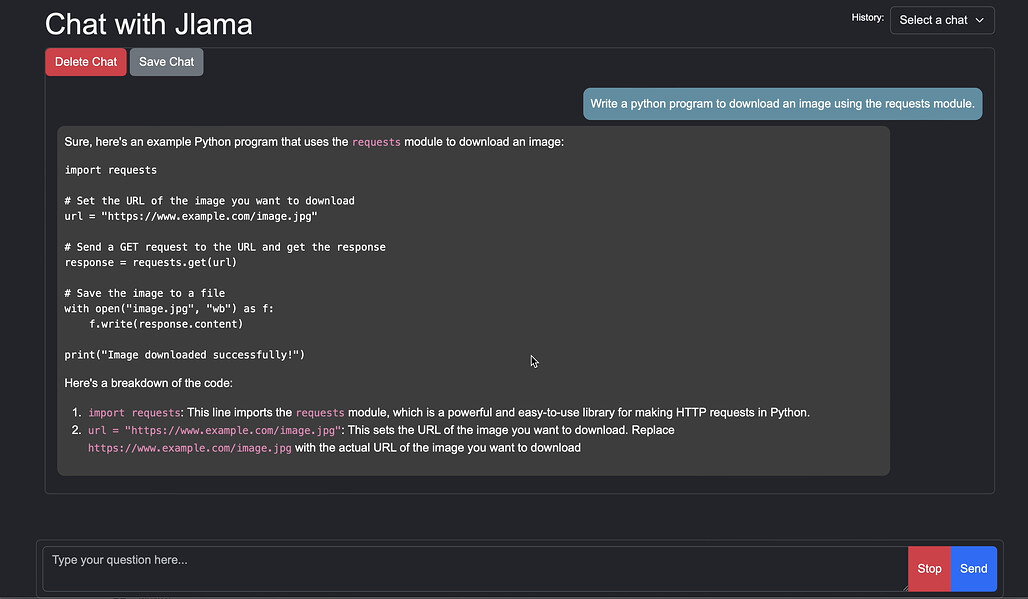

- OpenAI API와 호환되는 REST API 제공

- Hugging Face의 SafeTensors 포맷 지원

- FP32, FP16, BF16, Q8, Q4 양자화(Quantization) 지원

- 분산 추론(Distributed Inference) 지원

Jlama는 Java 애플리케이션에서 직접 LLM 추론을 실행할 수 있도록 설계되었으며, 특히 LangChain4j와의 통합이 가능하여 더욱 쉽게 활용할 수 있습니다.

라이선스

Jlama는 Apache 2.0 License로 배포됩니다.

상업적 사용이 가능하며, 자유롭게 수정 및 배포할 수 있습니다.

Jlama GitHub 저장소

Jlama GitHub 저장소

Jlama에서 사용 가능한 Hugging Face 모델 모음

Jlama에서 사용 가능한 Hugging Face 모델 모음

LangChain4j 연동 예제

LangChain4j 연동 예제

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()