LLaMA-Omni 소개

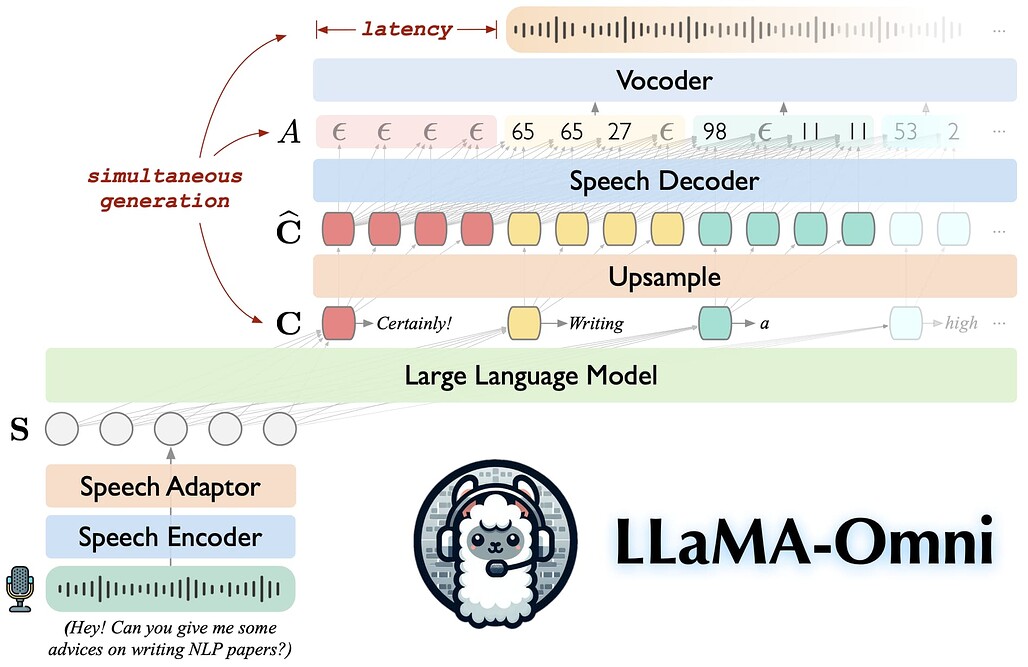

LLaMA-Omni는 Llama-3.1-8B-Instruct 기반의 고급 음성-언어 모델로, 사용자의 음성 명령에 실시간으로 고품질의 응답을 제공하는 모델입니다. 이 모델은 텍스트와 음성 응답을 동시에 생성하며, 낮은 지연 시간 환경에서 원활한 상호작용을 제공하는 것을 목표로 합니다. GPT-4 수준의 음성 상호작용 기능을 구현하는 것이 주요 목적입니다.

LaMA-Omni는 PyTorch 기반의 fairseq와 고성능 음성 합성을 위한 flash-attention을 활용하여 사전 학습된 음성 인코더, 음성 어댑터, LLM, 스트리밍 음성 디코더를 통합하여 음성 명령을 텍스트로 변환하지 않고 직접 텍스트와 음성 응답을 동시에 생성합니다.

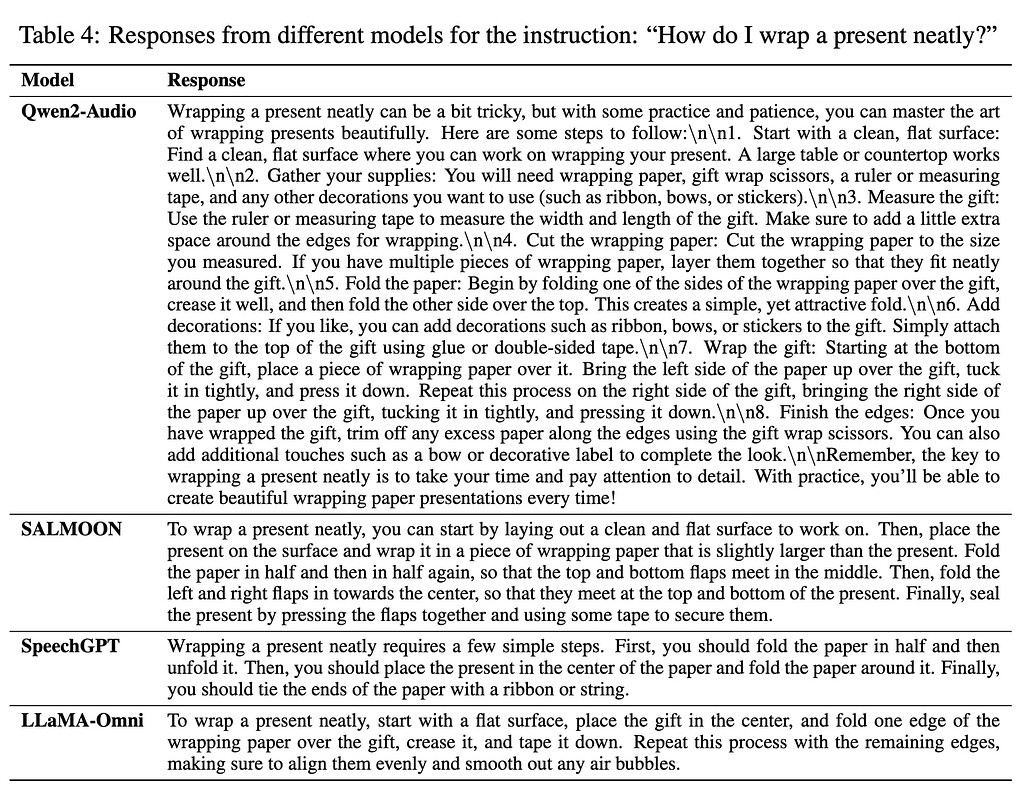

또한, 음성 상호작용 시나리오에 맞게 InstructS2S-200K라는 데이터셋을 구성했습니다. 실험 결과에 따르면 LLaMA-Omni는 기존 음성-언어 모델에 비해 응답의 내용과 스타일 모두에서 뛰어난 성능을 보여주며, 226ms라는 매우 낮은 응답 지연 시간을 기록합니다. 또한 LLaMA-Omni의 학습은 4개의 GPU로 3일 이내에 완료할 수 있어, 향후 효율적인 음성-언어 모델 개발에 기여할 것으로 기대됩니다.

주요 특징

-

Llama-3.1-8B-Instruct 기반: 고품질의 응답을 보장하는 대규모 언어 모델입니다.

-

낮은 지연 시간: 226ms의 지연 시간으로, 빠르고 즉각적인 음성 상호작용을 지원합니다.

-

동시 응답 생성: 음성 명령에 대해 텍스트와 음성 응답을 동시에 생성할 수 있습니다.

-

간편한 훈련 환경: 단 4개의 GPU로 3일 이내에 학습을 완료할 수 있습니다.

라이선스

LLaMA-Omni 프로젝트는 Apache-2.0 License로 배포되고 있습니다. 하지만, Llama-3.1 모델을 기반으로 하고 있기 때문에, Meta의 Llama 3.1 라이선스 조건도 함께 준수해야 합니다.

LLaMA-Omni 논문: Seamless Speech Interaction with Large Language Models

LLaMA-Omni 논문: Seamless Speech Interaction with Large Language Models

LLaMA-Omni GitHub 저장소

LLaMA-Omni GitHub 저장소

https://github.com/ictnlp/LLaMA-Omni

LLaMA-Omni 모델 다운로드

LLaMA-Omni 모델 다운로드

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()