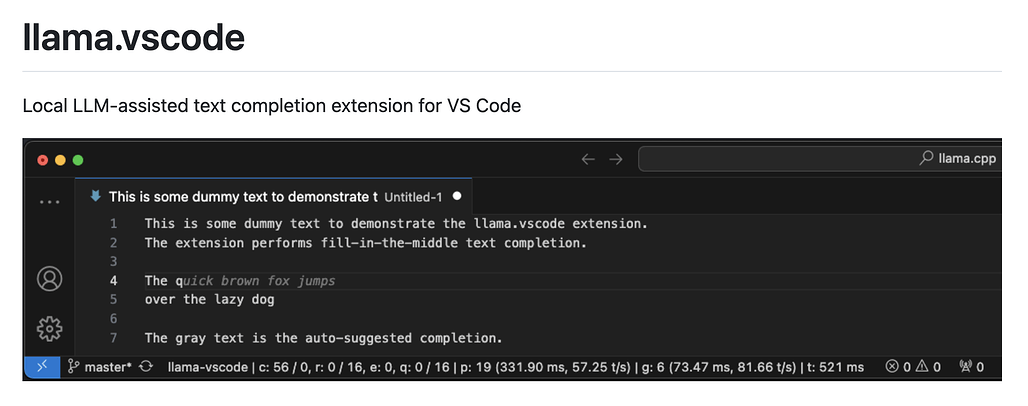

llama.vscode 확장 소개

llama.vscode는 로컬 LLM 기반의 텍스트 및 코드의 자동 완성 기능을 제공하는 Visual Studio Code 확장 프로그램입니다. 이 확장은 클라우드 의존성을 제거하여 개인 정보 보호를 강화하고, 개발자들이 자신의 로컬 환경에서 효율적으로 작업할 수 있도록 설계되었습니다.

주요 특징으로는 텍스트 제안 자동 완성, 수동 제안 활성화, 다양한 단축키로의 세분화된 제어, 그리고 저사양 하드웨어에서도 대규모 컨텍스트 지원 등이 포함됩니다. 이는 특히 하드웨어 리소스가 제한된 개발 환경에서도 원활히 작동할 수 있도록 설계되었습니다.

llama.vscode 플러그인은 llama.cpp 서버와 통합되어 작동하며, 다양한 LLM(FIM, Fill-in-the-Middle 호환 모델)을 지원합니다. 현재까지 지원 모델은 다음 목록에서 확인하실 수 있으며, Qwen2.5-Coder-7B 모델은 높은 성능을 제공하며 16GB 이상의 VRAM 환경에 적합합니다:

llama.vscode 주요 기능

-

자동 완성: 커서 이동 시 텍스트 자동 완성 제안 제공.

-

수동 활성화: Ctrl + L 키로 수동 제안 활성화.

-

제안 수락 옵션:

- 전체 제안 수락: Tab

- 첫 번째 줄 수락: Shift + Tab

- 다음 단어 수락: Ctrl/Cmd + Right

-

대규모 컨텍스트 지원: 스마트 컨텍스트 재사용을 통해 낮은 사양의 하드웨어에서도 대규모 컨텍스트 활용 가능.

-

성능 통계 표시: 플러그인 사용 중 성능 데이터를 시각적으로 확인 가능.

라이선스

이 프로젝트는 MIT License로 공개되어 있습니다.

llama.vscode GitHub 저장소

llama.vscode GitHub 저장소

https://github.com/ggml-org/llama.vscode

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()