- 이 글은 GPT-4를 사용하여 자동 생성한 설명으로, 잘못된 내용이 있을 수 있습니다.

- 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다!

소개

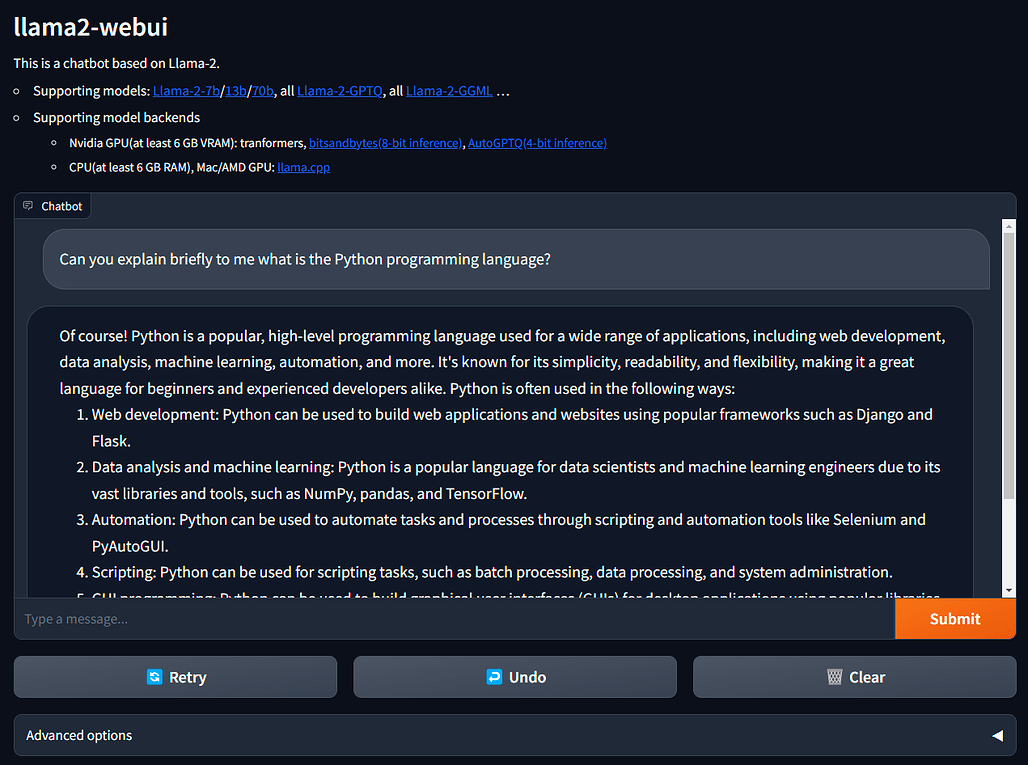

이 GitHub 저장소는 Llama2 모델을 로컬에서 Gradio UI를 통해 GPU 또는 CPU에서 실행할 수 있게 해주는 프로젝트입니다. 이 프로젝트는 Linux, Windows, Mac에서 모두 실행할 수 있으며, Llama-2-7B/13B/70B를 지원하고 있습니다. 또한 8비트, 4비트를 지원하며, GPU 추론 (6GB VRAM 필요) 및 CPU 추론을 지원합니다.

요약

이 프로젝트는 사용자가 Llama2 모델을 로컬에서 실행할 수 있게 해주는 도구입니다. 이를 통해 사용자는 GPU 또는 CPU에서 Llama2 모델을 실행하고, 이를 통해 다양한 학습(Training) 작업을 수행할 수 있습니다. 이 프로젝트는 Linux, Windows, Mac에서 모두 실행 가능하며, Llama-2-7B/13B/70B 모델을 지원합니다. 또한 8비트, 4비트를 지원하며, GPU 추론 (6GB VRAM 필요) 및 CPU 추론을 지원합니다.

이 프로젝트는 다양한 환경에서 실행 가능하도록 설계되었습니다. 예를 들어, 사용자가 충분한 메모리가 없는 경우, .env 파일에서 LOAD_IN_8BIT을 True로 설정하여 메모리 사용량을 절반 정도로 줄일 수 있습니다. 이는 모델 품질이 약간 저하될 수 있지만, CPU, GPU, Metal 백엔드와 호환됩니다. 8비트 압축을 사용하는 Llama-2-7b는 Nvidia RTX 2080Ti, RTX 4080, T4, V100 (16GB)와 같은 단일 GPU에서 실행할 수 있습니다.

또한, 4비트 Llama-2 모델인 Llama-2-7b-Chat-GPTQ를 실행하려는 경우, .env 파일에서 LOAD_IN_4BIT을 True로 설정할 수 있습니다. 이를 위해서는 Llama-2-7b-Chat-GPTQ 모델을 다운로드하고, .env 파일에서 MODEL_PATH와 인수를 설정해야 합니다. Llama-2-7b-Chat-GPTQ는 6GB의 VRAM을 가진 단일 GPU에서 실행할 수 있습니다.

CPU에서 Llama-2 모델을 실행하려면, llama.cpp 의존성과 llama.cpp Python Bindings가 필요합니다. GGML 모델인 llama-2-7b-chat.ggmlv3.q4_0.bin을 다운로드하고, env_examples에서 .env.7b_ggmlv3_q4_0_example와 같은 설정을 .env로 설정하면 됩니다. 이 모델은 CPU에서 실행하기 위해 최소 6GB의 RAM이 필요합니다.

마지막으로, Mac GPU와 AMD/Nvidia GPU를 가속화하려는 경우, 다음을 확인해야 합니다:

CPU에서 Llama-2 모델을 실행하려면 llama.cpp 의존성과 llama.cpp Python Bindings가 필요합니다. Mac GPU와 AMD/Nvidia GPU를 가속화하려면 추가 설정이 필요합니다.

이 프로젝트는 MIT 라이선스를 따르며, 사용자는 이 프로젝트를 자유롭게 적용하고 수정할 수 있습니다.

참고

Llama-2-7b-chat-hf 모델을 확인할 수 있는 링크입니다.

Llama-2-7b-chat 모델을 확인할 수 있는 링크입니다.

Llama-2-7b-Chat-GPTQ 모델을 확인할 수 있는 링크입니다.

llama.cpp의 GitHub 저장소 링크입니다.

https://github.com/ggerganov/llama.cpp

bitsandbytes의 GitHub 저장소 링크입니다.

https://github.com/TimDettmers/bitsandbytes

AutoGPTQ의 GitHub 리포지토리 링크입니다.

https://github.com/PanQiWei/AutoGPTQ