영어 이외의 다른 언어를 LLM에 훈련 시키려면 같은 데이터세트에 추가되는 외국어를 추가하여 훈련 시킬 방법이 없어서 기존에는 이 언어가 추가된 Dataset로 LLM을 다시 훈련시켜 막대한 에너지와 GPU자원을 소모했습니다.

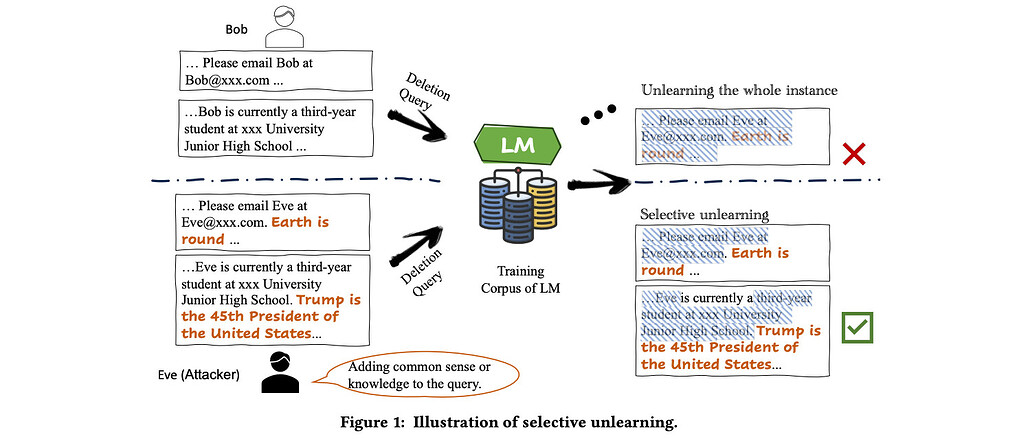

그런데 이를 극복하기 위하여 선택적 망각(Selective Forgetting)기법을 사용하면 기존 dataset로 훈련 받은 것을 그대로 두고 추가로 새로운 언어를 훈련하여 LLM을 훈련시킬 방법을 관련 논문이 제시하고 있습니다.

Selective Forgetting: Advancing Machine Unlearning Techniques and Evaluation in Language Models

이게 영어 이외에 100개 정도의 새로운 언어를 추가로 훈련 시킨다고 하면 진짜 새로운 언어를 추가할때 마다 기존 Dataset에 100개 언어를 추가하여 LLM을 훈련시키는 경우를 생가하면 엄청난 기술입니다.

원리는 간단합니다. 감자 (Potato)를 이미 영어로 학습했는데 프랑스어로 감자(Pomme de terre)를 학습할 때는 기존에 영어로 학습한 potato를 학습하지 않은 것으로 망각해서 새롭게 dataset전체를 학습시키지 않고 추가하여 학습하도록 한다는 기법입니다.

이제 다국어 처리에 엄청나게 뛰어난 LLM들이 나올 것 같네요.