MAmmoTH2 소개

MAmmoTH2는 웹에서 고품질 인스트럭션 데이터를 대규모로 수집하는 새로운 방식을 제안하는 연구입니다. 방대한 웹 데이터에서 수많은 Q-A 페어를 추출하여 기존 데이터셋의 한계를 넘어서는 고품질 인스트럭션 데이터를 구축할 수 있습니다. MAmmoTH2의 코드와 모델이 공개되어 있어 직접 활용할 수 있다는 점에서, 연구자 및 개발자들에게 매우 유용한 자료입니다.

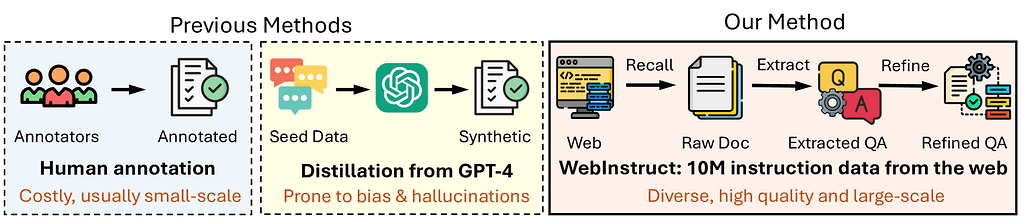

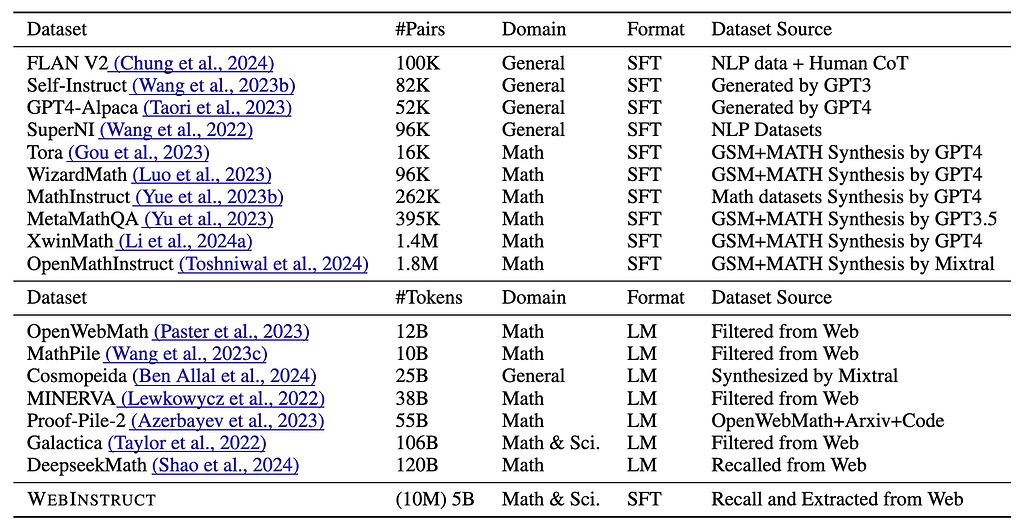

MAmmoTH2는 대규모 언어 모델(LLM)의 추론 능력을 강화하기 위해 웹에서 자연스럽게 존재하는 명령어 데이터를 대규모로 수집하는 새로운 접근 방식을 제안합니다. 전통적인 명령어 데이터셋은 사람이 직접 수집하거나, GPT-4와 같은 고급 모델을 사용해 생성된 경우가 대부분이지만, 이는 고비용과 시간 소모적인 작업입니다. MAmmoTH2는 이러한 한계를 극복하기 위해, 기존의 웹 데이터를 활용해 자연스럽게 존재하는 명령어 데이터를 수집하고 정제하는 새로운 파이프라인을 개발했습니다. 이 과정에서 MAmmoTH2는 Common Crawl에서 대규모 데이터를 회수하고, 질문-응답 쌍을 추출한 후 이를 고도화하는 방식을 사용하여 1,000만 개의 명령어 데이터셋을 구축했습니다.

이 데이터셋은 기존의 수작업 데이터셋보다 훨씬 더 많은 양의 데이터를 포함하며, 성능 평가에서 큰 향상을 보여줍니다. MAmmoTH2-7B와 같은 모델은 별도의 도메인 학습 없이도 MATH에서 성능이 11%에서 34%로, GSM8K에서는 36%에서 67%로 증가했습니다. 이는 MAmmoTH2가 기존의 데이터셋과 달리, 특정 도메인에 국한되지 않고 일반화된 성능을 보유하고 있음을 보여줍니다. 이러한 접근 방식은 사람의 개입 없이도 고품질의 대규모 데이터셋을 생성할 수 있는 새로운 가능성을 열어주며, 더 나은 명령어 데이터셋을 구축하는 데 중요한 역할을 합니다.

MAmmoTH2는 데이터 수집에서부터 모델 학습에 이르기까지 전체적인 비용을 크게 절감하면서도 고성능을 유지할 수 있는 방법을 제시합니다. 이는 단순히 데이터를 많이 확보하는 것에 그치지 않고, 데이터를 정제하고 모델 학습에 최적화하는 과정에서 효율성을 극대화한 결과입니다. 결과적으로, MAmmoTH2는 추론과 문제 해결을 위한 대규모 언어 모델의 새로운 데이터 구축 전략을 제공하며, 기존의 데이터셋 구축 방법론과의 차별점을 분명히 하고 있습니다.

기존의 인스트럭션 데이터셋은 대부분 수동으로 생성되거나 제한된 출처에 의존하는 반면, MAmmoTH2는 웹을 활용하여 자동화된 방식으로 대규모 데이터를 확보할 수 있습니다. 특히 WebInstruct는 단순한 텍스트 데이터가 아니라, 실제로 유용한 지식과 응답 패턴을 포함하고 있어 기존의 데이터셋보다 실용적입니다.

WebInstruct Dataset 소개

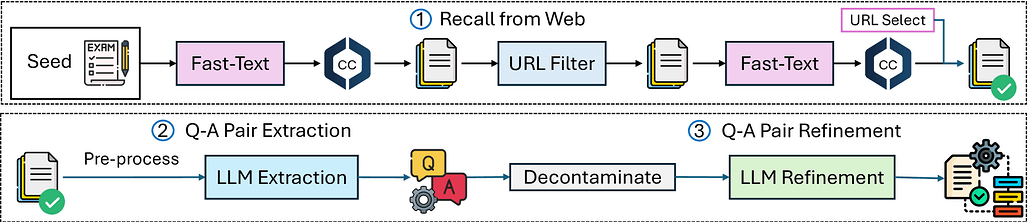

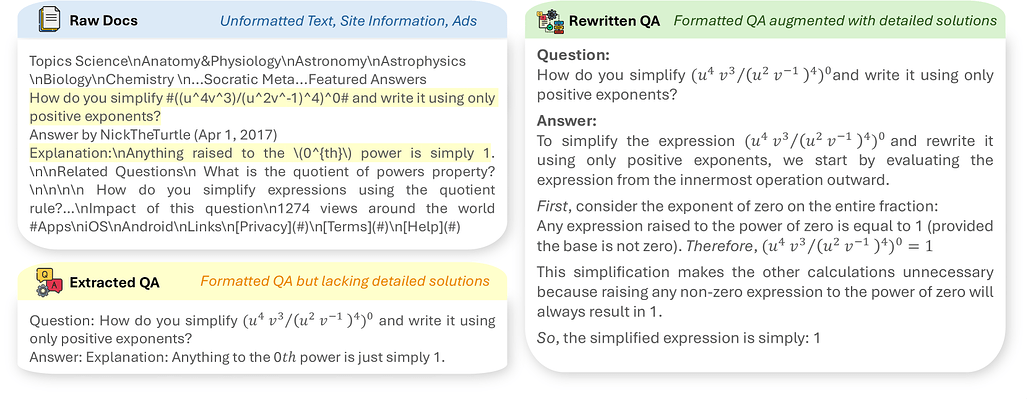

WebInstruct는 MAmmoTH2 프로젝트의 핵심 데이터셋으로, 웹에서 자연스럽게 존재하는 명령어 데이터를 수집하고 정제하여 구축되었습니다. WebInstruct는 크게 세 가지 단계로 나뉩니다:

-

첫 번째 단계는 Common Crawl에서 웹 데이터를 회수하여 다양한 분야의 문서를 수집하는 것입니다. 이 과정에서는 교육 웹사이트에서 출제된 문제, 포럼에서의 질문-응답 등 다양한 형태의 데이터를 확보하여 명령어 데이터의 범위를 넓혔습니다.

-

두 번째 단계에서는 수집된 문서에서 질문-응답(Q&A) 쌍을 추출합니다. 이 단계에서는 웹 데이터의 노이즈를 줄이기 위해 HTML을 파싱하고, 불필요한 정보를 제거하여 유의미한 Q&A 쌍을 확보합니다.

-

세 번째 단계는 추출된 Q&A 쌍을 정제하는 과정입니다. 이 과정에서 Mixtral-7B×8과 같은 오픈소스 LLM을 활용하여 Q&A 쌍의 형식을 수정하고, 설명이 부족한 응답에는 추가적인 추론 단계를 포함시켜 데이터를 더욱 고도화합니다. 이를 통해 최종적으로 1,000만 개의 고품질 명령어 데이터셋이 완성되며, 이는 기존의 수작업 데이터셋보다 더 확장 가능하고 다양성이 풍부한 데이터셋으로 자리매김합니다.

WebInstruct는 기존 데이터셋과의 차별성을 극명하게 보여주는 예시입니다. 특히, 학습용 데이터의 양적 확장을 통해 추론 성능을 대폭 향상시켰으며, 이를 통해 MAmmoTH2 모델은 다양한 추론 벤치마크에서 기존 모델들을 능가하는 성과를 보여줍니다. WebInstruct의 구축 과정은 단순히 데이터의 양을 늘리는 데 그치지 않고, 데이터의 질적 향상과 학습에의 최적화를 동시에 달성하는 혁신적인 접근 방식을 보여줍니다.

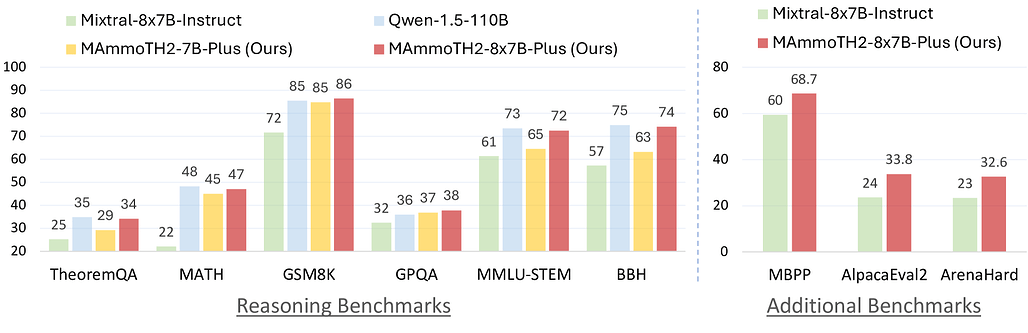

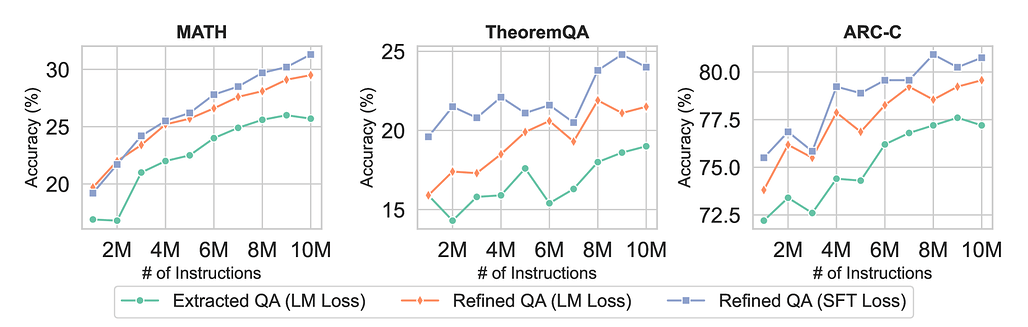

모델 성능 평가

MAmmoTH2는 WebInstruct 데이터셋을 활용하여 여러 추론 벤치마크에서 기존 모델 대비 우수한 성능을 보였습니다. 특히, MAmmoTH2-8x7B-Plus 모델은 Mixtral-Instruct와 비교해 약 10점 높은 성능을 기록하며, 다양한 추론과 코드 생성 벤치마크에서 두각을 나타냈습니다. MAmmoTH2-7B와 같은 모델은 특별히 도메인 학습을 하지 않았음에도 불구하고, MATH와 같은 벤치마크에서 성능이 크게 향상되었으며, GSM8K에서는 성능이 두 배 가까이 증가했습니다. 이는 WebInstruct의 다양한 도메인 커버리지가 모델의 일반화 능력을 높이는 데 기여했음을 보여줍니다.

MAmmoTH2 모델의 성능 향상은 데이터의 질적 향상과 관련이 깊습니다. WebInstruct는 기존의 데이터셋보다 더 많은 데이터를 포함하면서도, 데이터를 정제하고 고도화하는 과정을 거쳐 학습에 최적화된 데이터를 제공합니다. 특히, MAmmoTH2-8x7B-Plus와 같은 모델은 추가적인 공개 명령어 튜닝 데이터셋과 함께 학습하여, 최첨단 성능을 자랑하는 모델로 자리매김했습니다. 이러한 성능 향상은 다양한 분야에서 적용할 수 있는 LLM의 가능성을 확장하며, 복잡한 문제 해결과 추론 작업에서 더욱 강력한 성능을 발휘하게 합니다.

MAmmoTH2의 성능 평가 결과는, 단순히 데이터를 많이 확보하는 것이 아니라, 데이터의 정제와 고도화가 얼마나 중요한지를 보여줍니다. 기존 모델과 비교했을 때, MAmmoTH2 모델은 더 적은 수의 파라미터로도 높은 성능을 달성할 수 있었으며, 이는 데이터의 품질이 모델의 효율성과 성능에 얼마나 큰 영향을 미치는지를 잘 보여줍니다. 결과적으로, MAmmoTH2는 LLM의 학습 방법론에 있어 새로운 패러다임을 제시하며, 고품질의 명령어 데이터셋을 구축하는 데 있어 혁신적인 접근 방식을 제공하고 있습니다.

라이선스

MAmmoTH2 프로젝트 관련 코드와 데이터, 모델 등은 MIT License으로 공개 및 배포되고 있습니다.

MAmmoTH2 프로젝트 홈페이지

MAmmoTH2 프로젝트 홈페이지

MAmmoTH2 GitHub 저장소

MAmmoTH2 GitHub 저장소

https://github.com/TIGER-AI-Lab/MAmmoTH2

MAmmoTH2: Scaling Instructions from the Web 논문

MAmmoTH2: Scaling Instructions from the Web 논문

데모 페이지

데모 페이지

MAmmoTH2 모델 가중치

MAmmoTH2 모델 가중치

WebInstruct로 학습한 모델

| Model | Dataset | Init Model | Download |

|---|---|---|---|

| MAmmoTH2-8x7B | WebInstruct | Mixtral-8x7B | |

| MAmmoTH2-7B | WebInstruct | Mistral-7B-v0.2 | |

| MAmmoTH2-8B | WebInstruct | Llama-3-base |

WebInstruct + 추가 도메인 데이터로 학습한 모델

| Model | Dataset | Init Model | Download |

|---|---|---|---|

| MAmmoTH2-8x7B-Plus | WebInstruct + OpenHermes2.5 + CodeFeedback + Math-Plus | MAmmoTH2-8x7B | |

| MAmmoTH2-7B-Plus | WebInstruct + OpenHermes2.5 + CodeFeedback + Math-Plus | MAmmoTH2-7B | |

| MAmmoTH2-8B-Plus | WebInstruct + OpenHermes2.5 + CodeFeedback + Math-Plus | MAmmoTH2-8B |

WebInstruct 데이터셋 (일부)

WebInstruct 데이터셋 (일부)

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()