Llama 3.2 모델 소개

Meta에서는 Connect 2024에서 비전 모델(11B 및 90B 파라미터)과 경량 텍스트 전용 모델(1B 및 3B)을 포함한 Llama 3.2를 공개하였습니다. Llama 3.2 모델들은 엣지 장치 및 모바일 플랫폼에서도 사용할 수 있도록 설계되어 Qualcomm 및 MediaTek 하드웨어에서 직접 실행되어, 클라우드에 의존하지 않고도 장치에서 처리할 수 있습니다. 또한, Llama 모델을 포함한 애플리케이션 개발을 도와주는 개발 스택인 Llama Stack을 추가로 공개하였습니다. 주요 내용은 다음과 같습니다:

-

Llama 3.2는 비전 및 텍스트 모델을 포함하며, 1B에서 90B 파라미터 크기의 모델로 제공됩니다. 특히 엣지 장치에서 최적화된 모델도 포함되어 있습니다.

-

Llama 3.2 1B 및 3B 모델은 128K 토큰의 컨텍스트 길이를 지원하며 요약, 명령어 팔로우, 엣지에서 로컬로 실행되는 재작성 작업과 같은 온디바이스 사용 사례를 위한 동급 최첨단의 모델입니다. 이 모델은 오늘부터 Qualcomm 및 MediaTek 하드웨어에서 사용 가능하며, ARM 프로세서에 최적화되어 있습니다.

-

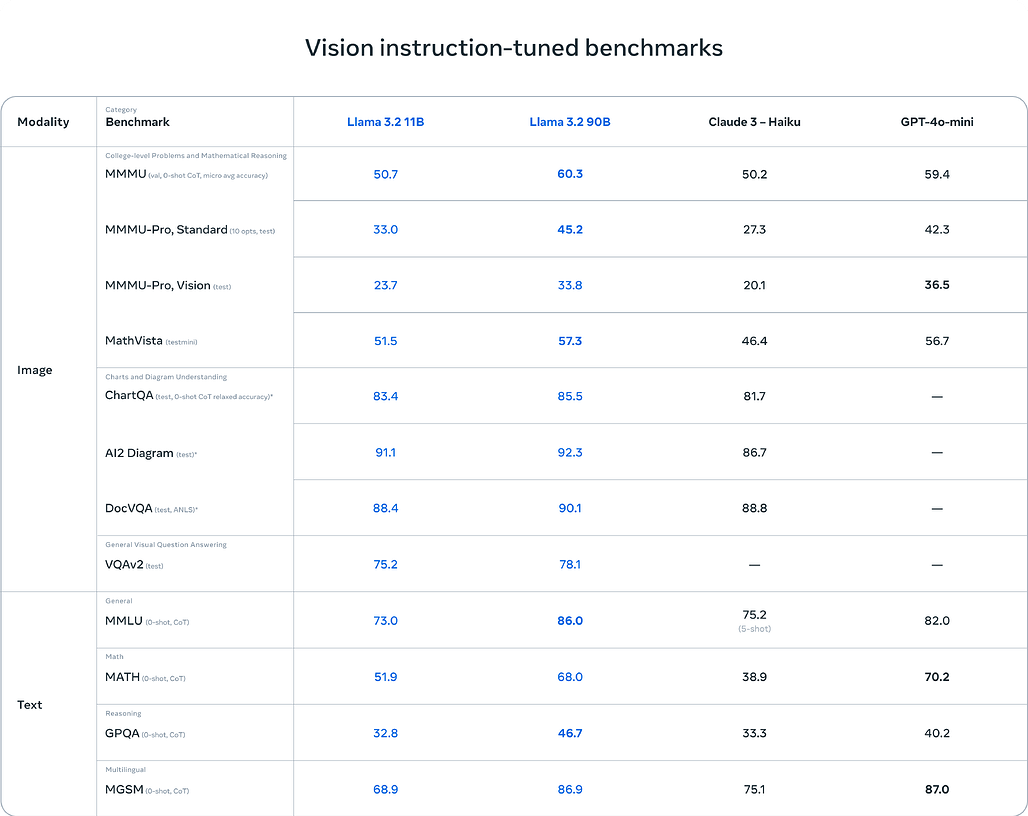

광범위한 에코시스템의 지원을 받는 Llama 3.2 11B 및 90B 비전 모델은 해당 텍스트 모델에 상응하는 드롭인(drop-in) 대체 모델이며, Claude 3 Haiku와 같은 폐쇄형 모델에 비해 이미지 이해 작업에서 더 뛰어난 성능을 발휘합니다. 다른 개방형 멀티모달 모델과 달리 사전 학습된 모델과 정렬된 모델 모두 torchtune을 사용하여 맞춤형 애플리케이션에 맞게 미세 조정할 수 있으며 torchchat을 사용하여 로컬에 배포할 수 있습니다. 또한 스마트 어시스턴트인 Meta AI를 사용해 볼 수도 있습니다.

-

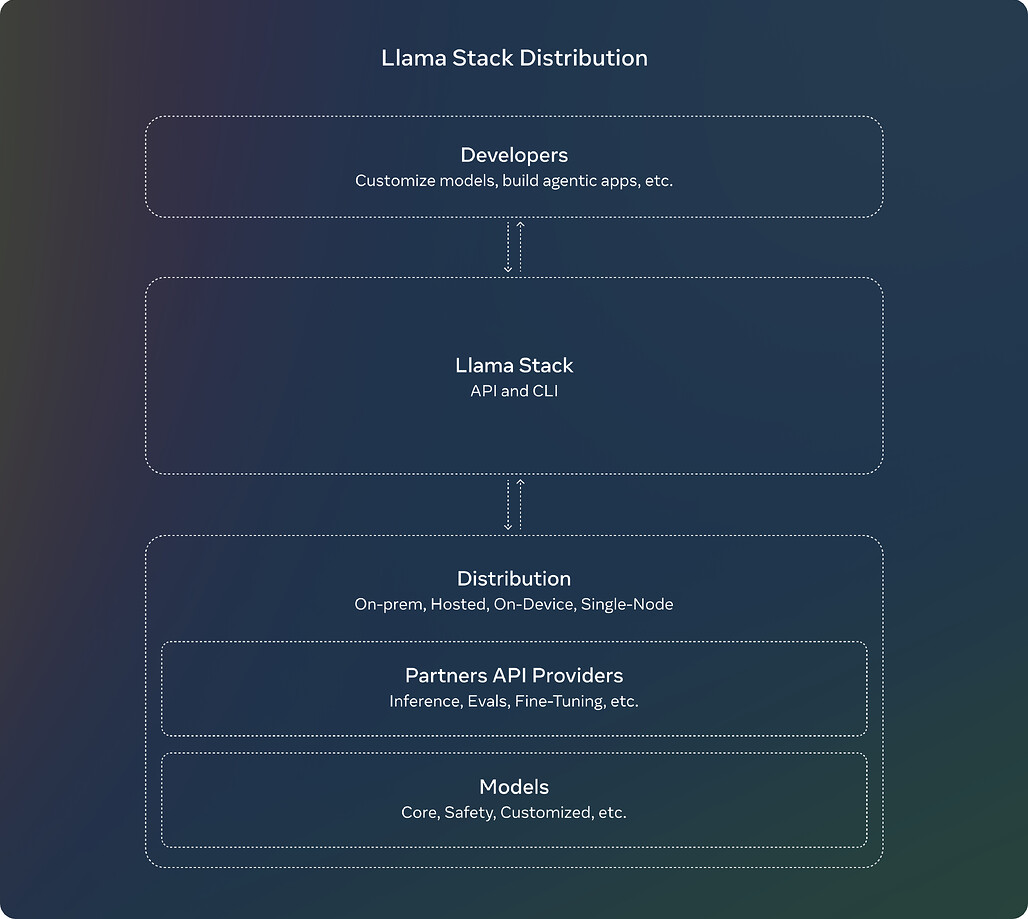

개발자가 단일 노드, 온프레미스, 클라우드, 온디바이스 등 다양한 환경에서 라마 모델로 작업하는 방식을 크게 간소화하여 검색 증강 생성(RAG) 및 툴링 지원 애플리케이션의 턴키 배포를 통합 안전성과 함께 가능하게 하는 최초의 공식 Llama Stack 배포를 공유할 예정입니다.

-

AWS 및 Databricks, Dell Technologies, Fireworks, Infosys, Together AI 등의 파트너와 긴밀히 협력하여 다운스트림 엔터프라이즈 고객을 위한 라마 스택 배포를 구축해 왔습니다. 온디바이스 배포는 PyTorch ExecuTorch를 통해 이루어지며, 단일 노드 배포는 Ollama를 통해 이루어집니다.

-

우리는 개방성이 혁신을 주도하고 개발자, 메타, 세상에 도움이 된다고 믿기 때문에 계속해서 우리의 작업을 공유하고 있습니다. 라마는 이미 개방성, 수정 가능성, 비용 효율성을 선도하며 더 많은 사람들이 제너레이티브 AI를 사용해 창의적이고 유용하며 삶을 변화시키는 혁신을 이룰 수 있도록 돕고 있습니다.

-

Llama 3.2 모델들은 llama.com과 Hugging Face에서 다운로드할 수 있으며, AMD, AWS, 데이터브릭스, 델, 구글 클라우드, 그루크, IBM, 인텔, 마이크로소프트 애저, 엔비디아, 오라클 클라우드, 스노우플레이크 등을 포함한 광범위한 파트너 플랫폼 생태계에서 즉시 개발할 수 있습니다.

Llama 3.2에서 추가된 Vision Model (11B/90B)

Llama 3.2의 비전 모델(11B 및 90B)은 문서 수준의 이해, 이미지 캡션 작성, 시각적 추론과 같은 작업에 탁월한 성능을 제공합니다. 이러한 모델들은 비즈니스 그래프에서 가장 좋은 매출 월을 찾거나, 지도에서 특정 트레일의 경사도를 예측하는 등의 작업을 처리할 수 있습니다.

Llama 제품군에서 처음으로 비전 작업을 지원하는 Llama 3.2의 11B 및 90B 모델은 이미지와 텍스트를 결합하여 의미를 이해하고, 캡션을 생성하거나 시각적 데이터를 기반으로 추론을 할 수 있습니다.

이 비전 모델들은 기존의 텍스트 전용 모델을 대체하는 드롭인 교체(Drop-in) 기능을 제공하며, 비전과 언어를 동시에 이해하는 새로운 차원의 성능을 제공합니다.

Llama 3.2에서 추가된 걍량(Small) 모델 (1B/3B)

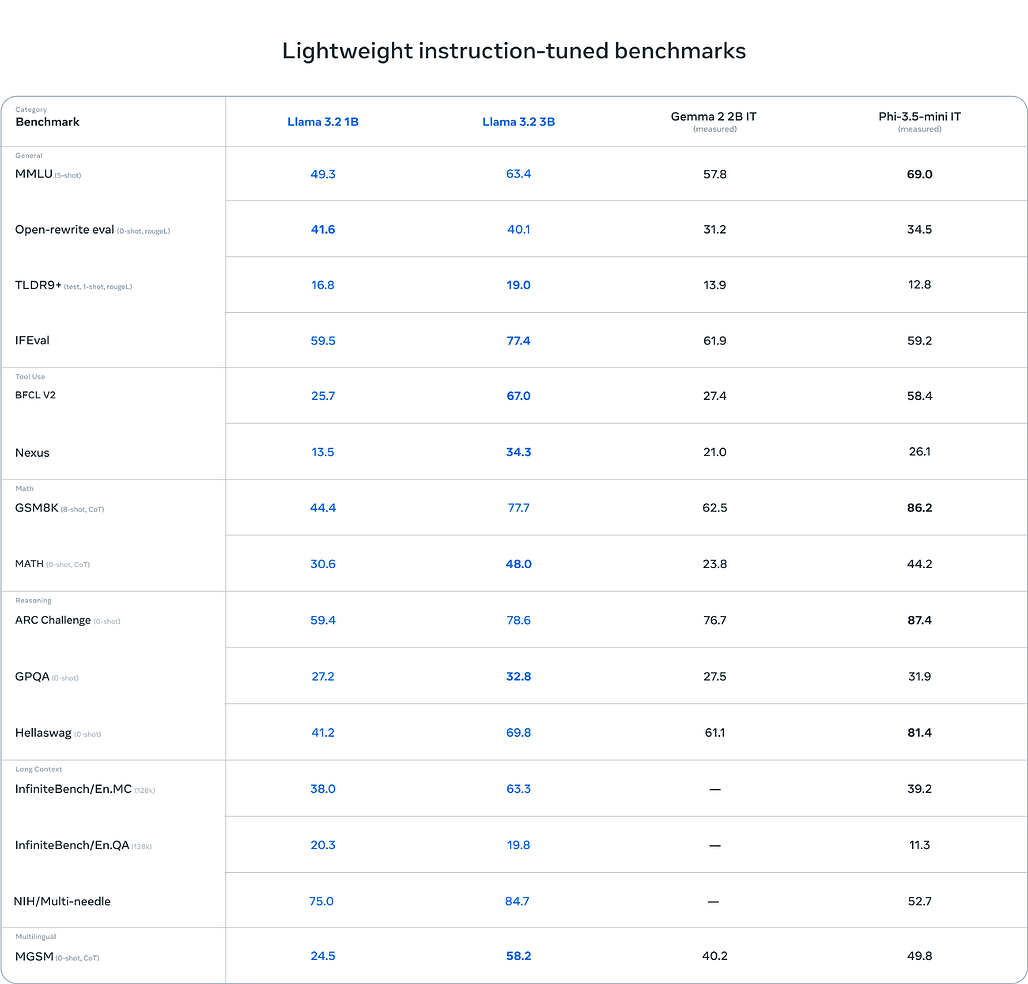

작은 크기의 1B 및 3B 모델은 강력한 텍스트 생성 및 도구 호출 기능을 제공하여, 요약, 재작성, 도구 사용과 같은 작업을 온디바이스에서 처리할 수 있습니다. 데이터가 클라우드로 전송되지 않고 장치 내에서 처리되어 프라이버시를 보장할 수 있습니다.

Llama 3.2는 1B 및 3B 경량 모델도 포함하고 있어 모바일 장치에서 효율적으로 실행할 수 있습니다. 이러한 모델들은 다국어 텍스트 생성, 명령 수행, 도구 호출 등에서 뛰어난 성능을 발휘하며, 데이터를 장치 내에서 처리해 빠른 응답과 개인 정보 보호를 보장합니다.

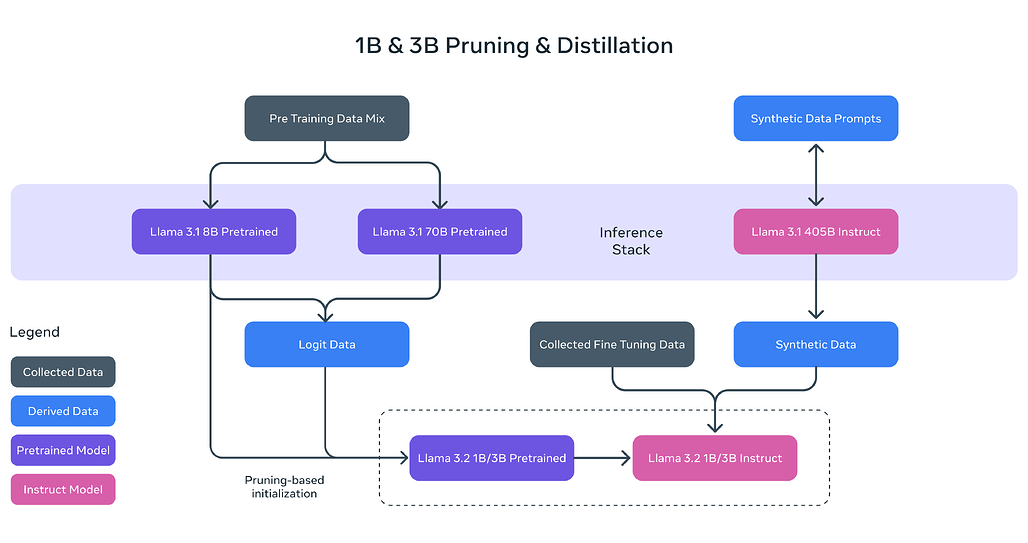

이 경량 모델들은 **지식 증류(Knowledge Distillation)**와 가지치기(Pruning) 기술을 활용하여 더 큰 모델들의 성능을 유지하면서도 크기를 줄여 모바일 플랫폼에서도 실행할 수 있게 최적화되었습니다.

다음은 이러한 경량 모델의 몇 가지 사용 데모, 공개되지 않은 양자화 모델(Quantized Model)을 사용하였습니다:

경량 모델의 사용 예시: 요약 데모

경량 모델의 사용 예시: 재작성 데모

경량 모델의 사용 예시: 글 작성 어시스턴트 데모

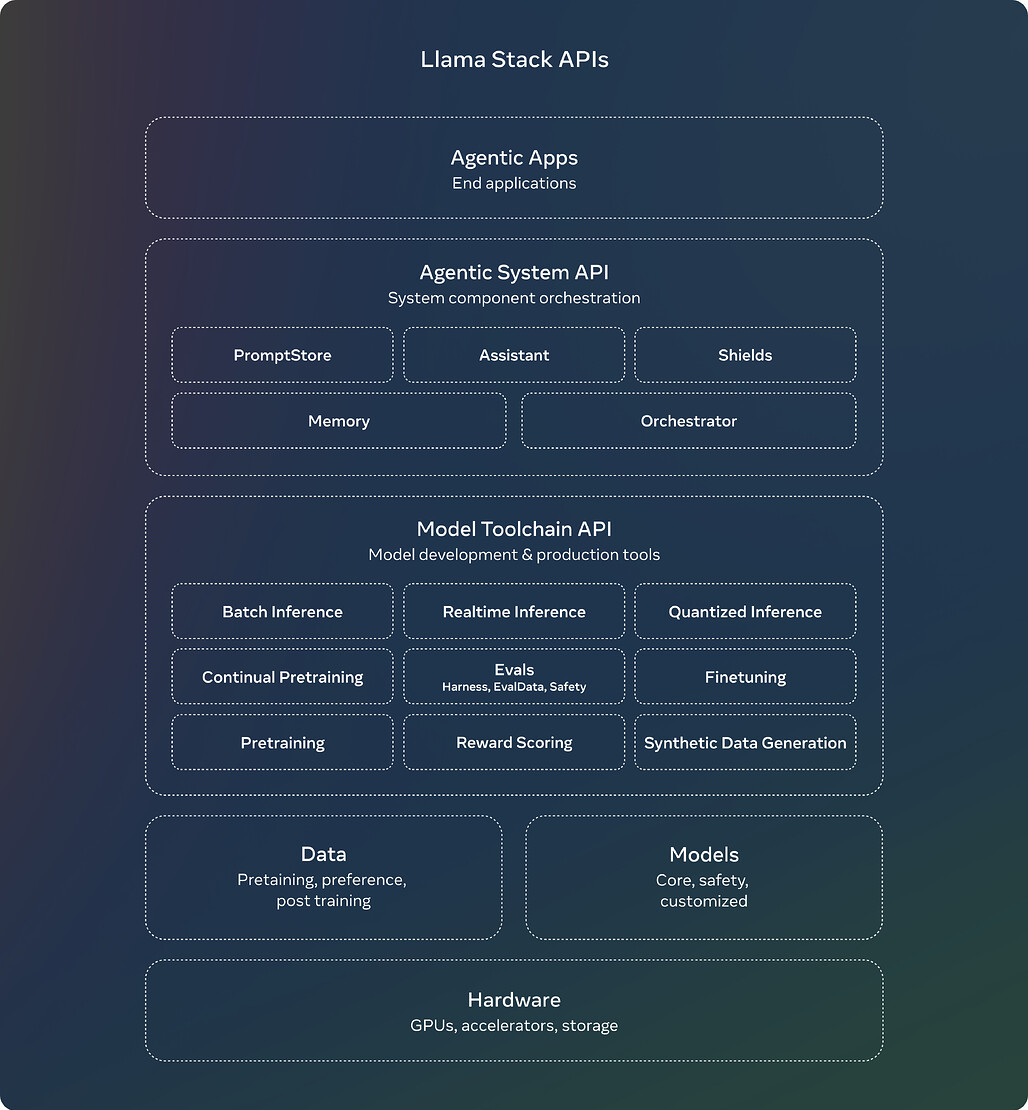

Llama Stack 배포

Llama Stack은 다양한 환경에서 Llama 모델을 배포하고 미세 조정할 수 있는 표준 API를 제공하여 AI 애플리케이션 개발을 간소화합니다. 이 플랫폼은 RAG(검색 증강 생성) 및 다양한 도구를 지원하며, 다음과 같은 기능을 포함합니다:

- CLI 도구를 통해 모델을 빌드하고 실행.

- Docker 컨테이너를 사용한 간편한 배포.

- iOS에서 PyTorch ExecuTorch를 통한 온디바이스 통합.

Llama Stack은 AWS, Databricks, Dell 등과 같은 파트너와 호환되며, 개발자가 손쉽게 사용할 수 있도록 설계되었습니다.

시스템 수준의 안전성

Meta는 책임 있는 혁신을 지속적으로 지원하고 있으며, Llama Guard 3를 도입하여 텍스트 및 이미지 입력/출력을 필터링하고, 경량 모델을 위한 가지치기 및 양자화 버전을 제공하여 배포 비용을 줄였습니다.

이러한 안전성 솔루션은 참조 구현 및 데모에 통합되어 있으며, 오픈 소스 커뮤니티에서 즉시 사용할 수 있습니다.

Llama 3.2 체험하기

Llama 3.2 모델은 llama.com과 Hugging Face에서 즉시 다운로드 및 사용할 수 있으며, Meta의 파트너 플랫폼을 통해 바로 개발할 수 있습니다. Meta는 개발자가 안전하고 강력한 AI 애플리케이션을 구축할 수 있도록 도구와 리소스를 제공하며, 책임 있는 릴리스 노력을 지속하고 있습니다.

Llama 홈페이지

Llama 홈페이지

Llama 3.2 모델 공개 블로그

Llama 3.2 모델 공개 블로그

Llama 3.2 모델 카드 및 프롬프트 형식

Llama 3.2 모델 카드 및 프롬프트 형식

Llama Stack GitHub 저장소

Llama Stack GitHub 저장소

https://github.com/meta-llama/llama-stack

Llama 모델 다운로드 (공식 홈페이지)

Llama 모델 다운로드 (공식 홈페이지)

Llama 모델 다운로드 (Hugging Face)

Llama 모델 다운로드 (Hugging Face)

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()

: