MiniMax M2 소개

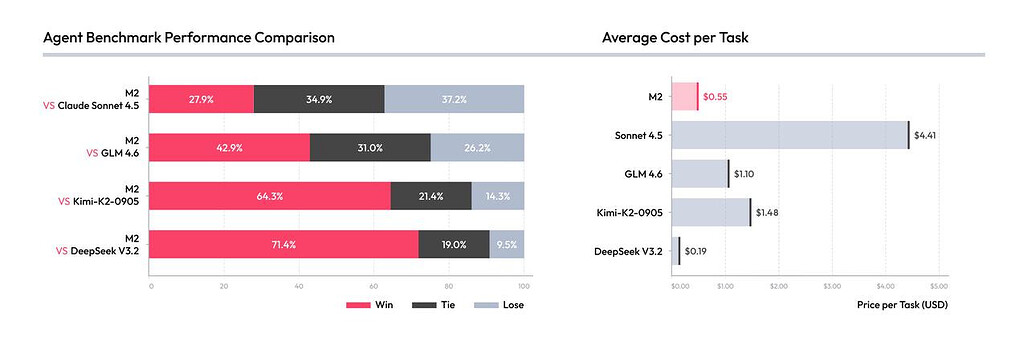

MiniMax는 설립 초기부터 “모두를 위한 인공지능(Intelligence with Everyone)”이라는 비전을 바탕으로 발전해온 중국 기반 AI 스타트업입니다. 최근 MiniMax는 이 비전을 구체화한 새로운 모델 MiniMax M2를 공개하며 큰 주목을 받고 있습니다. M2는 “에이전트(Agent)”와 “코딩”을 위해 설계된 오픈소스 모델로, 성능과 비용, 속도 사이의 균형을 혁신적으로 재정의했습니다. MiniMax는 이를 통해 클로드(Claude) Sonnet 대비 가격은 8%, 속도는 2배 이상 빠른 모델을 무료로 공개했다고 발표했습니다.

MiniMax-M2는 코드 생성과 복잡한 자동화 에이전트 작업을 동시에 수행할 수 있도록 설계되었습니다. 예를 들어 Shell 명령 실행, 브라우저 제어, Python 코드 해석기 호출, MCP 기반 도구 제어 등 다양한 작업을 안정적으로 수행합니다. 이러한 복합적인 도구 호출 능력은 단순한 챗봇을 넘어, “스스로 복잡한 업무를 완수하는 AI 에이전트”로의 진화를 상징합니다.

MiniMax는 이 모델을 내부 개발팀의 실제 업무에 직접 활용하면서 모델의 한계를 다듬었다고 밝혔습니다. 개발자, 백엔드 엔지니어, 비즈니스 담당자들이 함께 모델을 테스트하고 실제 업무에 통합하는 과정을 통해, M2는 현실적인 문제 해결력과 실행 안정성을 확보했습니다. 이러한 과정은 단순히 대규모 언어모델(LLM)을 만드는 것이 아니라, AGI(범용 인공지능) 시대에 협력하는 ‘AI 네이티브 조직’을 구축하는 첫걸음으로 평가됩니다.

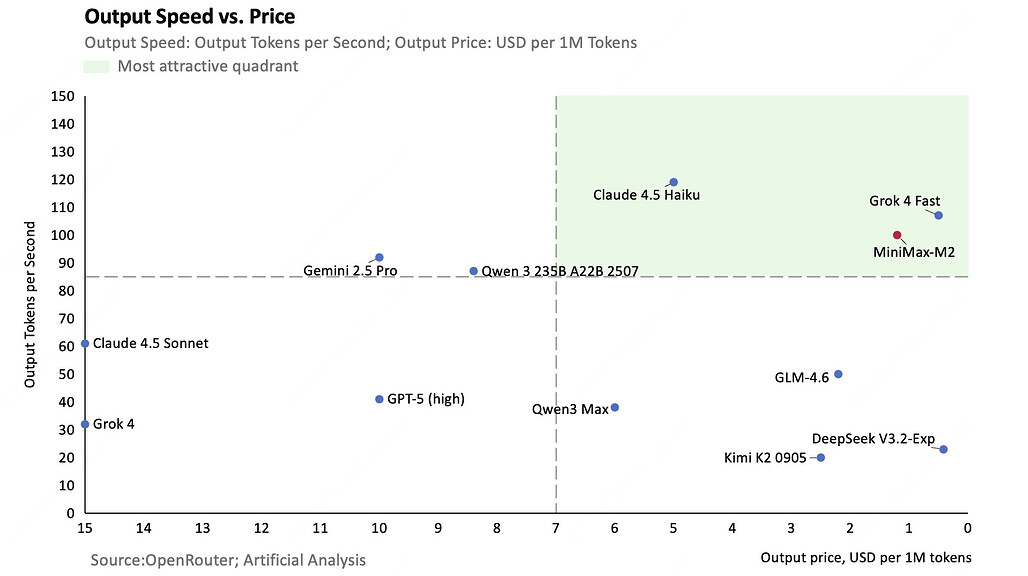

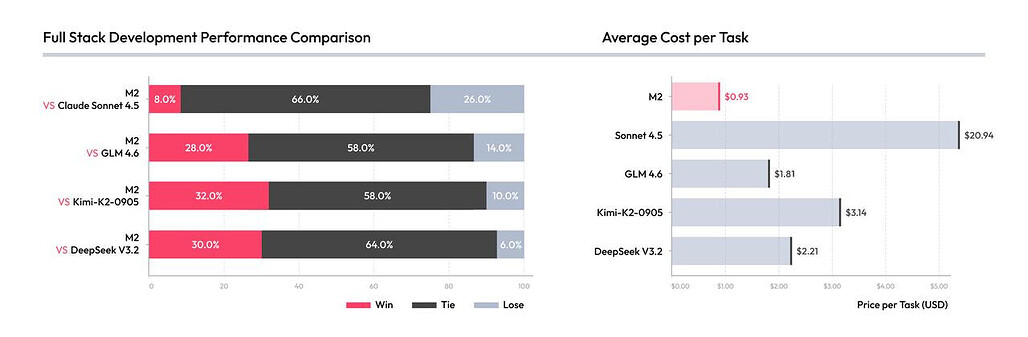

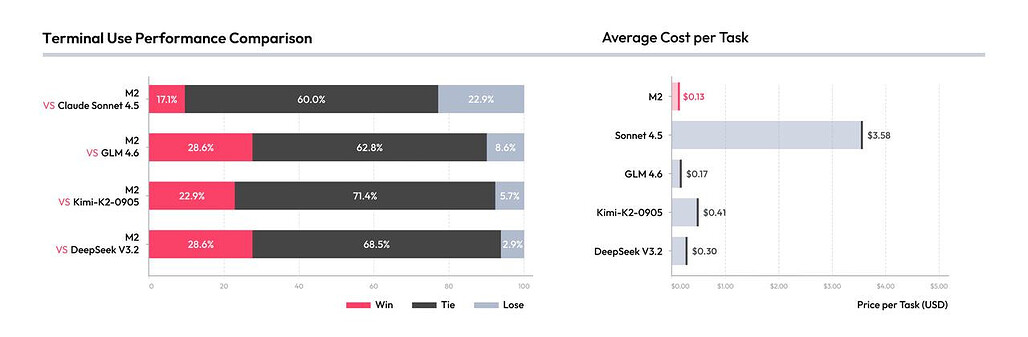

MiniMax가 강조하는 부분은 ‘성능–속도–비용’이라는 불가능해 보이는 삼각 구도의 균형입니다. 해외 상위 모델들은 뛰어난 성능을 보이지만, 높은 가격과 느린 응답 속도가 단점으로 지적됩니다. 반면 국내 모델들은 비용 면에서 유리하나, 전반적인 추론 속도와 정확도에서 한계가 있었습니다.

MiniMax M2는 이 두 극단 사이에서 적정 성능을 가진 가장 빠르고 저렴한 모델을 목표로 만들어졌습니다. 내부 벤치마크에 따르면 M2는 도구 활용 능력과 검색 능력(deep search)에서 해외 주요 모델들과 유사한 수준을 보였고, 프로그래밍 성능에서도 국내 최상위권을 기록했습니다.

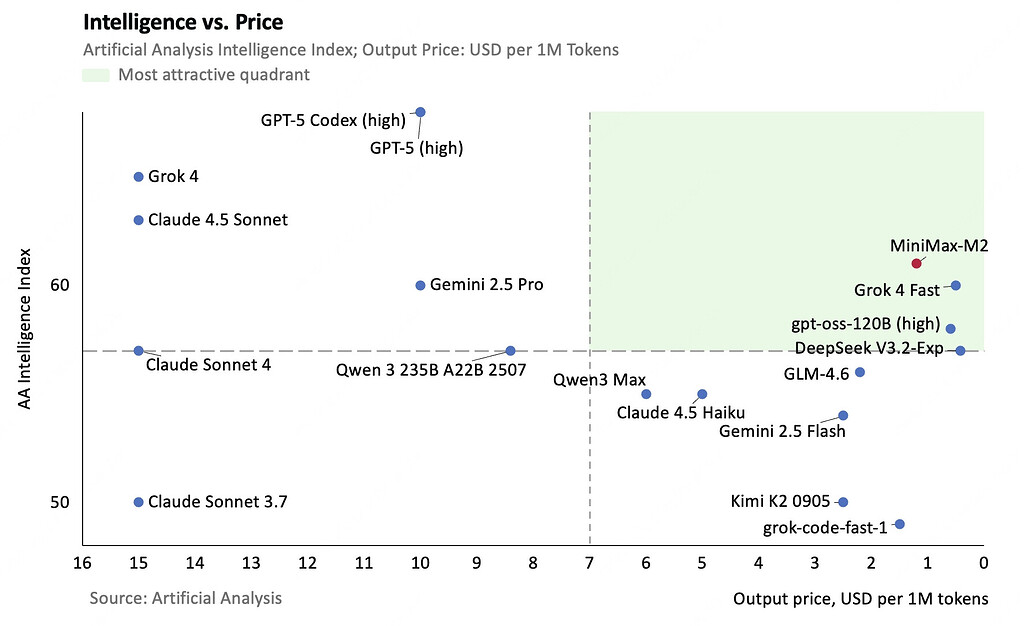

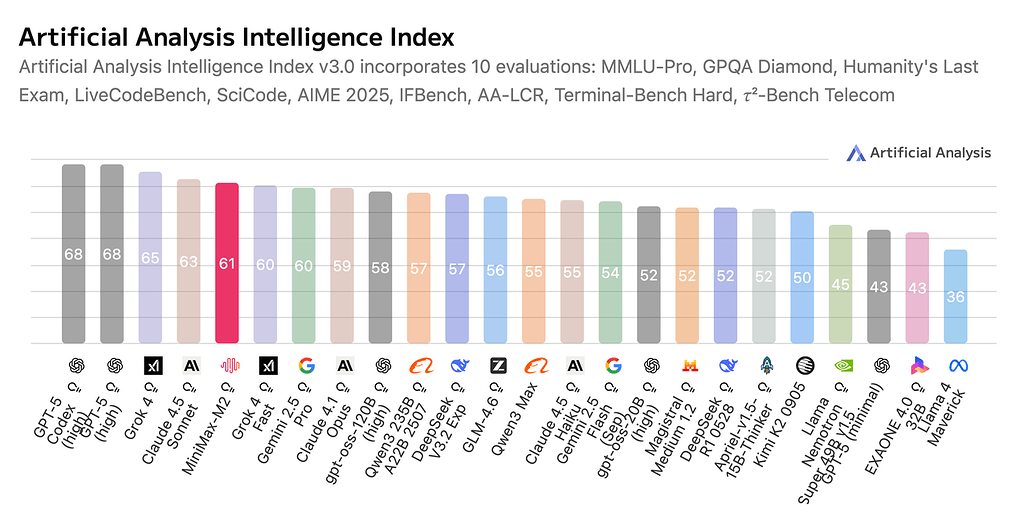

또한, MMLU-Pro, GPQA Diamond, Humanity's Last Exam, LiveCodeBench 등의 10가지 벤치마크를 합친 인공지능 종합 벤치마크 Artificial Analysis에서 전 세계 모델 중 상위 5위에 올랐다고 발표했습니다. 특히 “성능 대비 가격 효율성” 측면에서 보면, M2는 현재 상용 모델 중 가장 합리적인 선택지로 평가됩니다.

MiniMax M2의 주요 특징

MiniMax-M2의 기술적 핵심은 “활성화 파라미터(activated parameters)” 설계에 있습니다. 10B 규모의 활성 파라미터만으로도 대형 모델 수준의 성능을 유지하며, 그 결과 다음과 같은 장점이 있습니다:

-

코딩 및 개발 지원 능력: MiniMax M2는 Claude Code, Cursor, Cline, Kilo Code, Droid 등 다양한 개발 도구 환경에서 원활히 작동합니다. 단순한 코드 작성뿐 아니라, 전체 개발 워크플로우를 자동화하는 수준의 엔드 투 엔드 개발 보조 능력을 갖추고 있습니다.

이를 통해 개발자는 반복적인 코딩 작업을 자동화하고, 코드 리뷰, 디버깅, 테스트 등 다양한 과정에서 AI의 도움을 받을 수 있습니다. -

강력한 도구 연동(Agentic) 성능: MiniMax-M2는 복수의 도구 호출을 논리적으로 조율하는 능력이 뛰어납니다. 단순히 한 번의 명령을 수행하는 것이 아니라, Shell 명령어 실행 → 코드 생성 → 결과 분석 → 브라우저 호출 등의 복합적 체인 실행(Long-chain Tool Calling) 을 안정적으로 수행할 수 있습니다.

이는 기존의 LLM 기반 챗봇이 질의응답(Q&A)에 머물렀던 한계를 넘어, 실제 업무를 대체할 수 있는 지능형 에이전트 시스템의 핵심 구성 요소로 자리매김합니다. -

성능·비용·속도의 완벽한 균형: MiniMax는 M2의 API 단가를 입력 토큰 100만 개당 $0.30(약 2.1 RMB), 출력 토큰 100만 개당 $1.20(약 8.4 RMB) 로 설정했습니다. 이는 Claude 3.5 Sonnet 대비 약 8%의 가격 수준이며, 초당 토큰 처리 속도(TPS)는 약 100으로 두 배 이상 빠릅니다.

이러한 설계 덕분에 개발자는 기존 대비 훨씬 적은 비용으로 대규모 모델의 성능을 활용할 수 있게 되었습니다.

즉, “10B 활성화 = 빠른 응답 + 경제적 배포”라는 공식이 MiniMax-M2의 설계 철학이라 할 수 있습니다.

MiniMax Agent: M2 기반의 새로운 AI 비서

MiniMax는 M2 모델을 기반으로 MiniMax Agent라는 범용 AI 비서를 함께 출시했습니다. 이 서비스는 중국 및 해외 사용자 모두에게 제공되며, 다음 두 가지 모드를 지원합니다.

-

Lightning Mode: 실시간 질의응답, 간단한 검색, 코드 작성 등 즉시 응답이 필요한 작업에 적합한 초고속 모드

-

Pro Mode: 리서치, 웹 개발, PPT 작성, 리포트 생성 등 장기적이고 복합적인 작업을 수행하는 전문 모드

이러한 두가지 모드는 M2의 높은 추론 속도를 기반으로, 빠르면서도 비용 효율적인 대화형 AI 경험을 제공합니다. 현재 MiniMax는 서버 수용 한계에 도달하기 전까지 MiniMax Agent 서비스를 무료로 개방하고 있습니다.

MiniMax-M2 모델의 성능 벤치마크

MiniMax-M2는 코딩과 에이전트(Agentic) 작업을 위해 설계된 오픈소스 Mixture-of-Experts(MoE) 모델로, Claude 4.5·GPT-5·Gemini 2.5 Pro 등 주요 상용 모델과의 비교 평가에서 탁월한 효율성과 균형 잡힌 성능을 보여주었습니다.

아래에서는 MiniMax가 공개한 Coding & Agentic Benchmarks 및 Intelligence Benchmarks 결과입니다.

MiniMax-M2의 Coding & Agentic Benchmarks 성능 벤치마크 결과

MiniMax-M2의 코딩·에이전트 성능 벤치마크는 실제 개발 환경(IDE, 터미널, 브라우저 등)에서의 자동화 능력을 평가하는 테스트로 구성되어 있습니다. 이 평가군은 코드 편집, 명령 실행, 웹 탐색, 검색, 보고서 작성 등 개발자 생산성 자동화에 직결되는 실질적 능력을 검증합니다:

| 벤치마크 항목 | MiniMax-M2 | Claude 4.5 | GPT-5 (Thinking) | Gemini 2.5 Pro | 비교 요약 |

|---|---|---|---|---|---|

| SWE-bench Verified | 69.4 | 77.2 | 74.9 | 63.8 | GPT-5 및 Claude에 근접한 수준, 오픈소스 중 최고 |

| Multi-SWE-Bench | 36.2 | 44.3 | – | – | 상용 대비 낮지만, 오픈소스 내 준수 |

| SWE-bench Multilingual | 56.5 | 68 | – | – | 다국어 코딩에서도 강점 |

| Terminal-Bench | 46.3 | 50 | 43.8 | 25.3 | 실제 터미널 작업 성능 우수 (Claude 4.5에 근접) |

| ArtifactsBench | 66.8 | 61.5 | 73 | 57.7 | GPT-5 다음으로 높은 코드 아티팩트 생성 정확도 |

| BrowseComp | 44 | 19.6 | 54.9 | 9.9 | 웹 검색·정보 추출 능력에서 상용 모델 수준 |

| BrowseComp-zh | 48.5 | 40.8 | 65 | 32.2 | 중국어 웹 탐색 성능 우수 (국내 모델 중 최상위) |

| GAIA (text only) | 75.7 | 71.2 | 76.4 | 60.2 | GPT-5와 근접한 텍스트 기반 과학·지식 탐색 성능 |

| xbench-DeepSearch | 72 | 66 | 77.8 | 56 | GPT-5 다음으로 높은 딥서치 성능 |

| HLE (with tools) | 31.8 | 24.5 | 35.2 | 28.4 | 도구 연동형 에이전트 작업에서 상위권 |

| τ²-Bench | 77.2 | 84.7 | 80.1 | 59.2 | 사고(Thinking) 기반 복합 추론에서 GPT-5급 |

| FinSearchComp-global | 65.5 | 60.8 | 63.9 | 42.6 | 금융 데이터 검색·해석 분야에서 Claude 및 GPT-5급 |

| AgentCompany | 36 | 41 | – | 39.3 | 조직형 협업 시나리오에서 준수한 팀워크형 추론력 |

MiniMax-M2는 상용 모델에 근접한 성능을 오픈소스 가격(무료)으로 제공 한다는 점에서 큰 의미가 있습니다. Claude 4.5나 GPT-5에는 약간 뒤처지지만, 전반적 코드 작성 / 브라우징 / 도구 체인 제어 능력은 오픈소스 중 최상위 입니다. 특히, BrowseComp-zh, GAIA, FinSearchComp와 같은 복합 검색형 과제에서는 Claude보다 높은 점수를 기록했습니다. MiniMax-M2는 이렇게 코드·웹 탐색·추론이 결합된 Agentic 환경 최적화 모델로서의 완성도가 매우 높습니다.

MiniMax-M2의 Intelligence Benchmarks 성능 벤치마크 결과

이 평가는 Artificial Analysis(AA) 프레임워크에 따라 수학, 과학, 코딩, 추론 등 지능적 문제 해결 능력을 측정합니다. MiniMax-M2는 종합 지능 점수(AA Intelligence)에서 오픈소스 모델 중 최고 수준(61점)을 기록했습니다.

| 지표(Metric) | MiniMax-M2 | Claude 4.5 | GPT-5 (Thinking) | Gemini 2.5 Pro | 분석 요약 |

|---|---|---|---|---|---|

| AIME25 (수학 추론) | 78 | 88 | 94 | 88 | 수학 문제 해결력, GPT-5 다음 수준 |

| MMLU-Pro (범용 지식) | 82 | 88 | 87 | 86 | 전문 지식 이해력, Claude와 유사 |

| GPQA-Diamond (과학 지식) | 78 | 83 | 85 | 84 | 과학적 사고력 안정적 |

| HLE (w/o tools) | 12.5 | 17.3 | 26.5 | 21.1 | 비도구형 추론은 다소 제한적 |

| LiveCodeBench | 83 | 71 | 85 | 80 | 실시간 코딩 문제 해결 능력 매우 우수 |

| SciCode | 36 | 45 | 43 | 43 | 과학 코드 관련 문제에서는 보통 수준 |

| IFBench | 72 | 57 | 73 | 49 | 지시 따르기(instruction following) 매우 강력 |

| AA-LCR | 61 | 66 | 76 | 66 | 논리 추론력 평균 이상 |

| τ²-Bench-Telecom | 87 | 78 | 85 | 54 | 복잡한 멀티스텝 추론에서 Claude 및 GPT-5급 |

| Terminal-Bench-Hard | 24 | 33 | 31 | 25 | 고난도 환경 명령 수행에서는 중간 수준 |

| AA Intelligence (종합) | 61 | 63 | 69 | 60 | 오픈소스 모델 중 1위 수준 |

MiniMax-M2는 단일 영역에 특화되지 않고, 지식 이해 + 코드 생성 + 논리 추론에서 균형 잡힌 성능을 기록하며 폭넓은 문제 해결 능력을 보여줍니다. 특히, 수학 및 코딩, 명령형 추론에서 강점을 보이며, 과학 분야나 고난도 논리 문제에서는 상용 모델 대비 약간의 차이를 보입니다. 즉, MiniMax-M2 모델은 지능형 에이전트 구축용 기반 모델로 이상적이며, Claude 계열 대비 속도와 효율성에서 확실한 우위에 있습니다.

이상과 같이 MiniMax-M2는 “Claude급 성능을 가진 오픈소스 모델”이라는 평가에 걸맞은 결과를 보여주었습니다. 특히, 코드 작성, 명령 실행, 웹 탐색, 툴 연동 등 실제 개발 환경에서의 자동화 수행 능력 이 두드러지며, 상용 모델과의 격차를 현저히 줄인 첫 공개형 모델 로 평가됩니다.

MiniMax-M2 로컬 배포(Local Deployment) 가이드

MiniMax는 M2 모델을 Hugging Face를 통해 완전 공개(Open Source) 했습니다. 사용자는 모델 가중치를 다운로드해 로컬 및 클라우드 환경에 직접 배포할 수 있으며, vLLM 및 SGLang을 공식적으로 지원합니다. 다음은 MiniMax에서 권장하는 두 가지 주요 배포 방법입니다:

MiniMax-M2 모델 다운로드

먼저 Hugging Face에서 모델 가중치를 다운로드합니다.

git lfs install

git clone https://huggingface.co/MiniMaxAI/MiniMax-M2

cd MiniMax-M2

모델 다운로드 후, vLLM 및 SGLang의 두 가지 프레임워크 중 하나를 선택해 배포할 수 있습니다.

vLLM으로 MiniMax-M2 모델 배포하기

vLLM은 고속 LLM 추론을 위한 범용 엔진으로, MiniMax-M2를 “Day-0 지원”합니다. vLLM은 대규모 배포 환경(서버 클러스터)에서도 매우 효율적이며, 샘플링 속도(TPS)가 높습니다.

vLLM은 다음과 같이 설치할 수 있습니다. 이미 설치되어 있다면, 업데이트를 통해 최신 버전의 vLLM을 설치해주세요:

pip install vllm

설치 후에는 다음과 같은 CLI 명령어로 곧바로 모델 서빙 서버를 실행할 수 있습니다:

python -m vllm.entrypoints.openai.api_server \

--model MiniMaxAI/MiniMax-M2 \

--tensor-parallel-size 1 \

--dtype bfloat16

vLLM은 OpenAI 호환 서버를 기본 제공하여, 아래와 같이 별도 Client에서 API 형식으로 호출할 수 있습니다:

import openai

openai.api_key = "EMPTY"

openai.api_base = "http://localhost:8000/v1"

response = openai.ChatCompletion.create(

model="MiniMaxAI/MiniMax-M2",

messages=[{"role": "user", "content": "Explain what MoE means in LLMs"}],

)

print(response.choices[0].message["content"])

더 상세한 내용은 아래 vLLM 문서 및 MiniMax 배포를 위한 문서를 참고해주세요:

vLLM 공식 가이드

MiniMax-M2 배포 가이드 (vLLM)

SGLang으로 MiniMax-M2 모델 배포하기

SGLang은 Multi-Agent 및 LLM 추론에 특화된 프레임워크로, MiniMax-M2를 공식적으로 지원합니다. SGLang을 이용한 배포는 간단하며, 다음과 같은 단계를 거칩니다.

먼저 다음과 같이 SGLang을 설치합니다. 이미 설치되어 있다면, 업데이트를 통해 최신 버전의 SGLang을 설치해주세요:

pip install sglang

이후, 다음과 같이 실행할 수 있습니다:

from sglang import LanguageModel

model = LanguageModel("MiniMaxAI/MiniMax-M2")

response = model.chat("파이썬에서 퀵정렬을 구현해줘.")

print(response)

더 상세한 내용은 아래 SGLang를 사용한 MiniMax 배포를 위한 문서를 참고해주세요:

MiniMax-M2 배포 가이드 (SGLang)

권장 추론 설정(Recommended Parameters)

최적의 성능을 위해 MiniMax-M2 모델 사용 시 아래와 같은 설정을 권장합니다:

temperature = 1.0

top_p = 0.95

top_k = 40

MiniMax-M2는 ‘interleaved thinking’ 모델입니다. 즉, 모델의 내부 사고 과정을 아래 예시와 같이 <think>...</think> 태그로 감싸 출력합니다:

<think>이 문제를 해결하기 위해 먼저 정렬 알고리즘의 개념을 떠올린다...</think>

코드는 다음과 같습니다:

따라서 이러한 <think>...</think> 내용을 대화 이력에 그대로 유지해야 모델의 연속적 사고(Chain-of-Thought)가 유지되며, 제거할 경우 성능이 크게 저하되므로 주의해야 합니다.

도구 호출 (Tool Calling)

MiniMax-M2는 Shell, 브라우저, Python 인터프리터 등 외부 도구를 호출할 수 있는 구조를 갖추고 있습니다. 도구 호출 관련한 설정은 다음 문서를 참고해주세요:

MiniMax 공식 홈페이지

MiniMax 공식 홈페이지

MiniMax-M2 모델 공개 블로그

MiniMax-M2 모델 공개 블로그

MiniMax-M2 GitHub 저장소

MiniMax-M2 GitHub 저장소

https://github.com/MiniMax-AI/MiniMax-M2

MiniMax-M2 모델 다운로드

MiniMax-M2 모델 다운로드

MiniMax-M2 사용해보기 (API & Agent)

MiniMax-M2 사용해보기 (API & Agent)

아래 MiniMax-M2 Agent 및 API는 일정 시간 동안 무료로 제공(Free for a limited time)됩니다:

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()