- 아래 답변은 OpenAI의 GPT-4-Turbo 모델로 자동 생성한 것으로, 정확하지 않을 수 있습니다.

- 잘못된 답변을 보셨다면 댓글로 첨삭 지도 부탁드립니다.

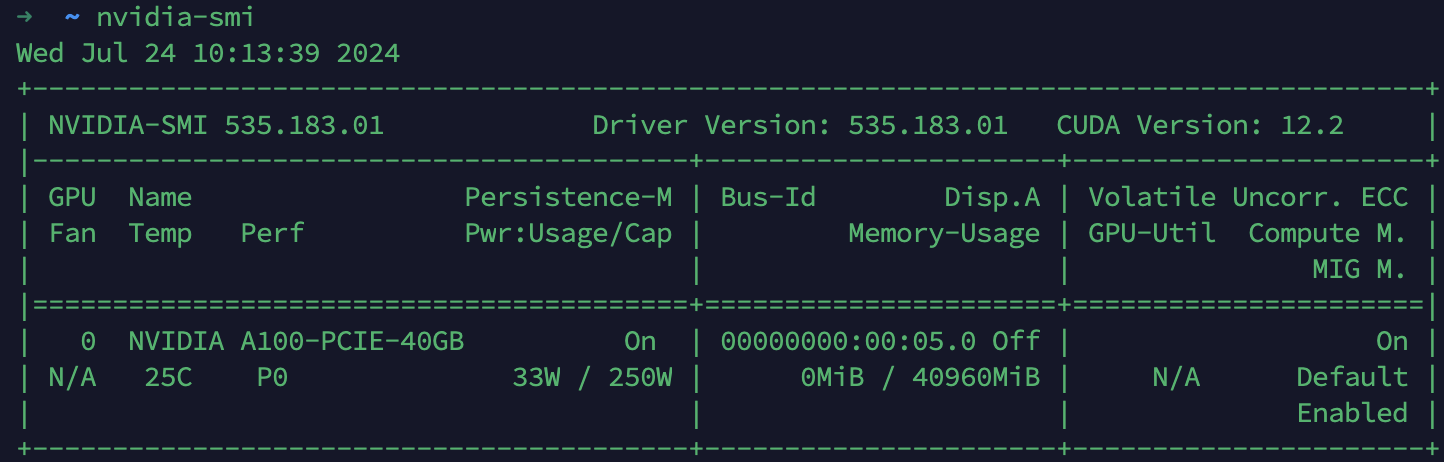

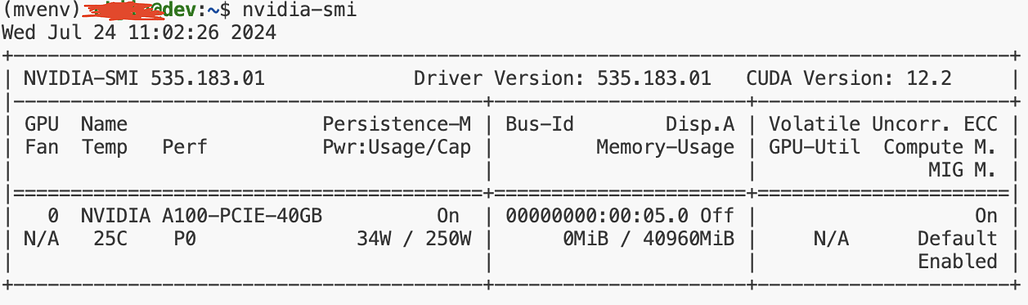

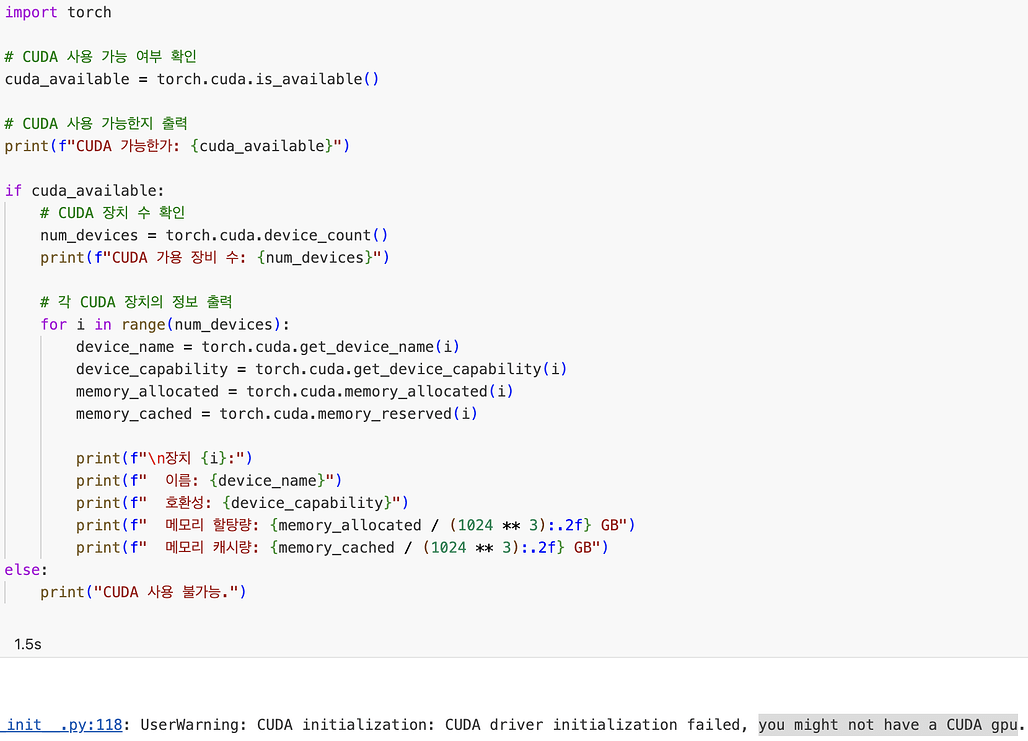

안녕하세요! Docker 컨테이너 내에서 CUDA가 동작하지 않는 문제로 고민이 많으시겠네요. 문제 상황을 정리해보자면, Ubuntu 22.04와 Docker 27.0.3 환경에서 nvidia/cuda:12.2.2-cudnn8-devel-ubuntu22.04 이미지를 사용하여 컨테이너를 구성하셨고, 호스트에서는 nvidia-smi가 정상적으로 동작하지만, 컨테이너 내에서 PyTorch를 통한 CUDA 검증 시 CUDA GPU를 인식하지 못하는 문제가 발생했다는 것으로 이해했습니다.

이 문제를 해결하기 위해 몇 가지 점검해볼 사항과 해결 방안을 제안드리겠습니다.

1. Docker 실행 명령어 확인

Docker 컨테이너를 실행할 때 --gpus all 플래그를 사용하여 NVIDIA GPU를 컨테이너에 할당했는지 확인해야 합니다. 이 플래그 없이 컨테이너를 실행하면, 컨테이너 내부에서 GPU를 사용할 수 없습니다. 예를 들어, 다음과 같은 명령어를 사용해야 합니다.

docker run --gpus all -it --rm nvidia/cuda:12.2.2-cudnn8-devel-ubuntu22.04

2. PyTorch 및 CUDA 호환성 확인

PyTorch와 CUDA 버전 간의 호환성도 중요합니다. PyTorch 설치 시 CUDA 버전을 명시적으로 지정하여 호환되는 버전을 설치하는 것이 좋습니다. 예를 들어, CUDA 12.2에 맞는 PyTorch를 설치하려면 다음과 같이 설치할 수 있습니다.

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu122

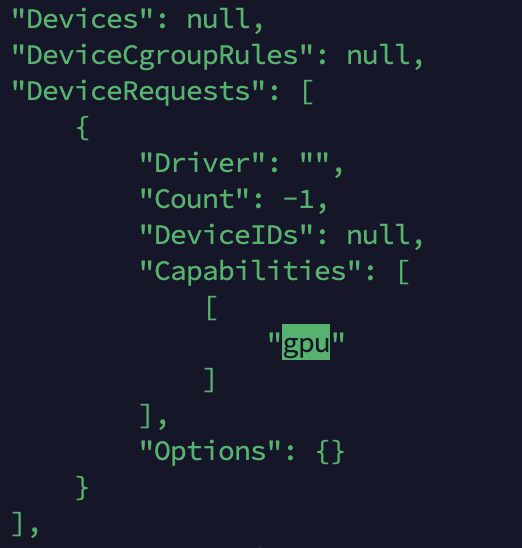

3. NVIDIA Container Toolkit 설치 및 설정 확인

nvidia-container-toolkit이 정상적으로 설치되어 있고, Docker 데몬 설정에서 default-runtime이 nvidia로 설정되어 있는지 확인해야 합니다. /etc/docker/daemon.json 파일을 확인하고, 다음과 같이 설정되어 있는지 확인해보세요.

{

"default-runtime": "nvidia",

"runtimes": {

"nvidia": {

"path": "nvidia-container-runtime",

"runtimeArgs": []

}

}

}

설정 후에는 Docker 데몬을 재시작해야 합니다.

sudo systemctl restart docker

4. CUDA 버전과 드라이버 호환성

호스트 시스템의 NVIDIA 드라이버 버전이 CUDA 버전과 호환되는지 확인해야 합니다. 일반적으로 최신 드라이버는 다양한 CUDA 버전을 지원하지만, 특정 CUDA 버전에 대한 최소 드라이버 버전 요구 사항이 있습니다. NVIDIA 공식 문서에서 해당 정보를 확인할 수 있습니다.

이러한 점검 사항을 모두 확인해보시고 문제가 계속된다면, 추가적으로 Docker 컨테이너 로그나 시스템 로그에서 더 구체적인 오류 메시지를 찾아볼 수 있습니다. 이를 통해 문제의 원인을 좀 더 정확히 파악할 수 있을 것입니다.

PyTorch와 CUDA, Docker 관련 공식 문서는 다음 링크에서 더 많은 정보를 얻을 수 있습니다:

제 답변이 정확하지 않을 수도 있으니, 상황에 따라 공식 문서를 참조하거나 추가적인 정보를 제공해주시면 더 도움을 드릴 수 있을 것 같습니다. 문제 해결을 위한 여정에서 조금이나마 도움이 되었기를 바랍니다.

- 답변이 어떠셨나요? 괜찮았다고 생각하신다면 아래

를 한 번 눌러주시길 부탁드려요!

를 한 번 눌러주시길 부탁드려요!