NVIDIA, Nemotron-4의 더 큰 버전인 Nemotron-4-340B 공개

Nemotron 시리즈 소개

Nemotron 모델 시리즈는 NVIDIA에서 공개한 대규모 언어 모델(LLM, Large Language Model) 시리즈로, 다양한 매개변수 크기와 컨텍스트 길이를 제공합니다. 또한, Nemotron 모델 시리즈는 NVIDIA의 NeMo 프레임워크와 호환되며, 다양한 기업용 AI 응용 프로그램을 지원하기 위해 설계되었습니다. Nemotron-3 시리즈와 Nemotron-4 시리즈는 각각 8B와 15B의 매개변수를 가지며, 이번에 새로 공개한 Nemotron-4-340B는 340B 규모의 매개변수를 갖는 모델군입니다. 각 모델 시리즈에 대한 상세한 설명은 다음 내용을 참고해주세요.

Nemotron-3 (8B) 시리즈 소개

2023년 말 출시된 Nemotron-3 시리즈는 8B 규모의 파라매터와 4K 컨텍스트 길이를 갖춘 대규모 언어 모델로, 기본 모델(Base), 채팅 모델(Chat), 질문 응답 모델(QA) 등 여러 변형들을 포함하고 있습니다. Microsoft Azure AI와의 협력을 통해 학습 및 공개되어, Azure AI에서도 쉽고 편하게 사용할 수 있도록 제공하고 있습니다.

Nemotron-3 8B 시리즈의 각 변형들의 설명 및 다운로드를 위한 링크는 다음과 같습니다:

| Model | Variant | Key Benefits |

|---|---|---|

| Base | Nemotron-3-8B-Base | 매개변수 효율적 미세 조정 및 도메인 적응을 위한 연속 사전 학습 지원 |

| Chat | Nemotron-3-8B-Chat-SFT | 사용자 정의 모델에 대해 Instruction-Following SFT(Supervised Fine-Tuning)을 진행 |

| Nemotron-3-8B-Chat-RLHF | RLHF(Reinforecement Learning by Human Feedback) 기법으로 지시어 튜닝(instruction-tuned)된 최고의 성능을 자랑하는 채팅 모델 | |

| Nemotron-3-8B-Chat-SteerLM | SteerLM 기반, 추론 시점에 유연한 정렬을 지원하는 채팅 모델 | |

| Question-and- Answer | Nemotron-3-8B-QA | 지식 기반(Knowledge Base)을 활용한 Q&A 모델 |

NVIDIA에서 공개한 Nemotron-8B 모델군에 대한 자세한 정보는 아래 공식 블로그를 참고해주세요:

모델은 위 표의 링크 및 아래 NVIDIA가 공개한 Hugging Face의 Nemotron-3 모델군 컬렉션에서 확인 및 다운로드하실 수 있습니다:

Azure AI에서의 사용은 다음 블로그를 참고해주세요.

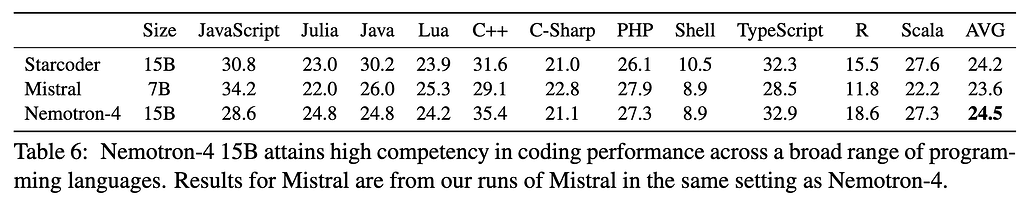

Nemotron-4 (15B) 시리즈

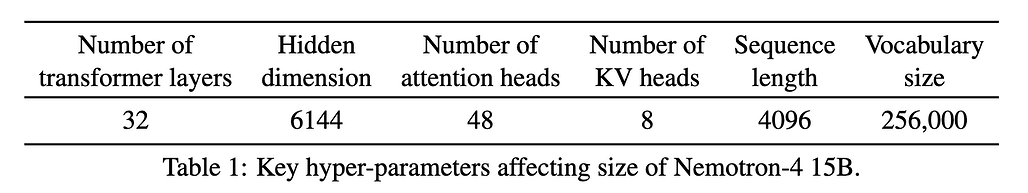

Nemotron-4는 NVIDIA에서 2024년 2월에 출시한 최신 대형 언어 모델(LLM) 시리즈입니다. 이전의 Nemotron-3 시리즈가 8B 규모의 파라매터를 가진 모델들로 구성된 것에 비해, Nemotron-4 시리즈는 15B 규모의 파라매터를 가진 모델들로 구성되어 있습니다.

15B억 개의 파라미터를 가진 Nemotron-4 15B 모델이 포함되어 있으며, 8T 규모의 토큰을 포함하는 다양한 학습 데이터셋으로 학습되었습니다. Nemotron-4 모델은 여러 언어와 코딩 작업에서 뛰어난 성능을 보이며, 다양한 다운스트림 평가 벤치마크에서 높은 성능을 보여줍니다.

Nemotron-4 (15B) 시리즈의 주요 기능 및 개선 사항

- 파라미터 및 학습 데이터: Nemotron-4 모델은 15B 규모의 모델로, 이전 모델(8B) 약 1.8배 가량 모델의 크기가 증가했습니다. 이러한 모델 크기의 향상으로 더 풍부한 이해와 성능을 제공합니다.

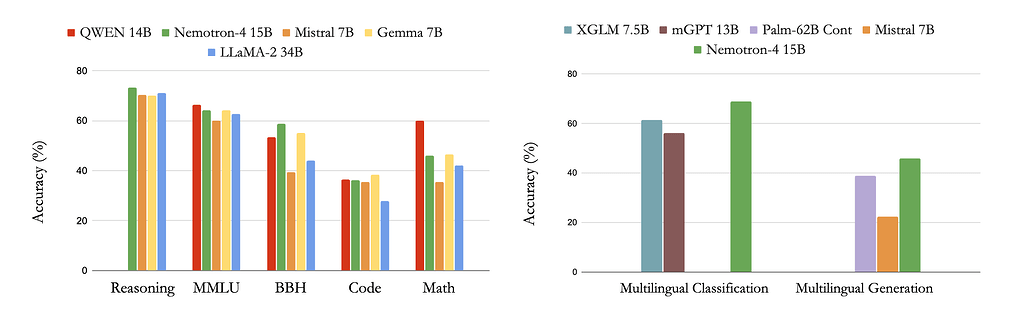

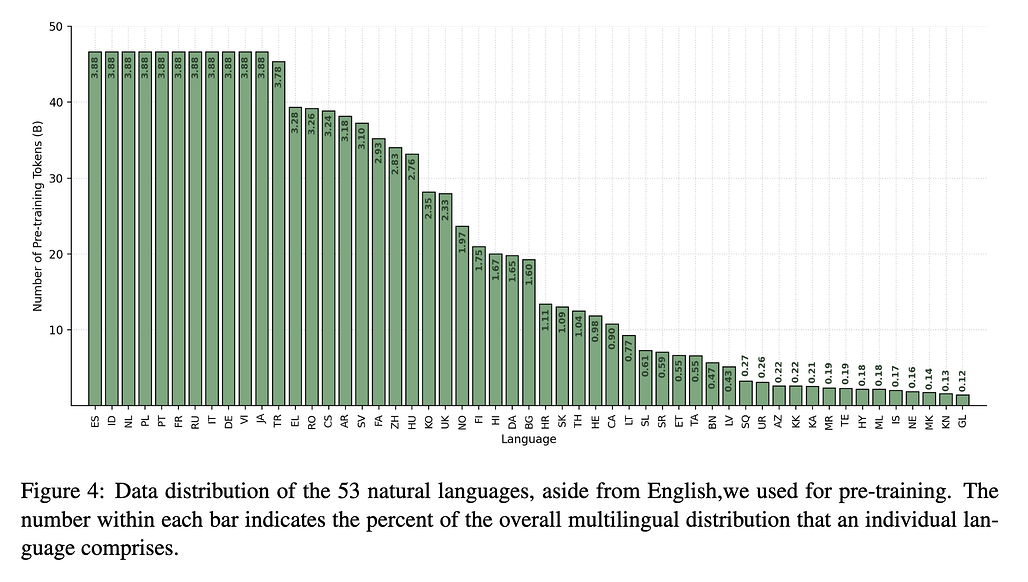

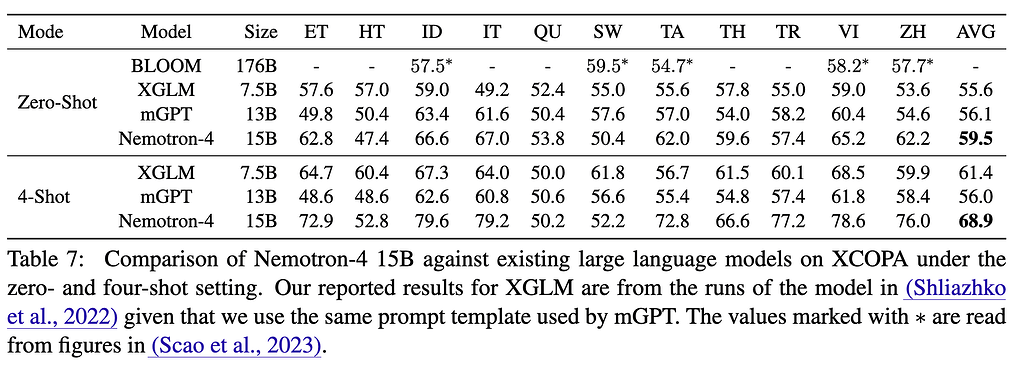

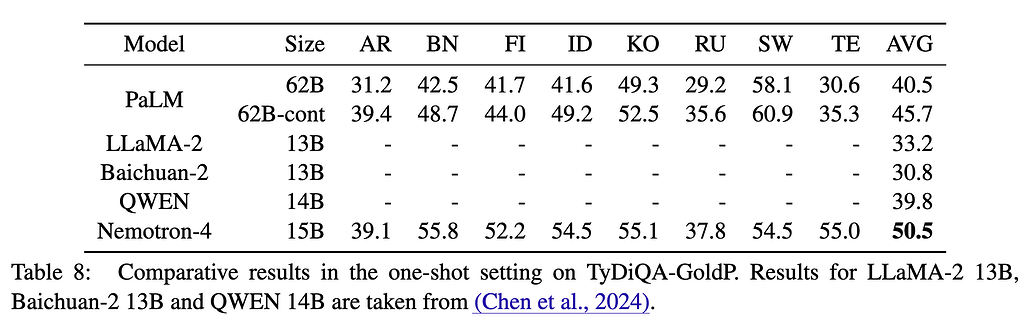

- 다국어 기능: 이 모델은 영어를 포함한 53개의 다국어로 사전 학습되었으며, 이를 통해 우수한 다국어 성능을 보여주며, 유사하거나 더 큰 크기의 다른 모델들을 능가합니다.

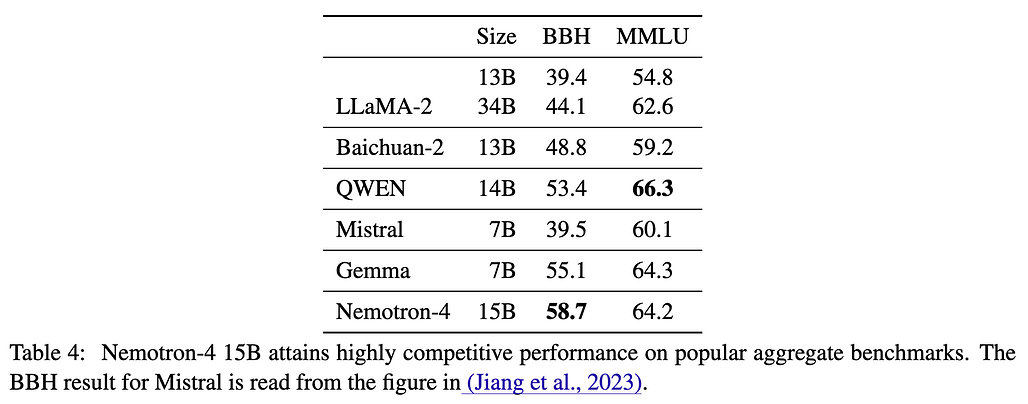

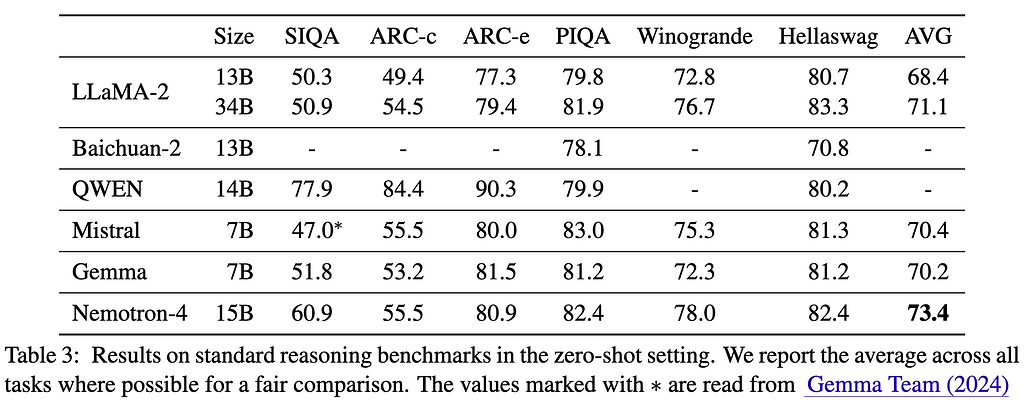

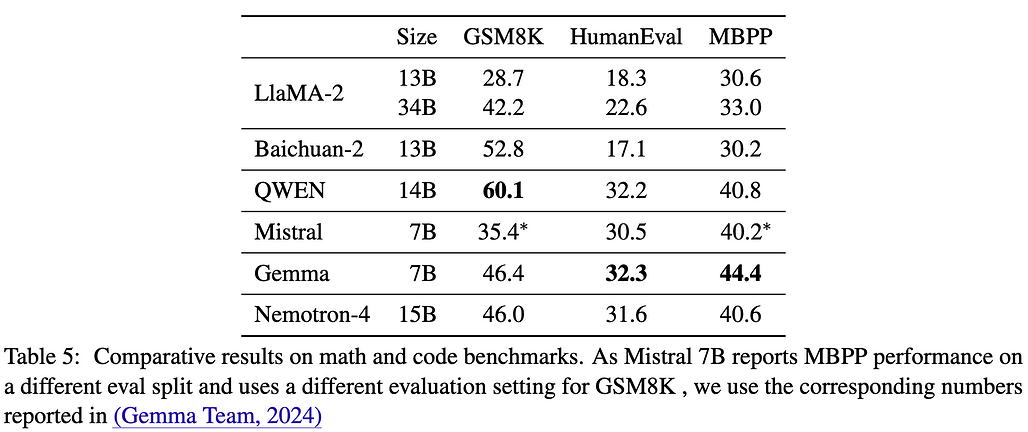

- 평가 벤치마크: Nemotron-4 모델은 이전 모델에 비해 작성, 롤플레이, 추출, STEM, 인문학, 추론 및 코딩 등과 같은 다양한 카테고리에서 향상된 성능을 보여줍니다. 특히,

Nemotron-4 시리즈(15B) 기술 문서

Nemotron-4-340B 모델 시리즈

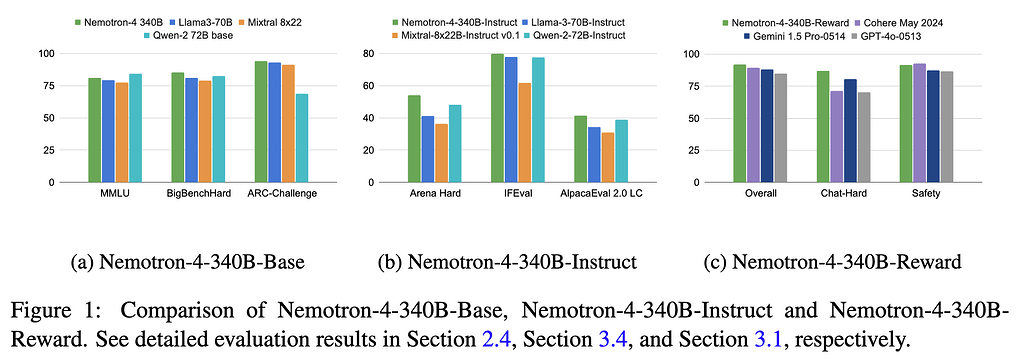

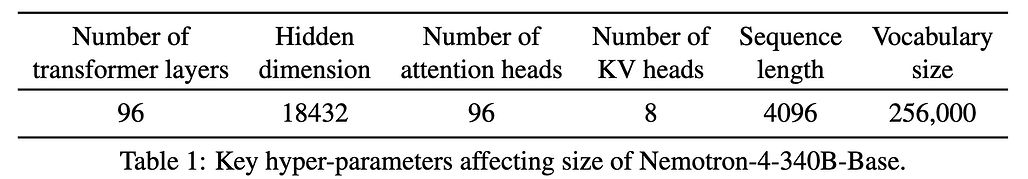

이번에 공개한 NVIDIA의 Nemotron-4 시리즈의 새로운 모델은 340B 규모의 파라매터를 갖는 대규모 언어 모델(LLM)입니다. Nemotron-4 340B 모델군은 기본(Base), 인스트럭트(Instruct), 리워드(Reward) 모델을 포함한 변형들로 구성되어 있습니다. 이 모델들은 데이터 큐레이션, 맞춤화 및 평가를 포함한 종단 간 모델 훈련을 위한 오픈소스 프레임워크인 NVIDIA NeMo와 최적화되어 있습니다. 또한, 추론 최적화를 위한 오픈소스 라이브러리인 NVIDIA TensorRT-LLM과도 최적화되어 있습니다.

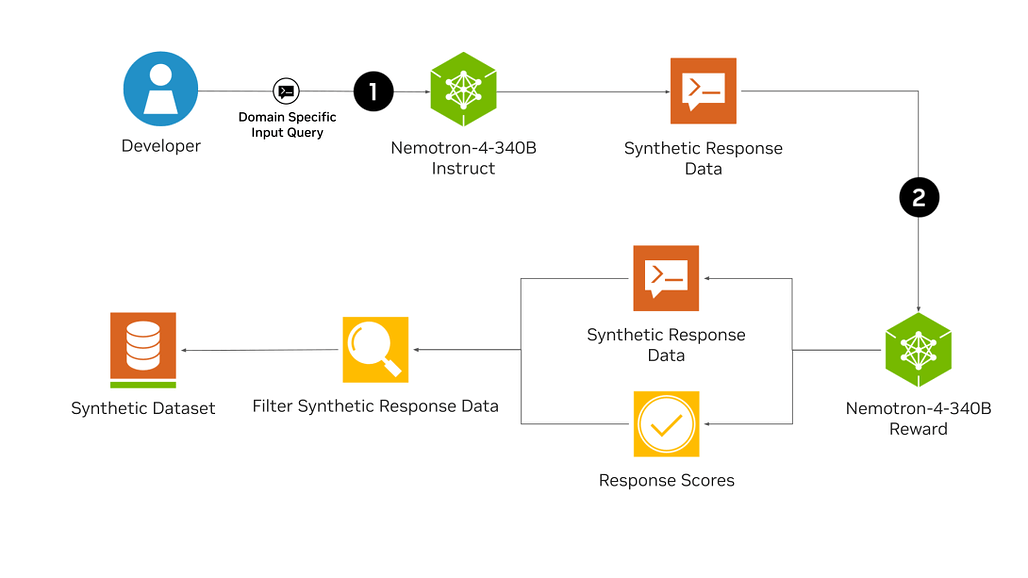

Nemotron-4-340B 모델의 가장 특징적인 부분은 대규모 모델을 학습 및 개선하기 위해 합성 데이터(Synthetic Data)를 사용했다는 것이며, 이를 위한 합성 데이터 생성 파이프라인까지 함께 공개했습니다. Nemotron-4-340B 모델 시리즈는 Hugging Face에서 다운로드할 수 있으며, 곧 NVIDIA NIM 마이크로서비스로도 제공될 예정입니다.

Nemotron-4-340B 모델 시리즈

| 모델명 | 저장소 링크 | 특징 및 성능 설명 |

|---|---|---|

| Nemotron-4 340B Base | Nemotron-4 340B Base | 9조 개의 토큰으로 훈련된 기본 모델. 사용자가 특정 도메인에 맞게 맞춤화 가능. |

| Nemotron-4 340B Instruct | Nemotron-4 340B Instruct | 다양한 합성 데이터를 생성하여 맞춤형 LLM의 성능을 향상시킴. 실제 데이터 특성을 모방하여 데이터 품질을 개선. |

| Nemotron-4 340B Reward | Nemotron-4 340B Reward | 생성된 데이터의 품질을 평가하는 모델. 도움, 정확성, 일관성, 복잡성, 장황성 등의 속성을 기준으로 응답 평가. |

Nemotron-4-340B 모델 시리즈의 주요 특징

-

합성 데이터 생성: Nemotron-4 340B Instruct 모델은 실제 데이터의 특성을 모방한 다양한 합성 데이터를 생성합니다.

-

데이터 품질 향상: Nemotron-4 340B Reward 모델은 생성된 데이터를 평가하여 품질 높은 응답을 필터링합니다.

-

맞춤화 가능: 사용자는 Nemotron-4 340B Base 모델을 사용하여 자신의 데이터를 통해 맞춤형 지시 및 보상 모델을 생성할 수 있습니다.

-

효율적 추론: TensorRT-LLM을 통해 다중 GPU 및 서버에서 효율적인 추론이 가능합니다.

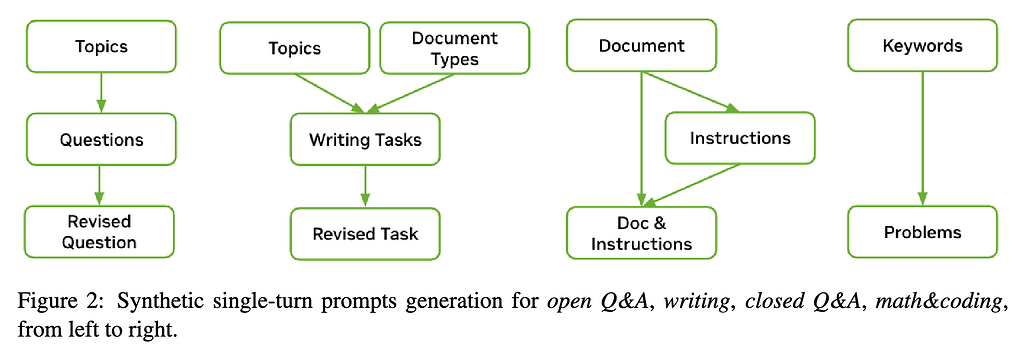

합성 데이터 생성 파이프라인 (Syntethic Data Generation Pipeline)

대규모 언어 모델(LLM)은 대규모의 다양한 라벨링 데이터 세트에 접근하기 어려운 상황에서 학습용 데이터를 생성하기 위해 사용할 수도 있습니다. Nemotron-4 340B Instruct 모델은 실제 데이터를 모방한 다양한 합성 데이터를 생성하여 맞춤형 LLM의 성능과 견고성을 향상시킵니다.

이렇게 생성된 AI 데이터의 품질을 높이기 위해 Nemotron-4 340B Reward 모델을 사용하여 고품질 응답을 필터링할 수 있습니다. 이 모델은 도움(Helpfulness), 정확성(Correctness), 일관성(Coherence), 복잡성(Complexity) 및 장황성(Verbosity)이라는 다섯 가지 속성을 기준으로 응답을 평가합니다:

- 도움 (Helpfulness): 응답이 프롬프트에 얼마나 도움이 되는지.

- 정확성 (Correctness): 오류 없이 관련된 모든 사실을 포함하는지.

- 일관성 (Coherence): 표현의 일관성과 명확성.

- 복잡성 (Complexity): 응답 작성에 필요한 지적 깊이.

- 장황성 (Verbosity): 프롬프트에 비례한 응답의 상세함.

오픈소스 NVIDIA NeMo와 NVIDIA TensorRT-LLM을 사용하여, 개발자는 합성 데이터를 생성하고 응답을 평가하기 위해 인스트럭트 및 리워드 모델의 효율성을 최적화할 수 있습니다. 모든 Nemotron-4 340B 모델은 TensorRT-LLM을 사용하여 텐서 병렬성을 활용하도록 최적화되어 있습니다. 이 기본 모델은 특정 사용 사례나 도메인에 맞게 사용자 지정할 수 있으며, NVIDIA NeMo 및 NeMo Alginer를 통해 감독된 미세 조정 및 파라미터 효율적 미세 조정 방법을 사용할 수 있습니다.

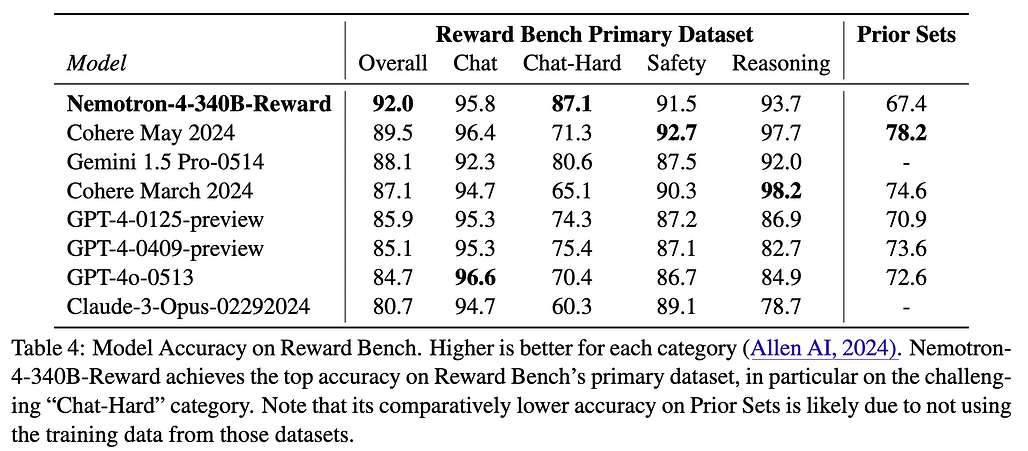

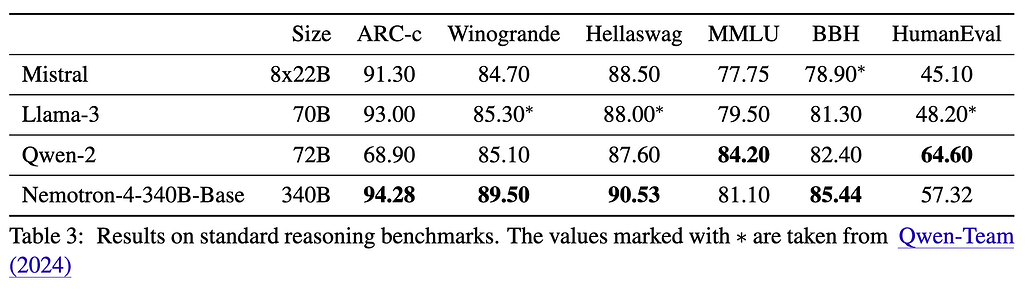

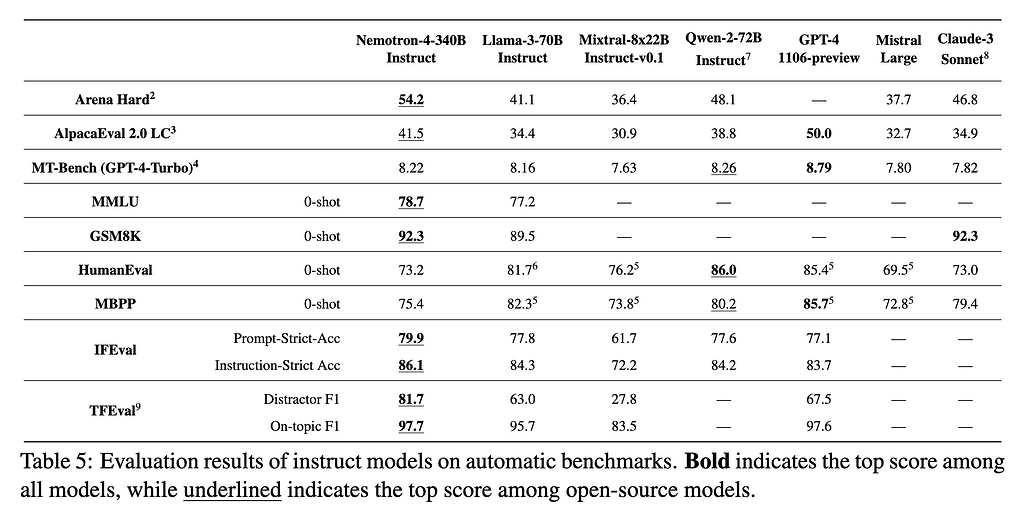

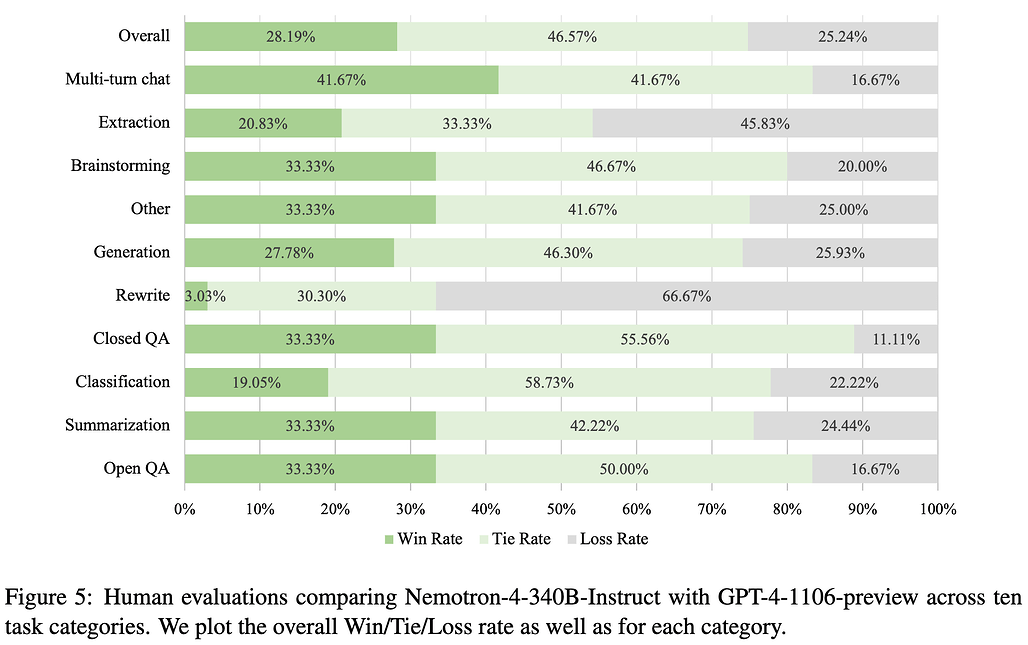

Nemotron-4-340B 모델의 성능

Nemotron-4-340B-Base 및 Instruct 모델 모두 유사한 크기의 다른 모델 대비 유사하거나 뛰어난 성능을 보입니다. 특히, Nemotron-4-340B-Rweward 모델은 AllenAI(AI2)가 제공하는 보상 모델(Reward Model) 성능 평가를 위한 Hugging Face RewardBench 리더보드에서 1위를 기록하였습니다.

HelpSteer2 데이터셋

NVIDIA와 Scale.AI와의 협력으로 제작한 HelpSteer2 데이터셋은 모델은 도움(Helpfulness), 정확성(Correctness), 일관성(Coherence), 복잡성(Complexity) 및 장황성(Verbosity)라는 다섯 가지 속성을 평가한 21,362개의 샘플을 포함한 데이터셋입니다. 이 데이터셋을 사용하여 대규모 언어 모델을 더 도움 되게, 사실에 맞게, 일관되게 조정할 수 있습니다.

-

프롬프트 출처: 주로 사용자가 기여한 ShareGPT 프롬프트 및 일부는 Scale AI에서 생성.

-

응답 생성: 내부 LLM 10개 중 조합으로 생성. 각 프롬프트마다 두 개의 응답 생성.

-

어노테이션: 각 샘플은 최소 3명에서 5명의 어노테이터가 독립적으로 평가.

Nemotron-4-340B 라이선스

이 프로젝트는 오픈 모델 라이선스로 공개 및 배포되고 있습니다. 상업적 사용에 제한이 없으며, 개발자들은 자유롭게 사용할 수 있습니다.

Nemotron-4-340B 공개 블로그

Nemotron-4-340B 기술 문서

Nemotron-4-340B 모델 다운로드를 위한 컬렉션

HelpSteer2 데이터셋 논문

HelpSteer2 데이터셋 다운로드

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()