GPT-OSS 소개

OpenAI가 드디어 자사의 첫 공개 가중치(Open Weight) 언어모델인 gpt-oss 시리즈를 공개하였습니다. 이번에 공개된 모델은 gpt-oss-120b와 gpt-oss-20b의 두 가지이며, 각각 대규모 서버 환경과 로컬 디바이스 환경을 겨냥하여 설계되었습니다. 이 모델들은 OpenAI의 고성능 폐쇄형 모델들과 유사한 수준의 추론 성능을 유지하면서도, Apache 2.0 라이선스로 누구나 자유롭게 사용 및 커스터마이징할 수 있도록 배포되었습니다.

이번 공개는 GPT-2 이후 오픈 가중치 모델이 거의 존재하지 않았던 OpenAI의 행보에 있어 매우 이례적인 결정이며, 연구 및 산업 전반에서 AI 접근성을 크게 높일 수 있는 전환점이라 할 수 있습니다. 특히, gpt-oss 시리즈는 단순히 “코드만 공개된 모델”을 넘어, 실제로 고성능 툴 연동, 사고의 연쇄(CoT, Chain-of-Thought) 기반 추론, 유연한 미세조정(fine-tuning) 등 다양한 실전 기능까지 포괄하고 있어 현장의 AI 활용도를 크게 높여줄 것으로 기대됩니다.

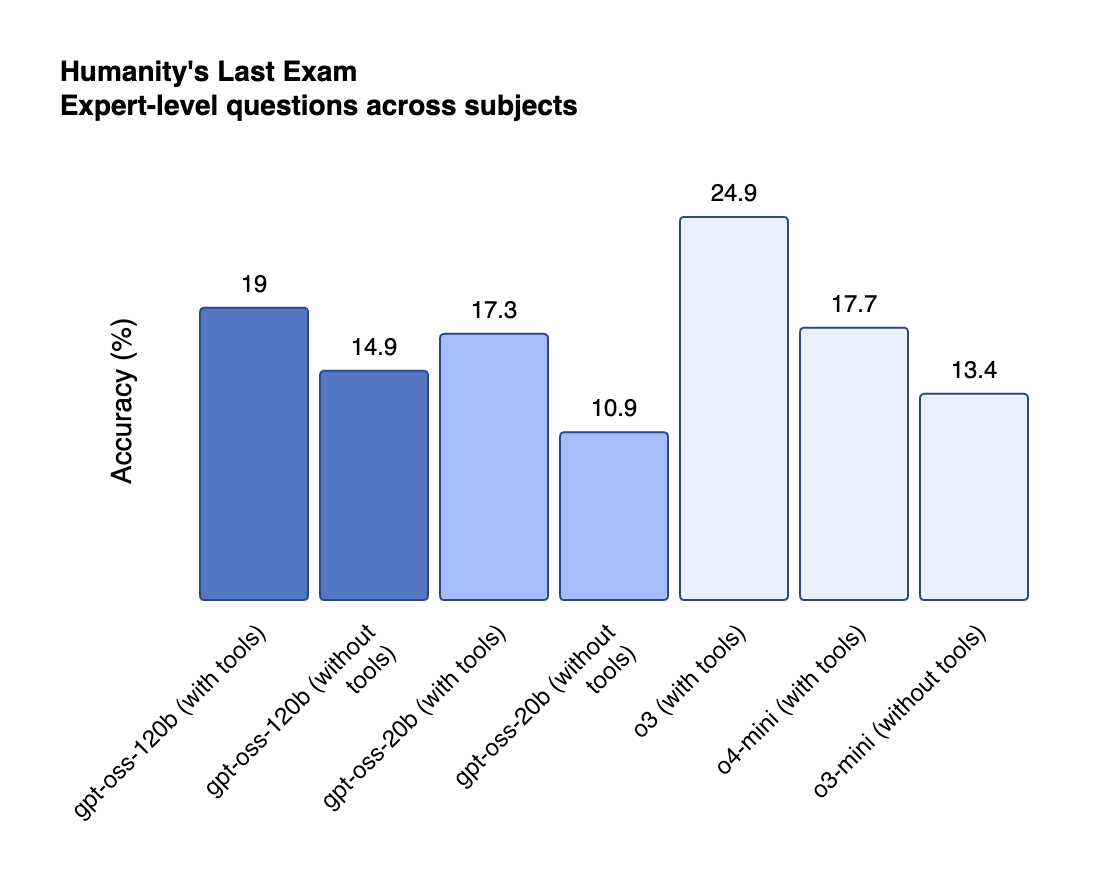

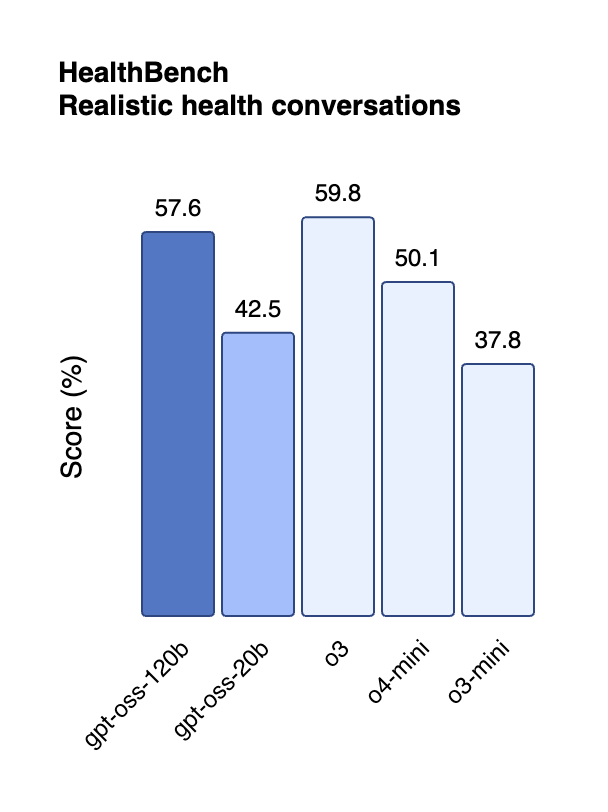

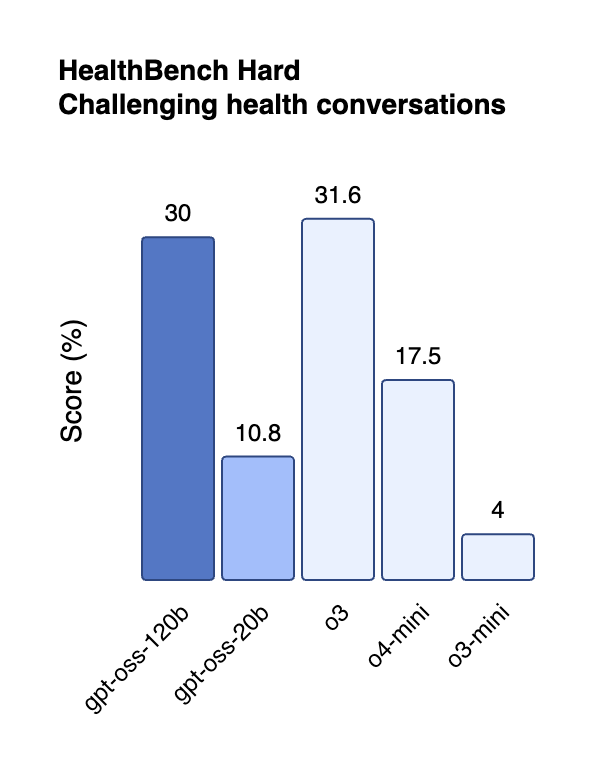

gpt-oss 모델은 내부적으로 OpenAI의 o시리즈(o3, o3-mini, o4-mini) 모델들과 비슷한 구조와 학습 전략을 채택하고 있으며, 그 성능 또한 유사하거나 일부 측면에서는 뛰어납니다.

-

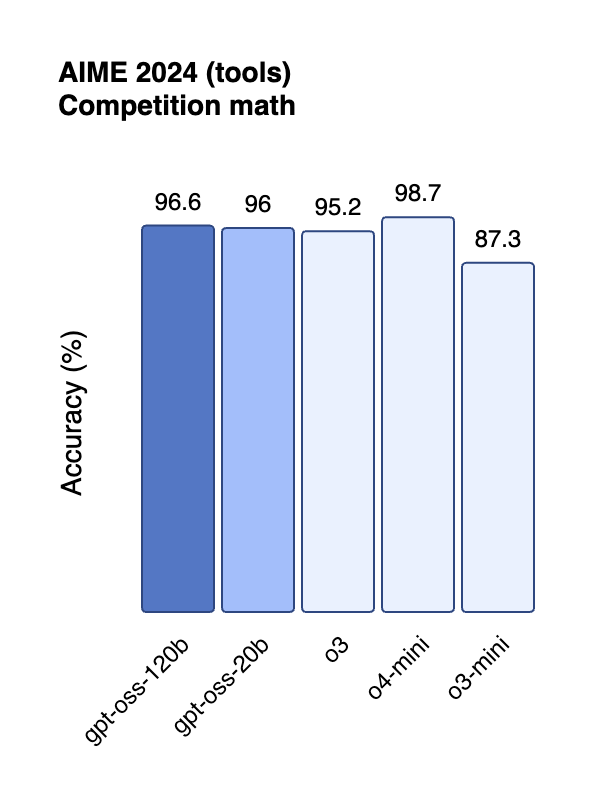

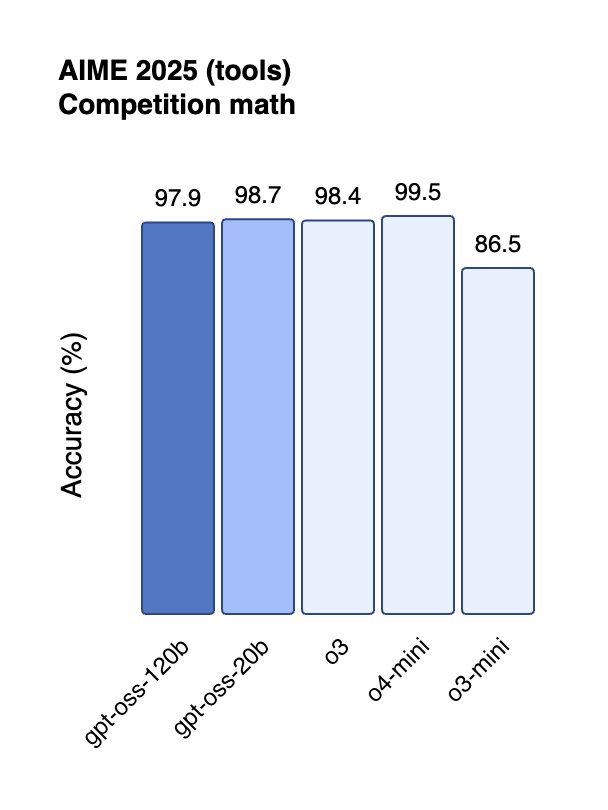

gpt-oss-120b: OpenAI의 o4-mini와 유사한 수준의 추론 성능을 보여주며, 특히 헬스 분야(HealthBench)와 수학 경진대회(AIME) 문제에서는 오히려 더 뛰어난 성능을 기록합니다.

-

gpt-oss-20b: o3-mini 수준의 성능을 유지하면서도, 단 16GB 메모리만으로도 로컬에서 실행 가능해 엣지 디바이스에서의 활용성이 매우 높습니다.

이러한 성능은 MoE(Mixure-of-Experts), Grouped Multi-Query Attention, RoPE, 128k context, Harmony Prompt Format 등 최신 기술이 집약된 결과이며, 동시에 OpenAI의 API 기반 폐쇄형 모델에 비해 훨씬 저렴한 비용으로 활용 가능하다는 장점이 있습니다.

경쟁 오픈모델들과 비교해도 gpt-oss 시리즈는 추론(reasoning), 도구 사용(tool use), 함수 호출(function calling) 등 실전 응용 능력에서 월등하며, 특히 chain-of-thought 미감독 학습 구조를 그대로 유지함으로써 모델의 행동을 감시하거나 제어하는 실험에도 적합합니다.

GPT-OSS 모델의 주요 특징

gpt-oss 모델 구조 및 사전학습

| Model | Layers | Total Params | Active Params Per Token | Total Experts | Active Experts Per Token | Context Length |

|---|---|---|---|---|---|---|

| gpt-oss-120b | 36 | 117B | 5.1B | 128 | 4 | 128k |

| gpt-oss-20b | 24 | 21B | 3.6B | 32 | 4 | 128k |

GPT-OSS 모델은 Transformer 기반으로 구축되었으며, MoE(Mixture-of-Experts) 구조를 통해 연산 효율을 극대화하였습니다. 예를 들어 gpt-oss-120b는 총 117B 파라미터를 갖지만, 실제로는 5.1B 파라미터만 활성화되어 추론에 사용됩니다. 이는 하나의 GPU에서도 고성능 모델을 효율적으로 실행할 수 있도록 돕는 핵심 설계입니다.

또한 gpt-oss는 다음과 같은 요소들을 포함합니다:

- RoPE(Rotary Positional Encoding) 사용

- 혼합된 Dense + Sparse Attention 구조 채택

- 128K 토큰 길이 지원: 긴 문서, 코드베이스, 대화 로그 등에도 대응 가능

- Grouped Multi-Query Attention : 빠른 추론을 위한 최적화

데이터셋은 대부분 영어 기반이며, 특히 STEM, 코딩, 일반 지식 분야에 초점을 맞춰 구성되었습니다. 또한 새로운 오픈소스 토크나이저인 o200k_harmony를 활용하여 텍스트를 처리합니다.

사후 학습 및 기능 특화

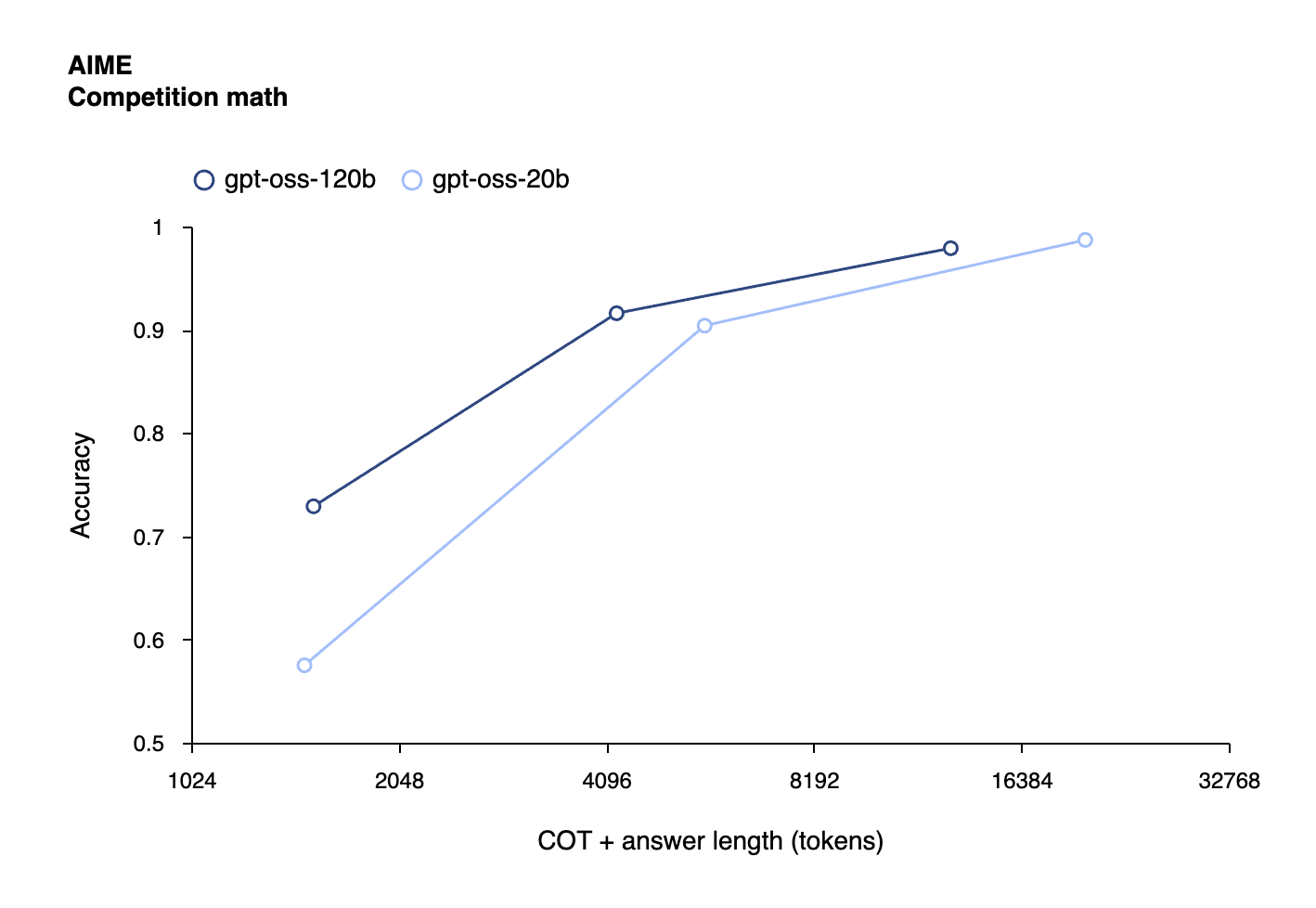

OpenAI는 이 모델들에 대해 o4-mini와 동일한 방식의 감독학습(SFT) + 고성능 RL 후처리를 적용했습니다. 특히 Tool Use, CoT reasoning, Instruction Following 등에 맞춰 조정된 학습 전략은 다음과 같은 성능 향상을 이끌어냈습니다:

- 추론 난이도 (low / medium / high)를 설정 가능

- Tool calling, Agentic workflow에서 강한 성능 발휘

- 개발자가 시스템 프롬프트에서 reasoning effort를 제어 가능

성능 지표

모델은 아래의 대표 벤치마크에서 OpenAI의 기존 o시리즈와 유사하거나 더 나은 결과를 보였습니다:

- TauBench (Tool use 평가)

- MMLU, HLE (문제 해결 능력)

- Codeforces, AIME (코딩/수학 대회 문제)

- HealthBench (의학적 질문 처리)

특히 gpt-oss-120b는 GPT-4o와 일부 영역에서 대등하거나 앞서는 결과를 보이기도 했습니다.

사고의 연쇄(CoT) 및 행동 모니터링

gpt-oss 모델은 CoT reasoning의 직접적 지도학습을 거치지 않았습니다. 이는 오히려 모델의 사고 과정을 투명하게 감시하고 이상 행동을 탐지하기 위한 목적으로 유지된 설계입니다. 사용자는 이 CoT 결과를 일반 사용자에게 직접 노출하지 않도록 주의해야 하며, 연구 목적에서만 활용하는 것이 권장됩니다.

모델 안전성과 악의적 활용 방지 대응

OpenAI는 gpt-oss 모델의 공개에 앞서, 다양한 위험 평가와 보안 실험을 진행했습니다. 특히 다음과 같은 점이 주목할 만합니다:

- CBRN(화학, 생물, 방사능, 핵) 관련 유해 데이터 필터링

- Deliberative Alignment 및 Instruction Hierarchy 기반 거부 학습

- 모의 악성 파인튜닝 실험: 생물학 및 보안 분야의 비거부 모델 생성 후 위험성 분석

- 외부 전문가 3곳의 평가 및 피드백 반영

또한 OpenAI는 공개와 동시에 Kaggle에서 50만 달러 규모의 Red Teaming Challenge를 열어, gpt-oss의 취약점을 발굴하는 글로벌 안전성 연구 생태계를 장려하고 있습니다.

활용 및 배포

모델은 다음과 같은 형태로 배포됩니다:

- Hugging Face에서 다운로드 가능 (MXFP4로 양자화됨)

- 120B 모델: 80GB GPU 필요

- 20B 모델: 16GB RAM 환경에서도 실행 가능

또한 다음과 같은 추가 요소들이 함께 제공됩니다:

- Harmony Renderer: Python, Rust로 구현됨

- PyTorch, Apple Metal 기반 추론 구현 예시

- 다양한 벤더 및 플랫폼과 협력 (Azure, AWS, vLLM, Ollama 등)

- Windows에서는 ONNX Runtime 기반 최적화 버전 제공

OpenAI의 GPT-OSS 모델 공개 블로그

OpenAI의 GPT-OSS 모델 공개 블로그

https://openai.com/index/introducing-gpt-oss/

GPT-OSS 사용해보기 (Playground)

GPT-OSS 사용해보기 (Playground)

OpenAI의 GPT-OSS 모델 카드

OpenAI의 GPT-OSS 모델 카드

https://openai.com/index/gpt-oss-model-card/

GPT-OSS 모델 다운로드

GPT-OSS 모델 다운로드

OpenAI ModelSpec 문서

OpenAI ModelSpec 문서

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()