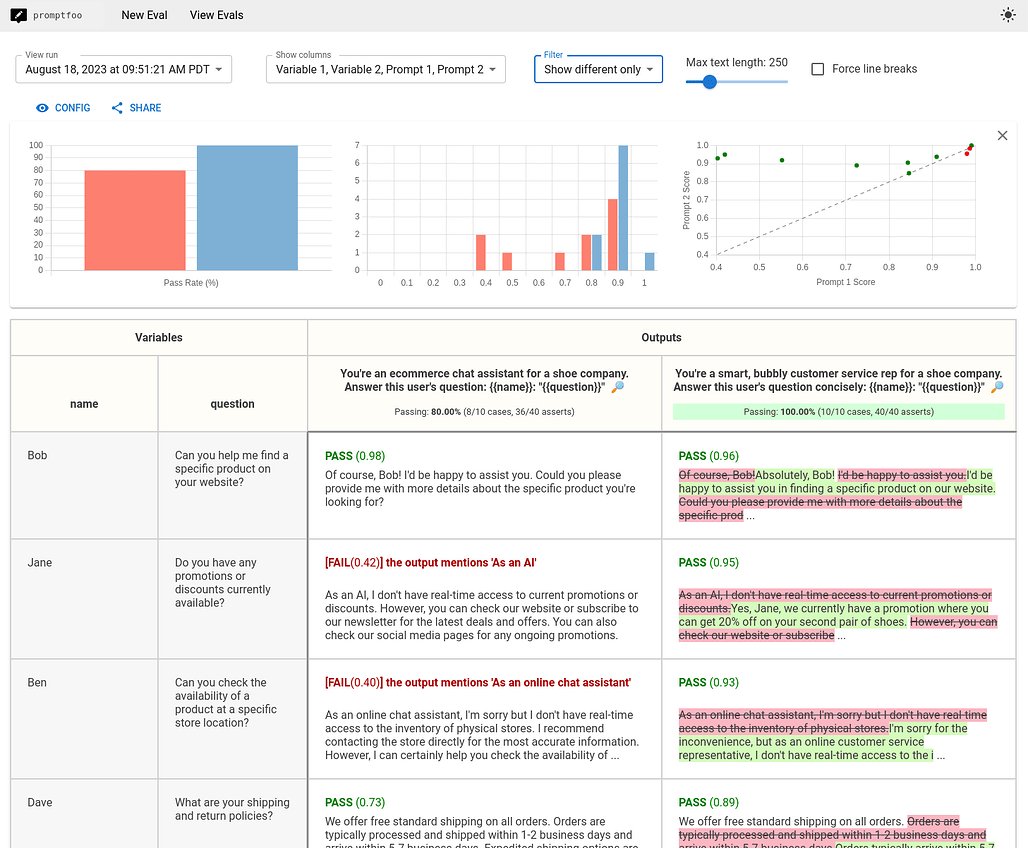

Promptfoo 소개

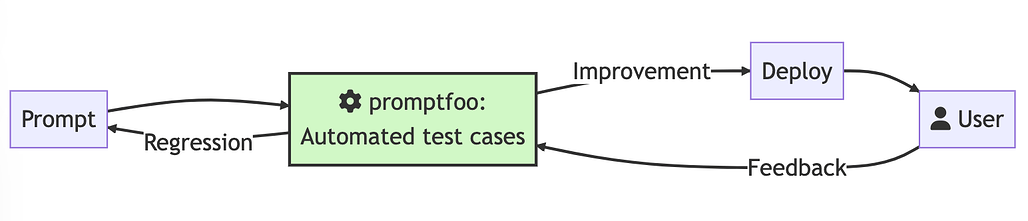

Promptfoo는 LLM(대형 언어 모델) 앱을 로컬에서 테스트하고 평가하는 강력한 도구입니다. LLM 개발 과정에서 프롬프트와 모델의 성능을 신속하게 평가할 수 있는 기능을 제공하여 개발자의 생산성을 높이고 앱의 품질을 보장합니다. 이 도구는 OpenAI, Anthropic, Azure, Google, HuggingFace, Llama 등 다양한 LLM API와 연동이 가능하며, 커스텀 API 프로바이더도 통합할 수 있습니다. Promptfoo는 LLM 개발에서 테스트 주도 개발(TDD)을 가능하게 하여, 시행착오를 반복하며 LLM 기반 애플리케이션을 개발하지 않을 수 있습니다.

Promptfoo가 다른 평가 도구들에 비해 특징적인 부분들은 다음과 같습니다:

-

개발자 친화적: 실시간 리로드와 캐싱 같은 품질 개선 기능을 제공하여 빠르고 효율적인 작업이 가능합니다.

-

검증된 도구: 1000만 명 이상의 사용자에게 서비스를 제공하는 LLM 앱 개발을 위해 제작되어 다양한 설정에 유연하게 적응할 수 있습니다.

-

간단한 테스트 케이스 정의: 코드 작성 없이도 간단하게 평가를 설정할 수 있습니다.

-

언어에 구애받지 않음: Python, JavaScript 등 다양한 언어를 사용할 수 있습니다.

-

협업 기능: 내장된 공유 기능과 웹 뷰어를 통해 팀원들과 협업할 수 있습니다.

-

오픈 소스: 100% 오픈 소스 프로젝트로서 사용 제약이 없습니다.

-

프라이버시 보장: 로컬에서 모든 평가가 이루어지며, LLM과 직접 통신합니다.

Promptfoo의주요 기능

Promptfoo는 다음과 같은 주요 기능을 제공합니다:

-

프롬프트 및 모델 평가: 다양한 프롬프트와 모델을 평가하여 최적의 성능을 도출할 수 있습니다.

-

자동화된 평가: 다양한 메트릭을 정의하여 자동으로 평가를 수행합니다.

-

커스터마이징 가능: CLI, 라이브러리, CI/CD 환경에서 사용이 가능합니다.

-

다양한 LLM API 지원: OpenAI, Anthropic, Azure, Google, HuggingFace, Llama 등 다양한 LLM API와 연동이 가능합니다.

사용 방법

Promptfoo를 사용하려면 다음 명령어를 실행하여 기본 설정을 초기화합니다:

npx promptfoo@latest init

이 명령어는 현재 디렉토리에 prompts.txt와 promptfooconfig.yaml 파일을 생성합니다. 이후 프롬프트와 변수를 수정한 후, 평가 명령어를 실행하여 평가를 시작합니다:

npx promptfoo@latest eval

자세한 설정 방법은 설정 가이드를 참고하세요.

라이선스

이 프로젝트는 MIT License로 공개 및 배포되고 있습니다.

Promptfoo GitHub 저장소

Promptfoo GitHub 저장소

https://github.com/promptfoo/promptfoo

Promptfoo 공식 문서

Promptfoo 공식 문서

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()