파이토치 한국 사용자 모임이 한땀한땀 정리한 오늘의 주요 AI/ML 소식들을 전해드립니다.

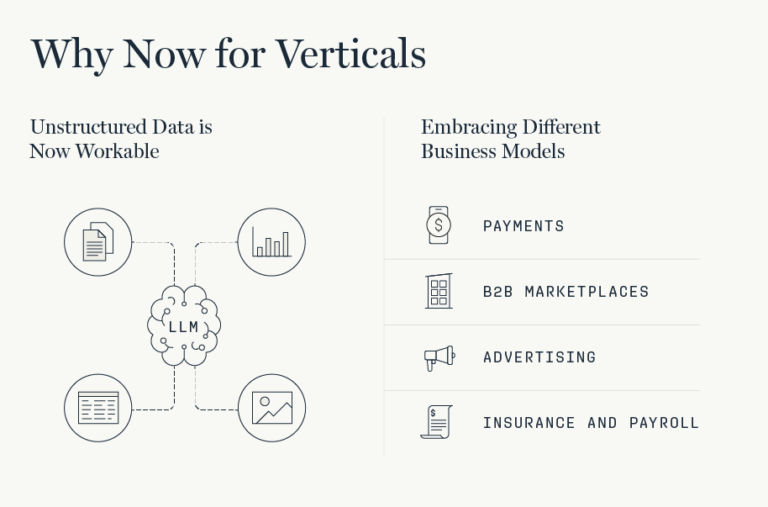

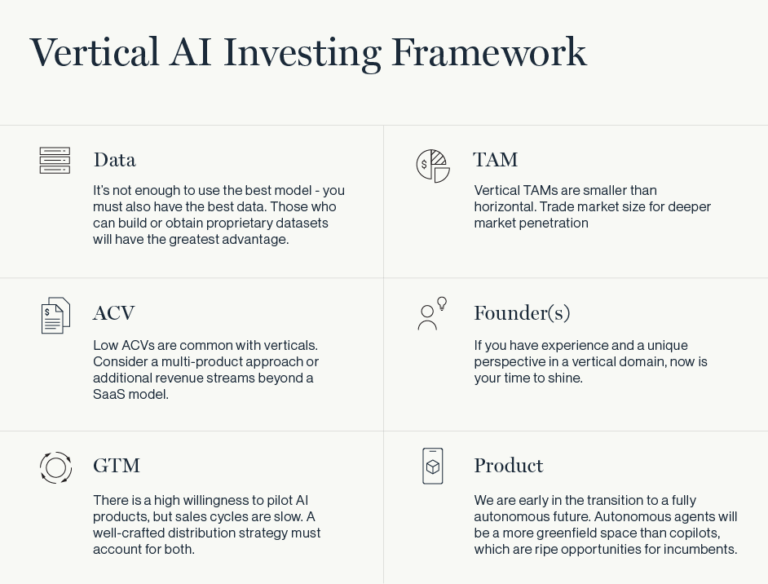

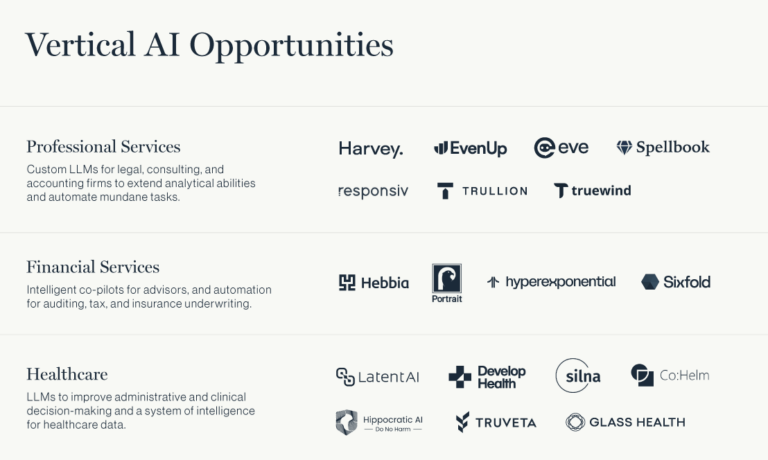

Vertical AI: 특정 산업에 특화된 수직적 AI(Vertical AI)가 중요한 이유

-

Vertical AI는 특정 산업에 특화된 소프트웨어 응용 프로그램을 의미합니다. Toast, Shopify, Procore, ServiceTitan과 같은 회사들의 성공이 강조되었습니다. 많은 시장들이 여전히 Vertical SaaS에 의해 충분히 서비스되지 않고 있으며, 특히 비정형 데이터, 제한된 총 주소 가능 시장(TAM: Target Addressable Market), 느린 판매 주기와 같은 장벽이 있는 시장들이 그러합니다. 이 글에서는 Vertical AI에 대해서 알아봅니다.

-

더 읽어보기

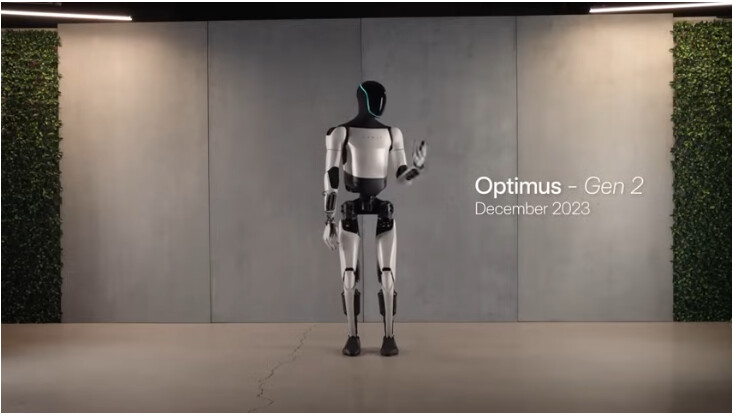

Tesla Optimus Gen2 공개

-

Telsa가 공개한 인간형 로봇 Optimus Gen 2는 인간이 수행하는 반복적인 작업을 대체하여 수행할 수 있을 것으로 기대합니다. Optimus Gen 2는 이전 모델보다 22파운드(약 10kg)가량 가볍고, 30% 더 빠르며, 더 부드럽고 능숙한 움직임을 보여줍니다. 이로 인해 보다 인간 같은 움직임을 구현할 수 있게 되었습니다. 이러한 발전은 휴머노이드 로봇 분야에서 중요한 진전을 나타내며, 인간과 유사한 기능과 움직임을 구현하는 데 있어서 새로운 가능성을 제시합니다.

-

더 읽어보기

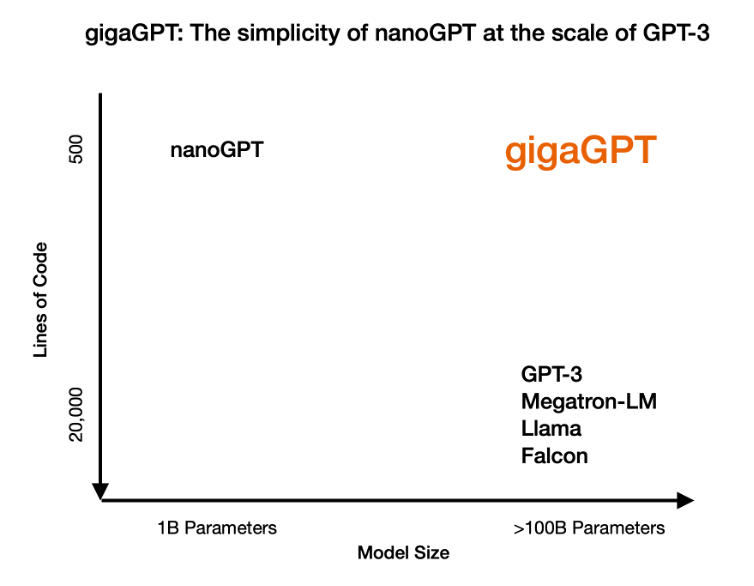

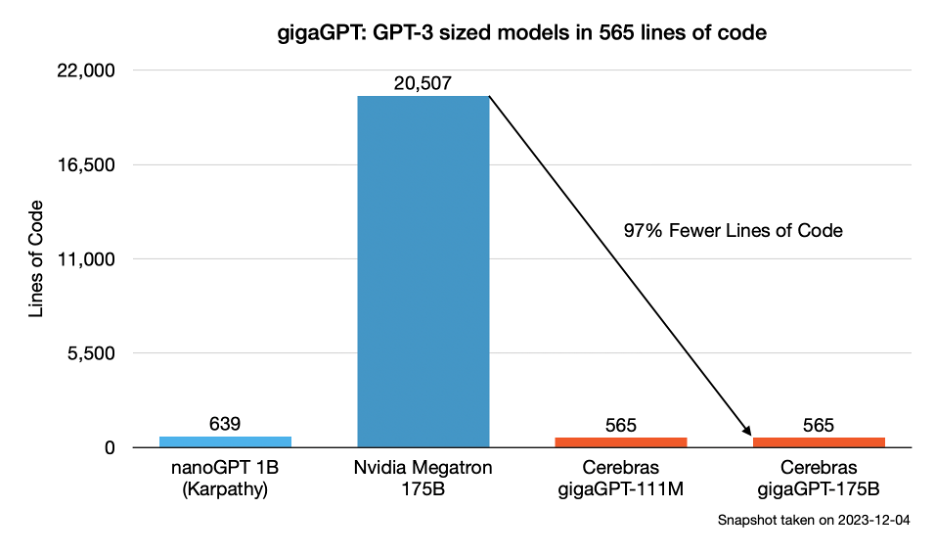

gigaGPT: Cerebras에서 공개한, 565줄의 코드로 구현한 GPT-3 크기 모델

-

gigaGPT는 Andrei Karpathy의 nanoGPT를 기반으로 하여 GPT 모델을 훈련하고 미세 조정하는 데 가장 간단하고 컴팩트한 코드 베이스를 제공합니다. nanoGPT가 최대 100M 파라미터 범위의 모델을 훈련시킬 수 있는 반면, gigaGPT는 100B 이상의 파라미터를 가진 모델을 훈련시킬 수 있습니다. 이는 추가 코드나 타사 프레임워크에 의존하지 않고, Cerebras 하드웨어의 대규모 메모리와 계산 능력을 활용하여 vanilla torch.nn 코드에 대한 대규모 훈련을 가능하게 합니다

-

더 읽어보기

- 소개 글: Introducing gigaGPT: GPT-3 sized models in 565 lines of code - Cerebras

- GitHub 저장소: GitHub - Cerebras/gigaGPT: a small code base for training large models

- nanoGPT 저장소: GitHub - karpathy/nanoGPT: The simplest, fastest repository for training/finetuning medium-sized GPTs.

- 관련 태그: nanogpt cerebras

모델 압축에 대한 재고찰: LLM에서 잠재 특징(latent feature)의 간소화된 모델링 방법

-

이 Rethinking Compression: Reduced Order Modelling of Latent Features in Large Language Models라는 제목의 논문은 대규모 언어 모델의 압축에 대해서 살펴봅니다. 이 논문은 대규모 언어 모델(Large Language Models, LLM)에서 최소한의 그래디언트 업데이트와 관련된 계산 요구 사항이 특히 소비자 등급 하드웨어에서 중요한 과제임을 설명하고 있습니다. 또한, 이에 대응하여 LLM의 실용적인 압축을 위한 혁신적인 접근 방법을 소개합니다

-

더 읽어보기

오늘의 주요 소식이 유용하셨나요?

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 뉴스 발행에 힘이 됩니다~

를 눌러주시면 뉴스 발행에 힘이 됩니다~ ![]()