Qwen의 QWQ-32B-Preview 모델 소개

Qwen팀에서는 새로운 대규모 언어 모델(LLM), QwQ-32B의 미리보기(QwQ-32B-preview)를 공개했습니다. QwQ는 Qwen with Questions의 약자로, QwQ-32B-preview 모델은 사용자 질의에 답을 하기 전, 자신의 가정에 의문을 제기하고 다양한 사고를 통해 추론하는 방식으로 더 나은 품질의 답을 제공합니다. 모델명에서 알 수 있듯 32.5B의 파라매터를 갖는 이 모델은 32K Context-Length를 지원합니다.

또한, 모델의 개발에는 대규모 데이터 세트와 고급 학습 기술이 적용되어 멀티태스크 학습과 높은 컨텍스트 길이를 지원합니다. 이를 통해 OpenAI의 o1-preview를 비롯한 다른 모델들과 견줄만한 성능을 가지고 있다고 합니다.

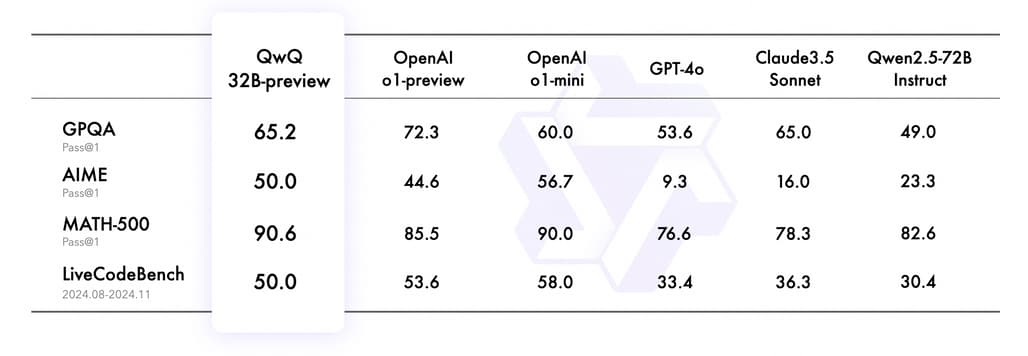

Qwen팀에서 공개한, 4가지 주요 벤치마크(GPQA, AIME, MATH-500, LiveCodeBench)에서 QwQ-32B-preview 모델과 다른 주요한 LLM과의 성능 비교 결과는 다음과 같습니다:

QwQ-32B-preview 모델의 주요 특징

-

대규모 파라미터: 320억 개의 파라미터를 통해 방대한 학습 데이터를 처리하며, 복잡한 패턴을 학습합니다.

-

다중 작업 학습 지원: 텍스트 생성, 번역, 요약, 코드 작성 등 다양한 작업에 최적화.

-

효율성: 기존 모델보다 더 낮은 계산 자원으로도 높은 성능 달성 가능.

-

확장성: 다양한 도메인 및 언어에 적응 가능.

사용 방법

QwQ-32B-preview 모델은 Huggingface와 Modelscope 등에 공개되어 있으며, 4.37.0 이상의 transformers가 설치되어 있다면 다음과 같이 사용 가능합니다(4.37.0 미만의 transformers가 설치되어 있다면 KeyError: 'qwen2'같은 오류가 발생합니다):

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/QwQ-32B-Preview"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompt = "How many r in strawberry."

messages = [

{"role": "system", "content": "You are a helpful and harmless assistant. You are Qwen developed by Alibaba. You should think step-by-step."},

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=512

)

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

Qwen팀의 QwQ-32B-preview 소개 블로그

Qwen팀의 QwQ-32B-preview 소개 블로그

QwQ-32B-preview 데모

QwQ-32B-preview 데모

QwQ 모델 GitHub 저장소 (Qwen2.5와 동일)

QwQ 모델 GitHub 저장소 (Qwen2.5와 동일)

QwQ-32B-preview 모델

QwQ-32B-preview 모델

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()