Stax 소개

최근 LLM(대규모 언어 모델)을 활용한 애플리케이션 개발이 활발히 이루어지면서, 개발자들은 “모델이 정말 개선되었는지” 확인하기 위한 평가의 중요성을 절실히 느끼고 있습니다. 그러나 전통적인 소프트웨어 테스트 방식은 LLM의 비결정적 특성(non-determinism) 때문에 충분히 효과적이지 않습니다. 같은 입력에도 출력이 달라질 수 있기 때문에, 단순한 단위 테스트로는 성능 변화를 검증하기 어렵습니다. 결국 개발자들은 프롬프트를 조금 바꾸고 실행해본 뒤, “이번 결과가 좀 더 좋아 보인다”는 **감각적 판단(vibe testing)**에 의존하게 됩니다.

구글은 이러한 문제를 해결하기 위해 Stax라는 새로운 평가 도구를 선보였습니다. Stax는 **AI 평가를 위한 완전한 툴킷(The complete toolkit for AI evaluation)**으로, 단순한 벤치마크 실행을 넘어 사용자의 데이터와 요구사항에 맞춘 체계적인 평가를 제공합니다. Google DeepMind의 평가 노하우와 Google Labs의 실험적 혁신이 결합된 Stax는, 개발자가 직접 평가 파이프라인을 구축하지 않고도 데이터 기반의 신뢰할 수 있는 평가 환경을 제공합니다. 이를 통해 LLM 기반 기능을 보다 빠르고 안정적으로 배포할 수 있으며, 반복적인 개선 과정도 체계적으로 관리할 수 있습니다.

Stax는 단순히 모델의 “일반 성능”을 보는 것이 아니라, 각 제품과 사용자 맥락에 맞는 평가 기준을 설정할 수 있다는 점에서 의미가 있습니다. 예를 들어 고객 지원 챗봇이 지나치게 장황하지 않도록 하거나, 코드 생성 모델이 특정 팀의 스타일 가이드를 준수하도록 평가할 수 있습니다. 이는 범용적인 벤치마크로는 확인하기 어려운 서비스 특화 성능을 직접 측정할 수 있게 해줍니다.

LLM 평가 방식은 크게 두 가지 접근이 있습니다. 첫째는 **인간 평가자(HITL; human-in-the-loop)**를 통한 방식입니다. 사람의 직접적인 판단은 여전히 가장 신뢰할 수 있는 기준이지만, 비용과 시간이 많이 든다는 한계가 있습니다. 둘째는 LLM-as-a-judge(Autorater) 방식입니다. 이는 강력한 LLM(예: Google Gemini)을 심판 역할로 활용해 다른 모델의 출력을 평가하는 방법으로, 일관성과 확장성을 제공하면서 사실성, 관련성, 톤 등 다양한 요소를 검증할 수 있습니다.

Stax는 이 두 방식을 결합하여, 필요에 따라 인간 평가와 자동 평가를 동시에 활용할 수 있게 합니다. 특히 Stax의 커스텀 Autorater 기능은 일반적인 벤치마크로는 측정하기 어려운 조직 맞춤형 규칙을 평가 기준으로 반영할 수 있다는 점에서 차별화됩니다.

Stax의 주요 기능

-

빠른 실험(Experiment): Stax는 모델, 프롬프트, 오케스트레이션 방식을 빠르게 비교할 수 있는 기능을 제공합니다. 개발자는 반복적인 수동 테스트를 대신해 한 번의 평가로 다양한 조합의 성능을 확인할 수 있습니다. 이를 통해 가장 적합한 모델과 프롬프트를 조기에 파악할 수 있습니다.

-

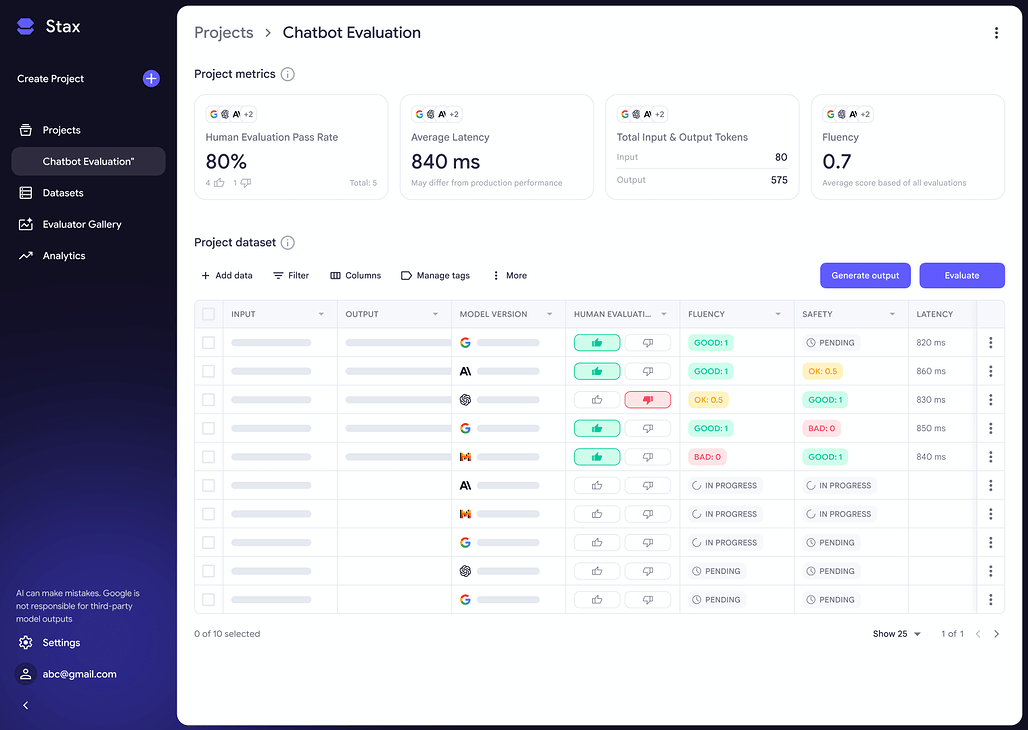

평가(Evaluate): Stax는 CSV 형태의 데이터셋을 업로드하거나, 직접 프롬프트와 정답을 정의하여 맞춤형 테스트 세트를 구축할 수 있게 합니다. 또한 기본 제공 Autorater를 활용해 일관성, 사실성, 간결함 등을 빠르게 평가할 수 있으며, 필요하다면 자체 기준에 맞는 Autorater를 제작할 수 있습니다. 예를 들어 다음과 같은 평가 기준들을 생성할 수 있습니다:

- 챗봇이 “친절하지만 장황하지 않게” 답변하는지 평가

- 요약 모델이 **개인정보(PII)**를 포함하지 않는지 검증

- 코드 생성 모델이 팀의 스타일 가이드를 따르는지 확인

-

분석(Analyze): Stax는 단일 평가 결과만 제공하는 것이 아니라, 시간에 따른 성능 변화를 시각적으로 추적할 수 있는 분석 기능을 갖추고 있습니다. 이를 통해 모델 개선 여부를 데이터 기반으로 확인할 수 있으며, 실제 프로덕션 배포 전 **출시 준비 상태(launch readiness)**를 점검할 수 있습니다.

-

데이터 기반 의사결정: Stax는 단순히 “좋아 보인다”는 직관에 의존하지 않고, 명확한 성능 지표를 기반으로 모델 선택과 배포 결정을 내릴 수 있도록 지원합니다. 이를 통해 기업은 더 자신 있게 LLM 기능을 상용 서비스에 통합할 수 있습니다.

Stax 빠른 시작

- Google 계정으로 로그인: Stax 홈페이지에서 Google 계정을 사용해 로그인합니다.

- 데이터셋 준비: 기존 CSV 데이터를 업로드하거나, 새로 평가용 데이터셋을 작성합니다.

- Autorater 선택: 기본 제공 Autorater(일관성, 사실성, 간결성 등)를 사용하거나, 필요에 따라 직접 커스텀 Autorater를 정의합니다.

- 평가 실행: 선택한 모델과 프롬프트를 데이터셋에 적용해 결과를 평가합니다.

- 분석 대시보드 활용: 평가 결과를 시각화된 대시보드에서 확인하고, 모델 개선 여부를 추적합니다.

- 반복 개선: 원하는 성능이 확보될 때까지 모델과 프롬프트를 조정하고 평가를 반복합니다.

결론

Stax는 단순한 테스트 도구를 넘어, LLM 개발과 운영 과정에서 평가를 하나의 엔지니어링 워크플로우로 정착시킬 수 있는 강력한 툴킷입니다. 감각적 판단에 의존하는 비효율적인 방식에서 벗어나, 체계적이고 데이터 기반의 평가를 통해 LLM 기반 애플리케이션을 더욱 신뢰성 있게 발전시킬 수 있습니다.

Stax 공식 홈페이지

Stax 공식 홈페이지

Google의 Stax 공개 블로그

Google의 Stax 공개 블로그

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()