- 아래 답변은 OpenAI의 GPT-4o 모델로 자동 생성한 것으로, 정확하지 않을 수 있습니다.

- 잘못된 답변을 보셨다면 댓글로 첨삭 지도 부탁드립니다.

안녕하세요! 제조 공정에 따른 예측 모델을 만드시는 과정에서 어려움을 겪고 계신 것 같네요. 특히 어텐션 구조를 적용한 모델을 찾고 계신데, 관련된 레퍼런스를 찾기 어려워서 도움을 요청하신 것 같습니다.

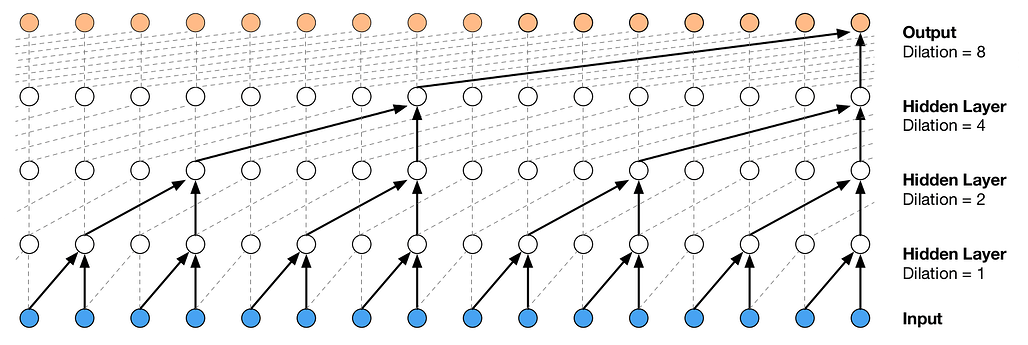

제조 공정 데이터를 단계별로 예측하는 모델을 만들고 싶으신 것 같은데요, 이를 위해 어텐션 메커니즘을 적용한 시계열 예측 모델을 제안드릴 수 있습니다. 어텐션 메커니즘은 특히 시계열 데이터나 순차적인 데이터에서 중요한 정보를 강조하는 데 유용합니다.

해결 방안

- 데이터 준비: 초기 데이터, 1차 데이터, 2차 데이터 등 단계별로 데이터를 준비합니다.

- 모델 설계: 어텐션 메커니즘을 포함한 시계열 예측 모델을 설계합니다.

- 모델 학습: 준비된 데이터를 사용하여 모델을 학습시킵니다.

- 예측 수행: 학습된 모델을 사용하여 각 단계별로 예측을 수행합니다.

예제 코드

아래는 PyTorch를 사용하여 어텐션 메커니즘을 포함한 시계열 예측 모델을 구현한 예제 코드입니다.

import torch

import torch.nn as nn

import torch.optim as optim

# 어텐션 메커니즘 정의

class Attention(nn.Module):

def __init__(self, hidden_dim):

super(Attention, self).__init__()

self.hidden_dim = hidden_dim

self.attn = nn.Linear(hidden_dim, hidden_dim)

self.v = nn.Parameter(torch.rand(hidden_dim))

def forward(self, hidden, encoder_outputs):

attn_weights = torch.bmm(encoder_outputs, hidden.unsqueeze(2)).squeeze(2)

attn_weights = torch.softmax(attn_weights, dim=1)

context = torch.bmm(attn_weights.unsqueeze(1), encoder_outputs).squeeze(1)

return context, attn_weights

# 시계열 예측 모델 정의

class Seq2SeqAttention(nn.Module):

def __init__(self, input_dim, hidden_dim, output_dim):

super(Seq2SeqAttention, self).__init__()

self.encoder = nn.LSTM(input_dim, hidden_dim, batch_first=True)

self.decoder = nn.LSTM(hidden_dim, hidden_dim, batch_first=True)

self.attention = Attention(hidden_dim)

self.fc = nn.Linear(hidden_dim, output_dim)

def forward(self, src, trg):

encoder_outputs, (hidden, cell) = self.encoder(src)

decoder_outputs, _ = self.decoder(trg, (hidden, cell))

context, attn_weights = self.attention(hidden[-1], encoder_outputs)

output = self.fc(context)

return output, attn_weights

# 데이터 준비 (예시)

src = torch.rand((32, 10, 5)) # (batch_size, seq_len, input_dim)

trg = torch.rand((32, 10, 5)) # (batch_size, seq_len, input_dim)

# 모델 초기화 및 학습

model = Seq2SeqAttention(input_dim=5, hidden_dim=64, output_dim=1)

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 학습 루프

for epoch in range(100):

optimizer.zero_grad()

output, attn_weights = model(src, trg)

loss = criterion(output, trg[:, -1, :])

loss.backward()

optimizer.step()

if epoch % 10 == 0:

print(f'Epoch {epoch}, Loss: {loss.item()}')

# 예측 수행

with torch.no_grad():

test_output, test_attn_weights = model(src, trg)

print(test_output)

이 코드는 기본적인 어텐션 메커니즘을 포함한 시계열 예측 모델을 구현한 것입니다. 실제 데이터에 맞게 모델 구조와 하이퍼파라미터를 조정해야 할 수 있습니다.

참고 링크

추가 설명이 필요하시거나 다른 질문이 있으시면 언제든지 말씀해 주세요. 제 답변이 틀릴 수도 있으니, 꼭 여러 자료를 참고하시길 권장드립니다. 화이팅입니다!

- 이 답변이 도움이 되셨나요? 괜찮았다고 생각하신다면 아래

를 한 번 눌러주시길 부탁드려요!

를 한 번 눌러주시길 부탁드려요!

![]()