딥러닝 초창기에 놀라운 성과에 대해서 아주 많은 이야기가 있었습니다.

시간이 흘러서 주요한 3명을 다룬 글이 나왔고, 잘 정리되었기에 소개해봅니다

제프리 힌튼, 페이페이 리, 젠슨 황에 대해서 설명하며 각각 어떤 기여를 했는지에 대한 소개를 합니다

제프리 힌튼

- 딥러닝 알고리즘 개발, gpu 사용

페이페이 리

- 이미지넷 만들어서 필요한 데이터셋 생성

젠슨 황

- cuda와 gpu 발전 도움

중간 즈음에 제프리 힌튼이 다른 연구자들에게 gpu사용 독려하면서

엔비디아에 무료 샘플 gpu 요청했는데 거절 당했다는 얘기는 왠지 재밌게 들립니다.

전문, 기계 번역됨:

왜 딥러닝 붐은 거의 모든 사람들을 놀라게 했을까?

“당신은 이 아이디어를 너무 과도하게 밀어붙인 것 같아요.”

—교수 페이페이 리(Fei-Fei Li)의 멘토가 했던 말.

By Timothy B. Lee (2024년 11월 6일)

2008년 가을, 저는 프린스턴대 컴퓨터공학 대학원 첫 학기 수업에서 COS 402: 인공지능 강의를 들었습니다. 학기 말 즈음, 신경망(neural networks)에 대한 강의가 있었습니다. 당시 강의와 교재 모두에서 신경망은 이미 한물간 기술이라는 인상을 받았습니다.

신경망은 1980년대 후반과 1990년대 초반에 주목할 만한 결과를 가져왔지만, 그 후 진전이 멈췄습니다. 2008년쯤에는 수학적으로 우아한 접근 방식인 **서포트 벡터 머신(Support Vector Machines)**과 같은 다른 방법들이 연구의 주류가 되었습니다.

당시 저는 몰랐지만, 같은 건물 안에서 프린스턴대의 한 연구팀이 신경망에 대한 기존의 통념을 뒤집고 그 잠재력을 입증할 프로젝트를 진행하고 있었습니다. 페이페이 리 교수가 이끄는 이 팀은 더 나은 신경망을 개발하려고 한 것이 아니었습니다. 그들은 신경망 자체를 거의 고려하지 않았습니다.

대신, 그들은 이전에 없던 규모의 새로운 이미지 데이터셋을 구축하는 데 집중했습니다: 1400만 장의 이미지, 각각 약 22,000개의 범주 중 하나로 라벨링된 데이터셋, ImageNet.

페이페이 리와 ImageNet의 탄생

리 교수는 최근 회고록 The Worlds I See에서 ImageNet 프로젝트를 처음 시작할 당시 받았던 회의적인 반응을 회상합니다.

2007년 몇 달 간의 작업 후, 한 멘토는 그녀에게 이렇게 말했습니다.

“이 아이디어를 너무 과도하게 밀어붙인 것 같아요. 연구 분야와 함께 성장해야지, 너무 앞서가서는 안 됩니다.”

문제는 단순히 방대한 데이터셋을 구축하는 것이 엄청난 물류적 도전이라는 점이 아니었습니다. 당시의 머신러닝 알고리즘이 그렇게 많은 이미지를 제대로 활용할 수 있을 거라 믿는 사람은 거의 없었습니다.

“ImageNet 이전에는 데이터를 중요하게 생각하지 않았습니다.”

2023년 Computer History Museum에서의 인터뷰에서 리는 이렇게 말했습니다.

“모든 연구가 아주 소량의 데이터로 전혀 다른 AI 패러다임을 사용하고 있었어요.”

그녀는 부정적인 피드백에도 불구하고 프로젝트를 2년 이상 지속했습니다. 연구 예산이 바닥날 위기에 처했고, 대학원생들의 인내심도 시험되었습니다. 그러나 리는 2009년 스탠퍼드대에 새로 부임하면서 ImageNet 프로젝트를 함께 캘리포니아로 가져갔습니다.

2009년, ImageNet이 처음 공개되었을 때 큰 주목을 받지 못했습니다. 그러나 2012년, 토론토 대학의 연구팀이 ImageNet을 기반으로 신경망을 훈련시켜 이전에 볼 수 없었던 이미지 인식 성능을 달성했습니다. 이 획기적인 모델은 AlexNet으로 알려지며, 현재까지 이어지는 딥러닝 붐을 촉발했습니다.

AlexNet의 성공과 NVIDIA GPU의 기여

AlexNet의 성공은 세 가지 혁신적인 요소의 결합 덕분이었습니다:

-

신경망(Neural Networks)

-

대규모 데이터셋(빅데이터; ImageNet)

-

NVIDIA GPU와 같은 고성능 컴퓨팅 기술

2006년, NVIDIA CEO 젠슨 황(Jensen Huang)은 GPU의 병렬 처리 능력을 그래픽 이외의 응용 프로그램, 예를 들어 과학 계산이나 날씨 시뮬레이션에 사용할 수 있다고 확신했습니다. 그러나 초기에는 시장의 반응이 냉담했습니다. CUDA라는 새로운 플랫폼이 발표되었지만, GPU의 잠재력을 활용할 적합한 애플리케이션이 없었습니다.

그러나 **힌튼(Geoffrey Hinton)**과 그의 학생들이 신경망 훈련에 CUDA와 GPU를 활용하면서 게임이 바뀌었습니다.

결론: 혁신은 도전에 맞서는 것에서 시작된다

페이페이 리는 이렇게 회상합니다.

“2012년은 현대 AI의 세 가지 필수 요소가 처음으로 하나로 융합된 해였습니다.”

이후 AI는 점점 더 큰 데이터셋과 모델을 필요로 하게 되었고, 이에 따라 GPU의 수요도 폭발적으로 증가했습니다. 하지만 AlexNet의 교훈은 단순히 스케일을 키우는 데에만 있는 것이 아닙니다.

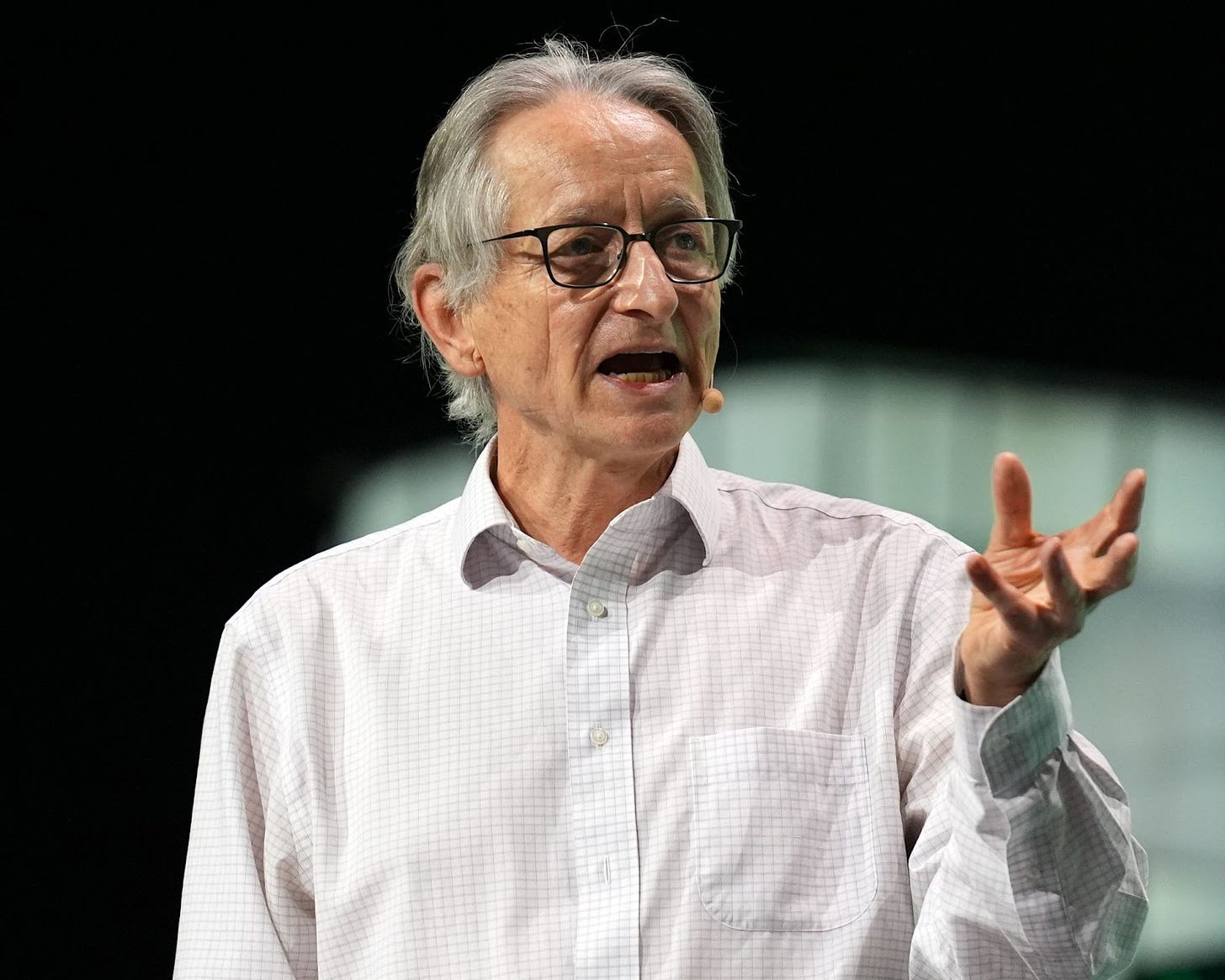

제프리 힌튼 (Geoffrey Hinton)

뉴럴 네트워크란?

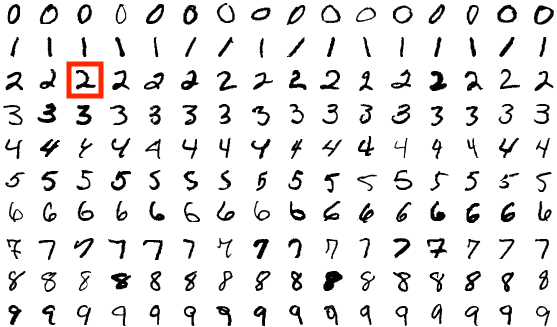

뉴럴 네트워크는 수천, 수백만, 심지어 수십억 개의 뉴런으로 이루어진 네트워크입니다. 각 뉴런은 입력값의 가중치 평균에 기반하여 출력을 생성하는 수학적 함수입니다.

예를 들어, 손으로 쓴 숫자(예: 숫자 2)를 식별하는 네트워크를 만들고 싶다고 가정해봅시다. 이 네트워크는 이미지의 각 픽셀에 대한 강도 값을 입력으로 받아 0~9 사이의 숫자에 대한 확률 분포를 출력합니다.

이 네트워크를 훈련하려면 초기 가중치를 무작위로 설정하고, 일련의 예제 이미지를 네트워크에 입력합니다. 각 이미지에 대해 네트워크가 “정답”에 가까운 출력을 생성하도록 연결을 강화하고, “오답”에 가까운 출력을 줄이는 방향으로 가중치를 조정합니다. 충분한 예제 이미지로 훈련시키면, 모델은 숫자 2를 보여줬을 때 높은 확률로 2라고 예측할 수 있게 됩니다.

뉴럴 네트워크의 발전사

1950년대 후반, 연구자들은 단일 계층으로 구성된 단순한 뉴럴 네트워크를 실험하기 시작했으나, 이 네트워크는 복잡한 계산을 수행할 능력이 부족하다는 것을 깨닫고 점차 관심을 잃었습니다.

1960년대에 이르러 다층 구조의 딥 네트워크가 더 강력할 가능성이 제기되었으나, 이를 효율적으로 훈련시키는 방법을 알지 못했습니다. 다층 네트워크의 중간 계층의 매개변수를 변경하면 출력에 복잡하고 예측 불가능한 영향을 미쳤기 때문입니다.

제프리 힌튼이 1970년대 연구를 시작했을 때, 뉴럴 네트워크는 이미 비주류가 되어 있었습니다. 그는 네트워크를 연구하기 위해 여러 대학과 연구소를 전전하며 연구를 지속했습니다.

백프로파게이션(Backpropagation)의 등장

1986년, 힌튼은 데이비드 루멜하트(David Rumelhart), 로널드 윌리엄스(Ronald Williams)와 함께 백프로파게이션 알고리즘을 발표하며 뉴럴 네트워크 훈련의 효율성을 크게 향상시켰습니다.

백프로파게이션은 출력 계층부터 역으로 그레이디언트를 계산하여 네트워크의 가중치를 조정하는 방식입니다. 이 알고리즘은 반복 훈련을 통해 뉴럴 네트워크의 정확도를 점진적으로 높입니다. 이 논문은 깊은 네트워크를 훈련할 수 있는 가능성을 제시하며 뉴럴 네트워크에 대한 새로운 관심을 불러일으켰습니다.

현대 인공지능의 기초

힌턴과 그의 동료들은 역전파(backpropagation)의 기본 아이디어를 처음 발견한 사람들이 아니었다. 하지만 그들의 논문은 이 방법을 대중화하는 데 기여했다. 사람들이 이제 더 깊은 네트워크를 훈련시킬 수 있다는 것을 깨닫자, 신경망에 대한 새로운 열풍이 일어났다.

힌턴은 1987년에 토론토 대학교로 자리를 옮겼고, 신경망을 연구하고자 하는 젊은 연구자들을 끌어모으기 시작했다. 그중 한 명이 프랑스 출신 컴퓨터 과학자인 얀 르쿤(Yann LeCun)으로, 그는 1년간 힌턴과 함께 박사후 연구원 과정을 수행한 뒤 1988년에 벨 연구소(Bell Labs)로 옮겼다.

힌턴의 역전파 알고리즘은 르쿤이 필기체 인식과 같은 실제 과제에서 뛰어난 성능을 발휘할 만큼 충분히 깊은 모델을 훈련할 수 있게 했다. 1990년대 중반에는 르쿤의 기술이 매우 효과적으로 작동하여 은행들이 수표를 처리하는 데 이 기술을 사용하기 시작했다.

“한때 르쿤의 기술은 미국에서 입금된 모든 수표의 10% 이상을 읽었다”고 케이드 메츠(Cade Metz)는 2022년 출간된 그의 저서 *천재 제조기(Genius Makers)*에서 썼다.

그러나 르쿤과 다른 연구자들이 신경망을 더 크고 복잡한 이미지에 적용하려고 시도했을 때는 성공하지 못했다. 신경망은 다시 인기를 잃었고, 신경망에 집중했던 일부 연구자들은 다른 프로젝트로 관심을 돌렸다.

힌턴은 신경망이 다른 머신러닝 방법보다 우수할 수 있다는 믿음을 결코 버리지 않았다. 하지만 그가 자신의 주장을 입증할 수 있는 충분한 데이터와 계산 능력을 갖추기까지는 많은 시간이 걸렸다.

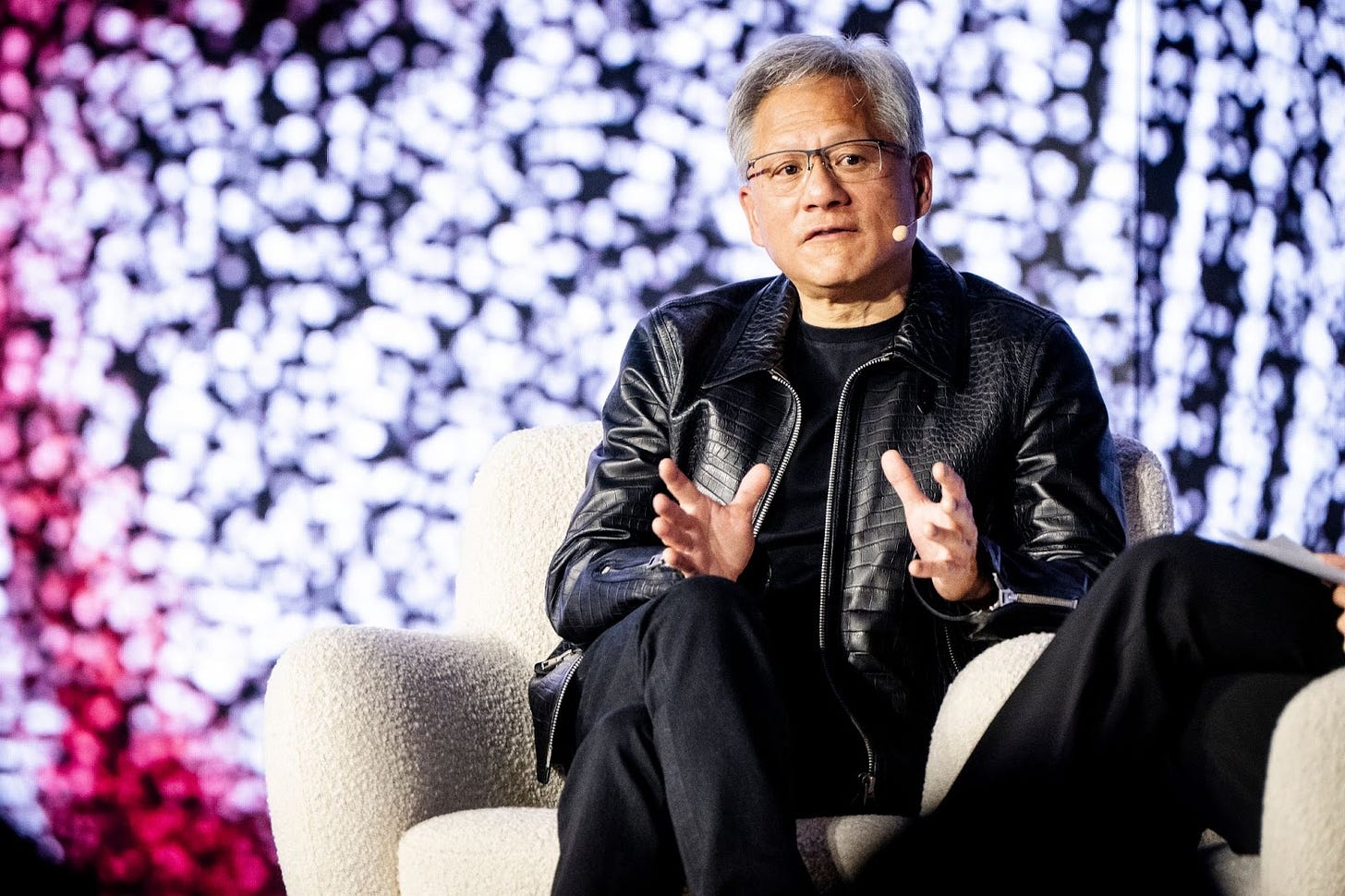

젠슨 황(Jensen Huang)

젠슨 황이 10월 덴마크에서 연설하고 있다. (사진: MADS CLAUS RASMUSSEN/Ritzau Scanpix/AFP via Getty Images)

모든 개인용 컴퓨터의 두뇌는 중앙처리장치(CPU)다. CPU는 계산을 순차적으로, 한 단계씩 수행하도록 설계되었다. 이 방식은 Windows나 Office 같은 일반 소프트웨어에서는 잘 작동한다. 하지만 비디오 게임 중 일부는 너무 많은 계산을 요구해 CPU의 한계를 초과한다. 특히 Quake, Call of Duty, Grand Theft Auto처럼 3차원 세계를 초당 여러 번 렌더링해야 하는 게임들이 그렇다.

그래서 게이머들은 성능을 가속화하기 위해 GPU에 의존한다. GPU 내부에는 여러 실행 유닛(작은 CPU와 유사한 구조)이 하나의 칩에 함께 탑재되어 있다. 게임 플레이 중에 각 실행 유닛은 화면의 다른 영역을 그린다. 이러한 병렬 처리 덕분에 CPU만으로는 불가능한 더 나은 이미지 품질과 높은 프레임 속도가 가능하다.

엔비디아(Nvidia)는 1999년에 GPU를 발명했고, 그 이후로 시장을 지배해 왔다. 2000년대 중반, 엔비디아 CEO 젠슨 황은 GPU 내부의 막대한 컴퓨팅 성능이 게임 외의 응용 분야에서도 유용할 것이라고 의심했다. 그는 과학자들이 이를 날씨 시뮬레이션이나 석유 탐사와 같은 연산 집약적 작업에 사용할 수 있기를 바랐다.

그래서 2006년, 엔비디아는 CUDA 플랫폼을 발표했다. CUDA는 프로그래머들이 “커널”이라는 짧은 프로그램을 작성해 단일 실행 유닛에서 실행할 수 있도록 한다. 커널은 큰 계산 작업을 작은 조각으로 나누어 병렬 처리로 수행할 수 있게 한다. 이를 통해 CPU만으로는 불가능한 속도로 특정 계산을 완료할 수 있다.

하지만 뉴요커에 따르면, 스티븐 윗(Steven Witt)이 작년에 쓴 글에서 CUDA가 처음 출시되었을 때 큰 관심을 끌지 못했다고 한다:

“CUDA가 2006년 말 출시되었을 때, 월스트리트는 당혹감을 보였다. 황은 슈퍼컴퓨팅을 대중에게 제공하려 했지만, 대중은 그런 것을 원한다는 신호를 전혀 보이지 않았다.

“그들은 이 새로운 칩 아키텍처에 막대한 비용을 쏟아붓고 있었다”고 인기 있는 실리콘밸리 팟캐스트 Acquired의 공동 진행자 벤 길버트(Ben Gilbert)는 말했다. “그들이 투자한 수십억 달러는 당시 시장 규모가 크지 않은 학문적, 과학적 컴퓨팅의 작은 영역을 겨냥하고 있었다.”

황은 CUDA의 단순한 존재만으로도 슈퍼컴퓨팅 분야가 확장될 것이라고 주장했다. 하지만 이 견해는 널리 받아들여지지 않았고, 2008년 말까지 엔비디아의 주가는 70% 하락했다…

2009년에 CUDA 다운로드가 정점을 찍었지만 이후 3년간 감소세를 보였다. 이사회는 엔비디아의 주가 하락으로 인해 회사가 기업 약탈자들의 표적이 될 것을 우려했다.

황은 CUDA 플랫폼을 만들 때 인공지능(AI)이나 신경망을 염두에 두지는 않았다. 하지만 힌턴의 역전파 알고리즘이 작은 단위로 나누기 쉬운 형태로 되어 있다는 것이 밝혀졌다. 결국 신경망 훈련은 CUDA의 킬러 애플리케이션이 되었다.

윗에 따르면, 힌턴은 CUDA의 잠재력을 빠르게 인식했다고 한다:

“2009년, 힌턴의 연구팀은 엔비디아의 CUDA 플랫폼을 사용해 인간 음성을 인식하는 신경망을 훈련시켰다. 그는 그 결과의 품질에 놀랐고, 그해 말 한 컨퍼런스에서 이를 발표했다. 그런 다음 그는 엔비디아에 연락했다. ‘내가 천 명의 머신러닝 연구자들에게 엔비디아 카드를 사라고 말했다’고 이메일을 보냈다. 하지만 엔비디아는 무료 제공 요청을 거절했다.”

그럼에도 불구하고 힌턴과 그의 대학원생들인 알렉스 크리제브스키(Alex Krizhevsky)와 일야 서츠케버(Ilya Sutskever)는 AlexNet 프로젝트를 위해 엔비디아 GTX 580 GPU 두 개를 구했다. 각 GPU는 512개의 실행 유닛을 가지고 있어 CPU만 사용할 때보다 신경망을 수백 배 더 빠르게 훈련할 수 있었다. 이 속도는 더 큰 모델을 훈련시키고 더 많은 이미지를 학습 데이터로 사용할 수 있게 했다. 그리고 이들은 방대한 ImageNet 데이터셋을 처리하기 위해 이 추가 컴퓨팅 파워가 꼭 필요했다.

페이페이 리 (Fei-Fei Li)

페이페이 리는 2007년 1월 프린스턴대에서 컴퓨터 과학 교수로 새 직장을 시작했을 당시 신경망이나 GPU에 대해 생각하고 있지 않았다. 칼텍(Caltech)에서 박사 학위를 받는 동안, 그녀는 101개 카테고리에 걸친 9,000개의 이미지를 포함한 Caltech 101이라는 데이터셋을 만들었다.

이 경험을 통해 리는 컴퓨터 비전 알고리즘이 더 크고 다양한 학습 데이터셋에서 더 잘 작동한다는 것을 배웠다. 그녀의 알고리즘뿐 아니라 다른 연구자들도 Caltech 101을 사용해 모델을 훈련하고 성능을 비교하기 시작했다. 이렇게 Caltech 101은 컴퓨터 비전 분야의 벤치마크가 되었다.

프린스턴에 도착한 리는 더 큰 목표를 세웠다. 그녀는 시각 과학자인 어빙 비더만(Irving Biederman)이 “평균적인 사람은 약 30,000가지 종류의 객체를 인식할 수 있다”는 추정에 집착하기 시작했다. 그녀는 사람들이 실제 세계에서 흔히 접하는 모든 종류의 객체를 포함한 종합적인 이미지 데이터셋을 만들 수 있을지 고민했다.

프린스턴의 한 동료가 리에게 14만 개의 단어를 체계적으로 분류한 WordNet 데이터베이스를 소개했다. 리는 자신의 새로운 데이터셋을 ImageNet이라고 명명하고, WordNet을 카테고리 선택의 출발점으로 사용했다. 그녀는 동사, 형용사, 추상적인 명사(예: “진리”)를 제거하고 구급차부터 호박까지의 22,000개 객체 목록을 만들었다.

Caltech 101과 동일한 접근법을 사용해 Google 이미지 검색으로 후보 이미지를 찾고 사람이 이를 검증하는 계획을 세웠다. 하지만 Caltech 101 때는 몇 달 만에 리 혼자 처리했지만, 이번에는 더 많은 사람이 필요했다. 프린스턴 학부생 수십 명을 고용해 이미지를 선택하고 라벨을 붙이려고 했지만, 리와 대학원생 지아 덩(Jia Deng)의 계산에 따르면, 수백만 개의 이미지를 선택하고 라벨링하는 데 18년 이상 걸릴 것으로 보였다.

이 프로젝트는 아마존의 크라우드소싱 플랫폼 **Mechanical Turk(AMT)**를 알게 되면서 구원받았다. AMT의 국제적 노동력은 프린스턴 학부생보다 비용이 저렴했고, 훨씬 더 유연하고 확장 가능했다. 리의 팀은 필요한 만큼 인력을 고용하고 작업이 있을 때만 비용을 지불할 수 있었다.

AMT 덕분에 ImageNet 제작 기간은 18년에서 2년으로 단축되었다. 하지만 리는 프로젝트를 완료하는 동안 연구실이 재정적으로 위태로운 상황에 처해 있었다고 적었다. 그럼에도 불구하고 최종 데이터셋의 1,400만 개 이미지 중 각 이미지를 세 명이 검토하도록 할 만큼의 자금은 확보했다.

ImageNet은 2009년에 발표 준비가 완료되었고, 리는 이를 그해 마이애미에서 열린 컴퓨터 비전 및 패턴 인식 학회(CVPR)에 제출했다. 논문은 채택되었지만, 리가 기대했던 만큼의 주목을 받지는 못했다.

“ImageNet은 포스터 세션으로 relegated 되었습니다.” 리는 이렇게 적었다. “우리의 작업을 강연장에서 청중 앞에서 발표할 기회는 없었고, 대신 컨퍼런스 플로어에서 프로젝트 요약을 담은 큰 포스터를 전시하고 지나가는 사람들이 질문하기를 기다려야 했습니다… 그 많은 노력이 결국 이렇게 되니 실망스러웠습니다.”

리의 관심을 끌기 위해, 그녀는 ImageNet을 경쟁 대회로 바꿨다. 그러나 전체 데이터셋은 지나치게 방대했기 때문에, 1,000개 카테고리와 140만 개 이미지를 포함한 소형 데이터셋을 만들었다.

2010년 첫 대회에는 11개 팀이 참여했고, 지원 벡터 머신(SVM)을 기반으로 한 모델이 우승했다. 그러나 “당시의 최첨단 기술과 비교했을 때 약간의 개선만 이루어졌다”고 리는 적었다.

2011년 대회 참가자는 줄었고, 또 다른 SVM이 우승했지만 2010년 우승작에 비해 거의 개선되지 않았다. 리는 비판이 맞았을지 의심하기 시작했다.

“2년 연속, 기존 알고리즘은 능력에서 점진적인 향상만 보였고, 실질적인 진전은 거의 없었습니다… ImageNet이 하나의 베팅이었다면, 우리는 졌다고 생각해야 할 때였습니다.”

그러나 2012년 세 번째 대회를 개최하자 상황이 완전히 달라졌다. 제프 힌턴(Geoff Hinton)의 팀은 심층 신경망을 기반으로 한 모델을 처음으로 제출했고, 이 모델의 상위 5개 정확도(top-5 accuracy)는 85%로, 2011년 우승작보다 10%포인트나 높았다.

리의 첫 반응은 믿기 어려운 것이었다.

“우리는 대부분 신경망을 유리로 덮인 먼지 쌓인 유물처럼 보았습니다.”

ImageNet 우승자 발표와 AlexNet의 성공

ImageNet 대회 결과는 2012년 10월 이탈리아 피렌체에서 열린 유럽 컴퓨터 비전 학회(ECCV)에서 발표될 예정이었다. 당시 캘리포니아에서 갓난아기를 돌보던 페이페이 리는 이 행사에 참석하지 않으려 했다. 하지만 AlexNet이 자신의 데이터셋에서 거둔 성과를 보고, 이 순간을 놓칠 수 없다고 판단했다. 그녀는 “20시간의 고된 비행, 수면 부족, 비좁은 비행기 좌석”을 감수하고 피렌체로 향했다.

피렌체의 어느 날, 알렉스 크리제브스키(Alex Krizhevsky)는 컴퓨터 비전 연구자들로 가득 찬 강연장에서 결과를 발표했다. 청중 속에는 페이페이 리와 얀 르쿤(Yann LeCun)도 있었다.

발표 후 르쿤은 자리에서 일어나 AlexNet을 가리켜 “컴퓨터 비전 역사에서 명확한 전환점”이라며, “이것이 바로 증거”라고 선언했다고 한다.

AlexNet의 성공과 역사적 의미

AlexNet의 성공은 신경망에 대한 제프리 힌턴(Geoffrey Hinton)의 신념을 입증했을 뿐 아니라, 르쿤에게도 더 큰 승리였다.

AlexNet은 르쿤이 20년 전 수표의 손글씨 숫자를 인식하기 위해 개발한 **합성곱 신경망(CNN)**을 기반으로 한 모델이었다.

1990년대 르쿤의 이미지 인식 네트워크와 AlexNet의 아키텍처 간에는 큰 차이가 없었다. 차이점은 AlexNet의 규모였다.

• 1998년 르쿤의 논문에서는 7개 층과 6만 개의 학습 가능한 매개변수를 가진 네트워크가 소개되었다.

• 반면, AlexNet은 8개 층과 6천만 개의 학습 가능한 매개변수를 가지고 있었다.

기술적 한계와 ImageNet의 역할

1990년대 초반에는 AlexNet 같은 대규모 모델을 훈련할 수 없었다. 당시에는 2012년 GPU 수준의 계산 능력을 가진 컴퓨터 칩이 없었기 때문이다. 슈퍼컴퓨터를 구축한다고 해도, 모델을 적절히 훈련시킬 수 있을 만큼 충분한 이미지를 모으는 데 막대한 비용이 들었을 것이다. Google과 Amazon Mechanical Turk가 등장하기 전에는 이런 데이터 수집은 매우 어려운 일이었다.

이 때문에 페이페이 리의 ImageNet 프로젝트가 결정적이었다. 그녀는 CNN을 발명하거나 GPU에서 효율적으로 실행할 방법을 찾은 것은 아니었다. 그러나 대규모 신경망이 잠재력을 발휘하는 데 필요한 학습 데이터를 제공했다.

기술 업계의 즉각적 반응

AlexNet의 중요성은 기술 업계에서 곧바로 인정받았다. 힌턴과 그의 학생들은 대형 기술 회사에 “인수 채용(acquihire)”되는 것을 목표로 껍데기 회사(shell company)를 설립했다. 몇 달 만에 Google이 이 회사를 4,400만 달러에 인수했다.

• 힌턴은 토론토 대학 교수직을 유지하면서 10년간 Google에서 근무했다.

• 일리야 서츠케버(Ilya Sutskever)는 Google에서 몇 년간 일한 후 OpenAI의 공동 창립자가 되었다.

Nvidia와 GPU 시장의 변화

AlexNet의 성공은 Nvidia GPU를 신경망 훈련의 업계 표준으로 만들었다.

• 2012년 당시 Nvidia의 시장 가치는 100억 달러 미만이었다.

• 오늘날 Nvidia는 세계에서 가장 가치 있는 기업 중 하나로, 시가총액이 3조 달러를 넘어선다.

이는 신경망 훈련에 최적화된 H100과 같은 GPU에 대한 압도적인 수요가 주도한 결과다.

가끔은 기존의 지혜가 틀릴 수 있다

“그 순간은 AI 세계에서 꽤 상징적인 순간이었습니다. 현대 AI의 세 가지 근본적인 요소가 처음으로 융합된 순간이었죠,” 페이페이 리는 컴퓨터 역사 박물관에서 열린 9월 인터뷰에서 이렇게 말했습니다. “첫 번째 요소는 신경망, 두 번째 요소는 빅 데이터로 ImageNet을 사용하는 것이었고, 세 번째 요소는 GPU 컴퓨팅이었습니다.”

오늘날 주요 AI 연구소들은 AI 발전의 핵심이 방대한 데이터 세트에 거대한 모델을 훈련시키는 것이라고 믿고 있습니다. 대형 기술 기업들은 더 큰 모델을 훈련시키기 위해 필요한 데이터 센터를 구축하려는 속도가 너무 빨라서 전체 원자력 발전소를 임대해 필요한 전력을 공급하고 있습니다.

이는 AlexNet에서 배운 교훈을 직설적으로 적용한 결과로 볼 수 있습니다. 하지만 저는 AlexNet에서 오히려 반대의 교훈을 얻어야 하는 건 아닌지 궁금합니다. 너무 기존의 지혜에 얽매이는 것은 실수일 수 있다는 교훈 말이죠.

**“확장 법칙”**은 AlexNet 이후 12년 동안 눈에 띄게 적용되어 왔으며, 아마도 앞으로 몇 세대 동안 더 인상적인 결과를 볼 수 있을 것입니다. 왜냐하면 주요 연구소들이 기반 모델을 더 확장하고 있기 때문입니다.

하지만 우리는 AlexNet의 교훈이 교리로 굳어지지 않도록 주의해야 합니다. 저는 적어도 확장 법칙이 앞으로 몇 년 내에 한계를 맞이할 가능성이 있다고 생각합니다. 그럴 경우, 우리가 새로운 세대의 고집 센 비주류들이 등장하여 기존 접근법이 더 이상 효과적이지 않다는 것을 깨닫고 다른 방법을 시도해야 할 필요가 있을 것이라고 봅니다.

출처 : Why the deep learning boom caught almost everyone by surprise