utjune

9월 30, 2022, 12:41오전

1

제가 논문이 구현되어있던 코드를 고치고 있습니다.

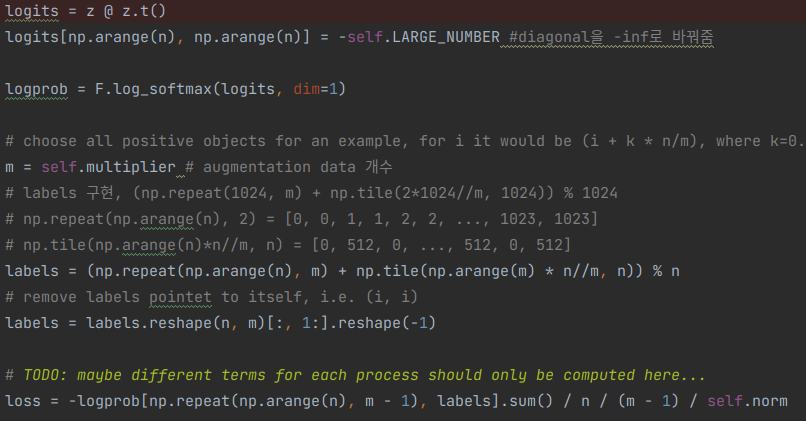

알고리즘을 대략 설명해드리면 logits이라는 행렬을 log_softmax() 함수를 통해서 로그 소프트맥스값을 얻은 뒤,

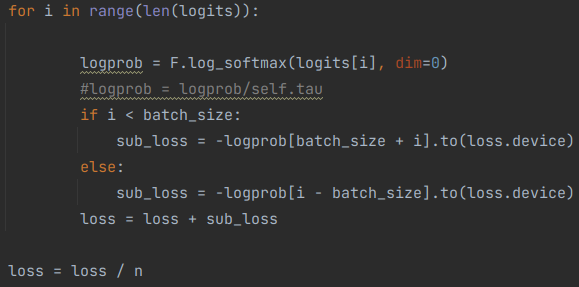

논문에서는 logits이라는 행렬 전체에서 한번에 구했는데 저는 불가피하게 for문을 한번 넣은 뒤, 각 행마다의 sub_loss를 구하고 final_loss를 구해주는 방식으로 코딩을 했는데요, 제가 작성한 코드는 학습이 되질 않네요.

뭐가 문제일까요…?

위에는 제가 작성한 코드이며 아래는 논문에서 작성된 코드입니다.

////////////////////////////////////////////////////////////////////////////////////////////////////////////

모델을 계속 디버깅하다가 확인했는데

감사합니다.

9bow

10월 1, 2022, 1:08오전

2

옷, 제가 올려주신 코드와 질문을 이해를 못한 것 같습니다ㅠ

구현하신 코드와 비교할 코드를 나눠서 보여주시면 같이 헤맬 수 있지 않을까요 -0-;;

1개의 좋아요

9bow

10월 1, 2022, 1:10오전

3

loss를 계산하실 때 모델을 통과한 값들을 사용하셨으면 autograd가 잘 들고 있다가 backward()를 해줄거 같은데 이상하네요

utjune

10월 4, 2022, 12:59오전

4

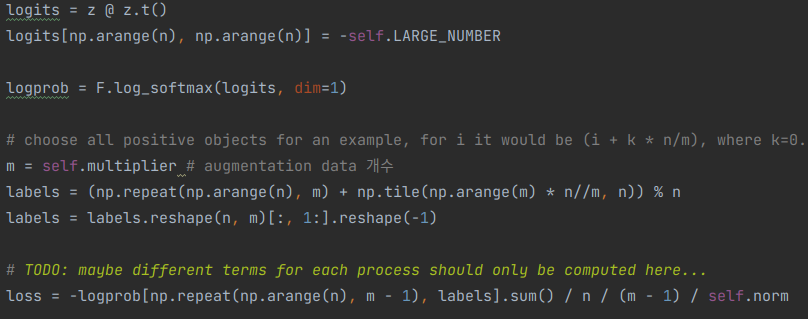

위의 코드가 기존 논문에서 작성된 코드입니다.

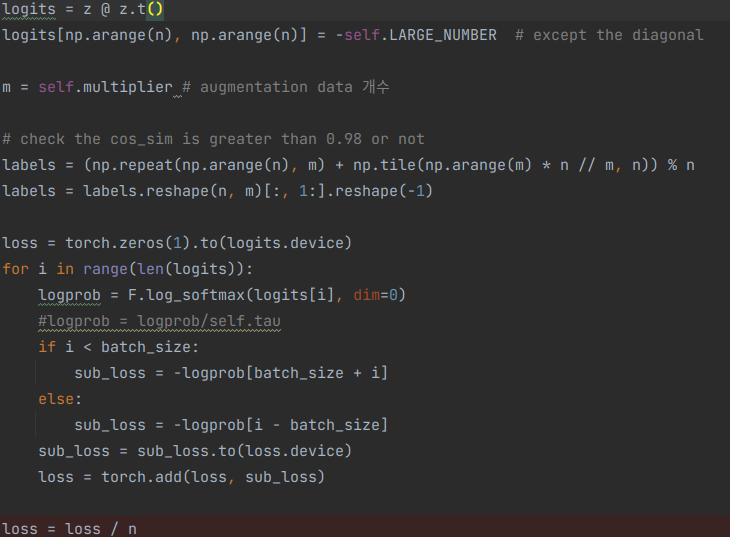

이게 제가 다시 구현한 코드입니다. 행을 하나하나씩 다 찾아봐야할 이유가 생겨서 각 행렬을 for문을 한번 사용해서 행마다 log_softmax를 구한뒤 정답값을 sub_loss로 구현하여 logits 전체의 sub_loss를 다 더한뒤 평균을 구해서 전체 loss로 구현하였습니다.

loss 값이 나오긴하는것같은데 모델의 weight를 optimizer.step()하기 전과 후로 나누어서 여러번 찍어봤는데

텐서 사이즈가 제가 생각한게 맞는지 확인 부탁드립니다.

softmax 부분을 for 안으로 넣으시면서 사이즈를 착각하신건 아닐까요?

logprob = F.log_softmax(logits,dim=1)

for i in range(len(logits)):

if i < batch_size:

sub_loss = -logprob[batch_size+i]

...

utjune

10월 4, 2022, 1:19오전

6

logits이 (2batch_size, feat_dim) * (feat_dim, 2batch_size)이기 때문에 (2batch_size, 2batch_size)가 됩니다.

혹시 제 생각이 잘못되거나 틀린부분 알려주시면 감사하겠습니다.

일단 말씀 해주신건 이해했습니다. 그래도 softmax는 효율상 밖으로 빼시는게 좋을듯…

loss를 구할때 여러개를 합하는건 문제가 없습니다.

로스의 크기나 그레디언트, 러닝레이트, 옵티마이저 등등을 봐야하지 않을까 싶은데요

1개의 좋아요

utjune

10월 4, 2022, 2:16오전

9

흡… 네 알겠습니다.

감사합니다.

utjune

10월 4, 2022, 5:27오전

10

문제 해결했습니다!

다음부턴 좀 더 잘 찾아보고 질문하도록 하겠습니다 ㅠㅠ;;

1개의 좋아요

9bow

10월 4, 2022, 8:04오전

11

오, 축하드립니다~

저는 누구한테 물어보고 나면 더 잘 보이더라구요 ㅎㅎㅎ

질문 올려주시고, 자문자답해주시는 것도 환영합니다!

system

11월 3, 2022, 8:05오전

12

이 글은 마지막 댓글이 달린지 오래(30일)되어 자동으로 닫혔습니다. 댓글 대신 새로운 글을 작성해주세요!