yolov5 object detection custom 학습 모델을 앱에 올리고 싶습니다.

그런데 pytorch(.pt)파일이 바로 올라가지 않고, tensorflow lite로 변환이 필요하더군요, 그래서 변환을 해서 올리는데 계속 에러가 나서 예측 결과를 얻을 수도 없어요... 어떻게 모델을 변환해야 결과를 받아볼 수 있을까요?

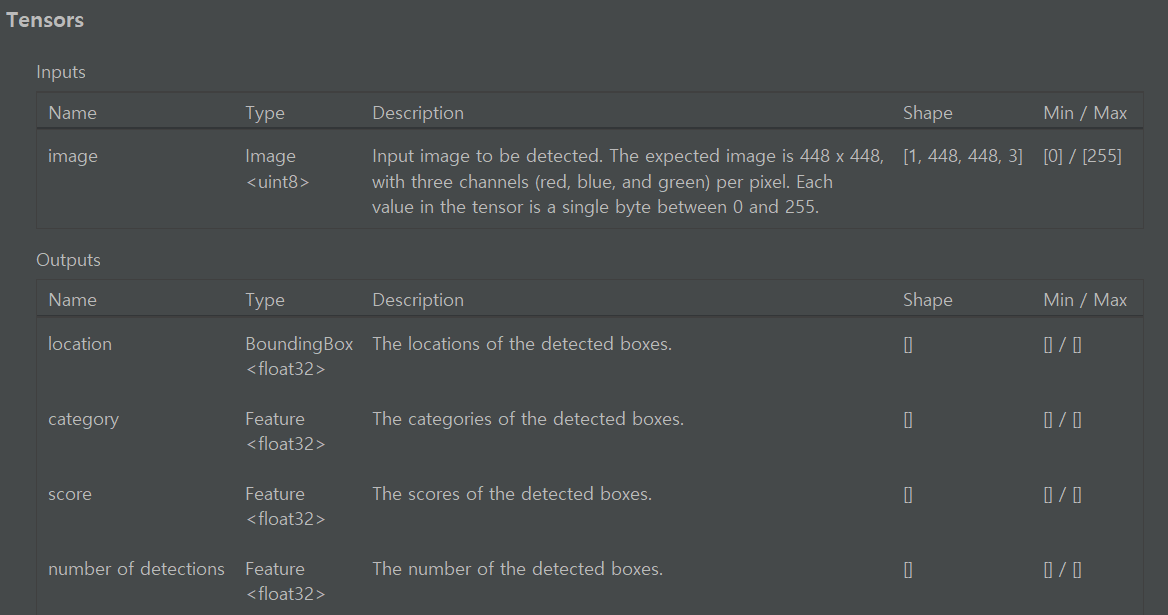

첫번째가 예시 tflite 모델이고,

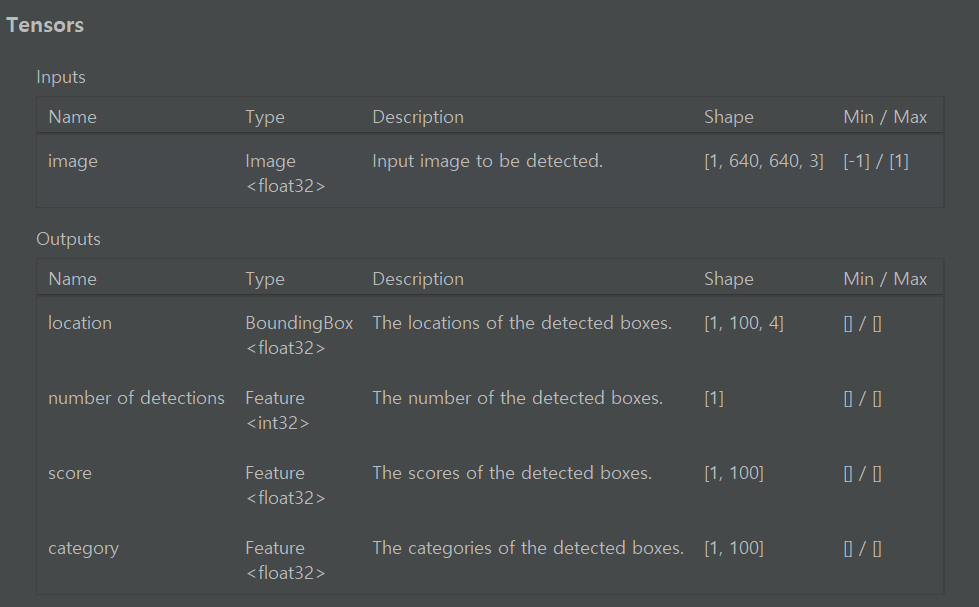

두번째 사진이 제가 학습한 tflite 모델입니다.

첫번째 모델은 예측이 잘 되는데 제가 학습한 모델은 예측 하지 못하고 앱이 바로 죽어버려요. 위의 모델처럼 메타데이터를 추가하거나 모델을 다시 export.py하는 방법이 있을까요?

아래의 코드에서 result 변수로 결과를 받는 부분에서 계속에러가 나서 어떻게 해결해야할지 모르겠습니다. 해당 코드에서 발생하는 에러는

Error getting native address of native library: task_vision_jni

java.lang.IllegalStateException: Error occurred when initializing ObjectDetector: AllocateTensors() failed.

입니다.

private fun runObjectDetection(bitmap: Bitmap) {

// Step 1: Create TFLite's TensorImage object

val image = TensorImage.fromBitmap(bitmap)

// Step 2: Initialize the detector object

val options = ObjectDetector.ObjectDetectorOptions.builder()

.setMaxResults(1)

.setScoreThreshold(0.1f)

.build()

val detector = ObjectDetector.createFromFileAndOptions(

this,

"best-fp16-2.tflite",

options

)

// Step 3: Feed given image to the detector

val results = detector.detect(image)

}