- 아래 답변은 OpenAI의 GPT-3.5(ChatGPT) 모델로 자동 생성한 것으로, 정확하지 않을 수 있습니다.

- 잘못된 답변을 보셨다면 댓글로 첨삭 지도 부탁드립니다.

안녕하세요 Minwoo_Ju님,

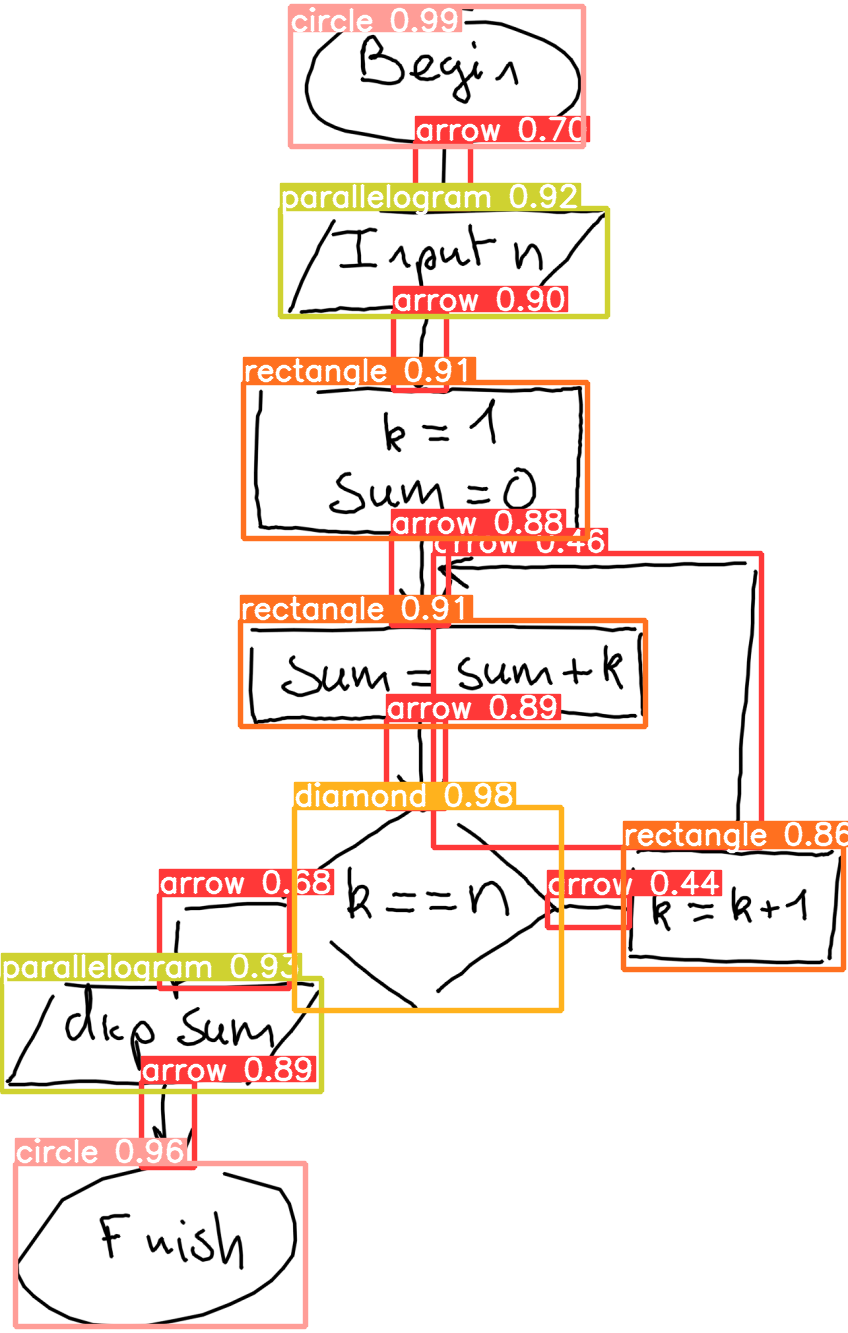

손으로 그린 다이어그램의 화살표가 가리키는 것을 학습시키는 방법에 대해 궁금하신 것 같습니다. 또한, 이미지 내 객체 인식에는 yolov8을 사용하여 성공하셨다고 합니다.

화살표가 이어주는 도형이 무엇인지 학습시키고 싶으시다면, 객체 감지 모델을 사용하여 화살표와 이어주는 도형을 인식하고, 이를 학습시키는 방법을 고민하고 계신 것 같습니다. 하지만, 기존의 객체 감지나 이미지 분할 기법으로는 화살표와 이어주는 도형을 직접 학습시키는 것은 어려울 수 있습니다.

이러한 경우에는 다른 방법을 고려해볼 수 있습니다. 예를 들어, 화살표와 이어주는 도형의 관계를 학습시킬 수 있는 데이터셋을 수집하고, 이를 기반으로 모델을 학습시킬 수 있습니다. 데이터셋을 구성할 때는 화살표와 이어주는 도형의 관계를 명확하게 표현하는 레이블을 추가해야 합니다. 예를 들어, "arrow1: from a to b"와 같은 형식으로 레이블을 지정할 수 있습니다.

이후에는 이러한 데이터셋을 사용하여 모델을 학습시킬 수 있습니다. 예를 들어, PyTorch의 torchvision 패키지를 사용하여 데이터셋을 로드하고, 모델을 정의하고, 손실 함수를 정의한 후에 학습을 진행할 수 있습니다. 학습된 모델은 화살표와 이어주는 도형의 관계를 예측할 수 있게 될 것입니다.

아래는 예시 코드입니다. 이 코드는 torchvision 패키지의 CIFAR-10 데이터셋을 사용하여 모델을 학습시키는 예시입니다. 이 코드를 참고하여 데이터셋과 모델을 적절히 수정하여 화살표와 이어주는 도형의 관계를 학습시킬 수 있습니다.

import torch

import torch.nn as nn

import torch.optim as optim

import torchvision

import torchvision.transforms as transforms

# 데이터셋 로드

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))])

trainset = torchvision.datasets.CIFAR10(root='./data', train=True,

download=True, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=4,

shuffle=True, num_workers=2)

# 모델 정의

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(3, 6, 5)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(6, 16, 5)

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = x.view(-1, 16 * 5 * 5)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

net = Net()

# 손실 함수와 최적화 함수 정의

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(net.parameters(), lr=0.001, momentum=0.9)

# 모델 학습

for epoch in range(2): # 데이터셋을 여러 번 반복합니다.

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

# 입력 데이터 가져오기

inputs, labels = data

# 변화도(Gradient) 매개변수를 0으로 만들고

optimizer.zero_grad()

# 순전파 + 역전파 + 최적화

outputs = net(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

# 통계 출력

running_loss += loss.item()

if i % 2000 == 1999: # 미니배치 단위로 누적 손실 출력

print('[%d, %5d] loss: %.3f' %

(epoch + 1, i + 1, running_loss / 2000))

running_loss = 0.0

print('학습이 완료되었습니다.')

이 코드는 CIFAR-10 데이터셋을 사용하여 모델을 학습시키는 예시입니다. 화살표와 이어주는 도형의 관계를 학습시키기 위해서는 이 코드를 수정하여 데이터셋을 구성하고, 모델을 정의해야 합니다.

더 자세한 내용은 PyTorch 공식 튜토리얼(Welcome to PyTorch Tutorials — PyTorch Tutorials 2.6.0+cu124 documentation)을 참고하시면 도움이 될 것입니다. 특히, "PyTorch로 시작하기"와 "전이 학습 튜토리얼"을 참고하시면 객체 감지와 관련된 내용을 더 자세히 알 수 있습니다.

이 답변이 도움이 되었는지 확인해주세요. 추가로 궁금한 점이 있다면 언제든지 질문해주세요. 감사합니다!

- 답변이 어떠셨나요? 괜찮았다고 생각하신다면 아래

를 한 번 눌러주시길 부탁드려요!

를 한 번 눌러주시길 부탁드려요!