GLM-4.7 소개

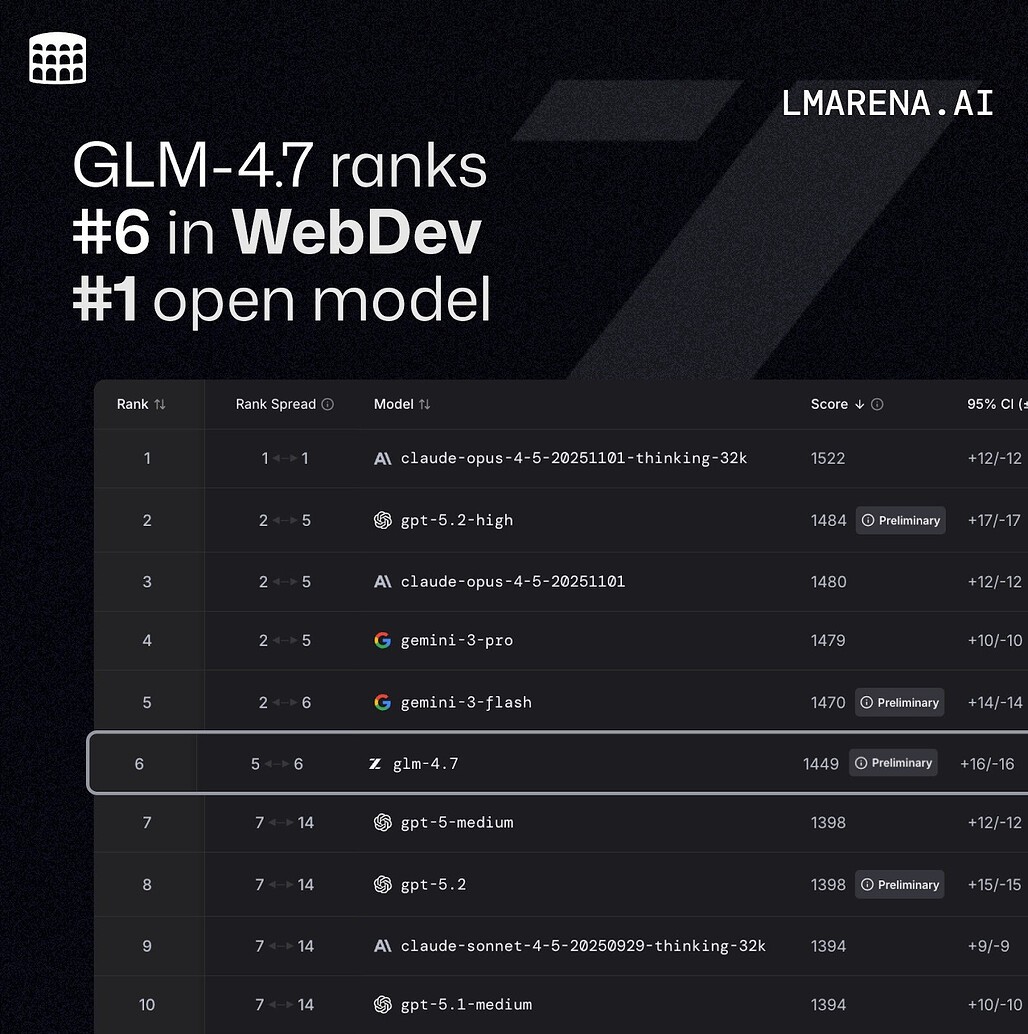

GLM-4.7은 Zhipu AI(Z.AI)가 최근 공개한 최신 오픈소스 플래그십 LLM(Large Language Model)입니다. 이 모델은 코딩, 추론, 그리고 에이전트(Agent) 실행 능력에서 비약적인 성능 향상을 이루었으며, 실제 소프트웨어 개발 워크플로우와 도구 기반 작업에서 업계 최고 수준의 성능을 제공하는 것을 목표로 합니다. 특히 Claude Code, Roo Code와 같은 에이전트 프레임워크와의 통합을 염두에 두고 설계되어, 복잡한 다단계 작업을 안정적으로 수행할 수 있는 "Think before act(행동 전 사고)" 메커니즘을 갖추고 있습니다.

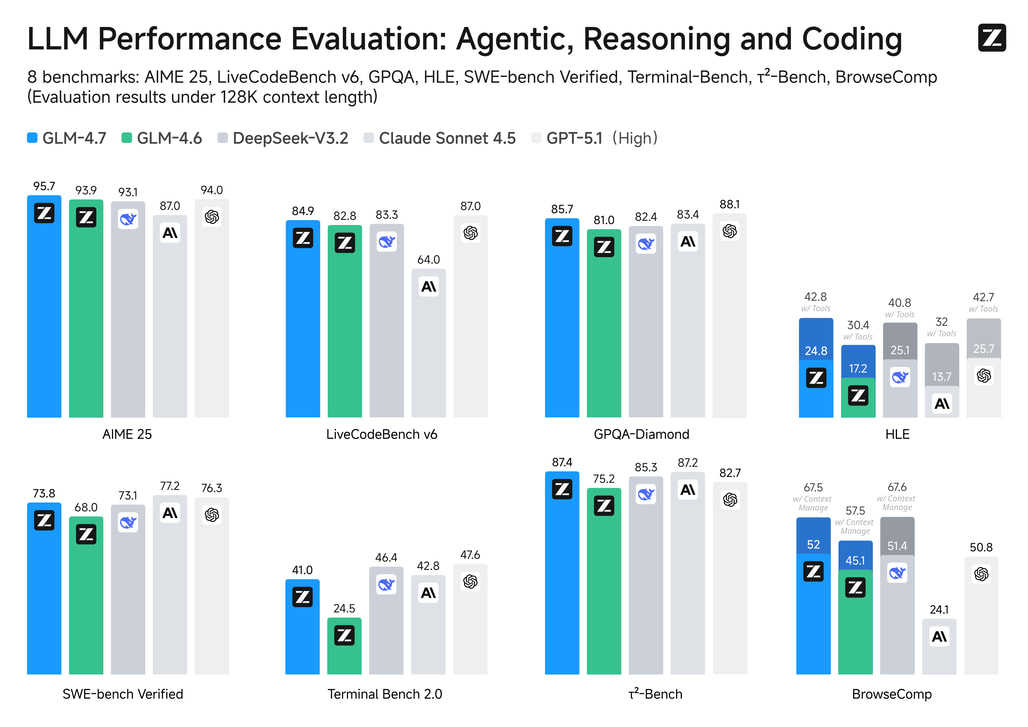

이 모델은 기존 버전 대비 UI/UX 생성 능력이 크게 강화되어, "Vibe Coding"이라 불리는 고품질의 프론트엔드 결과물을 생성할 수 있습니다. 예를 들어, 웹페이지의 레이아웃, 색상 조화, 컴포넌트 스타일링이 더욱 세련되게 생성되며, PPT(16:9 비율) 레이아웃 정확도가 91%까지 향상되어 생성 즉시 실무에 사용할 수 있는 수준을 보여줍니다. 또한, HLE(Humanity's Last Exam) 벤치마크에서 42.8%를 기록하며 수학적, 논리적 추론 능력에서도 괄목할 만한 성과를 입증했습니다.

GLM-4.7은 개발자들에게 더욱 유연한 제어권을 제공하기 위해 세 가지의 새로운 사고(Thinking) 모드를 도입했습니다. 이를 통해 단순한 질의응답부터 복잡한 장기 에이전트 작업까지 비용과 성능의 균형을 맞추며 최적화된 결과를 얻을 수 있습니다. vLLM, SGLang과 같은 고성능 추론 프레임워크를 공식 지원하여 로컬 및 클라우드 환경에서의 배포 용이성도 확보했습니다.

GLM-4.6 및 타 모델과 비교

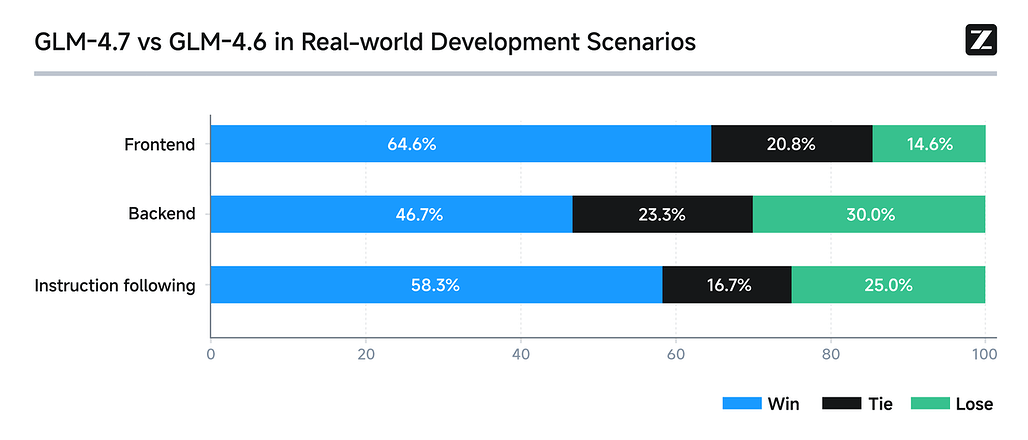

GLM-4.7은 이전 버전인 GLM-4.6 및 동급의 타사 모델들과 비교했을 때 다음과 같은 뚜렷한 성능 향상을 보입니다.

-

코딩 성능 (SWE-bench Verified): GLM-4.7은 73.8%를 기록하여 GLM-4.6 대비 5.8% 향상되었으며, 이는 오픈소스 SOTA(State-of-the-Art)에 해당합니다. 다국어 코딩 벤치마크인 SWE-bench Multilingual에서도 66.7%를 기록하며 큰 폭의 성장(+12.9%)을 보였습니다.

-

추론 능력 (HLE Benchmark): 수학 및 논리적 추론 능력을 측정하는 HLE에서 42.8%를 기록했습니다. 이는 GLM-4.6(30.4%) 대비 41% 가까이 향상된 수치이며, 도구 사용(Tool Use) 능력이 결합되었을 때 더욱 강력한 성능을 발휘합니다.

-

경쟁 모델 비교: 여러 주요 벤치마크(LiveCodeBench v6 등)에서 Claude Sonnet 4.5와 대등하거나 일부 항목에서는 더 높은 점수를 기록했습니다. 특히 에이전트 기반의 도구 사용(Tool Use) 평가인 τ²-Bench에서는 87.4%를 기록하며 Claude Sonnet 4.5를 상회하는 결과를 보여주었습니다.

GLM-4.7의 핵심 기능 및 기술적 특징

진보된 사고 능력 (Advanced Thinking Modes)

GLM-4.7은 복잡한 작업을 더욱 안정적으로 수행하기 위해 세분화된 세 가지 추론 모드를 제공합니다.

-

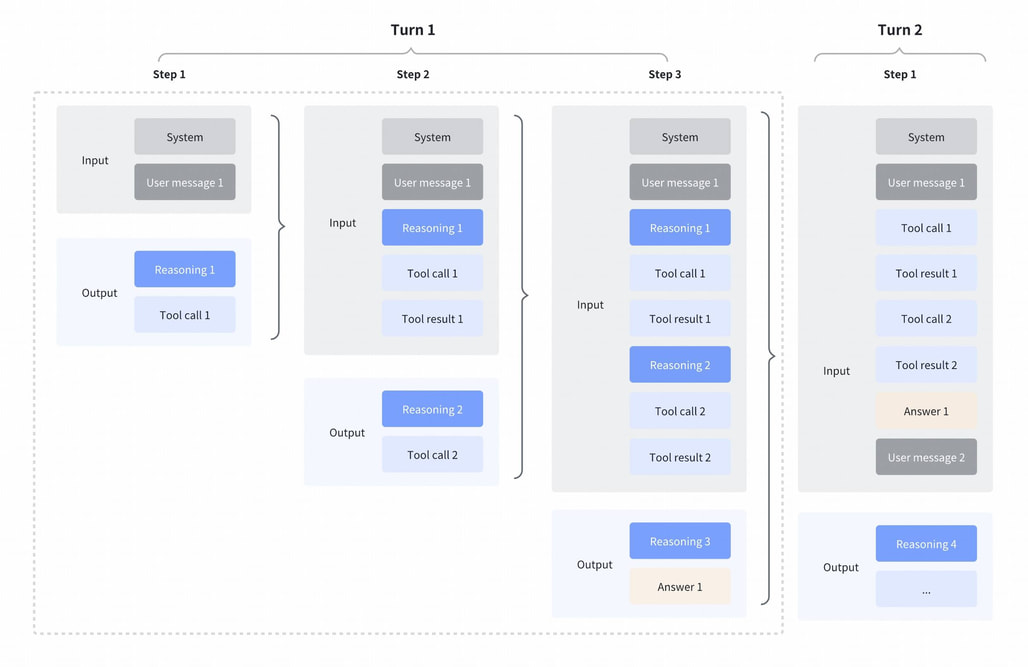

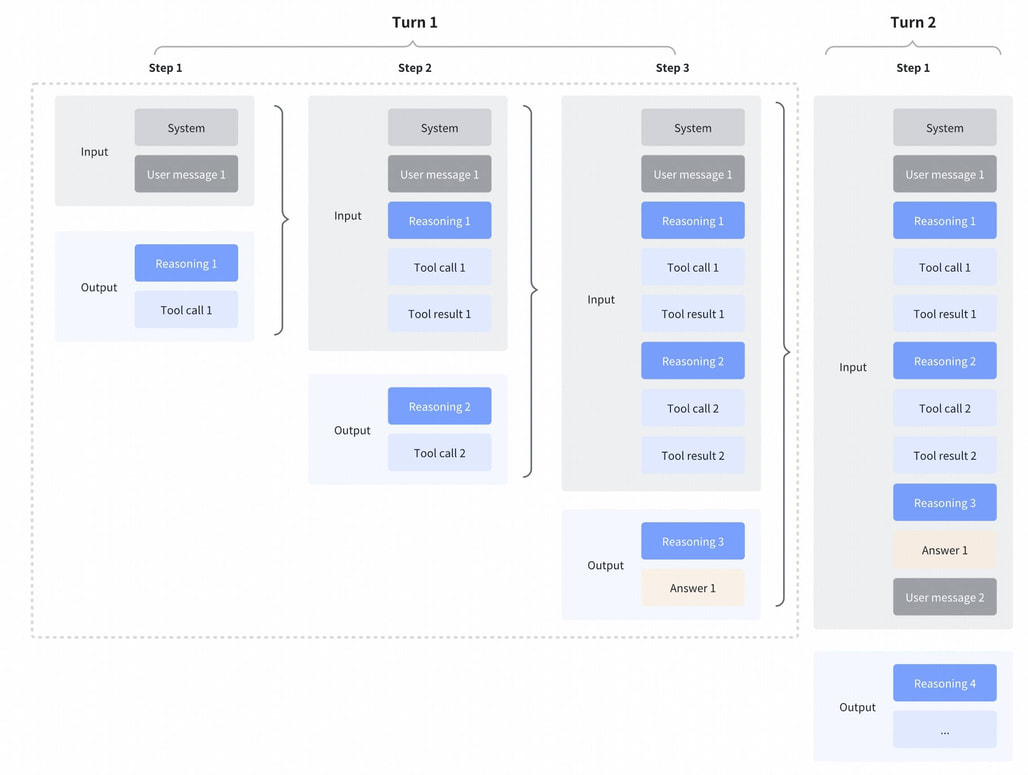

교차 사고(Interleaved Thinking): 모델이 답변을 생성하거나 도구(Tool)를 호출하기 직전에 반드시 추론 과정을 거칩니다. 이를 통해 지시 사항을 더 정확히 준수하고, 코드 생성의 논리적 오류를 사전에 방지합니다.

-

보존 사고(Preserved Thinking): 다중 턴(Multi-turn) 대화에서 이전 턴의 추론 블록(Thinking Block)을 자동으로 유지합니다. 긴 호흡의 코딩 작업 시 매번 처음부터 다시 추론할 필요 없이 이전의 맥락을 이어가므로, 정보 손실을 줄이고 일관성을 유지하는 데 탁월합니다.

-

턴 단위 제어(Turn-level Thinking): 개발자가 각 대화 턴마다 추론의 깊이를 제어할 수 있습니다. 단순한 포매팅 작업에는 추론을 비활성화하여 비용과 지연 시간(Latency)을 줄이고, 복잡한 로직 설계 시에는 활성화하여 정확도를 높이는 유연한 운용이 가능합니다.

GLM-4.7의 사고 모드에 대한 상세한 내용은 관련 문서를 참고해주세요:

강력한 코딩 및 에이전트 통합 (Agentic Coding)

GLM-4.7은 Claude Code , Cline , Roo Code , Kilo Code 와 같은 주류 코딩 에이전트 프레임워크와 원활하게 연동됩니다.

- Z.AI 플랫폼 통합: Z.AI의 API는 Anthropic API와 호환되는 엔드포인트를 제공하여, 기존 Claude Code 환경에서 코드 수정 없이 모델만 GLM-4.7로 교체하여 사용할 수 있습니다.

- 터미널 및 다단계 작업: 터미널 명령 실행 및 다단계 계획 수립 능력이 강화되어, 요구사항 분석부터 프로덕션 수준의 코드 출력까지 엔드투엔드(End-to-End) 작업 수행이 가능합니다.

Vibe Coding 및 UI/UX 생성

GLM-4.7은 단순한 코드 생성을 넘어, 시각적으로 완성도 높은 결과물을 만들어내는 능력 또한 검증되었습니다:

웹페이지 및 문서: 더 깔끔하고 현대적인 웹페이지 디자인을 생성하며, 슬라이드나 포스터 디자인 시 타이포그래피와 색상 배치를 전문가 수준으로 수행합니다.

PPT 생성: 16:9 비율의 프레젠테이션 레이아웃 정확도가 기존 52%에서 91%로 급상승했습니다.

API 및 배포 (Deployment)

- 프레임워크 지원: vLLM 및 SGLang의 메인 브랜치에서 GLM-4.7 추론을 지원하며, 공식 Docker 이미지를 통해 쉽게 로컬에 배포할 수 있습니다.

- 컨텍스트 윈도우: 기본 128K 컨텍스트를 지원하며, 긴 문서나 복잡한 코드베이스를 한 번에 처리할 수 있습니다.

GLM-4.7 소개 블로그

GLM-4.7 소개 블로그

GLM-4.7 소개 문서

GLM-4.7 소개 문서

GLM-4 모델군의 GitHub 저장소

GLM-4 모델군의 GitHub 저장소

https://github.com/zai-org/GLM-4

GLM-4.7 모델 다운로드

GLM-4.7 모델 다운로드

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()