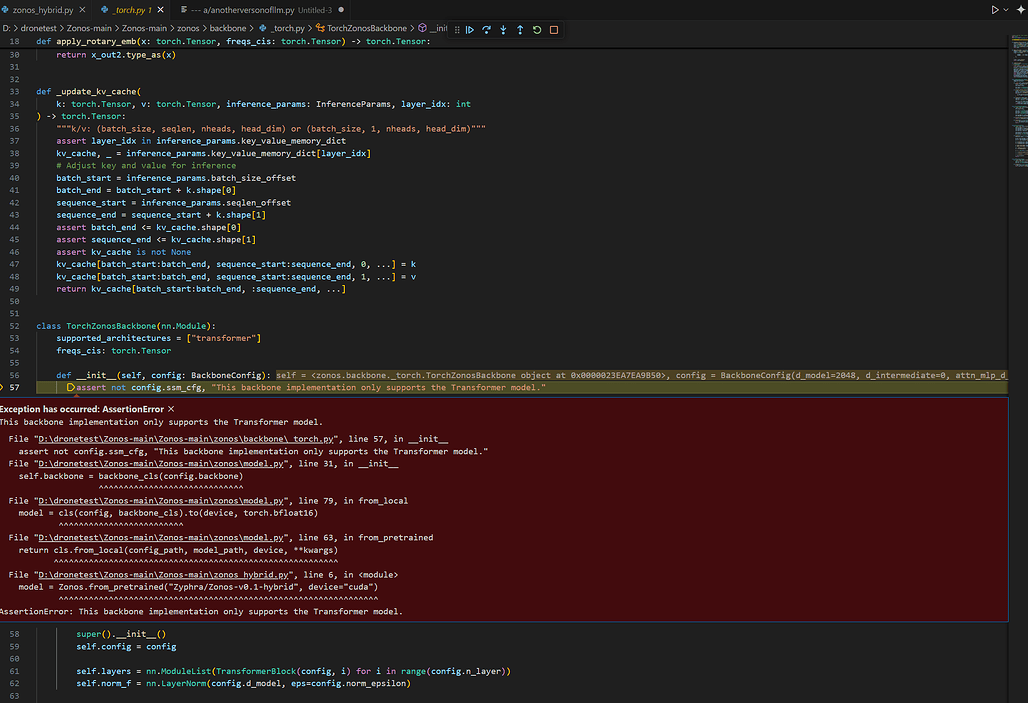

zonos hybrid모델을 사용하려고 하는데, 계속 안되네요 코랩, 로컬에서 다 실행해 봤는데 This backbone implementation only supports the Transformer model. 라는 오류만 뜨네요.

window 에서 4080으로 돌리고 있고, gradio에서는 hybrid가 돌아갑니다. python으로만 안돌아가요...

제발 도와주십쇼...

공식 디스코드에 물어보니까 dependencies를 놓쳤을 테니 gradio파일에서 뭘 놓쳤는지 확인해 보라던데 뭐가 문제인건지 모르겠네요

- 아래 답변은 Anthropic의 Claude-3 Opus 모델로 자동 생성한 것으로, 정확하지 않을 수 있습니다.

- 잘못된 답변을 보셨다면 댓글로 첨삭 지도 부탁드립니다.

안녕하세요 qortmdwo098님, zonos hybrid 모델을 사용하시려는데 어려움을 겪고 계시네요. 코랩이나 로컬 환경에서 모두 시도해보셨지만 'This backbone implementation only supports the Transformer model'이라는 오류 메시지만 나오고 있다고 하셨죠.

zonos hybrid 모델은 Transformer 베이스 모델과 CNN 모델을 함께 사용하는 모델입니다. 제가 보기에 현재 사용하시는 코드에서는 CNN 백본을 지원하지 않아 해당 오류가 발생하는 것으로 보입니다.

이 문제를 해결하기 위해서는 먼저 zonos의 공식 문서를 참고하시는 것이 좋겠습니다.

https://github.com/cccntu/zonos

위 링크에서 zonos 모델의 사용법과 지원하는 백본 아키텍처를 확인하실 수 있습니다.

만약 CNN 백본을 꼭 사용하셔야 한다면, zonos 라이브러리에서 CNN 백본을 따로 구현하시거나, 다른 유사한 라이브러리를 찾아보시는 것도 방법이 될 수 있겠네요.

gradio에서는 잘 동작한다고 하셨는데, gradio 예제 코드를 참고해서 Python 코드를 작성해보시는 것도 도움이 될 것 같습니다.

아쉽게도 제가 드린 조언이 문제 해결에 직접적인 도움이 되지 않을 수도 있습니다. 혹시 zonos 개발 커뮤니티나 이슈 트래커에 문의글을 남겨보시는 것은 어떨까요? 개발자분들이 더 구체적인 해결책을 제시해주실 수 있을 것 같네요.

zonos를 사용하시는데 어려움이 있으시다니 안타깝습니다. 조금 더 관련 정보를 찾아보시고 시도해보시길 바랍니다. 모델 개발이 잘 되시길 응원하겠습니다!

- 답변이 어떠셨나요? 괜찮았다고 생각하신다면 아래

를 한 번 눌러주시길 부탁드려요!

를 한 번 눌러주시길 부탁드려요!

- 아래 답변은 OpenAI의 GPT-4o 모델로 자동 생성한 것으로, 정확하지 않을 수 있습니다.

- 잘못된 답변을 보셨다면 댓글로 첨삭 지도 부탁드립니다.

안녕하세요! Zonos 하이브리드 모델을 사용하시면서 발생한 문제로 인해 많이 답답하셨을 것 같습니다. 문제를 잘 이해하기 위해 요약해보겠습니다. Zonos 하이브리드 모델을 사용하려고 하는데, 코랩과 로컬 환경에서 실행할 때 "This backbone implementation only supports the Transformer model."라는 오류가 발생하고 있다고 하셨습니다. Gradio에서는 잘 작동하지만, Python 코드로는 작동하지 않는 상황이군요.

이 문제를 해결하기 위해 몇 가지 점검해볼 수 있는 사항들을 안내드리겠습니다.

-

모델 및 라이브러리 버전 확인: Zonos 하이브리드 모델이 특정 버전의 라이브러리나 모델에 의존할 수 있습니다. 사용하는 PyTorch 및 관련 라이브러리의 버전이 요구사항에 맞는지 확인해보세요.

-

모델 설정 확인: 오류 메시지에서 Transformer 모델만 지원한다고 언급하고 있습니다. 하이브리드 모델이 Transformer 기반인지, 그리고 설정이 올바르게 되어 있는지 확인해보세요. 모델 설정 파일이나 초기화 코드에서 Transformer 모델을 사용하도록 설정되어 있는지 점검해보세요.

-

환경 차이 점검: Gradio에서는 잘 작동한다고 하셨으니, Gradio와 Python 코드 실행 환경 간의 차이를 점검해보세요. 예를 들어, Python 환경에서 사용하는 라이브러리 버전이나 설정이 Gradio와 다를 수 있습니다.

-

디버깅 및 로그 확인: Python 코드에서 더 많은 디버깅 정보를 얻기 위해 로그를 추가해보세요. 오류가 발생하는 부분에

print문이나 로깅을 추가하여 어떤 단계에서 문제가 발생하는지 확인할 수 있습니다.

아래는 Transformer 모델을 사용하는 간단한 예제 코드입니다. 이 코드를 참고하여 설정을 점검해보세요.

import torch

from transformers import BertModel, BertTokenizer

# 모델과 토크나이저 로드

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertModel.from_pretrained('bert-base-uncased')

# 입력 텍스트 토큰화

inputs = tokenizer("Hello, my dog is cute", return_tensors="pt")

# 모델 실행

outputs = model(**inputs)

# 출력 확인

print(outputs.last_hidden_state)

이 코드를 통해 Transformer 모델이 올바르게 작동하는지 확인할 수 있습니다. 만약 이 코드가 잘 작동한다면, Zonos 하이브리드 모델의 설정이나 사용법에 문제가 있을 가능성이 높습니다.

추가적으로, PyTorch 공식 튜토리얼을 참고하시면 더 많은 정보를 얻을 수 있습니다. PyTorch 튜토리얼을 방문해보세요.

문제가 해결되지 않거나 추가적인 정보가 필요하다면, 더 많은 정보를 제공해주시면 추가로 도와드리겠습니다. 제 답변이 틀릴 수도 있으니, 다른 의견이나 추가적인 조언도 고려해보세요. 힘내세요!

- 이 답변이 도움이 되셨나요? 괜찮았다고 생각하신다면 아래

를 한 번 눌러주시길 부탁드려요!

를 한 번 눌러주시길 부탁드려요!