9bow

(박정환)

1

GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다.

소개

- 현재까지 가장 강력한 언어 모델

- 7.3B 파라미터 모델로, 모든 벤치마크에서 Llama 2 13B를, 많은 벤치마크에서는 Llama 1 34B를 능가

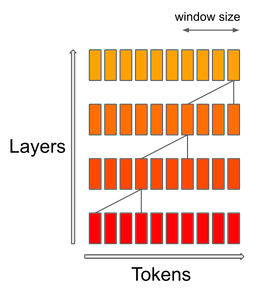

- 더 빠른 추론을 위한 Grouped-query attention (GQA)과 더 작은 비용으로 더 긴 시퀀스를 처리하기 위한 Sliding Window Attention (SWA)를 사용

- Apache 2.0 라이선스로, 제한 없이 사용 가능

- 어떤 클라우드(AWS/GCP/Azure)에서도 vLLM 추론 서버와 skypilot를 사용하여 배포할 수 있으며, HuggingFace에서도 사용할 수 있음

- 쉽게 미세 조정할 수 있으며, 채팅용으로 미세 조정된 모델은 Llama 2 13B 채팅을 능가

- Mistral, Meta와 DeciLM과 달리 이 클래스의 모델에 Apache 라이선스를 부여한 첫 회사입니다.

- 이 모델은 MacBook Air M1에서 잘 작동하며 GPT3.5와 비교할 수 있습니다.

- JSON과 같은 구조화된 데이터를 처리하기 위한 "함수 호출 API"의 사용 가능성에 대한 질문이 있습니다.

- 모델 훈련에 사용된 데이터셋에 대한 우려와 벤치마크 유출이 결과를 부풀릴 가능성이 제기되었습니다.

- 모델의 발표는 Twitter의 토렌트 트래커 URI를 통해 이루어졌습니다.

- LLMs를 위한 코딩 보조 도구 테스트에서 Mistral이 CodeLlama와 GPT4만큼 잘 수행하지 못했습니다.

- 모델은 llama.cpp에 의해 지원되기 때문에 macOS의 FreeChat에서 작동합니다.

- 프로젝트가 왜 7B 모델과 같은 큰 버킷 내에서 특정 파라미터 크기로 표준화하는 것처럼 보이는지에 대한 질문이 있습니다.

- 모델의 훈련에 대한 세부 정보, 그것이 기반한 데이터와 어디에서 훈련되었는지에 대한 요청이 있습니다.

- 훈련 세트에서 벤치마크 오염에 대한 테스트를 요청하는 것이 있습니다.

원문

9bow

(박정환)

2

- 이 글은 OpenAI의 GPT-4로 자동 요약하여, 잘못된 내용이 있을 수 있으니 원문을 참고해주세요!

- 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다!

소개

- Mistral AI 팀은 지금까지 가장 강력한 언어 모델인 Mistral 7B를 출시하게 되어 자랑스럽게 생각합니다.

- 이 모델은 Apache 2.0 라이선스 하에 출시되었으며, 제한 없이 사용할 수 있습니다.

주요 내용

-

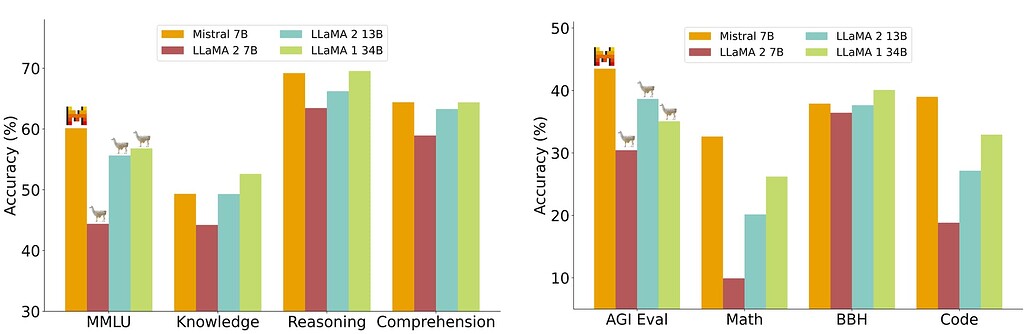

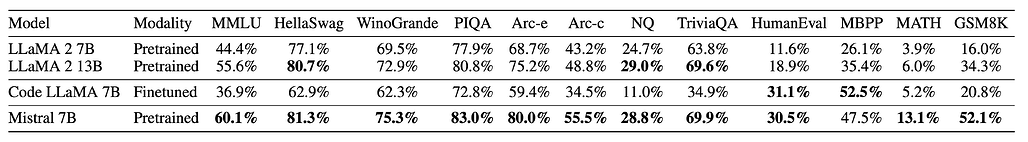

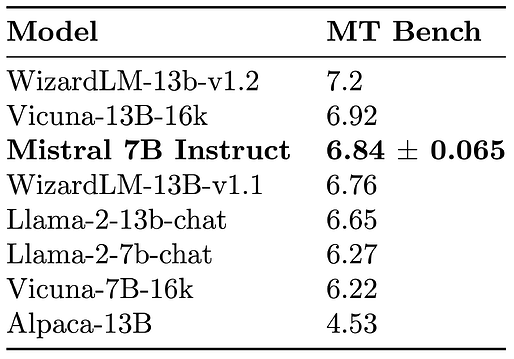

Mistral 7B 간략 소개: Mistral 7B는 7.3B 파라미터 모델로, 다양한 벤치마크에서 Llama 2 13B와 Llama 1 34B를 능가합니다. 특히 코드 작업에서는 CodeLlama 7B의 성능에 근접하면서도 영어 작업에서도 뛰어난 성능을 보입니다.

-

성능 상세: Mistral 7B는 Llama 2 모델 가족과 비교되었으며, 공정한 비교를 위해 모든 모델 평가를 재실행하였습니다. Mistral 7B는 모든 지표에서 Llama 2 13B를 크게 능가하며, Llama 34B와 동등한 성능을 보입니다.

-

주의사항: 우리의 평가와 LLaMA2 논문의 평가 사이에는 중요한 차이점이 있습니다. 예를 들어, MBPP에 대해 우리는 수동으로 검증된 하위 집합을 사용하고 있습니다.

-

Sliding Window Attention: Mistral 7B는 슬라이딩 윈도우 주의 (SWA) 메커니즘을 사용하며, 이는 각 레이어가 이전의 4,096 히든 상태에 주의를 기울이는 방식입니다.

-

Fine-tuning Mistral 7B for chat: Mistral 7B의 일반화 능력을 보여주기 위해, 우리는 HuggingFace에서 공개적으로 사용 가능한 지시 데이터셋에서 미세 조정을 수행하였습니다.

더 읽어보기

Sliding Window Attention(SWA) 메커니즘에 대한 설명 논문 2편

- Mistral 7B에서 사용된 어텐션 메커니즘에 대한 추가 정보를 제공합니다.

https://github.com/Dao-AILab/flash-attention

- Mistral 7B의 성능을 평가하기 위해 사용된 벤치마크에 대한 자세한 정보를 제공합니다.

원문

Mistral AI의 블로그 글

Mistral 7B 가중치 다운로드

https://files.mistral-7b-v0-1.mistral.ai/mistral-7B-v0.1.tar

Mistral 7B 모델 코드 등

Mistral 7B LLM 문서 / 빠른 시작

https://docs.mistral.ai/quickstart/

HuggingFace에서 보기

HuggingFace에서 보기

![]()