9bow

(박정환)

1

GeekNews의 xguru님께 허락을 받고 GN에 올라온 글들 중에 AI 관련된 소식들을 공유하고 있습니다.

소개

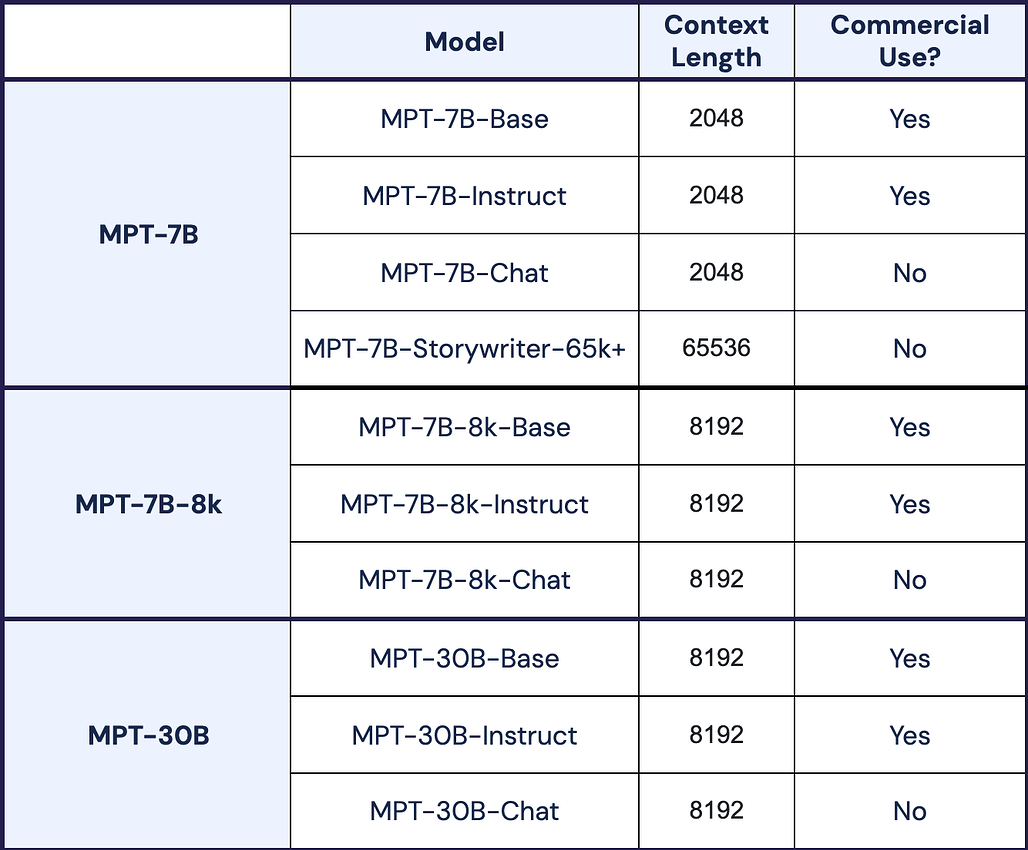

- 8k 컨텍스트 길이를 지원하는 7B 파라미터 오픈소스 LLM

- MPT-7B에 추가로 500B 토큰 데이터를 이용해 256개의 NVidia H100 으로 3일간 트레이닝

- 3개의 모델을 공개 : MPT-7B-8k, MPT-7B-8k-Instruct, MPT-7B-8k-Chat

- 상업적 용도로 사용 가능

- ALiBi(Attention with Linear Biases Enables Input Length Extrapolation) 로 8k 입력 지원

- FlashAttention 과 FasterTrasformer 로 빠른 훈련과 추론

원문

https://www.mosaicml.com/blog/long-context-mpt-7b-8k

더 읽어보기

![]()