Kimi-K2 모델 소개

최근 중국의 Moonshot AI가 공개한 Kimi-K2는 오픈소스 언어모델 분야에서 가장 주목할 만한 진보 중 하나로 평가받고 있습니다. 이 모델은 총 1조 개의 파라미터를 갖춘 대규모 MoE(Mixture-of-Experts) 구조 기반으로, 활성 파라미터는 320억 개에 이릅니다. 특히, 긴 문맥을 이해하는 능력과 에이전트 지향의 문제 해결 기능을 갖추고 있어 일반 챗봇을 넘는 다양한 응용 가능성을 보여주고 있습니다.

Moonshot AI는 기존의 Kimi 모델을 통해 수십만 토큰 규모의 컨텍스트 길이를 실현한 바 있으며, Kimi-K2는 이를 더 발전시켜 에이전트형 태스크, 도구 호출, 자동화된 사고 및 코드 생성 분야에서 경쟁 모델보다 뛰어난 성능을 보여줍니다. 실제로 SWE-bench Verified와 같은 고난도 벤치마크에서 오픈소스 모델 중 세계 최고 성능을 달성했으며, 이는 GPT-4.1, Claude Opus 등 상용 대형모델들과도 어깨를 나란히 합니다.

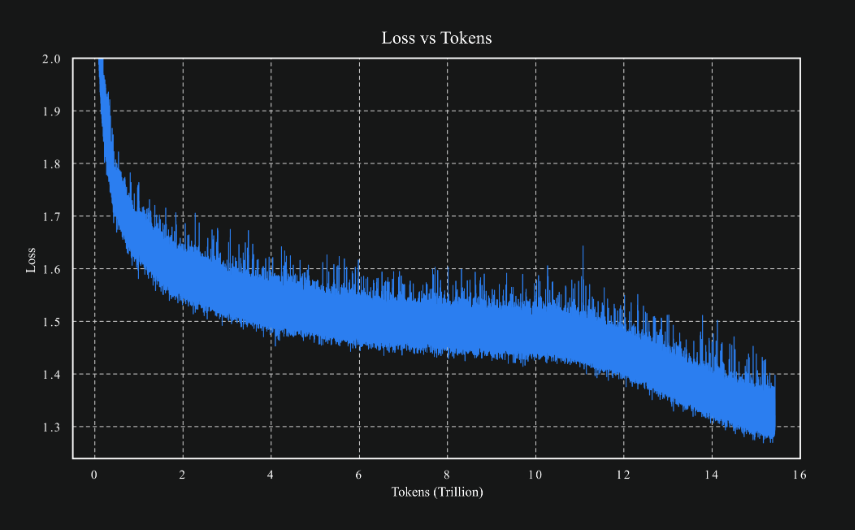

또한 Kimi-K2는 MuonClip이라는 고유의 옵티마이저를 기반으로 15.5조 개의 토큰을 안정적으로 학습하였으며, AI 연구자 및 개발자를 위한 Base, 일반 사용자 및 API 연동을 위한 Instruct 버전으로 나누어 제공됩니다:

-

Kimi-K2-Base: 연구자와 모델 개발자들이 커스터마이징이나 파인튜닝에 적합한 베이스 버전입니다. 추론 최적화나 도구 사용 기능은 탑재되어 있지 않으며, 기초 언어 모델링 용도에 활용됩니다.

-

Kimi-K2-Instruct: Instruct 버전은 미리 파인튜닝이 완료된 상태로, 일반적인 대화형 챗봇 혹은 LLM 기반 API 서비스에 바로 사용할 수 있습니다. 특히 Reflex-style 응답이 특징으로, ‘생각 후 말하기’보다는 즉각적이고 명확한 응답에 초점을 맞췄습니다.

Kimi-K2 모델 구조 및 구성

Kimi-K2는 MoE(Mixture-of-Experts) 기반 언어모델로, 1조(1T) 개의 총 파라미터 중 320억 개의 전문가 파라미터만 활성화되어 연산 효율성과 성능을 모두 잡는 구조입니다. MoE 구조는 입력 토큰마다 가장 적절한 전문가 8개만 활성화하도록 하여 전체 계산량을 줄이면서도 뛰어난 표현력을 유지할 수 있도록 설계되어 있습니다.

Kimi-K2 모델의 주요 하드웨어 구성 및 하이퍼파라미터는 다음과 같습니다:

- 총 파라미터: 1조(1Trillion)

- 활성화 파라미터: 32B

- 전체 레이어 수: 61 (Dense 레이어 1개 포함)

- Expert 수: 384개

- 토큰당 활성 Expert: 8개

- Attention Hidden Size: 7168

- MoE Hidden Size (Expert 단위): 2048

- Attention Head: 64개

- 컨텍스트 길이: 최대 128K

- 어텐션 메커니즘: MLA(Multi-Level Attention)

- 활성화 함수: SwiGLU

- Vocabulary 크기: 160,000

이러한 구조는 긴 문맥에서의 정확한 추론과 학습 안정성을 보장하며, 동시에 도구 호출과 같은 에이전트 기능에도 최적화되어 있습니다.

또한, Kimi-K2 모델은 단순히 언어를 생성하는 기능을 넘어, 도구를 사용하고 문제를 스스로 해결할 수 있는 에이전트형 인공지능(Agentic Intelligence)을 구현하기 위해 개발된 것이 특징입니다. 특히 “Open Agentic Intelligence”라는 슬로건은 이 철학을 가장 잘 담고 있으며, 이를 실현하기 위한 핵심 기술로는 MuonClip Optimizer와 강화된 Agentic Capabilities 설계가 포함되어 있습니다.

각각의 개념 및 기술은 다음과 같습니다:

Open Agentic Intelligence

Moonshot AI가 말하는 Open Agentic Intelligence는 전통적인 “응답형 LLM”에서 한 단계 진화한 개념으로, 인간의 지시를 ‘이해하고’, ‘계획하고’, ‘외부 도구를 사용해 실행’하며, 결과를 바탕으로 추가 사고를 전개하는 능력을 갖춘 인공지능을 의미합니다. 이 개념은 단순한 질문-응답 패턴을 넘어서, LLM이 에이전트처럼 자율적인 행위자(agent) 로 기능하도록 설계되었음을 강조합니다.

특히 오픈소스 생태계에서 이러한 능력을 가진 모델은 극히 드물며, 대부분 상용 모델(GPT-4, Claude 등)에서만 제한적으로 제공되던 기능입니다. Kimi-K2는 이와 같은 고급 AI 행위를 오픈소스로 제공한다는 점에서 “Open Agentic Intelligence”라는 명칭을 붙였습니다. 구체적으로는 다음과 같은 기능을 목표로 합니다:

- 도구 사용(tool calling) 및 자동 API 호출

- 작업 분해 및 계획 수립(task decomposition)

- 코드 생성 및 디버깅

- 연속적 사고 및 단계별 실행

- 멀티모달 연계 처리 (향후 확장 계획 포함)

MuonClip Optimizer: 초대형 MoE 학습을 위한 최적화 엔진

Kimi-K2는 총 1조 파라미터를 가진 Mixture-of-Experts(MoE) 구조를 안정적으로 학습하기 위해 자체 개발한 Muon 옵티마이저를 사용합니다. 이 옵티마이저는 기존 AdamW나 Lion 등과는 다른 방식으로 대규모 모델에서 발생하는 학습 불안정성(Instability) 문제를 해결하도록 설계되었습니다.

MuoonClip Optimizer의 주요 특징은 다음과 같습니다:

- Gradient Clipping 최적화: ‘MuonClip’이라는 이름은 아마도 gradient clipping의 새로운 형태 혹은 변형을 나타내는 것으로, 스케일 큰 모델에서 폭발하거나 소멸하는 gradient를 안정적으로 조절합니다.

- 안정적 확장성: 기존 옵티마이저들이 수천억 단위 파라미터까지는 견디지만, 1조 파라미터 규모에서는 학습률 설정이나 gradient scaling에 민감하게 반응해 학습이 중단되거나 수렴하지 않는 문제가 발생할 수 있습니다. Muon은 이런 확장 문제를 해결합니다.

- Zero Instability 학습 실현: 공식 발표에 따르면, 15.5조 토큰을 사용하는 프리트레이닝 과정에서 학습 중단 없이 안정적으로 수렴하는 성능을 달성했습니다.

Moonshot AI는 이 옵티마이저를 오픈소스로 공개하지는 않았지만, 논문 혹은 기술 보고서를 통해 향후 메커니즘을 상세히 공개할 가능성이 있습니다.

Agentic Capabilities: 도구 사용을 위한 대규모 데이터 합성과 일반 강화학습

Kimi-K2는 단순한 언어 생성 기능을 넘어, 사용자의 요청을 스스로 해석하고, 적절한 도구를 선택하여 실행하며, 이를 통해 복잡한 문제를 해결할 수 있는 능동적 인공지능, 즉 에이전트형 인공지능(Agentic Intelligence) 의 구현을 목표로 개발되었습니다. 이러한 목표를 실현하기 위해 Moonshot AI는 두 가지 핵심적인 전략을 적용하였습니다. 첫 번째는 다양한 도메인에 걸쳐 도구 사용을 학습하기 위한 대규모 합성 데이터(Large-Scale Agentic Data Synthesis) 생성이며, 두 번째는 명시적인 정답이 존재하지 않는 작업에서도 스스로 성능을 향상시킬 수 있도록 설계된 일반화된 강화 학습(General Reinforcement Learning) 접근입니다.

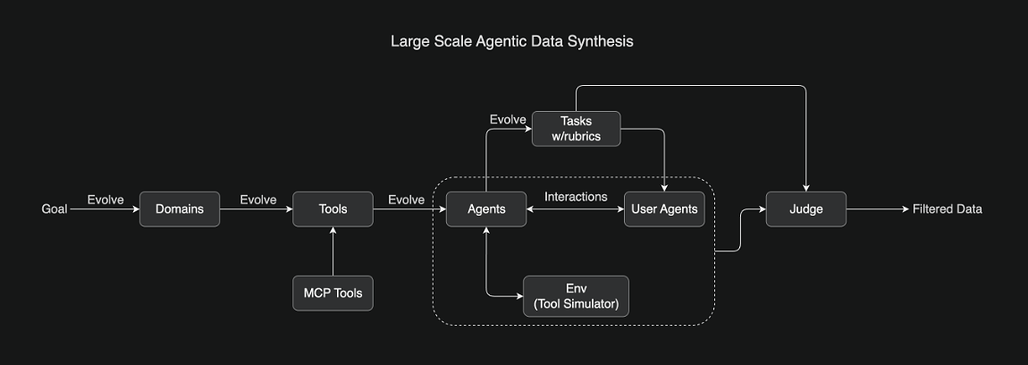

먼저, 도구 사용 학습을 위한 대규모 합성 데이터 생성은 Kimi-K2의 에이전트적 기능을 정교화하는 데 핵심적인 역할을 합니다. Moonshot AI는 수백 개의 작업 도메인과 수천 개의 도구를 정의하고, 다양한 시나리오에 따라 이 도구들을 활용하는 수많은 태스크를 구성하였습니다. 예를 들어 항공권 예약, 금융 계산, 코드 디버깅과 같은 실생활에서 빈번하게 발생하는 작업들을 기반으로 시뮬레이션 환경을 구축하고, 그 안에서 모델이 스스로 도구를 선택하고 결과를 해석하며 문제를 해결하도록 학습합니다.

이러한 시뮬레이션 환경은 단일 도구 호출에 국한되지 않고, 다단계의 연속적인 작업 흐름을 포함하고 있습니다. 모델은 사용자의 질문을 분석하고, 필요한 도구를 호출한 후 결과를 해석하여 후속 조치를 결정하는 일련의 과정을 반복함으로써 보다 복합적인 행동 패턴을 내재화하게 됩니다. 생성된 에이전트 행동 로그는 품질 보장을 위해 별도의 LLM 기반 평가자(judge)를 통해 필터링되며, 정확성과 일관성, 실행 성공 여부 등을 기준으로 고품질 데이터만이 최종 학습 데이터로 활용됩니다. 이를 통해 모델은 실제 응용 상황에서도 높은 신뢰성과 정밀도를 유지할 수 있게 됩니다.

한편, 도구 사용과 같은 명확한 작업 외에도 창작, 요약, 논리적 서술과 같은 주관적이며 정답이 명확하지 않은 작업에 대한 대응력을 확보하기 위해 Kimi-K2는 일반 강화 학습(General Reinforcement Learning) 기법을 도입하였습니다. 기존의 RLHF 방식이 사람의 수동적 피드백에 의존하는 데 반해, Kimi-K2는 LLM 자체를 평가자로 활용하는 Self-Critic 구조를 채택하고 있습니다. 즉, 모델이 생성한 응답에 대해 또 다른 LLM이 평가를 수행하며, 긍정적인 평가를 받은 결과물만을 선택하여 보강 학습에 반영하는 방식입니다.

이와 같은 구조는 사람이 직접 개입하지 않아도 모델이 스스로 응답의 질을 판단하고, 이를 기반으로 성능을 지속적으로 개선할 수 있도록 해 줍니다. 또한, 수학이나 프로그래밍처럼 정답이 존재하는 작업에서 먼저 신뢰도 높은 평가 기준을 학습한 뒤, 이를 창의적 작업의 평가로 확장함으로써 전체적인 강화 학습 시스템의 일관성과 정밀도를 높이는 전략도 병행적으로 적용되었습니다.

종합적으로 볼 때, Kimi-K2는 도구 사용 시나리오에 대한 고도화된 합성 데이터 기반 학습과 평가자 내재화 기반의 자기 보강 강화 학습을 통해, 단순한 질문-응답 생성기를 넘어서 사용자의 의도에 맞는 실행 계획 수립, 도구 선택 및 호출, 결과 해석과 후속 응답 생성을 모두 포괄할 수 있는 고급 에이전트형 인공지능으로 발전하였습니다. 이러한 설계 철학은 Moonshot AI가 지향하는 Open Agentic Intelligence의 핵심이며, Kimi-K2는 이를 구현한 대표적인 사례로서 향후 에이전트형 LLM 발전에 있어 중요한 전환점을 제시하고 있습니다.

지금까지 살펴본 것과 같이, Kimi-K2는 단순히 “많은 파라미터를 가진 LLM”이 아니라, 실제적인 도구 사용이 가능한 자율 에이전트를 오픈소스로 제공하는 모델입니다. 이 모델을 가능케 한 핵심 기술은 Open Agentic Intelligence라는 비전 아래, MuonClip 옵티마이저를 통한 안정적 학습, 그리고 뛰어난 Agentic Capabilities 설계에 있습니다.

Kimi-K2 모델 성능 평가 결과 및 벤치마크 분석

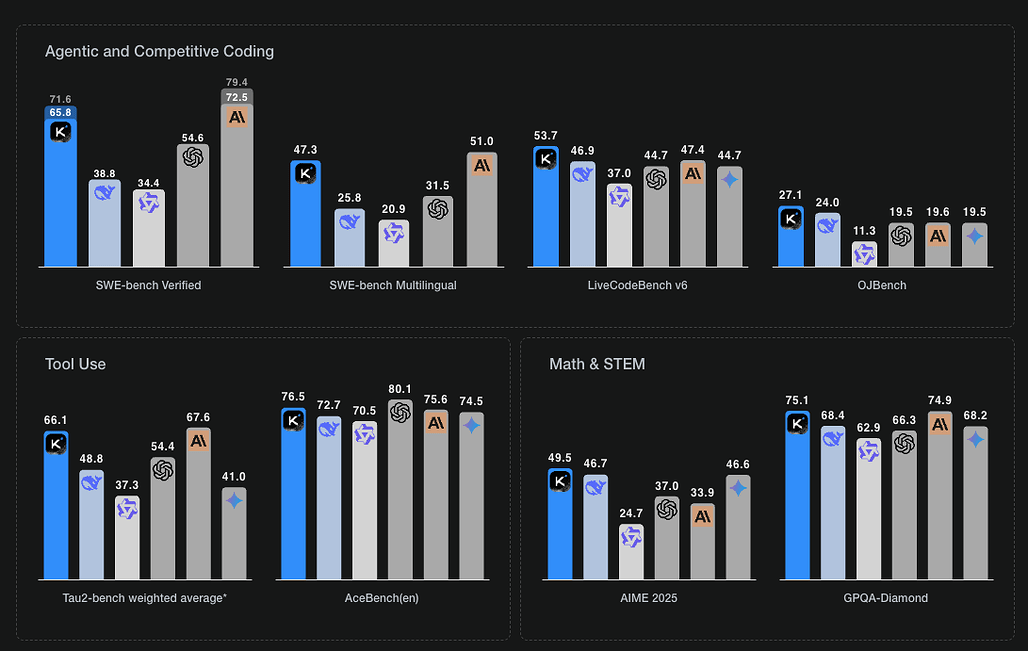

Kimi-K2는 다양한 작업군에서 동급 최고의 성능을 기록하며, 특히 코딩, 수학, 에이전트 도구 호출 등 실전 응용 분야에서 경쟁 오픈소스 또는 상용 모델보다 뛰어난 결과를 보여줍니다.

-

코딩 성능(SWE-bench): Kimi-K2는 코딩 태스크에서 우수한 성과를 보였습니다. 특히 SWE-bench Verified (Agentic Coding) 기준 단일 시도 정확도가 65.8%로, 오픈소스 모델 중 SOTA (State-of-the-art)입니다. 이는 Claude Opus(72.7%)와 GPT-4.1(54.6%)보다 뛰어난 결과로, 에이전트 수준에서 실제로 자동 문제 수정까지 가능한 능력을 시사합니다. 또한 일반 코딩 벤치마크인 LiveCodeBench v6에서 53.7%, MultiPL-E에서 85.7%라는 높은 정확도를 기록했습니다.

-

도구 사용(Task Automation): 도구 호출 관련 벤치마크인 Tau2 Bench에서는 소매, 항공, 통신 분야 각각에서 경쟁 모델보다 평균 5~15% 이상 높은 정확도를 보였습니다. 이는 Kimi-K2가 외부 API를 호출하거나 도구 기반의 작업을 수행하는 ‘에이전트 AI’로 사용하기에 최적화되어 있음을 보여줍니다.

-

수학/논리/지식: 수학 기반 평가에서 Kimi-K2는 MATH-500 97.4%, AIME 2024 69.6%, GPQA-Diamond 75.1% 등 높은 성과를 보여줬으며, MMLU 계열에서도 92.7%로 글로벌 기준 상위권에 속합니다. 일반 언어 이해나 상식 기반 QA에서도 GPT-4.1이나 Claude Sonnet과 유사하거나 상회하는 결과를 냈습니다.

Kimi-K2 모델 사용 방법

Kimi-K2는 다음과 같은 방법으로 사용할 수 있습니다:

-

Moonshot AI가 제공하는 API 사용: 공식 API는 OpenAI API와 호환되는 형태(OpenAI Compatiable Server)로 제공되며, 사용 가능한 API 엔드포인트는 다음과 같습니다:

-

OpenAI 외 Anthropic의 API와 같은 형태로도 제공되며, Anthropic 호환 모드의 경우 temperature 설정은 내부적으로 temperature × 0.6으로 매핑됩니다.

-

모델 직접 실행: 로컬 또는 클라우드 환경에서 직접 모델을 서빙하는 경우에는 vLLM, SGLang, KTransformers, TensorRT-LLM에서 최적화된 실행이 가능합니다. 또한, HuggingFace 저장소에서 block-fp8 포맷으로 가중치를 다운로드할 수 있습니다: moonshotai/Kimi-K2-Instruct · Hugging Face

- vLLM과 SGLang으로 직접 배포할 때에는 모델 배포 가이드 문서를 참고해주세요.

호출 예시 (Python)

다음과 같은 Python 코드를 사용하여 Kimi-K2 모델을 사용할 수 있습니다:

def simple_chat(client: OpenAI, model_name: str):

messages = [

{"role": "system", "content": "You are Kimi, an AI assistant created by Moonshot AI."},

{"role": "user", "content": [{"type": "text", "text": "Please give a brief self-introduction."}]},

]

response = client.chat.completions.create(

model=model_name,

messages=messages,

stream=False,

temperature=0.6,

max_tokens=256

)

print(response.choices.message.content)

도구 호출 예시 (Tool Calling)

또한, Kimi-K2-Instruct 모델은 도구 자동 호출 기능을 탑재하고 있습니다. 아래는 ‘날씨 확인’ API를 자동 호출하는 예시입니다:

def get_weather(city: str) -> dict:

return {"weather": "Sunny"}

tools = [{

"type": "function",

"function": {

"name": "get_weather",

"description": "Retrieve current weather information.",

"parameters": {

"type": "object",

"required": ["city"],

"properties": {

"city": {"type": "string", "description": "Name of the city"}

}

}

}

}]

tool_call_with_client 함수를 통해 유저 질문 → 도구 호출 → 응답 출력까지의 전체 과정을 구성할 수 있으며, 자세한 사용 방법은 도구 호출 가이드를 참고하면 됩니다.

라이선스

Kimi-K2는 코드 및 모델 가중치 모두 Modified MIT 라이선스로 공개되어 있습니다. 상업적 이용 시에는 특정 조건(예: UI에 Kimi 이름 표시 등)이 적용될 수 있으므로 반드시 전문을 검토해야 합니다.

Kimi-K2 공개 블로그

Kimi-K2 공개 블로그

Kimi-K2 모델 GitHub 저장소

Kimi-K2 모델 GitHub 저장소

https://github.com/MoonshotAI/Kimi-K2

Kimi-K2 API 공식 문서

Kimi-K2 API 공식 문서

https://platform.moonshot.ai/docs/introduction

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()