소개

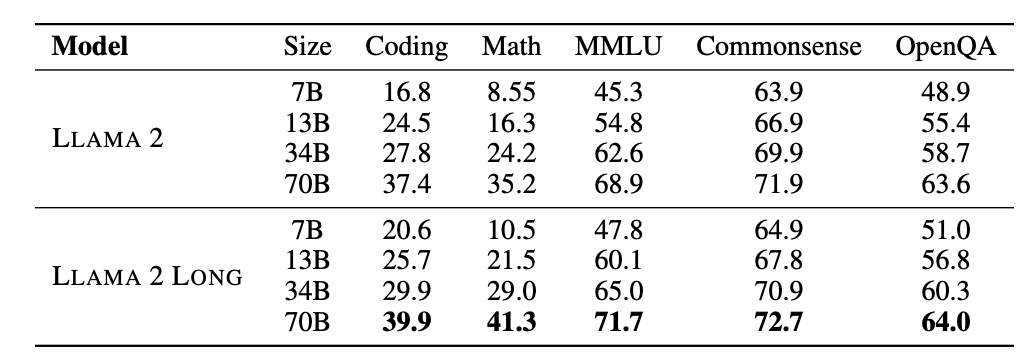

- 파운데이션 모델의 효과적인 장기 컨텍스트 확장(Effective Long-Context Scaling of Foundation Models)이라는 논문을 통해 LLaMA2 Long 모델을 공개

- 컨텍스트 윈도우(context window)의 길이가 32K(32,768) 토큰까지 지원

- 70B 버전은 이미 긴 컨텍스트 작업 모음에서

gpt-3.5-turbo-16k의 전체 성능을 능가 - 기존 모델 구조는 유지하면서, 위치 인코딩(Positional Encoding)에 RoPE(Rotary Positional Embedding)을 적용하여 적은 정보로 더 나은 응답 생성

원문

https://arxiv.org/pdf/2309.16039.pdf