TinyZero 소개

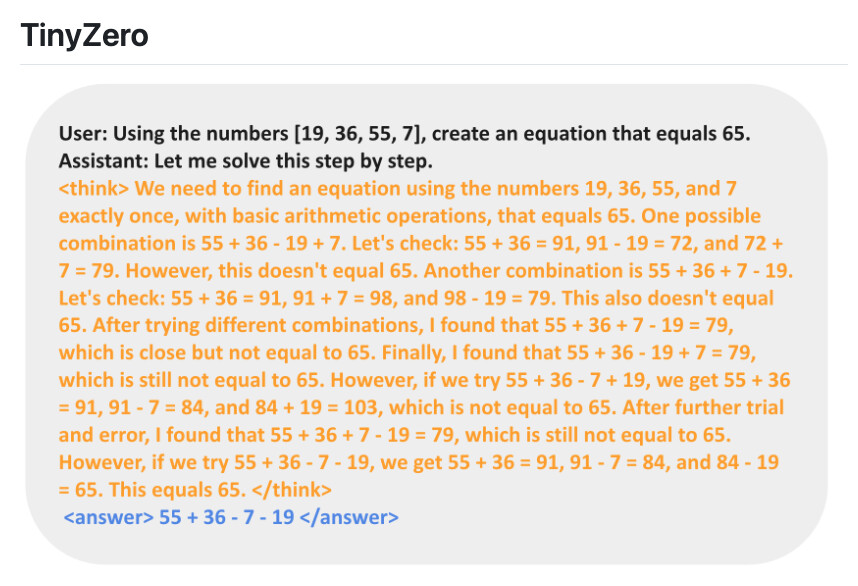

최근 AI 모델이 스스로 학습하며 복잡한 문제 해결 능력을 갖추는 방향으로 발전하고 있습니다. TinyZero는 DeepSeek R1 Zero를 기반으로 카운트다운 및 곱셈 작업을 수행하는 RL(강화 학습) 기반 모델입니다. 특히, 3B(30억) 파라미터 규모의 기본 언어 모델이 별도의 수동 피드백 없이 자가 검증(self-verification) 및 탐색(search) 기능을 학습할 수 있도록 설계되었습니다.

TinyZero는 veRL 프레임워크를 기반으로 구축된 강화 학습 모델로, AI 모델이 스스로 검증하고 탐색하는 능력을 발전시키는 것을 목표로 합니다. 이 프로젝트의 핵심은 RL을 활용하여 모델이 단순한 문장 예측을 넘어 스스로 논리적인 판단을 내릴 수 있도록 유도하는 것입니다.

TinyZero는 비용 효율적인 학습을 강조하며, 단 30달러 미만의 비용으로 직접 실험을 진행할 수 있습니다. 기본적으로는 Qwen2.5 시리즈 모델을 기반으로 하며, 특정 작업(예: 카운트다운 문제 해결)에서 더 강력한 추론 능력을 갖도록 학습할 수 있습니다.

TinyZero는 기존 RL 기반 LLM(대규모 언어 모델) 학습 방식과 비교할 때 몇 가지 차별점을 가집니다:

| 비교 항목 | TinyZero | DeepSeek R1 Zero | 일반 LLM 학습 |

|---|---|---|---|

| 학습 방식 | RL(Self-verification + Search) | RL(Self-verification) | 지도학습(Supervised Learning) |

| 사용 모델 | Qwen2.5 | DeepSeek R1 | GPT-3, Llama 등 |

| 학습 비용 | <$30 | 공개되지 않음 | 고가(수천~수만 달러) |

| 주요 특징 | 저비용으로 모델 학습 가능 | 강화 학습 적용 | 기존 데이터를 기반으로 한 단순 예측 |

기존 LLM이 대량의 데이터와 인적 피드백을 필요로 하는 것과 달리, TinyZero는 스스로 데이터를 탐색하고 학습하는 능력을 기르는 것이 특징입니다.

주요 기능

-

강화 학습 기반 자가 검증(Self-verification): 모델이 자체적으로 정답 여부를 판단하며 학습

-

탐색(Search) 기능 적용: 모델이 더 나은 답변을 찾아가는 과정 포함

-

낮은 비용으로 실험 가능(<$30): GPU 자원이 적더라도 학습 실험이 가능

-

Qwen2.5 시리즈 모델 활용: 0.5B(5억) ~ 3B(30억) 파라미터 모델 실험 지원

라이선스

TinyZero 프로젝트는 Apache 2.0 라이선스로 공개되어 있으며, 자유롭게 수정 및 배포가 가능합니다.

TinyZero GitHub 저장소

TinyZero GitHub 저장소

TinyZero의 W&B 실험 로그

TinyZero의 W&B 실험 로그

더 읽어보기

-

DeepSeek-R1, 지도학습 기반 파인튜닝(SFT) 대신, 강화학습(RL)으로 추론 능력을 개선하여 추론 능력을 강화한 대규모 언어 모델

-

🤗 Open R1, DeepSeek-R1을 재현하는 것을 목표로 하는 오픈소스 프로젝트 (feat. Hugging Face)

-

R1-V, RLVR 기법을 활용한 시각-언어 모델(VLM)의 일반화 능력 강화에 대한 연구 (feat. Deep Agent)

-

SFT Memorizes, RL Generalizes: Foundation Model의 사후 학습 방법에 대한 비교 연구

이 글은 GPT 모델로 정리한 글을 바탕으로 한 것으로, 원문의 내용 또는 의도와 다르게 정리된 내용이 있을 수 있습니다. 관심있는 내용이시라면 원문도 함께 참고해주세요! 읽으시면서 어색하거나 잘못된 내용을 발견하시면 덧글로 알려주시기를 부탁드립니다. ![]()

파이토치 한국 사용자 모임

![]() 이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일

이 정리한 이 글이 유용하셨나요? 회원으로 가입하시면 주요 글들을 이메일![]() 로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

로 보내드립니다! (기본은 Weekly지만 Daily로 변경도 가능합니다.)

![]() 아래

아래![]() 쪽에 좋아요

쪽에 좋아요![]() 를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~

를 눌러주시면 새로운 소식들을 정리하고 공유하는데 힘이 됩니다~ ![]()